flink scala 从Oracle同步数据到MySql

pom

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<flink.version>1.11.2</flink.version>

<scala.binary.version>2.11</scala.binary.version>

<scala.version>2.11.12</scala.version>

<log4j.version>2.12.1</log4j.version>

</properties>

<dependencies>

<!-- Apache Flink dependencies -->

<!-- These dependencies are provided, because they should not be packaged into the JAR file. -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-scala_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

<scope>compile</scope>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-scala_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

<scope>compile</scope>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

<scope>compile</scope>

</dependency>

<!-- Scala Library, provided by Flink as well. -->

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>${scala.version}</version>

<scope>compile</scope>

</dependency>

<!-- Add connector dependencies here. They must be in the default scope (compile). -->

<!-- Example:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

</dependency>

-->

<!-- Add logging framework, to produce console output when running in the IDE. -->

<!-- These dependencies are excluded from the application JAR by default. -->

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-slf4j-impl</artifactId>

<version>${log4j.version}</version>

<scope>runtime</scope>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-api</artifactId>

<version>${log4j.version}</version>

<scope>runtime</scope>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-core</artifactId>

<version>${log4j.version}</version>

<scope>runtime</scope>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>fastjson</artifactId>

<version>1.2.56</version>

</dependency>

<dependency>

<groupId>com.oracle</groupId>

<artifactId>ojdbc6</artifactId>

<version>11.1.0.7.0-Production</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>8.0.11</version>

</dependency>

</dependencies>

Job_Data_Oracle_To_MySql.scala

package org.myorg.quickstart

import java.sql.{Connection, DriverManager, PreparedStatement, ResultSet, Timestamp}

import java.text.SimpleDateFormat

import java.util.Date

import org.apache.flink.configuration.Configuration

import org.apache.flink.streaming.api.functions.sink.{RichSinkFunction, SinkFunction}

import org.apache.flink.streaming.api.functions.source.{RichSourceFunction, SourceFunction}

import org.apache.flink.streaming.api.scala._

object Job_Data_Oracle_To_MySql {

def main(args: Array[String]): Unit = {

val env = StreamExecutionEnvironment.getExecutionEnvironment

env.addSource(new OracleSource)

.name("OracleSource")

.addSink(new MySqlSink)

.name("MySqlSink")

.setParallelism(1)

env.execute("Data From Oracle To MySql")

}

def NowDate(): String = {

val now: Date = new Date()

val dateFormat: SimpleDateFormat = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss.SSS")

val date = dateFormat.format(now)

return date

}

}

case class TB_TEST01(ID: Int, NAME: String, CTIME: Date)

class OracleSource extends RichSourceFunction[TB_TEST01] {

var conn: Connection = _

var selectStmt: PreparedStatement = _

var isRunning: Boolean = true

override def open(parameters: Configuration): Unit = {

// 加载驱动

Class.forName("oracle.jdbc.driver.OracleDriver")

// 数据库连接

conn = DriverManager.getConnection("jdbc:oracle:thin:@localhost:1521/orcl", "lxw", "123456")

selectStmt = conn.prepareStatement("select * from TB_TEST01")

}

override def run(sourceContext: SourceFunction.SourceContext[TB_TEST01]): Unit = {

while (isRunning) {

var resultSet: ResultSet = selectStmt.executeQuery()

while (resultSet.next()) {

var ID: Int = resultSet.getInt("ID")

var NAME: String = resultSet.getString("NAME")

var CTIME: Date = resultSet.getTimestamp("CTIME")

sourceContext.collect(TB_TEST01(ID, NAME, CTIME))

}

println(Job_Data_Oracle_To_MySql.NowDate() + "暂停5秒")

Thread.sleep(5000)

}

}

override def close(): Unit = {

selectStmt.close()

conn.close()

}

override def cancel(): Unit = {

isRunning = false

}

}

class MySqlSink extends RichSinkFunction[TB_TEST01] {

var conn: Connection = _

var insertStmt: PreparedStatement = _

var updateStmt: PreparedStatement = _

override def close(): Unit = {

insertStmt.close()

updateStmt.close()

conn.close()

}

override def open(parameters: Configuration): Unit = {

Class.forName("com.mysql.cj.jdbc.Driver")

conn = DriverManager.getConnection("jdbc:mysql://localhost:3306/test?useUnicode=true&characterEncoding=utf8&useSSL=false&autoReconnect=true&serverTimezone=UTC"

, "root"

, "123456")

insertStmt = conn.prepareStatement("INSERT INTO `test`.`tb_test01`(`id`, `name`, `ctime`) VALUES (?, ?, ?)")

updateStmt = conn.prepareStatement("UPDATE `test`.`tb_test01` SET `name` = ?, `ctime` =? WHERE `id` = ?")

}

override def invoke(value: TB_TEST01, context: SinkFunction.Context[_]): Unit = {

// 执行更新语句

updateStmt.setString(1, value.NAME)

updateStmt.setTimestamp(2, new Timestamp(value.CTIME.getTime))

updateStmt.setInt(3, value.ID)

updateStmt.execute()

//如果update没有更新 即 没有查询到数据 即 没有该id 那么执行插入

if (updateStmt.getUpdateCount == 0) {

println(Job_Data_Oracle_To_MySql.NowDate() + "------------------插入数据>>" + value)

insertStmt.setInt(1, value.ID)

insertStmt.setString(2, value.NAME)

insertStmt.setTimestamp(3, new Timestamp(value.CTIME.getTime))

insertStmt.execute()

} else {

println(Job_Data_Oracle_To_MySql.NowDate() + "------------------更新数据>>" + value)

}

}

}

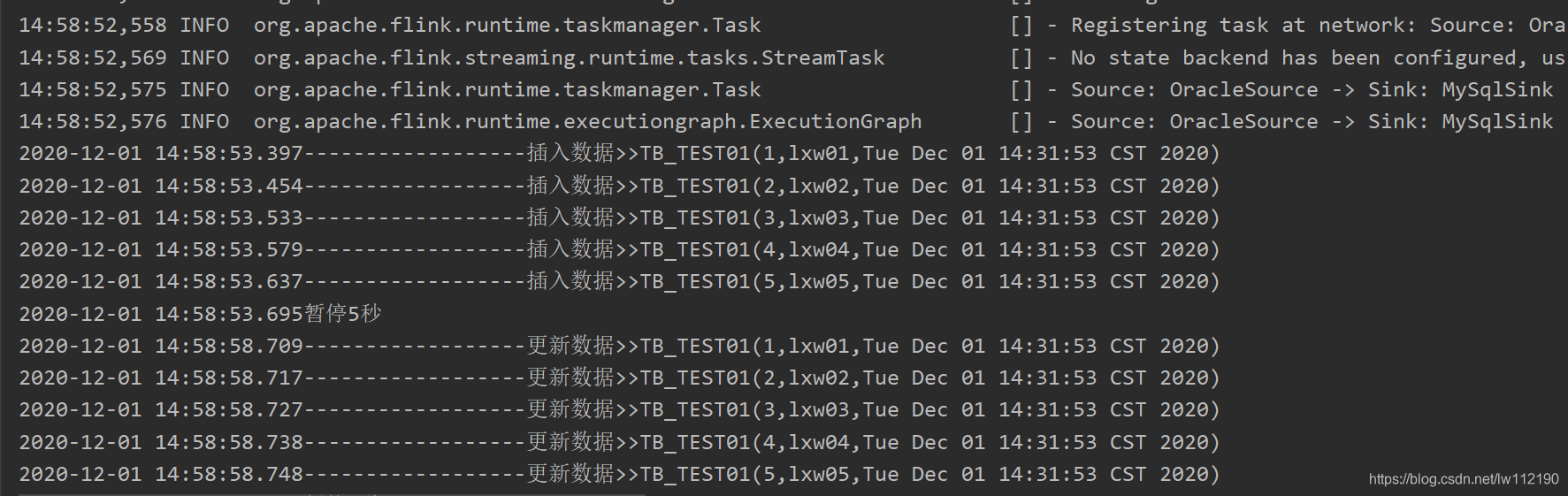

控制台输出

Oracle中

MySql中

flink scala 从Oracle同步数据到MySql的更多相关文章

- Flink 异步IO访问外部数据(mysql篇)

接上篇:[翻译]Flink 异步I / O访问外部数据 最近看了大佬的博客,突然想起Async I/O方式是Blink 推给社区的一大重要功能,可以使用异步的方式获取外部数据,想着自己实现以下,项目上 ...

- 定时执行rsync同步数据以及mysql备份

需求:把机器A中的附件.图片等,备份到备份机B中.将数据库进行备份 附件备份 在A中,启动rsync服务,编辑/etc/xinetd.d/rsync文件,将其中的disable=yes改为disabl ...

- 大数据批量导入,解决办法,实践从定时从 sqlserver 批量同步数据到 mySql

c#代码,批量导入数据代码 public class MySql_Target : ZFCommon.DataAccesser.Base.DABase { public MySql_Target() ...

- ORACLE GOLDEN GATE oracle同步数据至kafka

一.服务器信息 ip 软件版本 ogg版本 软件包 操作系统版本 OGG安装路径 10.1.50.52 源 oracle11.2.0.4 12.2.0.1.1 V100692-01.zip cen ...

- 从Oracle同步数据到SQLServer——大小写敏感设置

Oracle默认是大小写敏感,而SQLServer默认大小写不敏感, 尤其是涉及主键字段时,注意请提前设置SQLServer对应的数据库表为大小写敏感,不然会报主键冲突的错误. 设置表内大小写敏感 A ...

- Clickhouse单机部署以及从mysql增量同步数据

背景: 随着数据量的上升,OLAP一直是被讨论的话题,虽然druid,kylin能够解决OLAP问题,但是druid,kylin也是需要和hadoop全家桶一起用的,异常的笨重,再说我也搞不定,那只能 ...

- 实现从Oracle增量同步数据到GreenPlum

简介: GreenPlum是一个基于PostgreSQL数据库开发的MPP架构的数据库仓库,适用于OLAP系统,支持50PB(1PB=1000TB)级海量数据的存储和处理. 背景: 目前有一个业务是需 ...

- 将数据从MySQL迁移到Oracle的注意事项

将数据从MySQL迁移到Oracle的注意事项1.自动增长的数据类型处理MYSQL有自动增长的数据类型,插入记录时不用操作此字段,会自动获得数据值.ORACLE没有自动增长的数据类型,需要建立一个自动 ...

- 使用MySQL Migration Toolkit快速将Oracle数据导入MySQL[转]

使用MySQL Migration Toolkit快速将Oracle数据导入MySQL上来先说点废话本人最近在学习一些数据库方面的知识,之前接触过Oracle和MySQL,最近又很流行MongoDB非 ...

- MYSQL数据库间同步数据

http://blog.csdn.net/swandy45/article/details/6982421 环境要求: Windows 操作系统 需要Mysql 3.23.15以后的版本. 假设数据库 ...

随机推荐

- Linux查看系统版本的方法

记录几种查看当前Linux系统的版本的方法 一.使用命令:cat /proc/version 查看 linux版本号:Linux version 5.4.0-99-generic (buildd@lg ...

- Laravel入坑指南(6)——Redis缓存

写在前面: Redis是常用nosql服务之一,在Redis官网上最新的稳定版本是6.0.6.这里不讨论Redis服务如何编译,如何使用.在Redis官网有很健全的文档. 这里要讨论的是无论在cent ...

- 通过weblogic发布服务器某个文件夹

介绍 客户有一台老服务器,上面安装的是weblogic,现在有个需求是需要将服务器下面某个文件夹下的文件都发布出来供某前端直接访问.之前都是直接利用tomcat的webapps目录直接发布即可,搜索了 ...

- thymeleaf利用fragment解决html页面间获取context-path问题

问题说明 我使用spring boot+thymeleaf做了个项目,那前台页面都是html,里面有各种api调用和路径跳转. 大家都知道这些路径不能写死,为保证任何情况下路径的正确性,一般都是这种格 ...

- git回退至指定版本,并更新远程仓库

1. git log 查到commit记录 2.复制 commit 后面的id 3. git reset --hard commit 后面的id // 回退 4. 强制更新远程仓库 git ...

- 使用TLP对Linux系统进行充电保护

https://zhuanlan.zhihu.com/p/65546444 TLP:一个可以延长 Linux 笔记本电池寿命的高级电源管理工具 https://blog.csdn.net/zxw781 ...

- mysql-数据类型,类型约束,联合唯一约束,表与表之间的关系,存储引擎---day36

# ### char varchar(补充) char 字符长度 255个 varchar 字符长度 21845个 # ### part1 数据类型 -时间 date YYYY-MM-DD 年月日(结 ...

- 对于Celery原理的简单理解

参考博客: https://www.cnblogs.com/forward-wang/p/5970806.html https://blog.csdn.net/cuomer/article/detai ...

- 【LeetCode哈希表#2】两个数组的交集(Set+数组)

两个数组的交集 力扣题目链接(opens new window) 题意:给定两个数组,编写一个函数来计算它们的交集. 说明: 输出结果中的每个元素一定是唯一的. 我们可以不考虑输出结果的顺序. 思路 ...

- 详解SSL证书系列(4)免费的SSL证书和收费的证书有什么区别

上一篇介绍了如何选择SSL证书,更多地是从证书类型角度介绍的.SSL证书有免费和收费的,那么它们之间有什么区别呢? SSL证书免费和收费的主要区别体现在以下几个方面: 1,验证类型 免费SSL证书通常 ...