scrapy 项目通过scrapyd部署

年前的时候采用scrapy 爬取了某网站的数据,当时只是通过crawl 来运行了爬虫,现在还想通过持续的爬取数据所以需要把爬虫部署起来,查了下文档可以采用scrapyd来部署scrapy项目,scrapyd主要分两部分,一部分是服务器端(scrapyd),一个是客户端(scrapyd-client),服务器端主要聊调度和运行scrapy,客服端主要用于发布scrapy项目。

一.scrapyd 环境搭建

1.安装scrapyd可以采用pip和源码的两种方式安装

i.安装scrapyd

pip install scrapyd

ii.安装scrapyd-client

pip install scrapyd-client

2.运行scrapyd;

i.首先我们需要创建一个目录,用于存储发布我们部署的项目;

ii.执行scrapyd,运行启动,启动成功访问http://127.0.0.1:6800/,显示scrapyd界面,这样scrapyd安装成功;

iii.此时scrapyd只能在本机访问,我们需要去修改配置文件,运行所有的ip都可以访问。配置文件的路径在site-packages\scrapyd目录下,windows配置文件名字是default_scrapyd.conf,把bind_address改成0.0.0.0 这样就可以所有的地址都可以访问。

3.配置scrapyd-client。

i.安装完成scrapyd-client,我们要使用scrapyd-deploy来发布我们项目,但是在window运行scrapyd-deploy会出问题,这时候我们需要在python安装目录Scripts新建一个bat脚本

@echo off

"D:\Program Files\Python\Python35\python.exe" "D:\Program Files\Python\Python35\Scripts\scrapyd-deploy" %*

说明:前面是python.exe 目录,中间是 scrapyd-deploy 目录,%*代表输入的参数。

以上我们就把scrapyd的服务器端和客户端配置完成了,我们来发布下自己的项目。

二.scrapy 项目发布

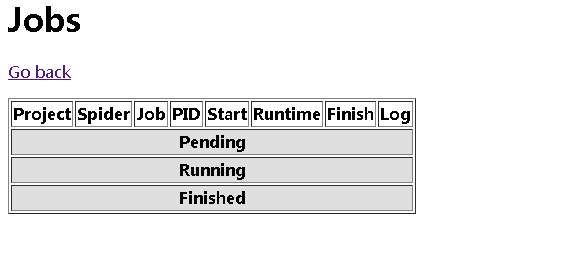

1.scrapyd安装成功,打开http://localhost:6800/ 可以看到scrapyd的一个页面,包括三个选项,jobs(任务),logs(日志),Documentation;

2.点击job可以看到目前运行的任务。

3.发布项目到scrapyd

i.配置scrapy工程scrapy.cfg文件

[settings]

default = boss.settings [deploy:boss] #如果多个项目,这里可以添加一个别名

url = http://localhost:6800/ #这里设置scrapyd的服务器地址;

project = boss

ii.通过scrapyd-deploy发布项目,需要进入scrapy的工程目录进行发布

scrapyd-deploy boss -p boss

语法:scrapyd-deploy <部署别名> -p 项目名称

发布成功以后,会返回以下结果。

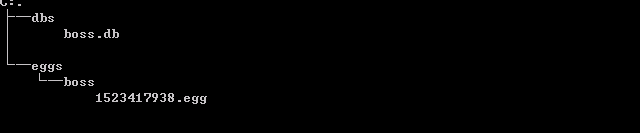

此时会在scrapyd目录下创建一个boss目录,把我们的scrapy项目打成一个egg的压缩文件。

三.启动、停止爬虫

这个时候我们需要调用scrapyd API来运行我们的爬虫。

1.启动爬虫

curl http://localhost:6800/schedule.json -d project=boss -d spider=zhaopin

语法:

curl http://<ip>:6800/schedule.json -d project=<项目名称> -d spider=<spider名称>

以下就是项目发布成功。

也可以在scrapyd管理界面看到项目的运行情况

2.停止爬虫

curl http://localhost:6800/cancel.json -d project=boss -d job=6700d2d43d3c11e8b1eaf8db8a950d02

语法:

curl http://<ip>:6800/cancel.json -d project=<项目名称> -d job=job_id(项目运行成功会返回ID)

3.常用的scrapyd API

.获取状态

http://127.0.0.1:6800/daemonstatus.json

.获取项目列表

http://127.0.0.1:6800/listprojects.json .获取项目下已发布的爬虫列表

http://127.0.0.1:6800/listspiders.json?project=<项目名称> .获取项目下已发布的爬虫版本列表

http://127.0.0.1:6800/listversions.json?project=<项目名称> .获取爬虫运行状态

http://127.0.0.1:6800/listjobs.json?project=<项目名称>

.启动服务器爬虫

http://localhost:6800/schedule.json (post方式,data={"project":<项目名称>,"spider":<spider名称>}) .删除某一版本爬虫

http://127.0.0.1:6800/delversion.json (post方式,data={"project":<项目名称>,"version":<版本号>}) .删除某一工程,包括该工程下的各版本爬虫

http://127.0.0.1:6800/delproject.json(post方式,data={"project":<项目名称>})

注意:

删除之前需要停止爬虫,才可以再次删除

scrapy 项目通过scrapyd部署的更多相关文章

- 第三百七十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapyd部署scrapy项目

第三百七十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapyd部署scrapy项目 scrapyd模块是专门用于部署scrapy项目的,可以部署和管理scrapy项目 下载地址:h ...

- 五十一 Python分布式爬虫打造搜索引擎Scrapy精讲—scrapyd部署scrapy项目

scrapyd模块是专门用于部署scrapy项目的,可以部署和管理scrapy项目 下载地址:https://github.com/scrapy/scrapyd 建议安装 pip3 install s ...

- scrapy项目部署

什么是scrapyd Scrapyd是部署和运行Scrapy.spider的应用程序.它使您能够使用JSON API部署(上传)您的项目并控制其spider. 特点: 可以避免爬虫源码被看到. 有版本 ...

- Scrapyd部署爬虫

Scrapyd部署爬虫 准备工作 安装scrapyd: pip install scrapyd 安装scrapyd-client : pip install scrapyd-client 安装curl ...

- Python 爬虫之 Scrapy 分布式原理以及部署

Scrapy分布式原理 关于Scrapy工作流程 Scrapy单机架构 上图的架构其实就是一种单机架构,只在本机维护一个爬取队列,Scheduler进行调度,而要实现多态服务器共同爬取数据关键就是共享 ...

- 爬虫部署 --- scrapyd部署爬虫 + Gerapy 管理界面 scrapyd+gerapy部署流程

---------scrapyd部署爬虫---------------1.编写爬虫2.部署环境pip install scrapyd pip install scrapyd-client 启动scra ...

- scrapyd部署、使用Gerapy 分布式爬虫管理框架

Scrapyd部署爬虫项目 GitHub:https://github.com/scrapy/scrapyd API 文档:http://scrapyd.readthedocs.io/en/stabl ...

- 创建第一个Scrapy项目

d:进入D盘 scrapy startproject tutorial建立一个新的Scrapy项目 工程的目录结构: tutorial/ scrapy.cfg # 部署配置文件 tutorial/ # ...

- Tomcat 利用server.xml进行其他盘符的其他项目映射的部署以及JSP引用其他盘符的图片(虚拟目录及虚拟路径)

Tomcat 利用server.xml进行项目映射的部署 2013-07-17 15:14 12843人阅读 评论(4) 收藏 举报 分类: web 开发(5) 版权声明:本文为博主原创文章,欢迎 ...

随机推荐

- SpringBoot(二)thymeleaf模板的引入

接着上一次的配置 1.在pom文件中添加thymeleaf模板的引入, <dependency> <groupId>org.springframework.boot</g ...

- 键盘keycode对照表

- SpringdataJpa的官方API学习

(将对Springdata JPA的API 第三章之后进行解释) 一 . Core concepts(核心概念) 1.springdata中的中心接口是——Repository.这个接口没有什么重 ...

- js-null 、undefined

注意:null 转为数值时为0,而 undefined 转为数值时为 NaN. Number(undefined) // NaN Number(null) // 0 null 表示"没有对象 ...

- Kaggle:House Prices: Advanced Regression Techniques 数据预处理

本博客是博主在学习了两篇关于 "House Prices: Advanced Regression Techniques" 的教程 (House Prices EDA 和 Comp ...

- 解决Python2.7的UnicodeEncodeError: ‘ascii’ codec can’t encode异常错误

更改 sys.defaultencoding 为文件的编码方式 #! /usr/bin/env python # -*- coding: utf-8 -*- import sys reload ...

- JavaBasic_09

方法的参数传递 方法调用时参数值的传递可以分为"值传递"和"引用传递"两种 值传递 - a.当方法的参数为基本数据类型时 b.实参的值被复制给形参,改变形参不会 ...

- Unity 思考问题的办法

Unity 思考问题的办法 本文提供全流程,中文翻译. Chinar 坚持将简单的生活方式,带给世人!(拥有更好的阅读体验 -- 高分辨率用户请根据需求调整网页缩放比例) Chinar -- 心分享. ...

- 苹果手机不兼容autoplay属性

var audio=new Audio("music/music.mp3"); audio.preload="preload"; // 自动播放解决苹果不兼容a ...

- Hive错误:Error: FUNCTION 'NUCLEUS_ASCII' already exists. (state=X0Y68,code=30000)

问题 初始化derby失败: [root@bigdata111 apache-hive-2.3.0-bin]# schematool -dbType derby -initSchemaSLF4J: C ...