java根据URL获取网页编码

由于很多原因,我们要获取网页的编码(多半是写批量抓取的脚本吧...嘻嘻嘻)

注意:

如果你的目的是获取不乱码的网页内容(而不是根据网址发送post请求获取返回值),切记切记,移步这里

java根据URL获取HTML内容

先说思路:

有三种方法:

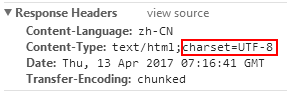

1,根据responseHeaders获取Content-Type里的charset,如下图

这种方法最好,最推荐,然而,很多网站都没有,要么是像百度这样:

有Content-Type,然而没有指定charset

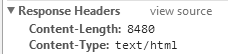

要么是像博客园这样:

???Content-Type都不给我么...???

所以虽然这种方法最准确.但是...并不是每个网站都有的...

2.根据html标签里的meta取

这里还以百度为例:

怎么取标签,我就不说了,如果不会就留言,如有需要我再写博客(然而也没什么人看我博客,更没什么人会留言...悲伤...我就默认你们都会取了)

虽然中文乱码,但是英文是不乱的,哪怕你不知道编码,随便用个GBK,UTF-8都能取...

但是,这种方法不准...不保证一定能取到正确的

并且..由于这种方法你还得拿到HTML内容...所以,还得判断一下是不是GZIP方式压缩了...贼麻烦...所以我就放弃了

3.通过第三方库,去猜格式

这种方法,原则上讲是存在一定的猜错几率的...

原理是同时进行多种编码的尝试(gb2312啊,utf-8啊,windows-XXXX啊),哪个先返回正确的格式就认定是哪个...虽然根据我的尝试很准,然而理论上还是会不贴切的,没有第一种准.

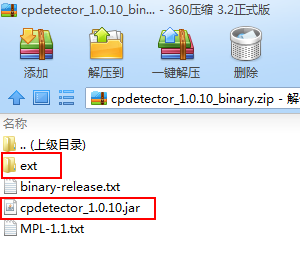

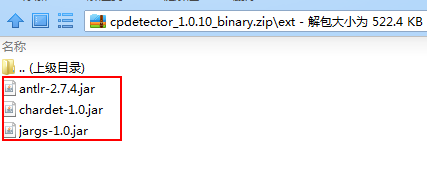

文件下载:http://files.cnblogs.com/files/blog5277/cpdetector_1.0.10_binary.zip

切记切记,总共是4个jar包...别的教程里并没有告诉我,害得我分别去找这三个编码jar包,好气...最后才发现原来就在这个压缩包里...吃了眼瞎的亏了

这四个jar包放进你项目里就行

最后,经过慎重的考虑与取舍,我决定先用第一种方法取(毕竟最准确),放弃第二种方法(贼麻烦...),第一种取不到了,再用第三种猜,如下

public static String getUrlCharset(String url){

try {

String urlNameString = url;

URL realUrl = new URL(urlNameString);

// 打开和URL之间的连接

URLConnection connection = realUrl.openConnection();

// 设置通用的请求属性

connection.setRequestProperty("accept", "*/*");

connection.setRequestProperty("connection", "Keep-Alive");

connection.setRequestProperty("user-agent",

"Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1;SV1)");

// 建立实际的连接

connection.connect();

// 获取所有响应头字段

Map<String, List<String>> map = connection.getHeaderFields();

// 遍历所有的响应头字段

System.out.println("Content-Type" + "--->" + map.get("Content-Type"));

List<String> list=map.get("Content-Type");

if (list.size()>0){

String contentType=list.toString().toUpperCase();

if (contentType.contains("UTF-8")){

return "UTF-8";

}

if(contentType.contains("GB2312")){

return "GB2312";

}

if (contentType.contains("GBK")){

return "GBK";

}

}

//如果相应头里面没有编码格式,用下面这种

CodepageDetectorProxy codepageDetectorProxy = CodepageDetectorProxy.getInstance();

codepageDetectorProxy.add(JChardetFacade.getInstance());

codepageDetectorProxy.add(ASCIIDetector.getInstance());

codepageDetectorProxy.add(UnicodeDetector.getInstance());

codepageDetectorProxy.add(new ParsingDetector(false));

codepageDetectorProxy.add(new ByteOrderMarkDetector());

Charset charset = codepageDetectorProxy.detectCodepage(new URL(url));

return charset.name();

}catch (Exception e){}

return null;

}

如果返回值是null,那很不幸,我也不知道哪里出异常了,自己debug解决吧,嘻嘻.一般是没事.最多就是网络不好timeout了

就这样

java根据URL获取网页编码的更多相关文章

- java根据URL获取HTML内容

之前我写脚本,是想获取HTML内容的. 但是呢...一方面编码困扰着我,于是我写了这个: java根据URL获取网页编码 然后呢,每个网站是不是GZIP还得判断,贼麻烦... 但是没办法啊,麻烦也得写 ...

- Java 网络爬虫获取网页源代码原理及实现

Java 网络爬虫获取网页源代码原理及实现 1.网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成.传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL ...

- Java从URL获取PDF内容

Java直接URL获取PDF内容 题外话 网上很多Java通过pdf转 HTML,转文本的,可是通过URL直接获取PDF内容,缺没有,浪费时间,本人最近工作中刚好用到,花了时间整理下,分享出来,防止浪 ...

- java根据url获取json对象

package test; import java.io.BufferedReader; import java.io.IOException; import java.io.InputStream; ...

- 【真相揭秘】requests获取网页编码乱码本质

有没有被网页编码抓狂,怎么转都是乱码. 通过查看requests源代码,才发现是库本身历史原因造成的. 作者是严格http协议标准写这个库的,<HTTP权威指南>里第16章国际化里提到,如 ...

- java爬虫HttpURLConnect获取网页源码

public abstract class HttpsURLConnection extends HttpURLConnection HttpsURLConnection 扩展 HttpURLConn ...

- asp.net 利用HttpWebRequest自动获取网页编码并获取网页源代码

/// <summary> /// 获取源代码 /// </summary> /// <param name="url"></param& ...

- python获取网页编码问题(encoding和apparent_encoding)

在requests获取网页的编码格式时,有两种方式,而结果也不同,通常用apparent_encoding更合适 注:推荐一个大佬写的关于获取网页编码格式以及requests中text()和conte ...

- LAMP环境下,通过网页url获取gb2312编码中文命名的下载资源方法

最近有个功能, 要求获取中文命名的.zip压缩文件,我准备直接采用网页url填写压缩文件地址的方式获取下载资源, 但问题是 我们的linux系统和php编程环境都是采用的zh_GB2312编码, 而浏 ...

随机推荐

- redis安装集群的2种方式

redis主从只是数据的备份,当主宕机后不会自动切换从为主,需要手动切换从为主. 哨兵就可以自动切换从为主, 当主数据库遇到异常中断服务后,开发者可以通过手动的方式选择一个从数据库来升格为主数据库,以 ...

- JustOj 1032: 习题6.7 完数

题目描述 一个数如果恰好等于它的因子之和,这个数就称为"完数". 例如,6的因子为1.2.3,而6=1+2+3,因此6是"完数". 编程序找出N之内的所有完数, ...

- 数据库 SQL 优化大总结之:百万级数据库优化方案

网上关于SQL优化的教程很多,但是比较杂乱.近日有空整理了一下,写出来跟大家分享一下,其中有错误和不足的地方,还请大家纠正补充. 这篇文章我花费了大量的时间查找资料.修改.排版,希望大家阅读之后,感觉 ...

- linux下nginx整合php

在nginx中药使用php可不像apache那样,因为apache是把php当做自己的一个模块来启动的, 而我们的nginx是把http请求转发给php程序,也就是说,php和nginx是相互独立的的 ...

- No module named scrapy 成功安装scrapy,却无法import的解决方法

今天本来准备写一个Python的爬虫,然而使用pip安装了Scrapy之后,却无论如何也无法import,显示的结果总是ImportError: No module named Scrapy.网上查阅 ...

- 作为phper既然了解共享内存函数shmop的使用方法,那么就必须要了解一下信号量是什么,以及信号量使用的代码案例

在单独的一个PHP进程中读写.创建.删除共享内存方面上你应该没有问题了.但是实际运行中不可能只是一个PHP进程在运行中.如果在多个进程的情况下你还是沿用单个进程的处理方法,你一定会碰到问题--著名的并 ...

- 深入浅出TCP之半关闭与CLOSE_WAIT

转自:https://www.2cto.com/net/201309/243585.html(相关链接) 深入浅出TCP之半关闭与CLOSE_WAIT 终止一个连接要经过4次握手.这由TCP的半关闭( ...

- Nginx入门简介

Nginx入门简介 Nginx 介绍 Nginx (engine x) 是一个高性能的HTTP和反向代理服务,也是一个IMAP/POP3/SMTP服务.Nginx是由伊戈尔·赛索耶夫为俄罗斯访问量第二 ...

- Linux使用退格键时出现^H + Tab键命令补全失效/方向键失效 + ls文件夹和文件没有颜色

删除问题 安装kalilinux使用普通用户的的时候按退格键无法实现删除功能 解决的办法有两个 一改变快捷键: 使用Ctrl+Backspace组合键可以实现删除功能 ctrl + backspace ...

- python简说(二十四)发送网络请求

一.get,post请求import requestsurl='http://127.0.0.1:8999/api/upload'# data = {'username':'testuser1','p ...