spark环境安装

源码包下载:

http://archive.apache.org/dist/spark/spark-2.1.1/v

集群环境:

master 192.168.1.99

slave1 192.168.1.100

slave2 192.168.1.101

下载安装包:

# Master

wget http://archive.apache.org/dist/spark/spark-2.1.1/spark-2.1.1-bin-hadoop2.7.tgz -C /usr/local/src

wget https://downloads.lightbend.com/scala/2.11.8/scala-2.11.8.tgz -C /usr/local/src

tar -zxvf spark-2.1.-bin-hadoop2..tgz

tar -zxvf scala-2.11.8.tgz

mv spark-2.1.-bin-hadoop2. /usr/local/spark

mv scala-2.11.8 /usr/local/scala

修改配置文件:

cd /usr/local/spark/conf

vim spark-env.sh

export SCALA_HOME=/usr/local/scala

export JAVA_HOME=/usr/local/jdk1.8.0_181

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

SPARK_MASTER_IP=master

SPARK_LOCAL_DIRS=/usr/local/spark

SPARK_DRIVER_MEMORY=1G

vim slaves

slave1

salve2

配置环境变量:

#Master slave1 slave2

vim ~/.bashrc

SPARK_HOME=/usr/local/spark

PATH=$PATH:$SPARK_HOME/bin #刷新环境变量

source ~/.bashrc

拷贝安装包:

scp -r /usr/local/spark root@slave1:/usr/local/spark

scp -r /usr/local/spark root@slave2:/usr/local/spark scp -r /usr/local/scala root@slave1:/usr/local/scala

scp -r /usr/local/scala root@slave2:/usr/local/scala

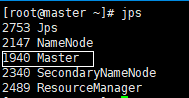

启动集群:

/usr/local/spark/sbin/start-all.sh

集群状态:

#Master

#slave1

#slave2

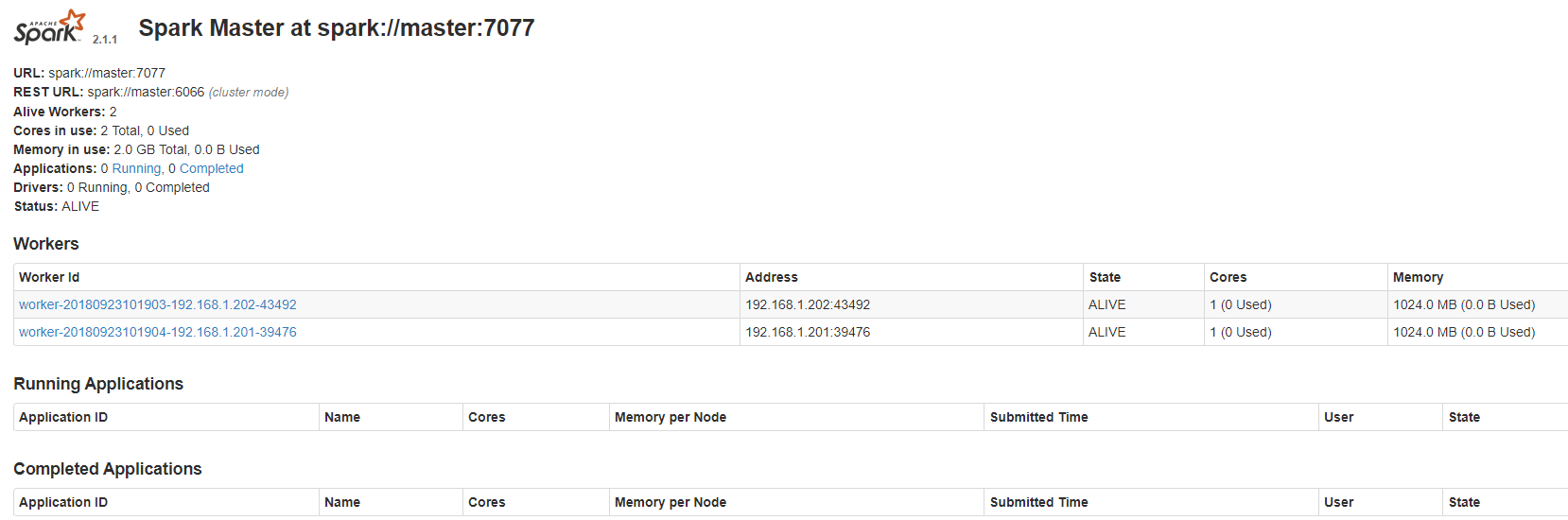

监控网页:

http://master:8080

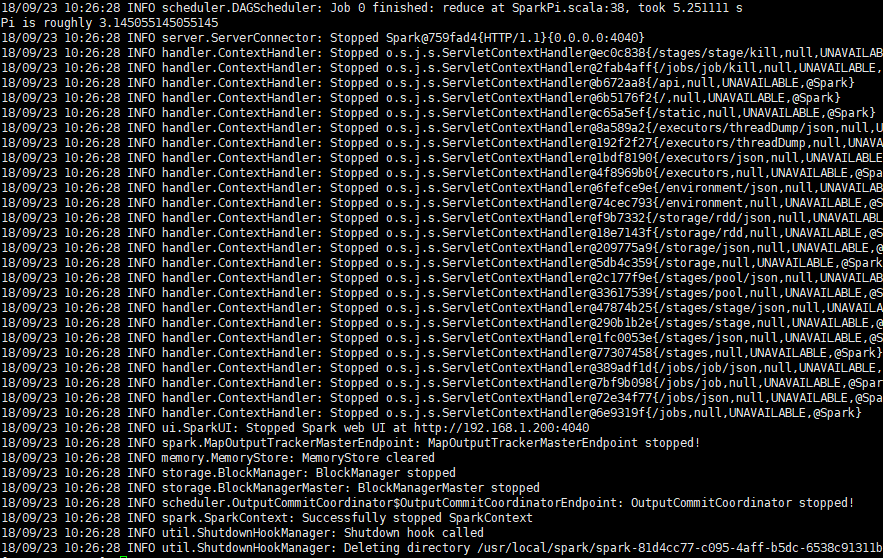

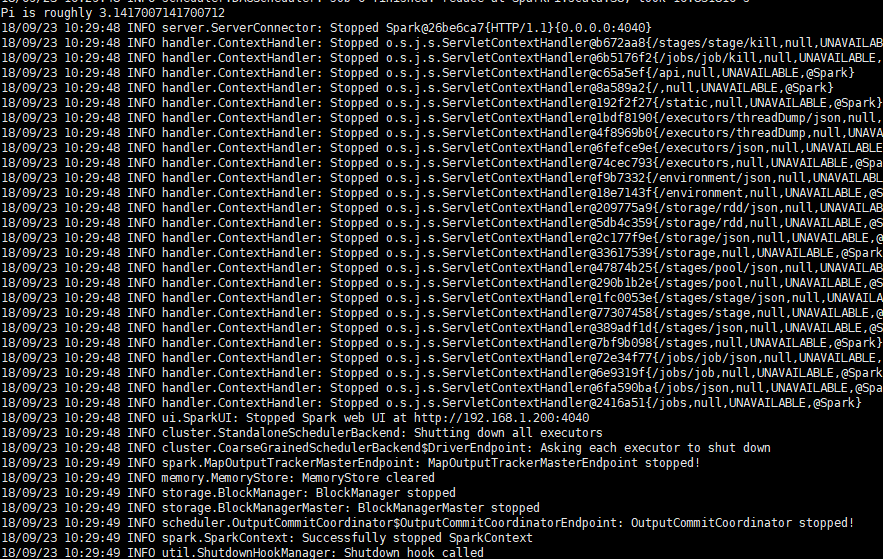

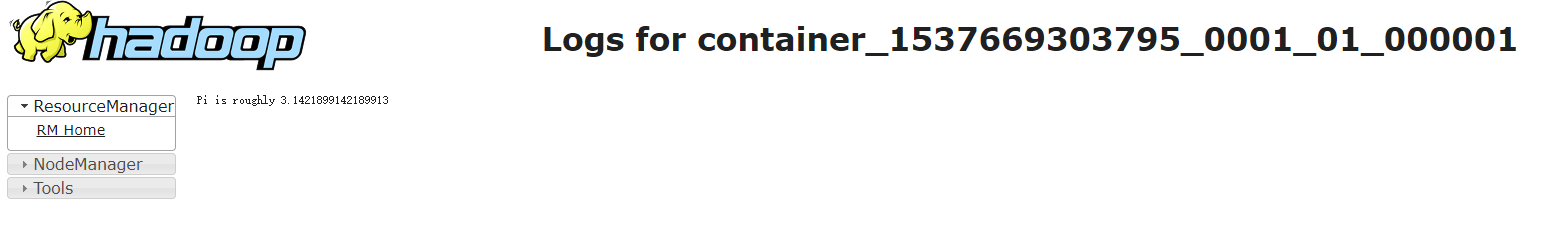

验证:

spark-submit --class org.apache.spark.examples.SparkPi --master yarn-cluster /usr/local/spark/examples/jars/spark-examples_2.11-2.1.1.jar 100

spark环境安装的更多相关文章

- 详解 jupyter notebook 集成 spark 环境安装

来自: 代码大湿 代码大湿 1 相关介绍 jupyter notebook是一个Web应用程序,允许你创建和分享,包含活的代码,方程的文件,可视化和解释性文字.用途包括:数据的清洗和转换.数值模拟.统 ...

- 手工命令行 搭建 hadoop 和 spark 环境

环境准备:3台CentOS7,64位,Hadoop2.7需要64位Linux 192.168.20.161 192.168.20.162 192.168.20.163 三台机器分别叫host01. ...

- Windows下安装Spark环境

根据博客总结 https://blog.csdn.net/nxw_tsp/article/details/78281533 需要的安装软件可以在网盘下载: 链接:https://pan.baidu.c ...

- hadoop环境的安装 和 spark环境的安装

hadoop环境的安装1.前提:安装了java spark环境的安装1.前提:安装了java,python2.直接pip install pyspark就可以安装完成.(pip是python的软件安装 ...

- Mac OSX系统中Hadoop / Hive 与 spark 的安装与配置 环境搭建 记录

Mac OSX系统中Hadoop / Hive 与 spark 的安装与配置 环境搭建 记录 Hadoop 2.6 的安装与配置(伪分布式) 下载并解压缩 配置 .bash_profile : ...

- Spark——Standalone 环境安装及简单使用

Standalone 环境安装 将 spark-3.0.0-bin-hadoop3.2.tgz 文件解压缩在指定位置(/opt/module) tar -zxvf spark-3.0.0-bin-ha ...

- Hive On Spark环境搭建

Spark源码编译与环境搭建 Note that you must have a version of Spark which does not include the Hive jars; Spar ...

- Spark入门实战系列--2.Spark编译与部署(下)--Spark编译安装

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .编译Spark .时间不一样,SBT是白天编译,Maven是深夜进行的,获取依赖包速度不同 ...

- 在MacOs上配置Hadoop和Spark环境

在MacOs上配置hadoop和spark环境 Setting up Hadoop with Spark on MacOs Instructions 准备环境 如果没有brew,先google怎样安装 ...

随机推荐

- 微信公众号支付JSAPI,提示:2支付缺少参数:appId

因为demo中支付金额是定死的,所以需要调整. 所以在使用的JS上添加了参数传入.这里的传入string类型的参数,直接使用是错误的,对于方法,会出现appid缺少参数的错误 //调用微信JS api ...

- 数据提交方式:post和get

众所周知,在B/S应用程序中,前台与后台的数据交互,都是通过HTML中Form表单完成的.而Form提供了两种数据传输的方式——get和post. Get请求表示客户端请求一个ur ...

- c++11——基于范围的for循环

c++11中有基于范围的for循环,基于范围的for循环可以不再关心迭代器的概念,只需要关系容器中的元素类型即可,同时也不必显式的给出容器的开头和结尾. int arr[] = {1, 2, 3, 4 ...

- java 集合之HashMap

原文出处http://zhangshixi.iteye.com/blog/672697 1. HashMap概述: HashMap是基于哈希表的Map接口的非同步实现.此实现提供所有可选的映射操 ...

- LeetCode——Search Insert Position

Description: Given a sorted array and a target value, return the index if the target is found. If no ...

- pvm虚拟机基本原理

零.绪论:特别鸣谢下文博客,自己博客是对这篇博客的学习笔记: 大佬webber博客:https://www.cnblogs.com/webber1992/p/6597166.html 一.三种文件: ...

- 代码片段,lucene基本操作(基于lucene4.10.2)

1.最基本的创建索引: @Test public void testIndex(){ try { Directory directory = FSDirectory.open(new File(LUC ...

- 一、微信小游戏开发 --- 初次在微信开发者工具里跑Egret小游戏项目

尝试下Egret的小游戏开发,学习,学习,干IT,不学习,就得落后啊... 相关教程: Egret微信小游戏教程 微信公众平台-微信小游戏教程 微信公众平台-微信小游戏接入指南 开发版本: Egret ...

- Windows Phone 在读取网络图片之前先显示默认图片

1.新建一个控件WindowsPhoneControl1 WindowsPhoneControl1.xaml <UserControl x:Class="DefaultImage.Wi ...

- windows服务的默认启动类型和登录帐户

转自:http://www.winhelponline.com/blog/windows-7-services-default-startup-type/ Service Name Startup T ...