24-hadoop-hiveserver2&jdbc-正则数据导入

hive 可以 类似jdbc链接, 但启动的必须是hiveserver2, 才可以使用

hiveserver2

默认监听 10000 端口

1, 启动:

nohup $HIVE_HOME/bin/hiveserver2 1>/dev/null 2>&1 &

重定向输出, 不干扰shell界面

nohup 用户退出, 也可以继续执行

或者

$HIVE_HOME/bin/hive --service hiveserver2 1>/dev/null 2>&1 &

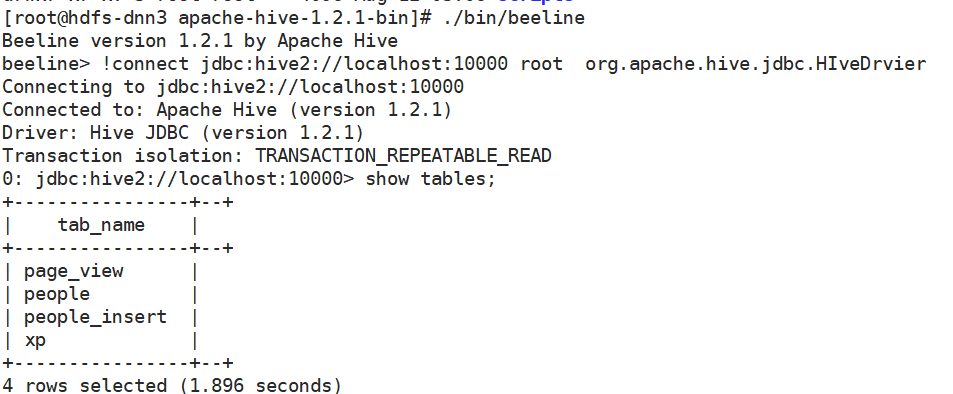

2, 使用 Beeline 进行连接

beelin

使用beeline链接, 和普通的hive是一样的, 只不过是远程的方式连接的, 操作命令几乎相同

!connect jdbc:hive2://192.168.208.109:10000 username password // org.apache.hive.jdbc.HIveDrvier

因为密码为空, 所以不需要写

!connect jdbc:hive2://localhost:10000 root // org.apache.hive.jdbc.HIveDrvier

可以直接链接

beelin -u jdbc:hive2://.. -n root

3, 退出

!quit

JDBC链接

java链接:

1, 导入jar包:

${HIVE_HOME}/lib下的所有包

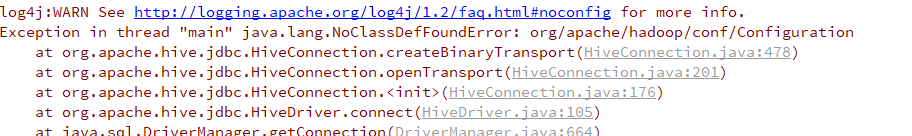

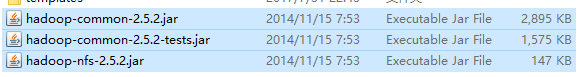

2, 导入hadoop的包, 否则报错

导入的包为:

${HADOOP_HOME}/share/hadoop/common/*

package com.wenbronk.hive; import java.sql.*; /**

*

*/

public class JDBCMain { private static String driverName = "org.apache.hive.jdbc.HiveDriver"; public static void main(String[] args) throws SQLException {

try {

Class.forName(driverName);

Connection con = DriverManager.getConnection("jdbc:hive2://192.168.208.109:10000/default", "root", ""); String sql = "select * from people";

PreparedStatement state = con.prepareStatement(sql); ResultSet res = state.executeQuery(); while (res.next()) {

System.out.println(res.getString() + "\t" + res.getString());

} } catch (ClassNotFoundException e) {

e.printStackTrace();

System.exit();

}finally {

//close

}

}

}

官网的例子坑太多了, python的链接没有实际操作, 改天试下并修改!!!!

python 链接

需要先安装包

pip install pyhs2

然后链接:

import pyhs2 with pyhs2.connect(host='localhost',

port=,

authMechanism="PLAIN",

user='root',

password='',

database='default') as conn:

with conn.cursor() as cur:

#Show databases

print cur.getDatabases() #Execute query

cur.execute("select * from table") #Return column info from query

print cur.getSchema() #Fetch table results

for i in cur.fetch():

print i

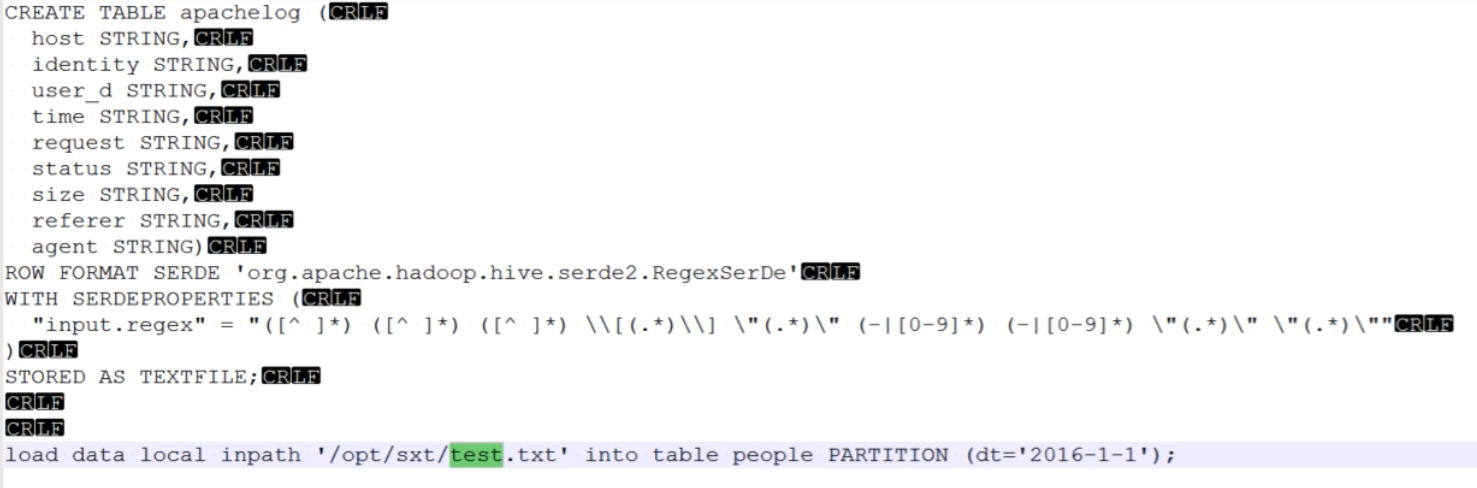

使用正则导入不规则数据

使用regexBuddy, 来正确匹配正则表达式

匹配nignx日志;

系列来自尚学堂极限班

24-hadoop-hiveserver2&jdbc-正则数据导入的更多相关文章

- Sqoop -- 用于Hadoop与关系数据库间数据导入导出工作的工具

Sqoop是一款开源的工具,主要用于在Hadoop相关存储(HDFS.Hive.HBase)与传统关系数据库(MySql.Oracle等)间进行数据传递工作.Sqoop最早是作为Hadoop的一个第三 ...

- 从零自学Hadoop(16):Hive数据导入导出,集群数据迁移上

阅读目录 序 导入文件到Hive 将其他表的查询结果导入表 动态分区插入 将SQL语句的值插入到表中 模拟数据文件下载 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并 ...

- 从零自学Hadoop(17):Hive数据导入导出,集群数据迁移下

阅读目录 序 将查询的结果写入文件系统 集群数据迁移一 集群数据迁移二 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephis ...

- 使用sqoop将mysql数据导入到hadoop

hadoop的安装配置这里就不讲了. Sqoop的安装也很简单. 完成sqoop的安装后,可以这样测试是否可以连接到mysql(注意:mysql的jar包要放到 SQOOP_HOME/lib 下): ...

- Hive数据导入——数据存储在Hadoop分布式文件系统中,往Hive表里面导入数据只是简单的将数据移动到表所在的目录中!

转自:http://blog.csdn.net/lifuxiangcaohui/article/details/40588929 Hive是基于Hadoop分布式文件系统的,它的数据存储在Hadoop ...

- Hadoop Hive概念学习系列之HDFS、Hive、MySQL、Sqoop之间的数据导入导出(强烈建议去看)

Hive总结(七)Hive四种数据导入方式 (强烈建议去看) Hive几种数据导出方式 https://www.iteblog.com/archives/955 (强烈建议去看) 把MySQL里的数据 ...

- 用JDBC把Excel中的数据导入到Mysql数据库中

步骤:0.在Mysql数据库中先建好table 1.从Excel表格读数据 2.用JDBC连接Mysql数据库 3.把读出的数据导入到Mysql数据库的相应表中 其中,步骤0的table我是先在Mys ...

- 大数据学习day26----hive01----1hive的简介 2 hive的安装(hive的两种连接方式,后台启动,标准输出,错误输出)3. 数据库的基本操作 4. 建表(内部表和外部表的创建以及应用场景,数据导入,学生、分数sql练习)5.分区表 6加载数据的方式

1. hive的简介(具体见文档) Hive是分析处理结构化数据的工具 本质:将hive sql转化成MapReduce程序或者spark程序 Hive处理的数据一般存储在HDFS上,其分析数据底 ...

- 通过 Sqoop1.4.7 将 Mysql5.7、Hive2.3.4、Hbase1.4.9 之间的数据导入导出

目录 目录 1.什么是 Sqoop? 2.下载应用程序及配置环境变量 2.1.下载 Sqoop 1.4.7 2.2.设置环境变量 2.3.设置安装所需环境 3.安装 Sqoop 1.4.7 3.1.修 ...

- sqoop1的安装以及数据导入导出测试

下载 wget http://mirror.bit.edu.cn/apache/sqoop/1.4.7/sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz 解压 tar -zxf ...

随机推荐

- leetcode - [2]Evaluate Reverse Polish Notation

Evaluate Reverse Polish Notation Total Accepted: 24595 Total Submissions: 123794My Submissions Evalu ...

- centos修改主机名命令

centos修改主机名命令 需要修改两处:一处是/etc/sysconfig/network,另一处是/etc/hosts,只修改任一处会导致系统启动异常.首先切换到root用户. vi / ...

- 第86讲:Scala中For表达式的生成器、定义和过滤器

今天我们来看一下For表达式中的生成器,定义和过滤等内容. 让我们来看下代码 def main(args:Array[String]){ val lauren = Persons(" ...

- jQuery插件初级练习4答案

html: $("p").log().css("color","red") jQuery: $.fn.extend({ log: funct ...

- 冲刺博客NO.1

今天小组开了一个会议来对APP进行模块分析,从客户需求 隐私问题到 界面设计大致定了一个方向并分工. 做的内容:对自己负责的模块进行了粗略的划分和认识,学会了如何页面跳转. 我负责的是登录界面,主界 ...

- Alpha阶段scrum meeting七天冲刺博客-天冷记得穿秋裤队

Alpha阶段scrum meeting七天冲刺博客 day url 第一天 https://www.cnblogs.com/laomiXD/articles/9874052.html 第二天 htt ...

- unigui作中间件使用

unigui作中间件使用 可返回string或者tstream数据. 如果返回JSON字符,则UNIGUI就是REST 中间件. procedure TUniServerModule.UniGUISe ...

- .Net 持续集成 —— windows service

上一篇讲了 Jenkins+WebDeploy+IIS完成 web项目部署,这篇继续讲windows service的部署. windows service 一般用于自动任务,定时完成某些操作.本文自 ...

- .NET Core 常用加密和Hash工具NETCore.Encrypt

前言 在日常开发过程中,不可避免的涉及到数据加密解密(Hash)操作,所以就有想法开发通用工具,NETCore.Encrypt就诞生了.目前NETCore.Encrypt只支持.NET Core ,工 ...

- 人工智能_机器学习——pandas - 箱型图

箱型图对数据的展示也是非常清晰的,这是箱型图的一些代码 #导报 机器学习三剑客 import numpy as np import pandas as pd from matplotlib impor ...