golang版并发爬虫

准备爬取内涵段子的几则笑话,先查看网址:http://www.budejie.com/text/

简单分析后发现每页的url呈加1趋势

第一页: http://www.budejie.com/text/1

第二页:http://www.budejie.com/text/2

...

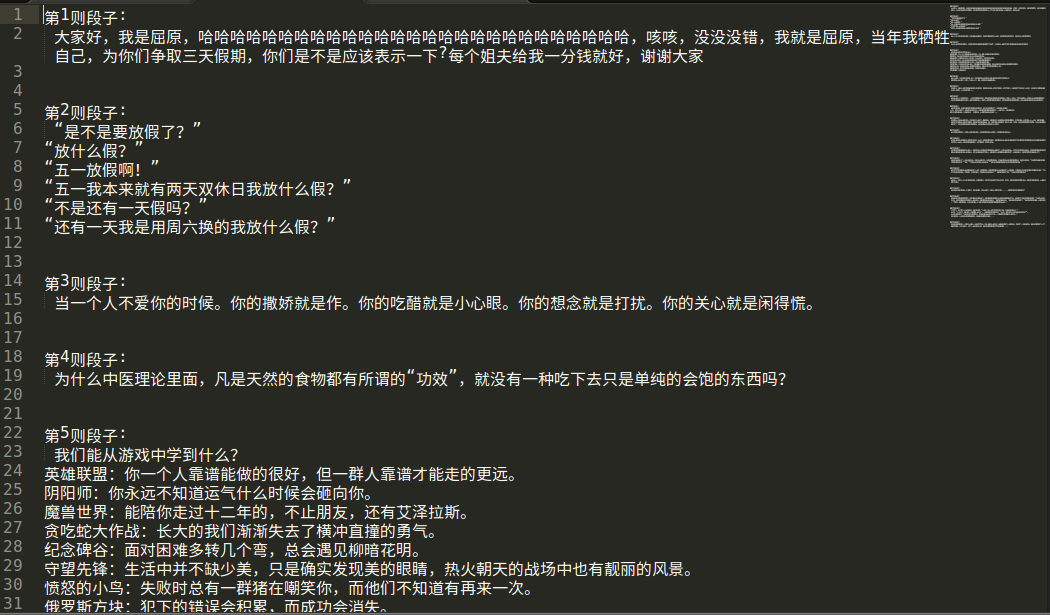

每页的段子:

<a href="/detail-28278217.html"> 内容</a>

<a href="/detail-28270675.html"> 内容</a>

....

所以正则表达式的解释规则是<a href="/detail-\d{8}.html">(?s:(.*?))</a>,第一个分组的内容就是需要的文字。

代码如下:

package main

import (

"fmt"

"regexp"

"strconv"

"net/http"

"log"

"os"

"strings"

) func onespider(n int, ch chan int) {

url := "http://www.budejie.com/text/" + strconv.Itoa(n)

resp, err := http.Get(url)

if err != nil {

log.Fatal("get error")

}

defer resp.Body.Close()

reg, err1 := regexp.Compile(`<a href="/detail-\d{8}.html">(?s:(.*?))</a>`)

if err1 != nil {

log.Fatal("compile error")

}

var respstring string

buf := make([]byte, )

for {

n, _ := resp.Body.Read(buf)

if n == {

break

}

respstring += string(buf[:n])

} cont := reg.FindAllStringSubmatch(respstring, -)

file, _ := os.OpenFile("./爬虫/"+"第"+strconv.Itoa(n)+"页爬虫.txt", os.O_RDWR|os.O_TRUNC|os.O_CREATE, )

defer file.CLose()

var i int

for _, value := range cont {

if len(value[]) < {

continue

}

value[] = strings.Replace(value[], "<br />", "\n", -)

index := strconv.Itoa(i+)

file.Write([]byte("第"+index+"则段:\n"+value[]+"\n\n\n"))

i++

}

ch <- n

}

func Spider(s, e int) {

ch := make(chan int)

for i := s; i <= e; i++ {

go onespider(i, ch)

}

for i := s; i <= e; i++ {

n := <- ch

fmt.Printf("第%d页爬取完毕\n", n)

}

}

func main(){

var start, end int

fmt.Println("输入起始页")

fmt.Scan(&start)

fmt.Println("输入终止页")

fmt.Scan(&end)

Spider(start, end)

}

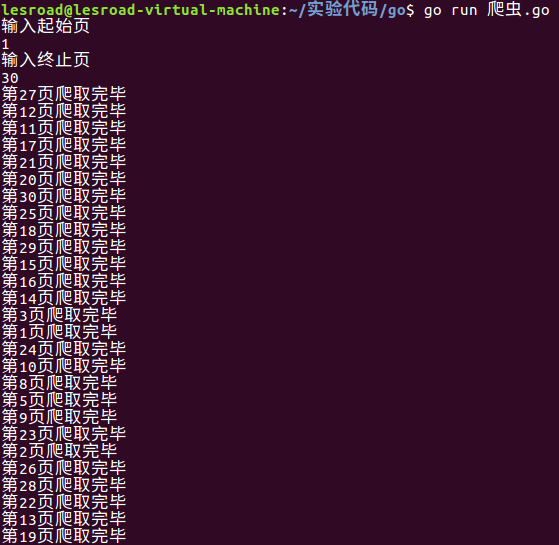

运行截图:

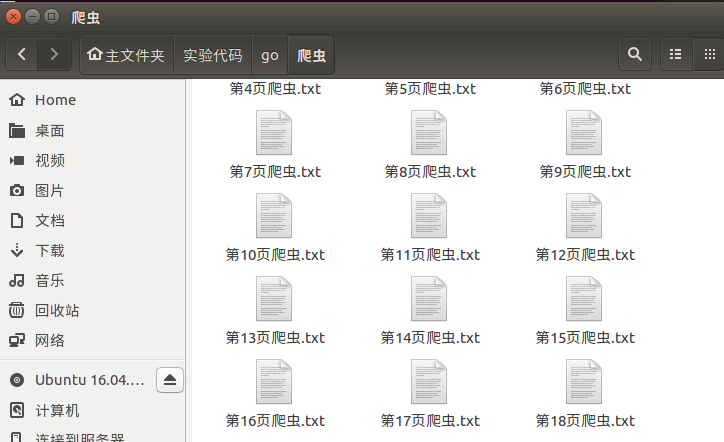

效果截图:

最后我发现第2页之后的段子都是重复的。。。

golang版并发爬虫的更多相关文章

- golang实现并发爬虫三(用队列调度器实现)

欲看此文,必先可先看: golang实现并发爬虫一(单任务版本爬虫功能) gollang实现并发爬虫二(简单调度器) 上文中的用简单的调度器实现了并发爬虫. 并且,也提到了这种并发爬虫的实现可以提高爬 ...

- golang实现并发爬虫一(单任务版本爬虫功能)

目的是写一个golang并发爬虫版本的演化过程. 那么在演化之前,当然是先跑通一下单任务版本的架构. 正如人走路之前是一定要学会爬走一般. 首先看一下单任务版本的爬虫架构,如下: 这是单任务版本爬虫的 ...

- golang实现并发爬虫二(简单调度器)

上篇文章当中实现了单任务版爬虫. 那么这篇文章就大概说下,如何在上一个版本中进行升级改造,使之成为一个多任务版本的爬虫.加快我们爬取的速度. 话不多说,先看图: 其实呢,实现方法就是加了一个sched ...

- golang的并发

Golang的并发涉及二个概念: goroutine channel goroutine由关键字go创建. channel由关键字chan定义 channel的理解稍难点, 最简单地, 你把它当成Un ...

- Golang版protobuf编译

官方网址: https://developers.google.com/protocol-buffers/ (需要FQ) 代码仓库: https://github.com/google/protobu ...

- golang的并发不等于并行

先 看下面一道面试题: func main() { runtime.GOMAXPROCS(1) wg := sync.WaitGroup{} wg.Add(20) for i := 0; i < ...

- [Golang] kafka集群搭建和golang版生产者和消费者

一.kafka集群搭建 至于kafka是什么我都不多做介绍了,网上写的已经非常详尽了. 1. 下载zookeeper https://zookeeper.apache.org/releases.ht ...

- Go语言之进阶篇简单版并发服务器

1.简单版并发服务器 示例1: package main import ( "fmt" "net" "strings" ) //处理用户请求 ...

- swing版网络爬虫-丑牛迷你采集器2.0

swing版网络爬虫-丑牛迷你采集器2.0 http://www.javacoo.com/code/704.jhtml 整合JEECMS http://bbs.jeecms.com/fabu/3186 ...

随机推荐

- dubbo总结

一 .Dubbo产生背景 单一应用架构当网站流量很小时,只需一个应用,将所有功能都部署在一起,以减少部署节点和成本.此时,用于简化增删改查工作量的 数据访问框架(ORM) 是关键. 垂直应用架构当访 ...

- python之路 django2

Django请求生命周期 首先:对于所有的web框架来说本质就是一个socket服务端,浏览器是socket客户端 路由系统 在Django的urls中我们可以根据一个URL对应一个函数名来定义路由规 ...

- server2003 IIS 错误 解决

网页无法打开总显示: 无法找到该页您正在搜索的页面可能已经删除.更名或暂时不可用. ---------------------------------------------------------- ...

- spark[源码]-TaskSchedulerlmpl类源码

TaskSchedulerImpl概述 TaskSchedulerlmpl是创建三大核心TaskSheduler的实现类,TaskScheduler是一个特征类,DAGScheduler在提交Task ...

- redis数据持久化内存不足

原因:写数据到redis里面写不进去,查看redis日志显示: Can't save in background: fork: Cannot allocate memory 在小内存的进程上做一个fo ...

- Java并发编程:并发容器之ConcurrentHashMap(转)

本文转自:http://www.cnblogs.com/dolphin0520/p/3932905.html Java并发编程:并发容器之ConcurrentHashMap(转载) 下面这部分内容转载 ...

- Web前端学习笔记之JavaScript、jQuery、AJAX、JSON的区别

官网的英文解释: javascript和jQuery有点关系,js是一种脚本语言,主要用于客户端,现在主要用于实现一些网页效果. jquery是js的一个库,你可以认为是对js的补充,提供了很多方便易 ...

- mspdb100.dll不见了的解决办法

一.如果在运行某软件或编译程序时提示缺少.找不到mspdb100.dll等类似提示,将下载来的mspdb100.dll拷贝到指定目录即可 (一般是system系统目录或放到软件同级目录里面),或者重新 ...

- Learning Phrase Representations using RNN Encoder–Decoder for Statistical Machine Translation

1.主要完成的任务是能够将英文转译为法文,使用了一个encoder-decoder模型,在encoder的RNN模型中是将序列转化为一个向量.在decoder中是将向量转化为输出序列,使用encode ...

- 配置hadoop集群的lzo压缩

MR-Job中使用lzop详见MR案例:Job中使用Lzo压缩 1). 配置前的环境准备 # yum -y install lzo-devel zlib-devel gcc autoconf auto ...