Spark Core核心----RDD常用算子编程

1、RDD常用操作2、Transformations算子3、Actions算子4、SparkRDD案例实战

1、Transformations算子(lazy)

含义:create a new dataset from an existing on 从已经存在的创建一个新的数据集

RDDA---------transformation----------->RDDB

map:map(func)

将func函数作用到数据集的每一个元素上,生成一个新的分布式的

数据集返回

例子:1

data = [1, 2, 3, 4, 5]

rdd1 = sc.parallelize(data)

rdd2 = rdd1.map(lambda x:x*2)

print(rdd2.collect())例子2:

a = sc.parallelize(["dog","tiger","lion","cat","panther","eagle"]).map(lambda x:(x,1))

print(a.collect())结果:

filter(过滤)filter(func)

选出所有func返回值为true的元素,生成一个新的分布式数据集返回

例子:

RDDA = sc.parallelize([1, 2, 3, 4, 5]).map(lambda x:x*2).filter(lambda x:x>5)

print(RDDA.collect())结果:

flatMap() flatMap(func)

输入的item能够被map到0或者多个items输出,返回值是一个Sequence (拆分)

data = ["hello spark","hello word","hello word"]

RDD = sc.parallelize(data)

print(RDD.flatMap(lambda line:line.split(" ")).collect())结果

groupByKey()(把相同的key的数据分发到一起)

data = ["hello spark", "hello word", "hello word"]

RDD = sc.parallelize(data)

RDD2 = RDD.flatMap(lambda line:line.split(" ")).map(lambda x:(x,1))

RDD3 = RDD2.groupByKey()

print(RDD3.map(lambda x:{x[0]:list(x[1])}).collect())结果

reduceByKey(把相同的key的数据分发到一起,并进行相应的计算)

data = ["hello spark", "hello word", "hello word"]

RDD = sc.parallelize(data)

RDD2 = RDD.flatMap(lambda line: line.split(" ")).map(lambda x: (x, 1))

RDD3 = RDD2.reduceByKey(lambda a,b:a+b)

print(RDD3.collect())结果

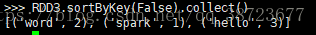

sortByKey()默认按照key值升序排列

data = ["hello spark", "hello word", "hello word"]

RDD = sc.parallelize(data)

RDD2 = RDD.flatMap(lambda line: line.split(" ")).map(lambda x: (x, 1))

RDD3 = RDD2.reduceByKey(lambda a, b: a + b)

sortRDD = RDD3.sortByKey()

sortRDD.collect()结果

加False参数降序排列

实现按照数字排序

使用map交换一下顺序

union连接(把RDD连接起来)

a = sc.parallelize([1, 2, 3])

b = sc.parallelize([4, 5, 6])

a.union(b).collect()结果

distinct(去除重复)

a = sc.parallelize([1, 2, 3])

b = sc.parallelize([4, 3, 3])

a.union(b).distinct().collect()结果

join(内连接,左外连接,右外连接)

a = sc.parallelize([("A","a1"),("C","c1"),("D","d1"),("F","f1"),("F","f2")])

b = sc.parallelize([("A","a2"),("C","c2"),("C","c3"),("E","e1")])

a.join(b).collect() # 内连接

a.rightOuterJoin(b).collect() # 右外连接

a.leftOuterJoin(b).collect() # 左外连接

a.fullOuterJoin(b).collect() # 全连接内连接:

得到两者key值相同的值的集合

右外连接:以右表key为基准进行连接

左外连接:以左表以右表key为基准进行连接

全连接:左右连接的并集所有的都出来

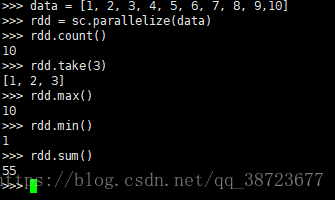

2、Actions算子

含义:return a value to the driver program after running acomputation on the dataset

data = [1, 2, 3, 4, 5, 6, 7, 8, 9,10]

rdd = sc.parallelize(data)

rdd.count() # 数量

rdd.take(3) # 前几个

rdd.max() # 最大值

rdd.min() # 最小值

rdd.sum() # 求和

rdd.reduce(lambda x,y:x+y) # 求和

rdd.foreach(lambda x:print(x)) #foreach遍历

rdd.saveAsTextFile #写入文件系统结果:

Spark Core核心----RDD常用算子编程的更多相关文章

- Spark的核心RDD(Resilient Distributed Datasets弹性分布式数据集)

Spark的核心RDD (Resilient Distributed Datasets弹性分布式数据集) 原文链接:http://www.cnblogs.com/yjd_hycf_space/p/7 ...

- spark——详解rdd常用的转化和行动操作

本文始发于个人公众号:TechFlow,原创不易,求个关注 今天是spark第三篇文章,我们继续来看RDD的一些操作. 我们前文说道在spark当中RDD的操作可以分为两种,一种是转化操作(trans ...

- Spark学习之路(四)—— RDD常用算子详解

一.Transformation spark常用的Transformation算子如下表: Transformation算子 Meaning(含义) map(func) 对原RDD中每个元素运用 fu ...

- Spark 系列(四)—— RDD常用算子详解

一.Transformation spark 常用的 Transformation 算子如下表: Transformation 算子 Meaning(含义) map(func) 对原 RDD 中每个元 ...

- 4.RDD常用算子之transformations

RDD Opertions transformations:create a new dataset from an existing one RDDA --> RDDB ...

- 理解Spark的核心RDD

http://www.infoq.com/cn/articles/spark-core-rdd/

- spark core (二)

一.Spark-Shell交互式工具 1.Spark-Shell交互式工具 Spark-Shell提供了一种学习API的简单方式, 以及一个能够交互式分析数据的强大工具. 在Scala语言环境下或Py ...

- spark学习(10)-RDD的介绍和常用算子

RDD(弹性分布式数据集,里面并不存储真正要计算的数据,你对RDD的操作,他会在Driver端转换成Task,下发到Executor计算分散在多台集群上的数据) RDD是一个代理,你对代理进行操作,他 ...

- Spark Streaming核心概念与编程

Spark Streaming核心概念与编程 1. 核心概念 StreamingContext Create StreamingContext import org.apache.spark._ im ...

随机推荐

- java集合(3)-Java8新增的Stream操作集合

Java8新增了Stream,IntStream,LongStream,DoubleStream等流式API,这些API代表多个支持串行和并行聚集操作的元素.上面的4个接口中,Stream是一个通用的 ...

- Leetcode No.14 Longest Common Prefix最长公共前缀(c++实现)

1. 题目 1.1 英文题目 Write a function to find the longest common prefix string amongst an array of strings ...

- R绘图(7): 把散点图的点换成扇形

前几天分析了一批单细胞TCR的数据,需要画这样一个图: 行是不同的样本,列是不同的T细胞类型,每一个位置点的大小表示T细胞的数目多少,并且还需要根据T细胞所属的克隆型类型涂色.这个图用来描述TCR是我 ...

- 怎么添加对Shopify 的WebHook 验证

怎么添加对Shopify 的WebHook 验证 背景介绍 Shopify 是一家一站式SaaS 模式的电商服务平台,总部位于加拿大首都渥太华,专注于为跨境电商用户提供海外品牌建立及销售渠道管理.为电 ...

- PAT乙级:1076 Wifi密码 (15分)

PAT乙级:1076 Wifi密码 (15分) 题干 下面是微博上流传的一张照片:"各位亲爱的同学们,鉴于大家有时需要使用 wifi,又怕耽误亲们的学习,现将 wifi 密码设置为下列数学题 ...

- DNS Bind日志详述

简介 在默认情况下,BIND9 把日志消息写到 /var/log/messages 文件中,而这些日志消息是非常少的,主要就是启动,关闭的日志记录和一些严重错误的消息:而将调试日志信息写入 BIND ...

- Winform中生成自动控件

场景: 前几天项目需要模拟数据,但是实际设备还没有接上,就自己用Winform搭建了一个数据模拟器,生成数据给平台.这里又一个需求,就是从数据库中找出设备,然后自动生成控件,勾选就表示开启该设备,能上 ...

- Windows服务器如何磁盘分区,Windows服务器磁盘分区常见的三种

原文来自:https://www.sohu.com/a/272133008_100217178 我怕链接会失效,故转载此篇文章,解析得很透彻,一目了然!记录. -------------------- ...

- Nginx 配置错误导致漏洞

目录 1.CRLF注入漏洞 2.目录穿越漏洞 参考链接 1.CRLF注入漏洞 CRLF是"回车+换行"(\r\n)的简称,其十六进制编码分别为0x0d和0x0a.先看payload ...

- 靶机CH4INRULZ_v1.0.1

nmap开路. root@kali:~# nmap -sP 192.168.1.* //拿到靶机地址192.168.1.8 root@kali:~# nmap -p- -sS -v -sV 192.1 ...