solr8.2 环境搭建 配置中文分词器 ik-analyzer-solr8 详细步骤

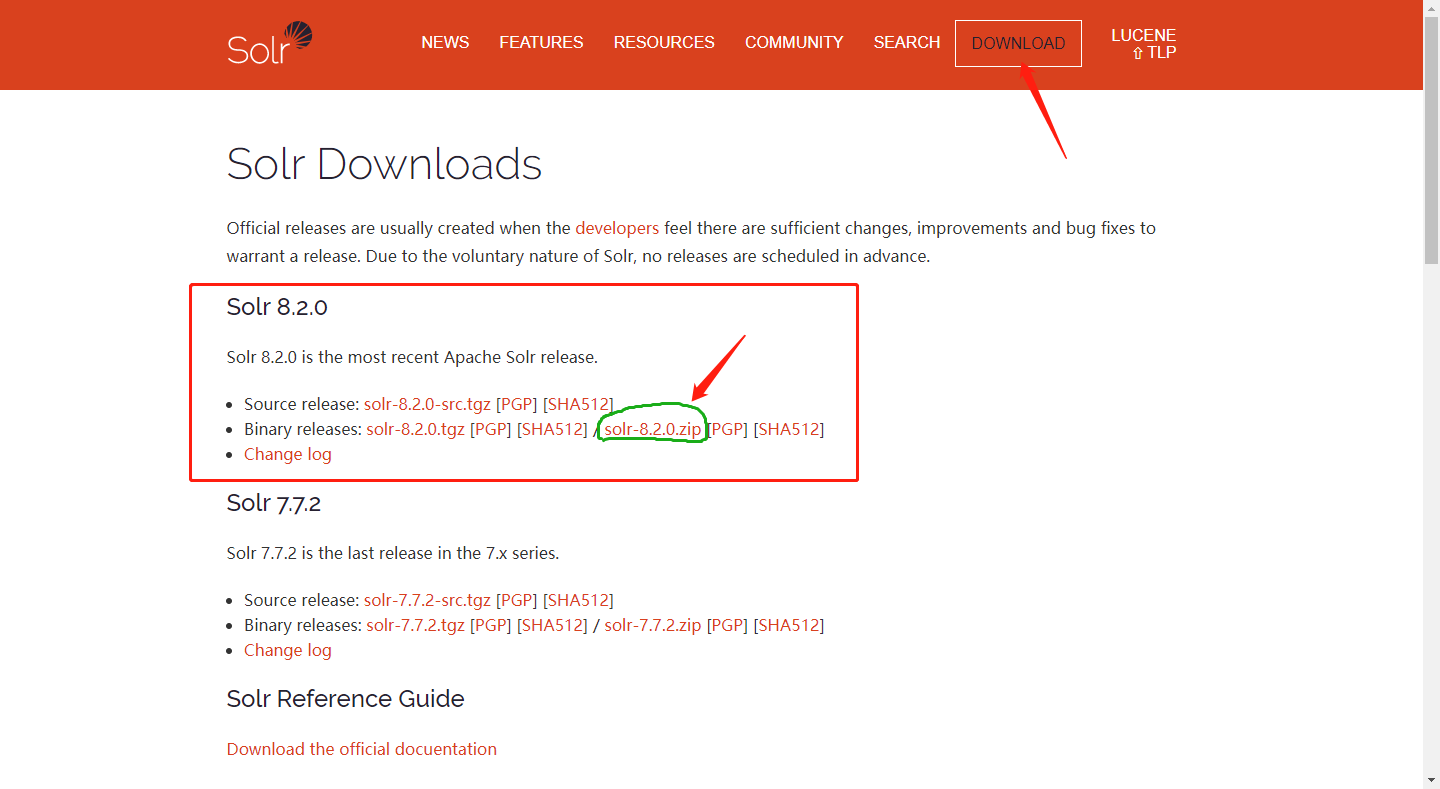

一、下载安装Apache Solr 8.2.0

下载地址:http://lucene.apache.org/solr/downloads.html

因为是部署部署在windows系统上,所以下载zip压缩包即可。

下载完成后解压出来。

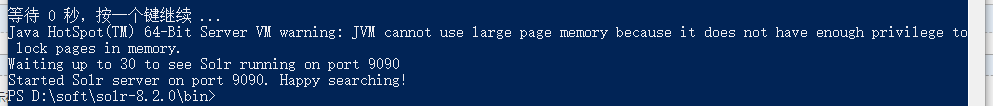

二、启动solr服务

进入solr-7.3.0/bin目录:

Shift+右键 在此处打开命令窗口;

在控制台输入以下命令:

./solr start -p 9090

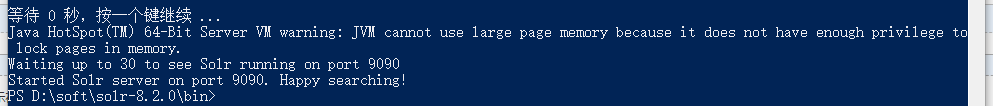

看到Started Solr server on port 9090. Happy searching!表示solr服务已经启动成功,这里是用solr自带的jetty启动的。

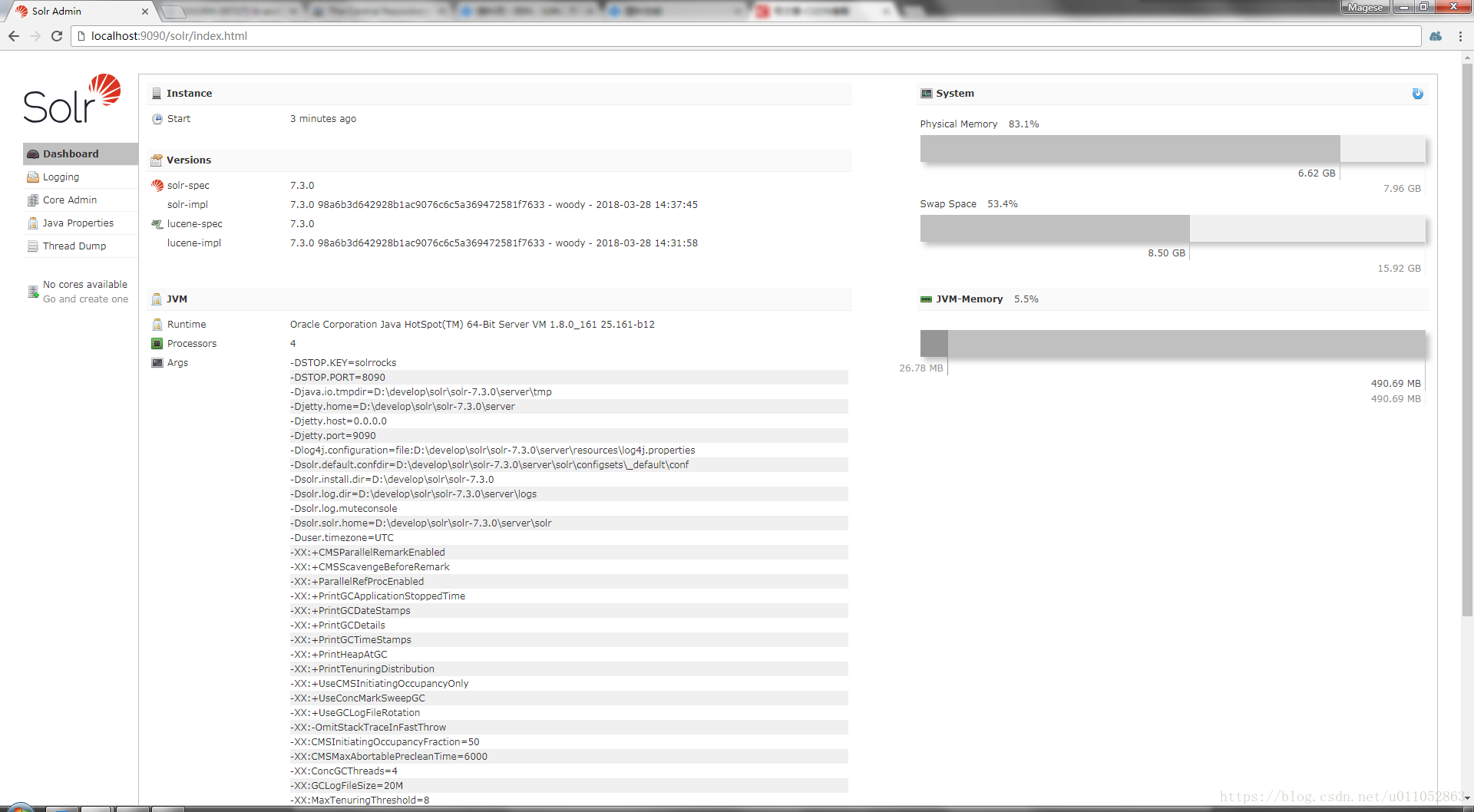

接下来我们可以打开浏览器访问:http://localhost:9090/solr/index.html

就可以看到solr已经成功启动了。

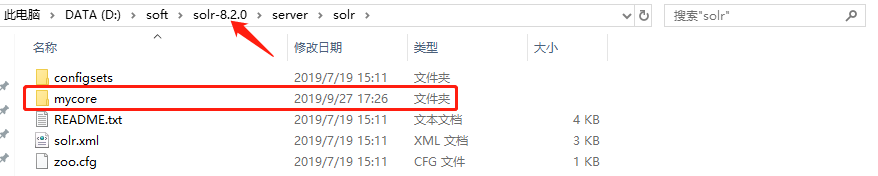

三、添加solr core

先进入solr-7.3.0/example/example-DIH/solr/solr目录中

将该目录中的conf文件夹与core.properties文件copy

接下来我们进入solr-7.3.0/server/solr目录

在此目录创建一个文件夹mycore

然后我们将上面的conf文件夹和core.properties文件copy到此文件夹中

接下来在之前启动的cmd窗口重启一下solr服务,在控制台输入以下命令:

./solr restart -p 9090

重启完成后刷新一下http://localhost:9090/solr/index.html页面,

发现solr core已经添加成功了

四、配置中文分词器 IK-Analyzer-Solr8

先下载solr8版本的ik分词器,下载地址:https://search.maven.org/search?q=com.github.magese

分词器GitHub源码地址:https://github.com/magese/ik-analyzer-solr8

GitHub上有分词器的使用方式

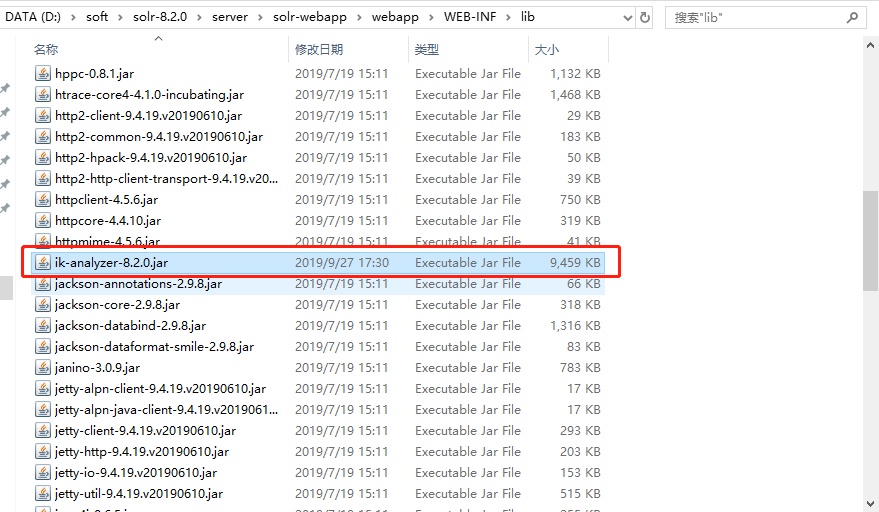

将下载好的jar包放入solr-7.3.0/server/solr-webapp/webapp/WEB-INF/lib目录中

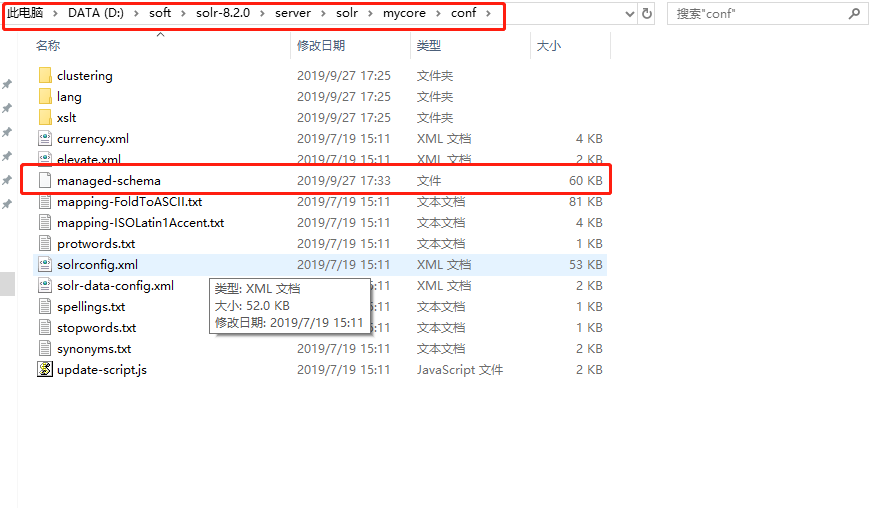

然后到solr-7.3.0/server/solr/mycore/conf目录中打开managed-schema文件

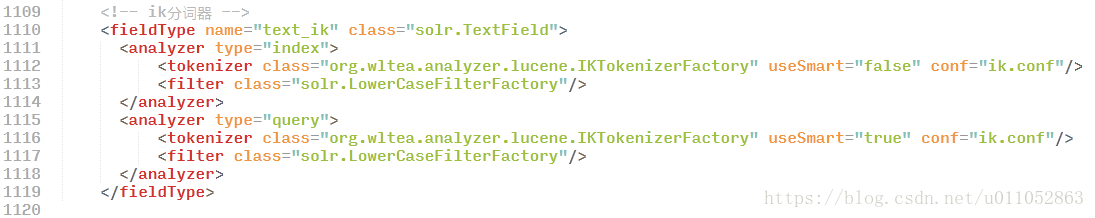

在配置文件中加入以下代码:

<!-- ik分词器 -->

<fieldType name="text_ik" class="solr.TextField">

<analyzer type="index">

<tokenizer class="org.wltea.analyzer.lucene.IKTokenizerFactory" useSmart="false" conf="ik.conf"/>

<filter class="solr.LowerCaseFilterFactory"/>

</analyzer>

<analyzer type="query">

<tokenizer class="org.wltea.analyzer.lucene.IKTokenizerFactory" useSmart="true" conf="ik.conf"/>

<filter class="solr.LowerCaseFilterFactory"/>

</analyzer>

</fieldType>

配置完成后再次重启一次solr服务

./solr restart -p 9090

再次刷新http://localhost:9090/solr/index.html页面

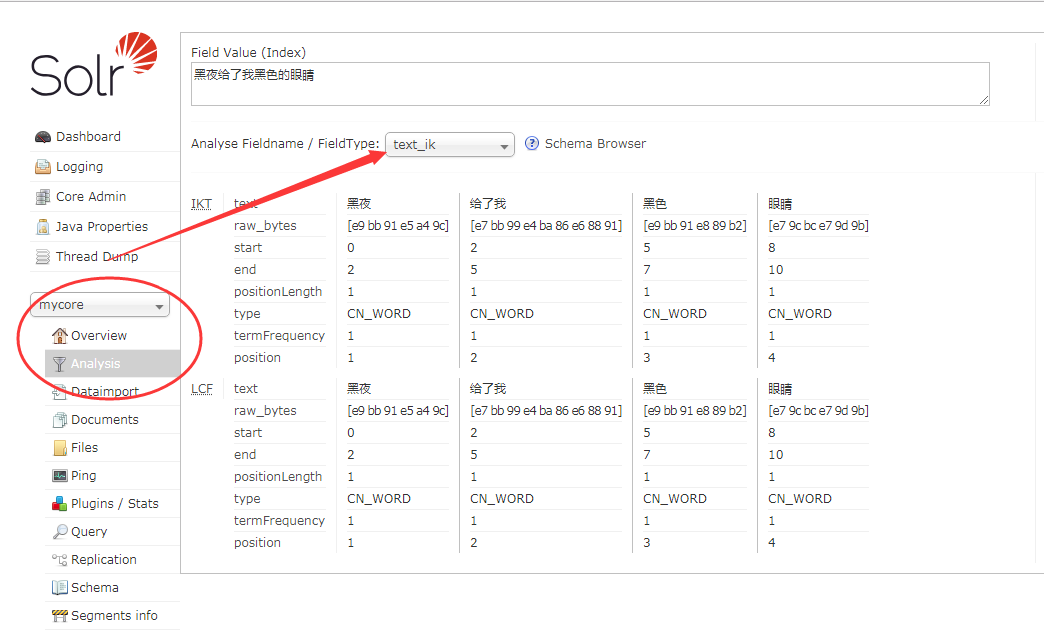

选择mycore -> Analysis -> 选择分词器 text_ik 输入 "黑夜给了我黑色的眼睛"

点击"Analyse Values"按钮可以看到结果已经分词成功了。

solr8.2 环境搭建 配置中文分词器 ik-analyzer-solr8 详细步骤的更多相关文章

- 转:solr6.0配置中文分词器IK Analyzer

solr6.0中进行中文分词器IK Analyzer的配置和solr低版本中最大不同点在于IK Analyzer中jar包的引用.一般的IK分词jar包都是不能用的,因为IK分词中传统的jar不支持s ...

- 我与solr(六)--solr6.0配置中文分词器IK Analyzer

转自:http://blog.csdn.net/linzhiqiang0316/article/details/51554217,表示感谢. 由于前面没有设置分词器,以至于查询的结果出入比较大,并且无 ...

- ElasticSearch搜索引擎安装配置中文分词器IK插件

近几篇ElasticSearch系列: 1.阿里云服务器Linux系统安装配置ElasticSearch搜索引擎 2.Linux系统中ElasticSearch搜索引擎安装配置Head插件 3.Ela ...

- solrcloud配置中文分词器ik

无论是solr还是luncene,都对中文分词不太好,所以我们一般索引中文的话需要使用ik中文分词器. 三台机器(192.168.1.236,192.168.1.237,192.168.1.238)已 ...

- ElasticSearch7.3学习(十五)----中文分词器(IK Analyzer)及自定义词库

1. 中文分词器 1.1 默认分词器 先来看看ElasticSearch中默认的standard 分词器,对英文比较友好,但是对于中文来说就是按照字符拆分,不是那么友好. GET /_analyze ...

- Solr 配置中文分词器 IK

1. 下载或者编译 IK 分词器的 jar 包文件,然后放入 ...\apache-tomcat-8.5.16\webapps\solr\WEB-INF\lib\ 这个 lib 文件目录下: IK 分 ...

- 5.Solr4.10.3中配置中文分词器

转载请出自出处:http://www.cnblogs.com/hd3013779515/ 1.下载IK Analyzer 2012FF_hf1.zip并上传到/home/test 2.按照如下命令安装 ...

- 沉淀再出发:ElasticSearch的中文分词器ik

沉淀再出发:ElasticSearch的中文分词器ik 一.前言 为什么要在elasticsearch中要使用ik这样的中文分词呢,那是因为es提供的分词是英文分词,对于中文的分词就做的非常不好了 ...

- 如何在Elasticsearch中安装中文分词器(IK)和拼音分词器?

声明:我使用的Elasticsearch的版本是5.4.0,安装分词器前请先安装maven 一:安装maven https://github.com/apache/maven 说明: 安装maven需 ...

随机推荐

- jQuery BlockUI Plugin Demo

1.Login Form $(document).ready(function() { $('#demo1').click(function() { $.blockUI({ message: $('# ...

- Python3多重继承排序原理(C3算法)

参考:https://www.jianshu.com/p/c9a0b055947b https://xubiubiu.com/2019/06/10/python-%E6%96%B9%E6%B3%95% ...

- git 提交大小超过100M

#MsnDialog.ad, #MyMoveAd, #QQ_Full, #ad-SNSSplashAd, #ad6cn, #adBody07, #adLeftFloat, #adRightFloat, ...

- leetcode903 Valid Permutations for DI Sequence

思路: dp[i][j]表示到第i + 1个位置为止,并且以剩下的所有数字中第j + 1小的数字为结尾所有的合法序列数. 实现: class Solution { public: int numPer ...

- Npcap.例子(raw tcp syn)

1.来自:winpcap实现syn攻击 - 125096 - CSDN博客.html(https://blog.csdn.net/qq125096885/article/details/5178452 ...

- word模板文档填充数据

1.切记一定要用Word 97-2003(*.doc)格式的文档另存为 *.xml格式的文件,而不能用 Word 2007(*.docx)格式的word文档转 *.xml,将转成功之后的xml文件放入 ...

- storm是如何保证at least once语义的?

storm中的一些原语: 要说明上面的问题,得先了解storm中的一些原语,比如: tuple和messagetuple:在storm中,消息是通过tuple来抽象表示的,每个tuple知道它从哪里来 ...

- Fiddler之手机抓包

1.Fiddle设置端口,Tools->Options->Connections, 2.手机设置代理服务器: 注意:要保证手机和PC电脑IP在同一个网段(或者同一个网关) (1).安卓手机 ...

- LayUI笔记

LayUI 经典模块化前端框架,低门槛开箱即用的前端 UI 解决方案. 其他UI框架: Bootstrap,Element, EasyUI,LayUI 等等 LayUI使用 Layui ...

- python实现文件搜索工具(简易版)

在python学习过程中有一次需要进行GUI 的绘制, 而在python中有自带的库tkinter可以用来简单的GUI编写,于是转而学习tkinter库的使用. 学以致用,现在试着编写一个简单的磁文件 ...