使用Xpath+多进程爬取诗词名句网的史书典籍类所有文章。update~

上次写了爬取这个网站的程序,有一些地方不完善,而且爬取速度较慢,今天完善一下并开启多进程爬取,速度就像坐火箭。。

# 需要的库

from lxml import etree

import requests

from multiprocessing import Pool

# 请求头

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'

}

# 保存文本的地址

pathname=r'E:\爬虫\诗词名句网\\'

# 获取书籍名称的函数

def get_book(url):

try:

response = requests.get(url,headers)

etrees = etree.HTML(response.text)

url_infos = etrees.xpath('//div[@class="bookmark-list"]/ul/li')

urls = []

for i in url_infos:

url_info = i.xpath('./h2/a/@href')

book_name = i.xpath('./h2/a/text()')[0]

print('开始下载.'+book_name)

urls.append('http://www.shicimingju.com' + url_info[0])

# print('http://www.shicimingju.com'+url_info[0])

# get_index('http://www.shicimingju.com'+url_info[0])

# 开启多进程

pool.map(get_index,urls)

except Exception:

print('get_book failed')

# 获取书籍目录的函数

def get_index(url):

try:

response = requests.get(url, headers)

etrees = etree.HTML(response.text)

url_infos = etrees.xpath('//div[@class="book-mulu"]/ul/li')

for i in url_infos:

url_info = i.xpath('./a/@href')

# print('http://www.shicimingju.com' + url_info[0])

get_content('http://www.shicimingju.com' + url_info[0])

except Exception as e:

print(e)

# 获取书籍内容并写入.txt文件

def get_content(url):

try:

response = requests.get(url, headers)

etrees = etree.HTML(response.text)

title = etrees.xpath('//div[@class="www-main-container www-shadow-card "]/h1/text()')[0]

content = etrees.xpath('//div[@class="chapter_content"]/p/text()')

if not content:

content = etrees.xpath('//div[@class="chapter_content"]/text()')

content = ''.join(content)

book_name = etrees.xpath('//div[@class="nav-top"]/a[3]/text()')[0]

with open(pathname + book_name + '.txt', 'a+', encoding='utf-8') as f:

f.write(title + '\n\n' + content + '\n\n\n')

print(title + '..下载完成')

else:

content = ''.join(content)

book_name=etrees.xpath('//div[@class="nav-top"]/a[3]/text()')[0]

with open(pathname+book_name+'.txt','a+',encoding='utf-8') as f:

f.write(title+'\n\n'+content+'\n\n\n')

print(title+'..下载完成')

except Exception:

print('get_content failed')

# 程序入口

if __name__ == '__main__':

url = 'http://www.shicimingju.com/book/'

# 开启进程池

pool = Pool()

# 启动函数

get_book(url)

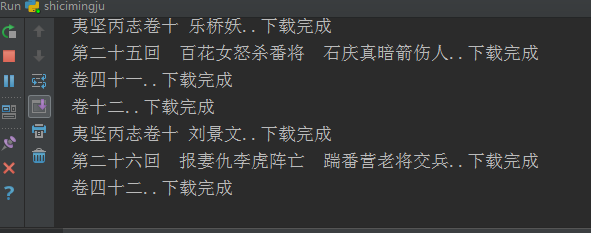

控制台输出;

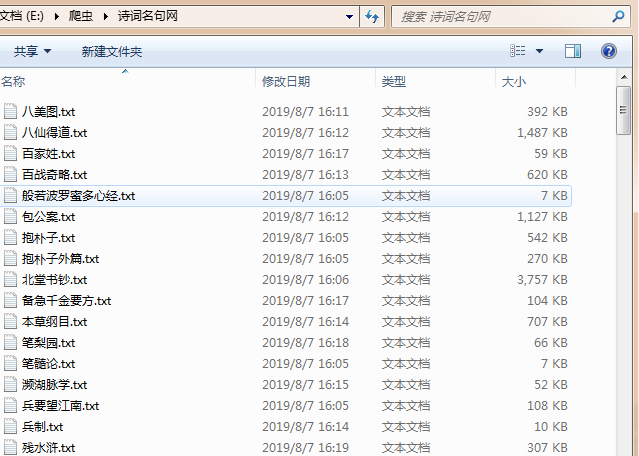

查看文件夹,可以发现文件是多个多个的同时在下载;

done。

使用Xpath+多进程爬取诗词名句网的史书典籍类所有文章。update~的更多相关文章

- 使用Xpath爬虫库下载诗词名句网的史书典籍类所有文章。

# 需要的库 from lxml import etree import requests # 请求头 headers = { 'User-Agent': 'Mozilla/5.0 (Windows ...

- xpath+多进程爬取网易云音乐热歌榜。

用到的工具,外链转换工具 网易云网站直接打开源代码里面并没有对应的歌曲信息,需要对url做处理, 查看网站源代码路径:发现把里面的#号去掉会显示所有内容, 右键打开的源代码路径:view-source ...

- xpath+多进程爬取全书网纯爱耽美类别的所有小说。

# 需要的库 import requests from lxml import etree from multiprocessing import Pool import os # 请求头 heade ...

- xpath+多进程爬取八零电子书百合之恋分类下所有小说。

代码 # 需要的库 import requests from lxml import etree from multiprocessing import Pool import os # 请求头 he ...

- 爬取斗图网图片,使用xpath格式来匹配内容,对请求伪装成浏览器, Referer 防跨域请求

6.21自我总结 一.爬取斗图网 1.摘要 使用xpath匹配规则查找对应信息文件 将请求伪装成浏览器 Referer 防跨域请求 2.爬取代码 #导入模块 import requests #爬取网址 ...

- python爬虫基础应用----爬取校花网视频

一.爬虫简单介绍 爬虫是什么? 爬虫是首先使用模拟浏览器访问网站获取数据,然后通过解析过滤获得有价值的信息,最后保存到到自己库中的程序. 爬虫程序包括哪些模块? python中的爬虫程序主要包括,re ...

- selenium爬取煎蛋网

selenium爬取煎蛋网 直接上代码 from selenium import webdriver from selenium.webdriver.support.ui import WebDriv ...

- Scrapy实战篇(一)之爬取链家网成交房源数据(上)

今天,我们就以链家网南京地区为例,来学习爬取链家网的成交房源数据. 这里推荐使用火狐浏览器,并且安装firebug和firepath两款插件,你会发现,这两款插件会给我们后续的数据提取带来很大的方便. ...

- Python Scrapy 爬取煎蛋网妹子图实例(一)

前面介绍了爬虫框架的一个实例,那个比较简单,这里在介绍一个实例 爬取 煎蛋网 妹子图,遗憾的是 上周煎蛋网还有妹子图了,但是这周妹子图变成了 随手拍, 不过没关系,我们爬图的目的是为了加强实战应用,管 ...

随机推荐

- .NET ftp文件上传和下载

文章参考来源地址:https://blog.csdn.net/wybshyy/article/details/52095542 本次对代码进行了一点扩展:将文件上传到ftp指定目录下,若目录不存在则创 ...

- Zabbix使用第三方API短信报警

之前试过邮件告警,微信告警.但是,对于一些企业的重要业务服务器,可能是存放在隔离的内网中的,无法正常连接外网.这个时候,就有必要考虑一下使用短信告警.以下这个其实还是需要服务器能够连接到外网的,但是我 ...

- Linux——xargs命令学习

有时候我们会遇到需要将指定命令返回结果进行处理的情况 这种情况下,可能就需要写for循环之类的脚本进行处理了(目前我只能想到这种方法) 但是想起来还有一个xargs命令,组合这个命令就比较省事了. 场 ...

- WIN10设置notepad++默认打开txt文件

修改txt的默认打开方式为notepad++.效果如下图所示 修改方式: 1.新建名称为OpenFromNotepad++的txt文档,并将后缀名修改为reg格式(注册表格式),在文件中输入以下内容. ...

- Laradock中文文档

文档地址:https://laradock.linganmin.cn

- (CSDN迁移)JAVA多线程实现-单线程化线程池newSingleThreadExecutor

JAVA通过Executors提供了四种线程池,单线程化线程池(newSingleThreadExecutor).可控最大并发数线程池(newFixedThreadPool).可回收缓存线程池(new ...

- Mybaties的简单使用(全当做复习了)

在使用mybaties的时候,最容易忘掉的是他的动态SQL,不过网上有关这方面的文章很多. 在动态SQl中最常见的几种SQL的语法就是: if choose (when, otherwise) tri ...

- PHP设计模式 - 备忘录模式

备忘录模式又叫做快照模式(Snapshot)或 Token 模式,备忘录模式的用意是在不破坏封装性的前提下,捕获一个对象的内部状态,并在该对象之外保存这个状态,这样就可以在合适的时候将该对象恢复到原先 ...

- Django框架深入了解_05 (Django中的缓存、Django解决跨域流程(非简单请求,简单请求)、自动生成接口文档)

一.Django中的缓存: 前戏: 在动态网站中,用户所有的请求,服务器都会去数据库中进行相应的增,删,查,改,渲染模板,执行业务逻辑,最后生成用户看到的页面. 当一个网站的用户访问量很大的时候,每一 ...

- 打家劫舍I

题目描述(LeetCode) 你是一个专业的小偷,计划偷窃沿街的房屋.每间房内都藏有一定的现金,影响你偷窃的唯一制约因素就是相邻的房屋装有相互连通的防盗系统,如果两间相邻的房屋在同一晚上被小偷闯入,系 ...