文本离散表示(一):词袋模型(bag of words)

一、文本表示

文本表示的意思是把字词处理成向量或矩阵,以便计算机能进行处理。文本表示是自然语言处理的开始环节。

文本表示按照细粒度划分,一般可分为字级别、词语级别和句子级别的文本表示。字级别(char level)的如把“邓紫棋实在太可爱了,我想养一只”这句话拆成一个个的字:{邓,紫,棋,实,在,太,可,爱,了,我,想,养,一,只},然后把每个字用一个向量表示,那么这句话就转化为了由14个向量组成的矩阵。

文本表示分为离散表示和分布式表示。离散表示的代表就是词袋模型,one-hot(也叫独热编码)、TF-IDF、n-gram都可以看作是词袋模型。分布式表示也叫做词嵌入(word embedding),经典模型是word2vec,还包括后来的Glove、ELMO、GPT和最近很火的BERT。

这篇文章介绍一下文本的离散表示。

二、词袋模型

假如现在有1000篇新闻文档,把这些文档拆成一个个的字,去重后得到3000个字,然后把这3000个字作为字典,进行文本表示的模型,叫做词袋模型。这种模型的特点是字典中的字没有特定的顺序,句子的总体结构也被舍弃了。下面分别介绍词袋模型中的one-hot、TF-IDF和n-gram文本表示方法。

(一)one-hot

看一个简单的例子。有两句话“邓紫棋太可爱了,我爱邓紫棋”,“我要看邓紫棋的演唱会”,把这两句话拆成一个个的字,整理得到14个不重复的字,这14个字决定了在文本表示时向量的长度为14。

下面这个表格的第一行是这两句话构成的一个词袋(或者说字典),有14个字。要对两句话进行数值表示,那么先构造一个2×14的零矩阵,然后找到第一句话中每个字在字典中出现的位置,把该位置的0替换为1,第二句话也这样处理。只管字出现了没有(出现了就填入1,不然就是0),而不管这个字在句子中出现了几次。

下面表格中的二、三行就是这两句话的one-hot表示。

|

邓 |

紫 |

棋 |

太 |

可 |

爱 |

了 |

我 |

要 |

看 |

的 |

演 |

唱 |

会 |

|

1 |

1 |

1 |

1 |

1 |

1 |

1 |

1 |

0 |

0 |

0 |

0 |

0 |

0 |

|

1 |

1 |

1 |

0 |

0 |

0 |

0 |

1 |

1 |

1 |

1 |

1 |

1 |

1 |

第一个问题是数据稀疏和维度灾难。数据稀疏也就是向量的大部分元素为0,如果词袋中的字词达数百万个,那么由每篇文档转换成的向量的维度是数百万维,由于每篇文档去重后字数较少,因此向量中大部分的元素是0。而且对数百万维的向量进行计算是一件比较蛋疼的事。

但是这样进行文本表示有几个问题。可见,尽管两个句子的长度不一样,但是one-hot编码后长度都一样了,方便进行矩阵运算。

第二个问题是没有考虑句中字的顺序性,假定字之间相互独立。这意味着意思不同的句子可能得到一样的向量。比如“我太可爱了,邓紫棋爱我”,“邓紫棋要看我的演唱会”,得到的one-hot编码和上面两句话的是一样的。

第三个问题是没有考虑字的相对重要性。这种表示只管字出现没有,而不管出现的频率,但显然一个字出现的次数越多,一般而言越重要(除了一些没有实际意义的停用词)。

接下来用TF-IDF来解决字的相对重要性问题。

(二)TF-IDF

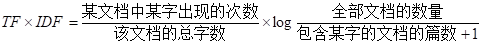

TF-IDF用来评估字词对于文档集合中某一篇文档的重要程度。字词的重要性与它在某篇文档中出现的次数成正比,与它在所有文档中出现的次数成反比。TF-IDF的计算公式为:

下面一步步来理解。

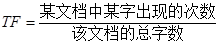

1 TF——词频

TF(term frequency),即词频,用来衡量字在一篇文档中的重要性,计算公式为:

首先统计字典中每个字在句子中出现的频率:

|

邓 |

紫 |

棋 |

太 |

可 |

爱 |

了 |

我 |

要 |

看 |

的 |

演 |

唱 |

会 |

|

2 |

2 |

2 |

1 |

1 |

2 |

1 |

1 |

0 |

0 |

0 |

0 |

0 |

0 |

|

1 |

1 |

1 |

0 |

0 |

0 |

0 |

1 |

1 |

1 |

1 |

1 |

1 |

1 |

为了防止数值过大,将其归一化,其中下表的二、三行构成的就是TF值矩阵。可以看到,第一句话中“邓、紫、棋、爱”这4个字对应的值更大,在第一句中更重要。

|

邓 |

紫 |

棋 |

太 |

可 |

爱 |

了 |

我 |

要 |

看 |

的 |

演 |

唱 |

会 |

|

0.14 |

0.14 |

0.14 |

0.07 |

0.07 |

0.14 |

0.07 |

0.07 |

0 |

0 |

0 |

0 |

0 |

0 |

|

0.07 |

0.07 |

0.07 |

0 |

0 |

0 |

0 |

0.07 |

0.07 |

0.07 |

0.07 |

0.07 |

0.07 |

0.07 |

2 IDF——逆文档频率

IDF((inverse document frequency),叫做逆文档频率,衡量某个字在所有文档集合中的常见程度。当包含某个字的文档的篇数越多时,这个字也就烂大街了,重要性越低。计算公式为:

计算出来的IDF矩阵如下表。值为负或0,因为这个例子比较极端,只有两句话,所以得到了这个极端的结果。“邓、紫、棋、我”这四个字由于在两句话中都出现了,所以得到的IDF值较小。

|

邓 |

紫 |

棋 |

太 |

可 |

爱 |

了 |

我 |

要 |

看 |

的 |

演 |

唱 |

会 |

|

-0.41 |

-0.41 |

-0.41 |

0 |

0 |

0 |

0 |

-0.41 |

0 |

0 |

0 |

0 |

0 |

0 |

最后得到TF-IDF = TF × IDF,这里就不再计算了。

TF-IDF的思想比较简单,但是却非常实用。然而这种方法还是存在着数据稀疏的问题,也没有考虑字的前后信息。

(三)n-gram

上面词袋模型的两种表示方法假设字与字之间是相互独立的,没有考虑它们之间的顺序。于是引入n-gram(n元语法)的概念。n-gram是从一个句子中提取n个连续的字的集合,可以获取到字的前后信息。一般2-gram或者3-gram比较常见。

比如“邓紫棋太可爱了,我爱邓紫棋”,“我要看邓紫棋的演唱会”这两个句子,分解为2-gram词汇表:

{邓,邓紫,紫,紫棋,棋,棋太,太,太可,可,可爱,爱,爱了,了,了我,我,我爱,爱邓,我要,要,要看,看邓,棋的,的,的演,演,演唱,唱会,会}

于是原来只有14个字的1-gram字典(就是一个字一个字进行划分的方法)就成了28个元素的2-gram词汇表,词表的维度增加了一倍。

结合one-hot,对两个句子进行编码得到:

[1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,0]

[1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1,1]

也可以结合TF-IDF来得到文本表示,这里不再计算。

这种表示方法的好处是可以获取更丰富的特征,提取字的前后信息,考虑了字之间的顺序性。

但是问题也是显而易见的,这种方法没有解决数据稀疏和词表维度过高的问题,而且随着n的增大,词表维度会变得更高。

三、总结

文本的离散表示存在着数据稀疏、向量维度过高、字词之间的关系无法度量的问题,适用于浅层的机器学习模型,不适用于深度学习模型。

后续我会再写两篇文章,分析如何用代码实现文本的one-hot编码和TF-IDF编码。

参考资料:

1、《Python深度学习》

2、https://www.cnblogs.com/lianyingteng/p/7755545.html

3、https://www.jianshu.com/p/7298deddca21

4、https://flashgene.com/archives/9201.html

文本离散表示(一):词袋模型(bag of words)的更多相关文章

- 机器学习入门-文本数据-构造Ngram词袋模型 1.CountVectorizer(ngram_range) 构建Ngram词袋模型

函数说明: 1 CountVectorizer(ngram_range=(2, 2)) 进行字符串的前后组合,构造出新的词袋标签 参数说明:ngram_range=(2, 2) 表示选用2个词进行前后 ...

- 机器学习入门-文本数据-构造词频词袋模型 1.re.sub(进行字符串的替换) 2.nltk.corpus.stopwords.words(获得停用词表) 3.nltk.WordPunctTokenizer(对字符串进行分词操作) 4.np.vectorize(对函数进行向量化) 5. CountVectorizer(构建词频的词袋模型)

函数说明: 1. re.sub(r'[^a-zA-Z0-9\s]', repl='', sting=string) 用于进行字符串的替换,这里我们用来去除标点符号 参数说明:r'[^a-zA-Z0- ...

- 机器学习入门-文本数据-构造Tf-idf词袋模型(词频和逆文档频率) 1.TfidfVectorizer(构造tf-idf词袋模型)

TF-idf模型:TF表示的是词频:即这个词在一篇文档中出现的频率 idf表示的是逆文档频率, 即log(文档的个数/1+出现该词的文档个数) 可以看出出现该词的文档个数越小,表示这个词越稀有,在这 ...

- 【sklearn文本特征提取】词袋模型/稀疏表示/停用词/TF-IDF模型

1. 词袋模型 (Bag of Words, BOW) 文本分析是机器学习算法的一个主要应用领域.然而,原始数据的这些符号序列不能直接提供给算法进行训练,因为大多数算法期望的是固定大小的数字特征向量, ...

- 文本向量化及词袋模型 - NLP学习(3-1)

分词(Tokenization) - NLP学习(1) N-grams模型.停顿词(stopwords)和标准化处理 - NLP学习(2) 之前我们都了解了如何对文本进行处理:(1)如用NLTK文 ...

- 【CV知识学习】【转】beyond Bags of features for rec scenen categories。基于词袋模型改进的自然场景识别方法

原博文地址:http://www.cnblogs.com/nobadfish/articles/5244637.html 原论文名叫Byeond bags of features:Spatial Py ...

- 机器学习---文本特征提取之词袋模型(Machine Learning Text Feature Extraction Bag of Words)

假设有一段文本:"I have a cat, his name is Huzihu. Huzihu is really cute and friendly. We are good frie ...

- 文本特征提取---词袋模型,TF-IDF模型,N-gram模型(Text Feature Extraction Bag of Words TF-IDF N-gram )

假设有一段文本:"I have a cat, his name is Huzihu. Huzihu is really cute and friendly. We are good frie ...

- 词袋模型(BOW, bag of words)

词集模型:单词构成的集合,每个单词只出现一次. 词袋模型:把每一个单词都进行统计,同时计算每个单词出现的次数. 在train_x中,总共有6篇文档,每一行代表一个样本即一篇文档.我们的目标是将trai ...

随机推荐

- 利用nginx解决cookie跨域

一.写在前面 最近需要把阿里云上的四台服务器的项目迁移到客户提供的新的项目中,原来的四台服务器中用到了一级域名和二级域名.比如aaa.abc.com 和bbb.abc.com 和ccc.abc.com ...

- MySQL远程链接

当把本地数据库作为服务器的时候,如果你发现client无法链接到你的数据库服务器,那么有可能是: 1. 当前account没有远程链接权限,如何开通? GRANT ALL PRIVILEGES ON ...

- 5月2日——iOS11定位失效问题

所存在的问题: (1)定位不能正常使用 (2)首次安装APP 时 "是否允许使用定位信息" 系统提示框不显示 iOS定位失效原因: 因为苹果现在增加了一项新的隐私保护功能 NSL ...

- Cookie SQL注入

转自http://blog.sina.com.cn/s/blog_6b347b2a0101379o.html cookie注入其原理也和平时的注入一样,只不过说我们是将提交的参数已cookie方式提交 ...

- PAT1052:Linked List Sorting

1052. Linked List Sorting (25) 时间限制 400 ms 内存限制 65536 kB 代码长度限制 16000 B 判题程序 Standard 作者 CHEN, Yue A ...

- 通俗的讲法理解spring的事务实现原理

拿房屋买卖举例,流程:销售房屋 -- 接待员 -- 销售员 -- 财务 售楼处 存放着所有待售和已售的房屋数据(数据源 datasource) 总经理 带领一套自己的班底,下属员工都听自己的,服务于售 ...

- SVN学习之windows下svn的安装

svn是apache的一个开源项目,全称为subversion.是一个基于版本的项目管理软件,一般在多人开发的项目中使用,目前svn已经替代了原来的cvs.大多数情况下,svn服务安装在linux服务 ...

- 4.app是怎么炼成的

很多刚进入app后端的小伙伴,有的是之前没有接触过这个行业,有的是只在学校学习了基本的技术知识,不知道开发app的整个流程是怎么样的,因此心里会有一股恐惧.听着别人口中的一大串app相关的术语,也不知 ...

- Log4j2中的同步日志与异步日志

1.背景 Log4j 2中记录日志的方式有同步日志和异步日志两种方式,其中异步日志又可分为使用AsyncAppender和使用AsyncLogger两种方式. 2.Log4j2中的同步日志 所谓同步日 ...

- Integer的疑惑

1.Integer m =200; Integer n =200; System.out.println(m==n); 输出falseInteger x =6; Integer y=6; System ...