python 使用selenium模块实现自动搜索百度百科词条(模拟人工搜索)

目标:模拟人工搜索百度百科词条,爬取相关信息,自动删除上一个关键词,输入新关键词,继续搜索,直到循环结束。

代码:

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import time

from bs4 import BeautifulSoup univs = ['清华大学', '不知道大学', '北京大学']

AllUnivInfolist = [] browser = webdriver.Firefox() # 创建一个浏览器对象,这里还可以使用chrome等浏览器

try:

browser.get('https://baike.baidu.com/') # 打开百科

for univ in univs:

browser.find_element_by_id('query').send_keys(univ) # 找到输入框输入字段

time.sleep(3)

browser.find_element_by_id('search').send_keys(Keys.ENTER) # 找到搜索按钮模拟点击

time.sleep(3)

html = browser.page_source # 获取html页面

soup = BeautifulSoup(html, 'html.parser') # beautifulsoup库解析html title = soup.find_all('dt', class_="basicInfo-item name") # key

node = soup.find_all('dd', class_="basicInfo-item value") # value allunivinfo = []

titlelist = []

infolist = [] for i in title: # 将所有dt标签内容存入列表

title = i.get_text()

titlelist.append(title)

for i in node: # 将所有dd标签内容存入列表

info = i.get_text()

infolist.append(info)

for i, j in zip(titlelist, infolist): # 多遍历循环,zip()接受一系列可迭代对象作为参数,将对象中对应的元素打包成一个个tuple(元组),然后返回由这些tuples组成的list(列表)。

info = ''.join((str(i) + ':' + str(j)).split())

allunivinfo.append(info)

AllUnivInfolist.append(allunivinfo)

# 模拟ctrl+a 操作 全选输入框内容

browser.find_element_by_id('query').send_keys(Keys.CONTROL, 'a')

time.sleep(3)

# 删除输入框内容 (删除操作 模拟键盘的Backspace)

browser.find_element_by_id('query').send_keys(Keys.BACK_SPACE)

time.sleep(3) finally:

browser.quit() with open("AllUnivInfo.txt", "wt", encoding='utf8') as out_file:

for u in AllUnivInfolist:

out_file.write(str(u)+'\n')

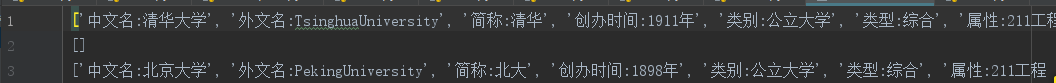

运行结果(部分):

python 使用selenium模块实现自动搜索百度百科词条(模拟人工搜索)的更多相关文章

- python简单爬虫 用beautifulsoup爬取百度百科词条

目标:爬取“湖南大学”百科词条并处理数据 需要获取的数据: 源代码: <div class="basic-info cmn-clearfix"> <dl clas ...

- python使用selenium,webdriver自动下载百度网盘内容

想实现一个自动下载微信公众号分享百度网盘图片链接的爬虫,使用selenium和火狐的webdriver进行完成 1.首先根据自己的浏览器下载相应的webdriver驱动器,python中导入selen ...

- Python学习--Selenium模块学习(2)

Selenium的基本操作 获取浏览器驱动寻找方式 1. 通过手动指定浏览器驱动路径2. 通过 `$PATH`环境变量找寻浏览器驱动 可参考Python学习--Selenium模块简单介绍(1) 控制 ...

- Python学习--Selenium模块

1. Python学习--Selenium模块介绍(1) 2.Python学习--Selenium模块学习(2) 其他: 1. Python学习--打码平台

- Python 爬虫实例(爬百度百科词条)

爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成.爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入 ...

- python+selenium+chrome实现自动登录百度

#python3.4+selenium3.5+chrome版本 63.0.3239.132+chrome驱动chromedriver.exe #实现自动登录百度 from selenium impor ...

- Python爬虫——selenium模块

selenium模块介绍 selenium最初是一个测试工具,而爬虫中使用它主要是为了解决requests无法直接执行JavaScript代码的问题 selenium本质是通过驱动浏览器,完全模拟浏览 ...

- Python中Selenium模块的使用

目录 Selenium的介绍.配置和调用 Selenium的配置 Selenium的调用 Selenium的使用 定位 定位元素的使用 定位下拉标签元素 在iframe框架之间切换 上传文件 Webd ...

- python 使用selenium模块爬取同一个url下不同页的内容(浏览器模拟人工翻页)

页面翻页,下一页可能是一个新的url 也有可能是用js进行页面跳转,url不变,解决方法是实现浏览器模拟人工翻页 目标:爬取同一个url下不同页的数据(上述第二种情况) url:http://www. ...

随机推荐

- win10配置java开发环境

安装java(JDK) Oracle官网下载地址 选择JavaSE > Downloads 选择最新版本 > Download Accept License Agreement 选择要下载 ...

- SPOJ 1811 LCS - Longest Common Substring

思路 和SPOJ 1812 LCS2 - Longest Common Substring II一个思路,改成两个串就有双倍经验了 代码 #include <cstdio> #includ ...

- 解决idea的.gitignore有时不起作用的问题

有时候,.gitignore会对部分文件/文件夹失效,大概原因是由于新创建的文件已经出现在git本地仓库的缓存,所以.gitignore就失效了 解决办法就是清空一下git仓库的缓存,重新提交一次就好 ...

- C++_day8_ 多重继承、钻石继承和虚继承

1.继承的复习 1.1 类型转换 编译器认为访问范围缩小是安全的. 1.2 子类的构造与析构 子类中对基类构造函数初始化只能写在初始化表里,不能写在函数体中. 阻断继承. 1.3 子类的拷贝构造与拷贝 ...

- 2017-2018 ACM-ICPC German Collegiate Programming Contest (GCPC 2017)

A Drawing Borders 很多构造方法,下图可能是最简单的了 代码: #include<bits/stdc++.h> using namespace std; ; struct ...

- Inquirer.js

一个使用界面进行交互的命令行集合 4.0以上的版本只支持node 6以上的,node4请使用3.x 目标和理念(hilosophy) 努力去做一个容易的 嵌入式的(embeddable) 和优美的命令 ...

- Click event doesn't work on dynamically generated elements

I couldn't get live or delegate to work on a div in a lightbox (tinybox). I used setTimeout successf ...

- 2 Class类

在程序运行期间,Java运行时系统始终为所有的对象维护一个被称为运行时地类型标识.这个信息跟踪着每个对象所属地类.虚拟机 利用运行时类型信息选择相应地方法执行. 然而,可以通过专门地Java类访问这 ...

- 使用js如何设置、获取盒模型的宽和高

第一种: dom.style.width/height 这种方法只能获取使用内联样式的元素的宽和高. 第二种: dom.currentStyle.width/height 这种方法获取的是浏览器渲染以 ...

- wait和sleep的区别

wait是线程永久等待,只有调用notify才能进行唤醒 sleep是等待指定的时间,自动唤醒