大数据基础-2-Hadoop-1环境搭建测试

Hadoop环境搭建测试

1 安装软件

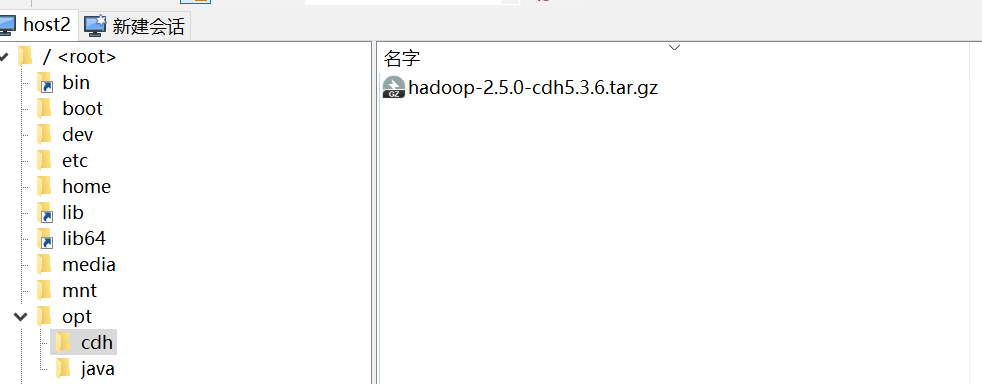

1.1 规划目录 /opt

[root@host2 ~]# cd /opt

[root@host2 opt]# mkdir java

[root@host2 opt]# mkdir cdh

[root@host2 opt]# ls

cdh java

1.2 安装RZ工具

RZ工具:可以直接从win平台拖动下载好的软件到Linux平台

sudo yum -y install lrzsz

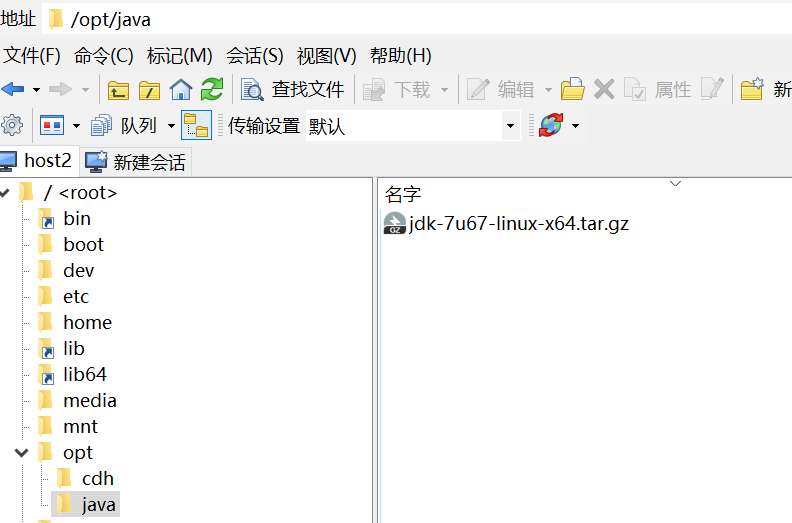

1.3 上传软件

将windows准备好的软件上传

1.4 解压

[root@host2 java]# tar -zxf jdk-7u67-linux-x64.tar.gz #解压

[root@host2 java]# rm -rf jdk-7u67-linux-x64.tar.gz #删除压缩包

[root@host2 java]# ls

jdk1.7.0_67

[root@host2 java]# cd /opt/cdh/

[root@host2 cdh]# tar -zxf hadoop-2.5.0-cdh5.3.6.tar.gz #解压

[root@host2 cdh]# ls

hadoop-2.5.0-cdh5.3.6 hadoop-2.5.0-cdh5.3.6.tar.gz

[root@host2 cdh]# rm -rf hadoop-2.5.0-cdh5.3.6.tar.gz #删除压缩包

[root@host2 cdh]# ls

hadoop-2.5.0-cdh5.3.6

1.5删除hadoop说明文档,系统瘦身

[root@host2 opt]# rm -rf /opt/cdh/hadoop-2.5.0-cdh5.3.6/share/doc

2 配置JAVA、Hadoop环境变量

2.1 位置:/etc/profile

#JAVA_HOME

export JAVA_HOME=/opt/java/jdk1.7.0_67

export PATH=$JAVA_HOME/bin:$PATH

#HADOOP_HOME

export HADOOP_HOME=/opt/cdh/hadoop-2.5.0-cdh5.3.6

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

export HADOOP_PREFIX=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HADOOP_HDFS_HOME=$HADOOP_HOME

export HADOOP_MAPPER_HOME=$HADOOP_HOME

export HADOOP_YARN_HOME=$HADOOP_HOME

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$HADOOP_HOME/lib

2.2 刷新

[root@host2 opt]# source /etc/profile #刷新

[root@host2 opt]# java -version #查看版本

java version "1.7.0_67"

Java(TM) SE Runtime Environment (build 1.7.0_67-b01)

Java HotSpot(TM) 64-Bit Server VM (build 24.65-b04, mixed mode)

3 配置Hadoop环境

当前目录:/opt/cdh/hadoop-2.5.0-cdh5.3.6

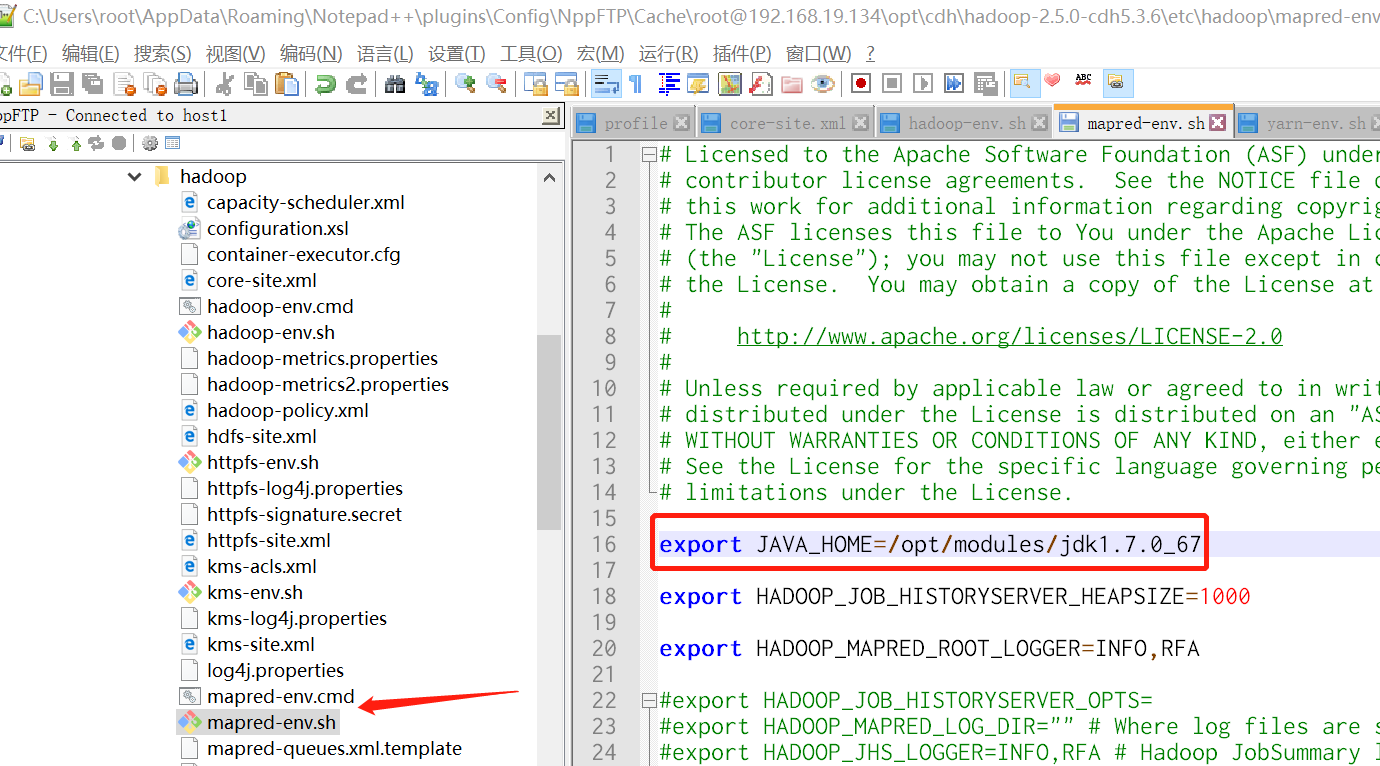

3.1 配置JAVA环境变量

3.1.1 etc/hadoop/hadoop-env.sh

3.1.2 etc/hadoop/mapred-env.sh

3.1.3 etc/hadoop/yarn-env.sh

export JAVA_HOME=/opt/java/jdk1.7.0_67

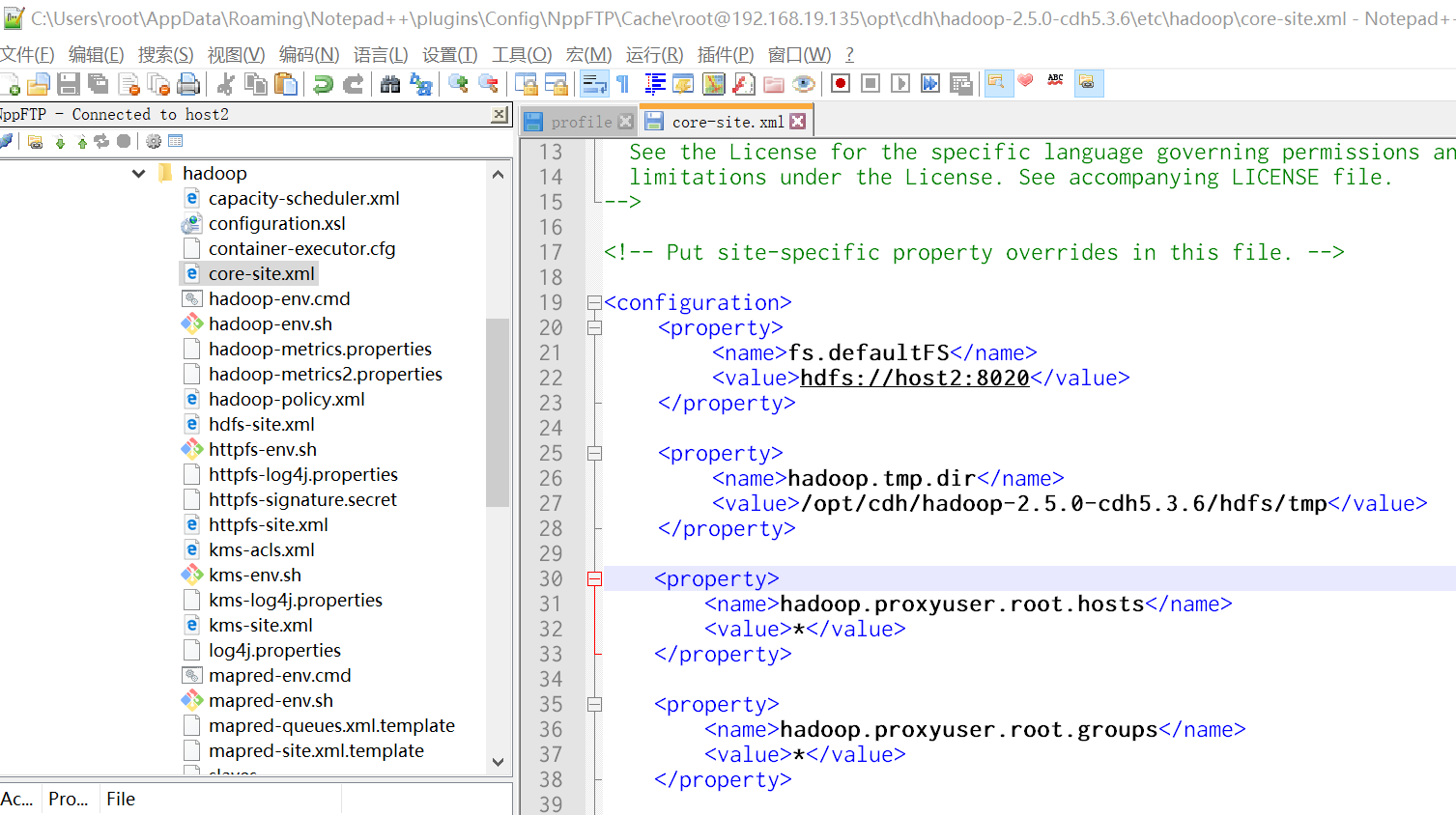

3.2 配置文件

3.2.1 etc/hadoop/core-site.xml

说明:主节点NameNode位置及交互端口

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://host2:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/cdh/hadoop-2.5.0-cdh5.3.6/hdfs/tmp</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

</configuration>

3.2.2 etc/hadoop/hdfs-site.xml

说明:系统中文件块的数据副本个数,是所有datanode总和,每个datanode上只能存放1个副本

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

3.2.3 etc/hadoop/yarn-site.xml:

<configuration>

<!-- reduce获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定ResourceManager的位置 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>host2</value>

</property>

</configuration>

3.2.4 etc/hadoop/mapred-site.xml

[root@host2 hadoop-2.5.0-cdh5.3.6]# cp etc/hadoop/mapred-site.xml.template etc/hadoop/mapred-site.xml

<configuration>

<!-- 指定MapReduce运行在yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 配置历史服务器端口 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop-senior02.ibeifeng.com:10020</value>

</property>

<!-- 开历史服务器的WEB UI界面 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop-senior02.ibeifeng.com:19888</value>

</property>

</configuration>

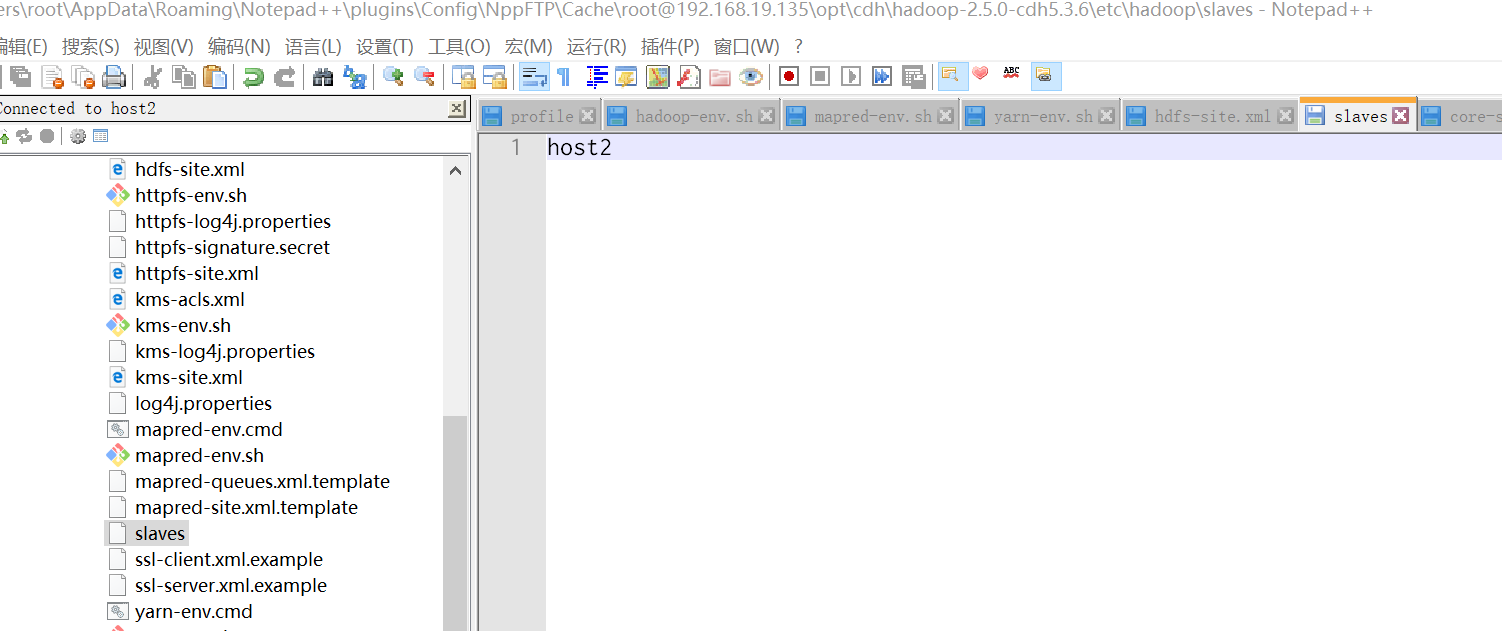

3.2.5 etc/hadoop/salves

说明:配置在从节点DataNode的位置,直接添加主机名

4 启动HDFS文件系统测试读写文件

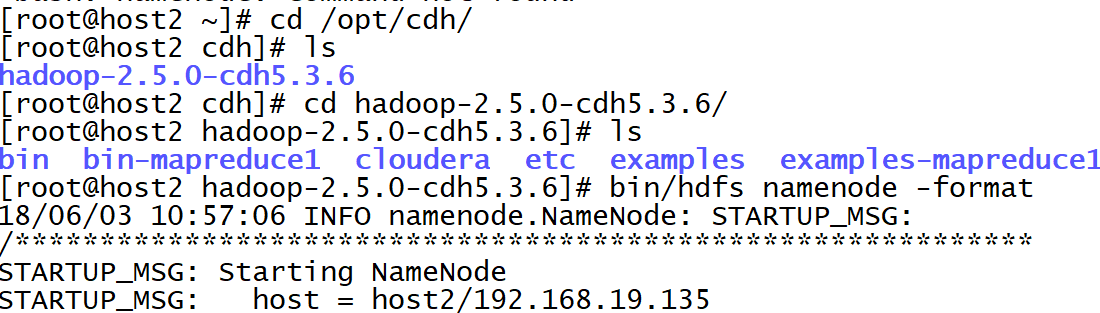

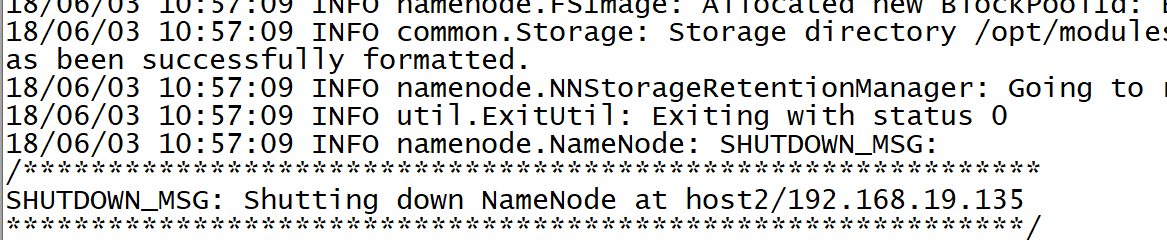

4.1 格式化HDFS文件系统

[root@host2 ~]# cd /opt/cdh/

[root@host2 cdh]# ls

hadoop-2.5.0-cdh5.3.6

[root@host2 cdh]# cd hadoop-2.5.0-cdh5.3.6/

[root@host2 hadoop-2.5.0-cdh5.3.6]# ls

bin bin-mapreduce1 cloudera etc examples examples-mapreduce1 include lib libexec sbin share src

[root@host2 hadoop-2.5.0-cdh5.3.6]# bin/hdfs namenode -format

18/06/03 10:57:06 INFO namenode.NameNode: STARTUP_MSG:

格式化成功

4.2 启动namenode和datanote

[root@host2 hadoop-2.5.0-cdh5.3.6]# sbin/hadoop-daemon.sh start namenode

starting namenode, logging to /opt/cdh/hadoop-2.5.0-cdh5.3.6/logs/hadoop-root-namenode-host2.out

[root@host2 hadoop-2.5.0-cdh5.3.6]# sbin/hadoop-daemon.sh start datanode

starting datanode, logging to /opt/cdh/hadoop-2.5.0-cdh5.3.6/logs/hadoop-root-datanode-host2.out

[root@host2 hadoop-2.5.0-cdh5.3.6]# jps

1255 Jps

1184 DataNode

1109 NameNode

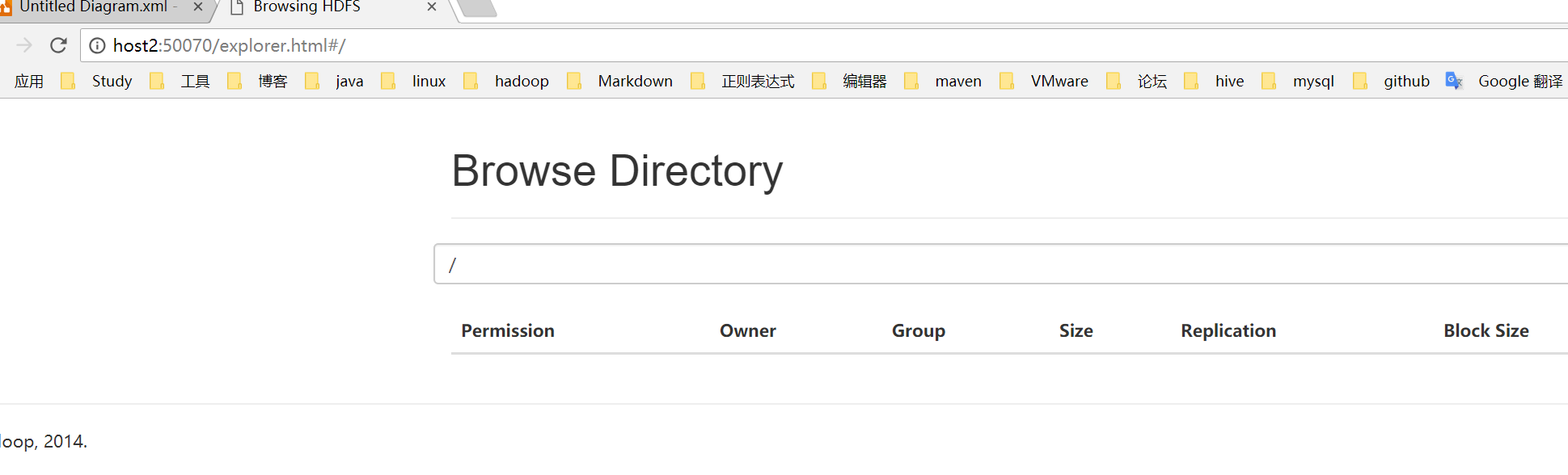

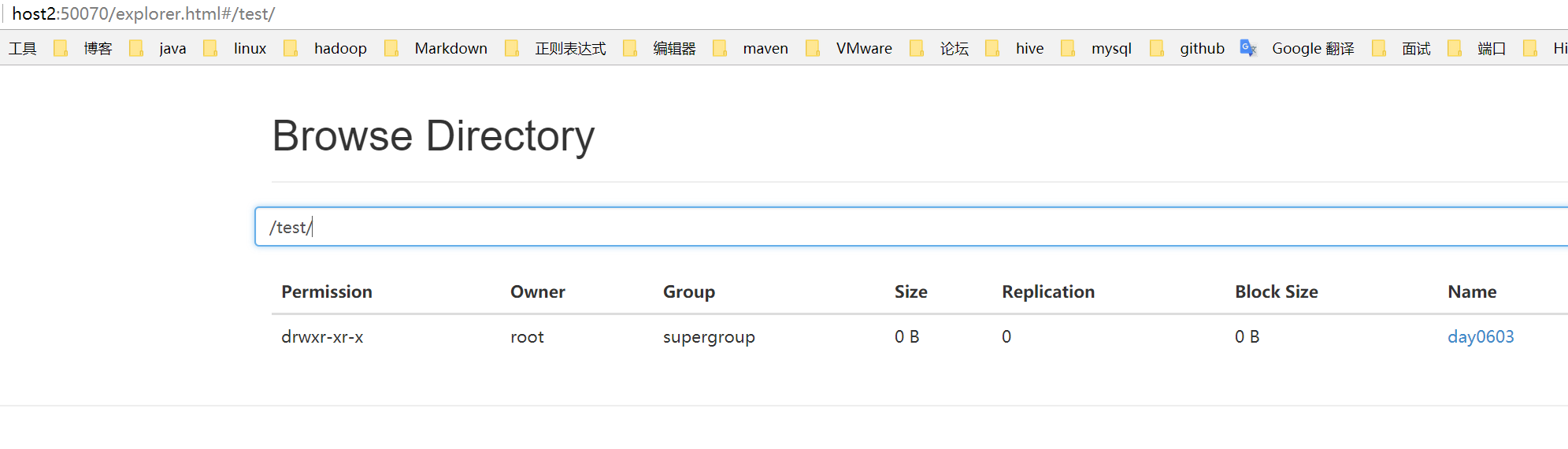

4.3 登陆HDFS的WEB界面

端口号:50070

登陆WEB:http://host2:50070/explorer.html#/

5 文件操作

5.1 创建目录

[root@host2 hadoop-2.5.0-cdh5.3.6]# bin/hdfs dfs -mkdir -p /test/day0603

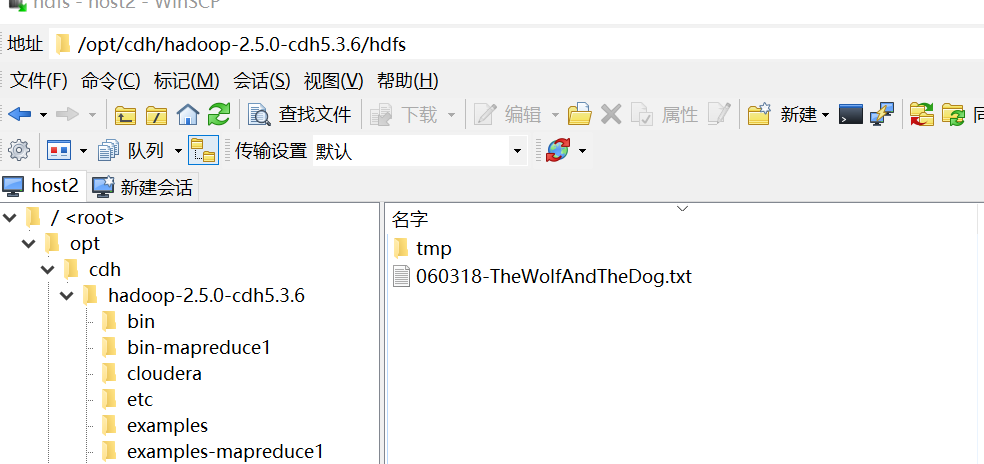

5.2 上传文件

[root@host2 hadoop-2.5.0-cdh5.3.6]# bin/hdfs dfs -put hdfs/060318-TheWolfAndTheDog.txt /test/day0603

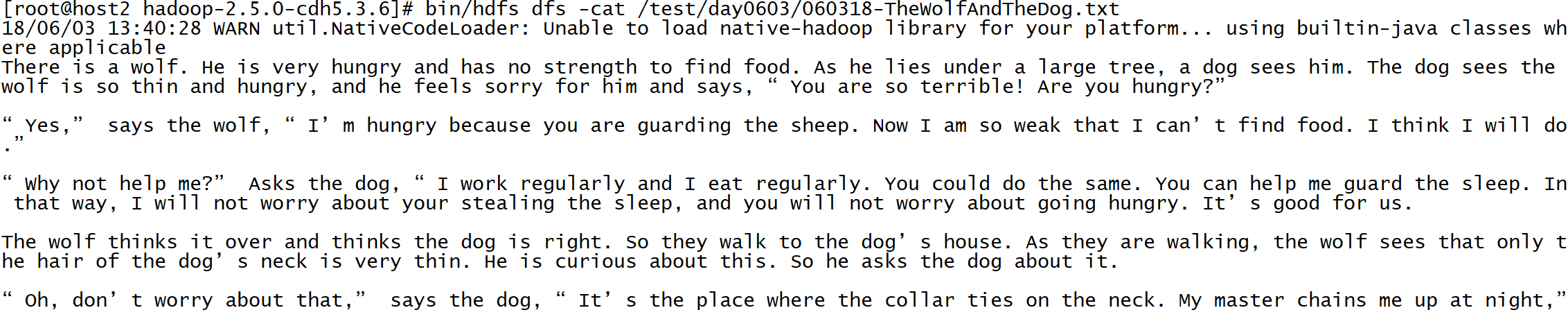

5.3 读取文件

[root@host2 hadoop-2.5.0-cdh5.3.6]# bin/hdfs dfs -cat /test/day0603/060318-TheWolfAndTheDog.txt

5.4 启动yarn并开启历史服务器

[root@host2 hadoop-2.5.0-cdh5.3.6]# sbin/yarn-daemon.sh start nodemanager

[root@host2 hadoop-2.5.0-cdh5.3.6]# sbin/yarn-daemon.sh start resourcemanager

[root@host2 hadoop-2.5.0-cdh5.3.6]# sbin/mr-jobhistory-daemon.sh start historyserver #启动历史服务器

yarn管理界面

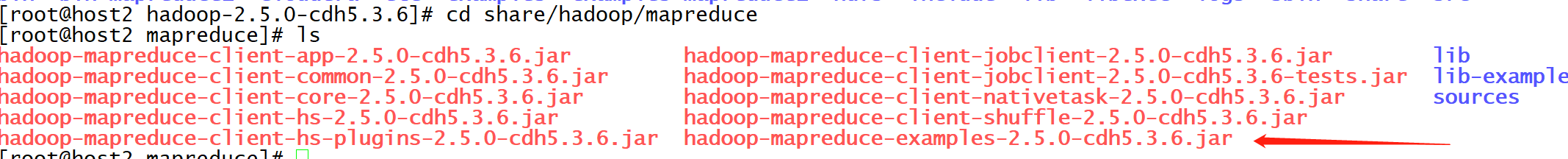

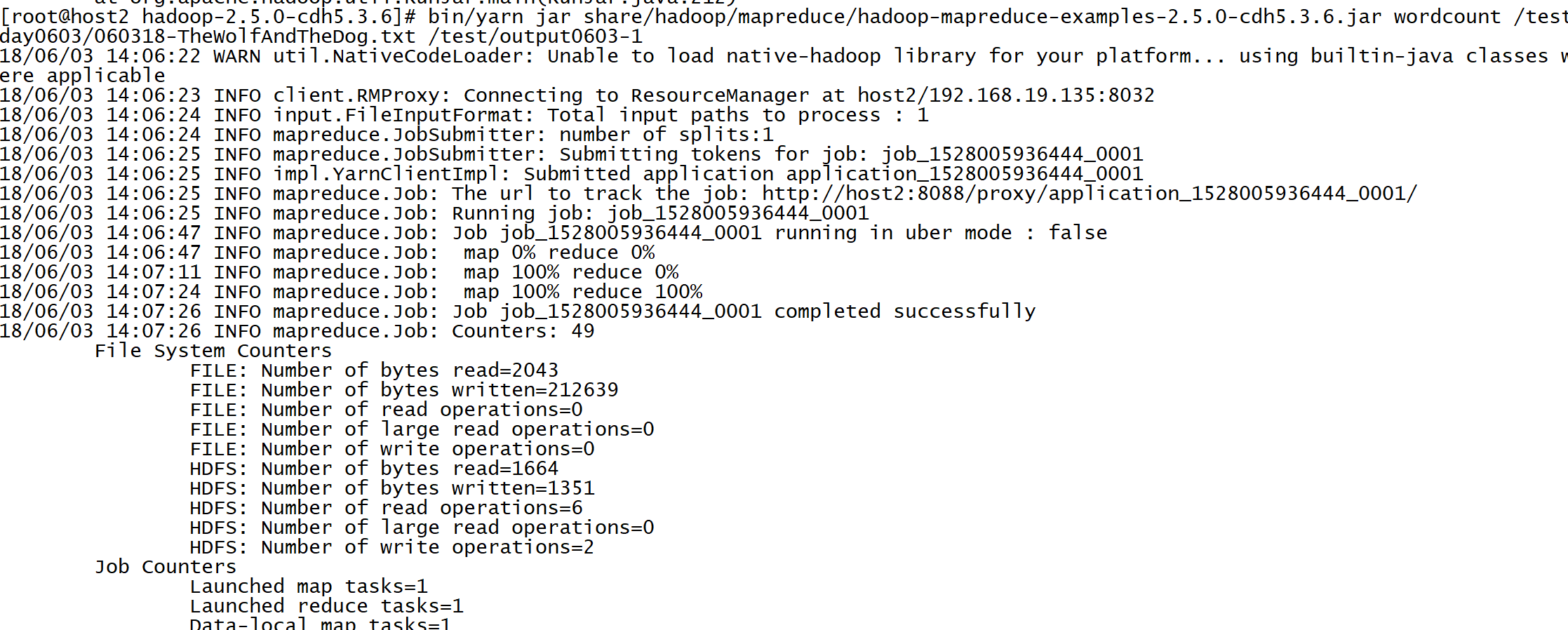

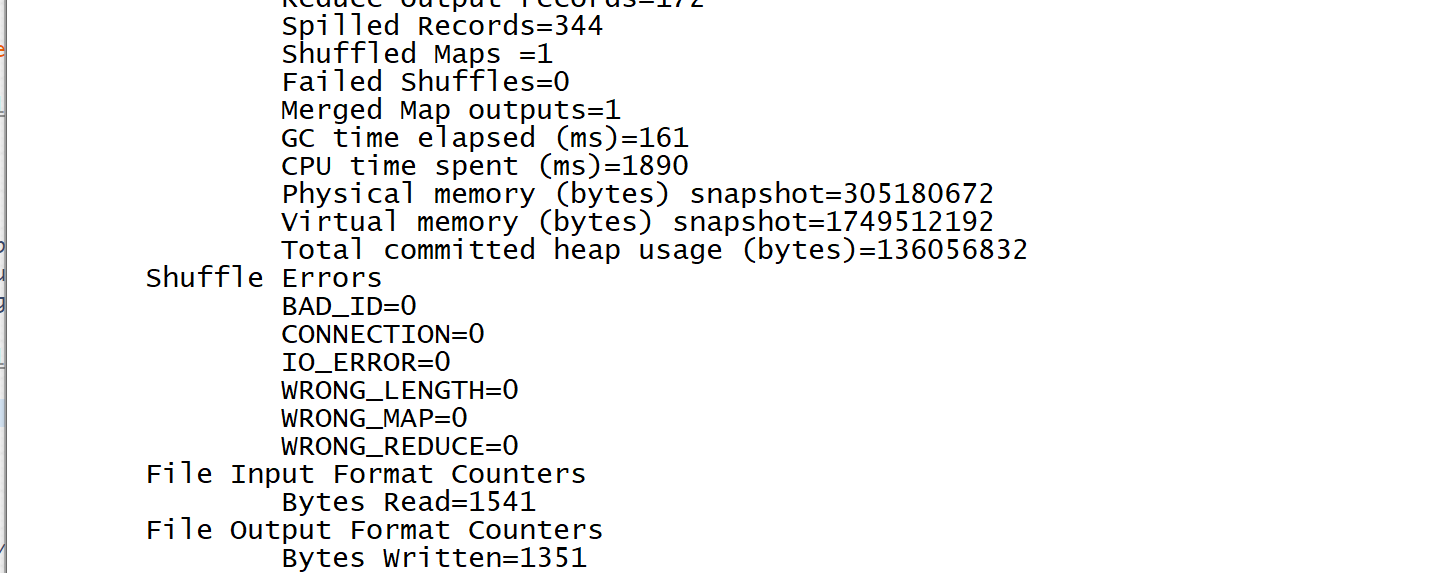

6 运行MapReduce WordCount程序

6.1 找到hadoop-mapreduce-examples-2.5.0-cdh5.3.6.jar

6.2 使用jar

[root@host2 hadoop-2.5.0-cdh5.3.6]# bin/yarn jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.5.0-cdh5.3.6.jar wordcount /test/day0603/060318-TheWolfAndTheDog.txt /test/output0603-1

6.3 查看结果

[root@host2 hadoop-2.5.0-cdh5.3.6]# bin/hdfs dfs -text /test/output0603-1/part*

18/06/03 14:10:14 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

After 1

Are 1

As 2

Asks 1

Come 1

He 2

I 12

If 1

In 2

It’s 1

I’m 3

My 1

MapReduce 会针对key进行排序

Hadoop2.X伪分布式搭建并且测试完成

大数据基础-2-Hadoop-1环境搭建测试的更多相关文章

- 学习大数据基础框架hadoop需要什么基础

什么是大数据?进入本世纪以来,尤其是2010年之后,随着互联网特别是移动互联网的发展,数据的增长呈爆炸趋势,已经很难估计全世界的电子设备中存储的数据到底有多少,描述数据系统的数据量的计量单位从MB(1 ...

- 【原创】大数据基础之Hadoop(2)hdfs和yarn最简绿色部署

环境:3结点集群 192.168.0.1192.168.0.2192.168.0.3 1 配置root用户服务期间免密登录 参考:https://www.cnblogs.com/barneywill/ ...

- 【原创】大数据基础之Hadoop(1)HA实现原理

有些工作只能在一台server上进行,比如master,这时HA(High Availability)首先要求部署多个server,其次要求多个server自动选举出一个active状态server, ...

- 【原创】大数据基础之Hadoop(3)yarn数据收集与监控

yarn常用rest api 1 metrics # curl http://localhost:8088/ws/v1/cluster/metrics The cluster metrics reso ...

- 大数据学习——java操作hdfs环境搭建以及环境测试

1 新建一个maven项目 打印根目录下的文件的名字 添加pom依赖 pom.xml <?xml version="1.0" encoding="UTF-8&quo ...

- 大数据测试之初识Hadoop

大数据测试之初识Hadoop POPTEST老李认为测试开发工程师是面向测试的开发,也就是说,写代码就是为完成测试任务服务的,写自动化测试(性能自动化,功能自动化,安全自动化,接口自动化等等)的cas ...

- 【HADOOP】| 环境搭建:从零开始搭建hadoop大数据平台(单机/伪分布式)-下

因篇幅过长,故分为两节,上节主要说明hadoop运行环境和必须的基础软件,包括VMware虚拟机软件的说明安装.Xmanager5管理软件以及CentOS操作系统的安装和基本网络配置.具体请参看: [ ...

- 分享知识-快乐自己:大数据(hadoop)环境搭建

大数据 hadoop 环境搭建: 一):大数据(hadoop)初始化环境搭建 二):大数据(hadoop)环境搭建 三):运行wordcount案例 四):揭秘HDFS 五):揭秘MapReduce ...

- 大数据技术之Hadoop入门

第1章 大数据概论 1.1 大数据概念 大数据概念如图2-1 所示. 图2-1 大数据概念 1.2 大数据特点(4V) 大数据特点如图2-2,2-3,2-4,2-5所示 图2-2 大数据特点之大量 ...

随机推荐

- 【vue】vue全家桶

vue-router(http://router.vuejs.org) vuex(https://vuex.vuejs.org/zh/guide/) vue-resource(https://gith ...

- [LeetCode] 5. 最长回文子串

题目链接:https://leetcode-cn.com/problems/longest-palindromic-substring/ 题目描述: 给定一个字符串 s,找到 s 中最长的回文子串.你 ...

- 秒杀系统HTML倒计时设置

倒计时就是在秒杀表中设定好要秒杀的时间 再减去现在的时间 把时间差显示在页面上 由于第一次搞秒杀倒计时 辛苦搞了半天 留此微博 以留备用 <!DOCTYPE html PUBLIC &qu ...

- 迷茫<第二篇:回到老家湖南长沙>

2014年8月初,我买了回老家的火车票,当时没有买到坐票,卧铺贵了买不起,所以我就选择了站票,准备站回老家.我现在还记得我当时买的是T1列火车,北京西站到长沙火车站,全程16个小时.当时我就在火车上站 ...

- 使用反射动态调用ActiveX控件

使用反射动态调用ActiveX控件 袁永福 2018-3-2 ■■■■问题描述: 目前的基于.NET平台的软件研发中仍然存在大量的对COM及ActiveX控件的调用.使用C#调用ActiveX控件时一 ...

- IDEA 创建包和类及基本操作

创建包和类步骤如下: 1. 展开创建的工程,在源代码目录 src 上,鼠标右键,选择 new->package ,键入包名 com.itheima.demo ,点击确定. 2. 在创建好的包上, ...

- (poj 2502) Subway 最短路

题目链接: 题意:在一个城市里有许多地铁,现在你知道每条地铁的起点 终点与停站点的坐标,知道我们的起始坐标与终点坐标,问加上走路最快到达终点的时间是多少? 方法:求出任意两点的车速时间与步行时间,再 ...

- sqlalchemy常用

一.SQLAlchemy 创建表 from sqlalchemy.ext.declarative import declarative_base from sqlalchemy import Colu ...

- 【学习总结】GirlsInAI ML-diary day-7-数据类型转换

[学习总结]GirlsInAI ML-diary 总 原博github链接-day7 回顾之前见到的常见数据类型 int 整数 float 浮点数 bool 布尔值 string 字符串 ... 1- ...

- 在IIS上搭建WebSocket服务器(一)

一.搭建环境 1.System.Web.WebSockets需搭建在Windows8及Server2012以上系统的上. 2.在Windows8及Server2012以上系统的上安装IIS和WebSo ...