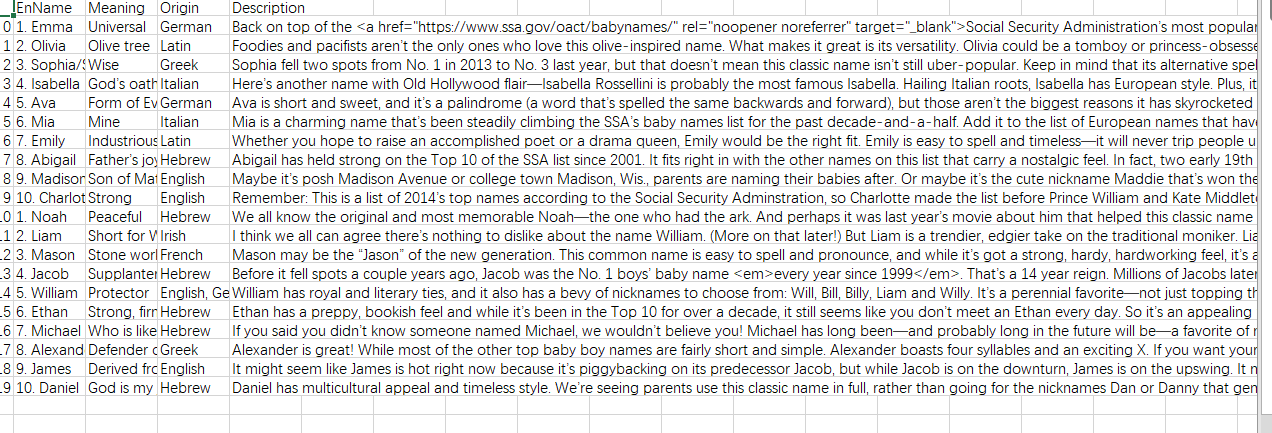

爬取https://www.parenting.com/baby-names/boys/earl网站top10男女生名字及相关信息

爬取源代码如下:

import requests

import bs4

from bs4 import BeautifulSoup

import re

import pandas as pd

import io

import sys

sys.stdout = io.TextIOWrapper(sys.stdout.buffer,encoding='gb18030') lilist=[] r=requests.get('https://www.parenting.com/baby-names/boys/earl')

soup=BeautifulSoup(r.text,"lxml")

soup= soup.find_all('a',href=True)

for i in soup:

if 'https://www.parenting.com/pregnancy/baby-names/baby-boy-names/' in str(i)or'https://www.parenting.com/pregnancy/baby-names/girl-baby-names/' in str(i):

lilist.append(i.get("href"))

lilist1=[]

results1=[]

results=[]

results2=[] for i in list(set(lilist)):

r=requests.get(i)

soup=BeautifulSoup(r.text,"lxml") Source=soup.find_all('p')

Source=soup.find_all(attrs={'class': 'description'}) results0 = re.findall('<h4>(.*?)</h4>', r.text)

for c in results0:

if c!='':

lilist1.append(c)

#print(lilist1)

#lilist1=[]

pattern = re.compile('<p><strong>Origin:</strong>\s(.*?)</p>', re.S)

results += re.findall(pattern, str(Source)) pattern1 = re.compile('<p><strong>Meaning:</strong>\s(.*?)</p>', re.S)

results1 += re.findall(pattern1, str(Source))

pattern2 = re.compile("<p><strong>Why it’s big:</strong>\s(.*?)</p>", re.S)

results2 += re.findall(pattern2, str(Source)) print(lilist1)

print(results1)

print(results)

print(results2)

data = {

'EnName':lilist1,

'Meaning':results1,

'Origin':results,

'Description':results2

}

frame = pd.DataFrame(data)

frame.to_csv('wt10.csv',encoding="gb18030")

#print(results2)

爬取https://www.parenting.com/baby-names/boys/earl网站top10男女生名字及相关信息的更多相关文章

- 一个爬取https和http通用的工具类(JDK自带的URL的用法)

今天在java爬取天猫的时候因为ssl报错,所以从网上找了一个可以爬取https和http通用的工具类.但是有的时候此工具类爬到的数据不全,此处不得不说python爬虫很厉害. package cn. ...

- 解决:Python爬取https站点时SNIMissingWarning和InsecurePlatformWarning

今天想利用Requests库爬取糗事百科站点,写了一个请求,却报错了: 后来参考kinsomy的博客,在cmd中pip install pyopenssl ndg-httpsclient pyasn1 ...

- 爬取https页面遇到“SSLError: hostname 'xxx' doesn't match either of”的解决方法

使用python requests 框架包访问https://itunes.apple.com 页面是遇到 SSLError: hostname 'itunes.apple.com' doesn't ...

- java爬虫爬取https协议的网站时,SSL报错, java.lang.IllegalArgumentException TSLv1.2 报错

目前在广州一家小公司实习,这里的学习环境还是挺好的,今天公司从业十几年的大佬让我检查一下几年前的爬虫程序是否还能使用…… 我从myeclipse上check out了大佬的程序,放到workspace ...

- pyspider爬取tourism management 所有文章的标题 作者 摘要 关键词等等所有你想要的信息

#!/usr/bin/env python # -*- encoding: utf-8 -*- # vim: set et sw=4 ts=4 sts=4 ff=unix fenc=utf8: # C ...

- python爬取酒店信息练习

爬取酒店信息,首先知道要用到那些库.本次使用request库区获取网页,使用bs4来解析网页,使用selenium来进行模拟浏览. 本次要爬取的美团网的蚌埠酒店信息及其评价.爬取的网址为“http:/ ...

- Python 利用 BeautifulSoup 爬取网站获取新闻流

0. 引言 介绍下 Python 用 Beautiful Soup 周期性爬取 xxx 网站获取新闻流: 图 1 项目介绍 1. 开发环境 Python: 3.6.3 BeautifulSoup: ...

- python网络爬虫之解析网页的BeautifulSoup(爬取电影图片)[三]

目录 前言 一.BeautifulSoup的基本语法 二.爬取网页图片 扩展学习 后记 前言 本章同样是解析一个网页的结构信息 在上章内容中(python网络爬虫之解析网页的正则表达式(爬取4k动漫图 ...

- 教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http://www.xiaohuar.com/,让你体验爬取校花的成就感. Scr ...

随机推荐

- Android中常见的设计模式

前言: Android开发的设计模式,基本设计思想源于java的设计模式,java的设计模式有N多种,据不完全统计,迄今为止,网络出现最频繁的大概有23种.Java只是一门开发语言,学会并掌握这门语言 ...

- 性能测试——记XX银行电票系统上线后宕机问题诊断优化

四月份我们公司负责的电票系统上线了,这个系统上线比客户方其他系统上线还特殊,是二期改造项目,旧系统数据还要整合抽取到新系统中继续使用,而且该系统不是增量型方式开发上线的,而且全部开发完后全国上线的,这 ...

- html——标签基础

img标签:使用 src="xxx" 来链接图片 当图片显示不出来的时候 显示alt 中定义的内容 当图片显示了出来 鼠标移动到图片上的时候 显示的是 title 中定义的 ...

- 2019-10-30,Hack The Box 获取邀请码

一.快速获取邀请码方法 1,使用curl请求下面的地址curl -X POST https://www.hackthebox.eu/api/invite/generate 2,在返回结果的code部分 ...

- python中return和print的区别

之前遇到这个问题,就试着对比几种不同的结果,总结啦一下return和print的区别. 总结: return的作用之一是返回计算的值print的作用是输出数据到控制端 在第一个结果中什么都没有输出:在 ...

- yum运行报错:File "/usr/bin/yum", line 30 except KeyboardInterrupt, e: ^SyntaxError: invalid syntax

这是由于Python升级导致 备份Python 历史版本 [root@sdw1 autoconf]# ls /usr/bin/python* [root@sdw1 autoconf]# mv /usr ...

- 2019牛客暑期多校训练营(第九场) E-All men are brothers(并查集+组合数学)

>传送门< 题意:最初有 n个人且互不认识,接下来 m行,每行有 x,y表示x和y交朋友,朋友关系满足自反性和传递性,每次输出当前选取4个人且互不认识的方案数. 思路:比赛的时候知道是用并 ...

- django restful framework 一对多方向更新数据库

目录 django restful framework 序列化 一 . 数据模型: models 二. 序列化: serializers 三, 视图: views 四, 路由: urls 五. 测试 ...

- Day01-变量/常量/数据类型/流程控制之 if

1.变量 把程序运行的中间结果临时的存在内存里,以便后续的代码调用.代指一些复杂的.过长的数据. 声明变量 name = 'Dylan' # 把数据'Dylan'声明(赋值)给变量 nmae,以便后 ...

- 王晶:华为云OCR文字识别服务技术实践、底层框架及应用场景 | AI ProCon 2019

演讲嘉宾 | 王晶(华为云人工智能高级算法工程师王晶) 出品 | AI科技大本营(ID:rgznai100) 近期,由 CSDN 主办的 2019 中国AI 开发者大会(AI ProCon 2019) ...