python爬虫-模拟微博登录

微博模拟登录

这是本次爬取的网址:https://weibo.com/

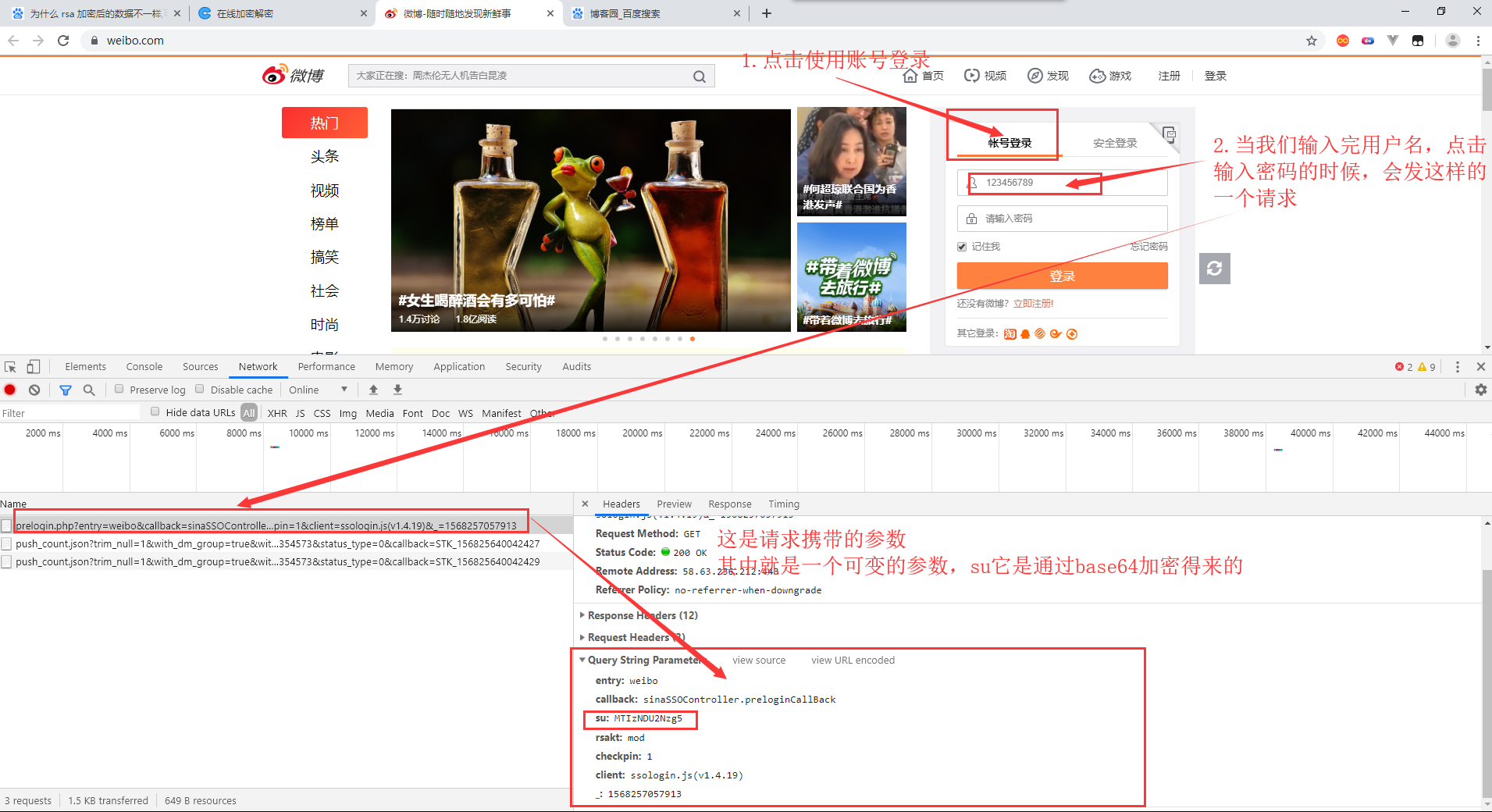

一、请求分析

找到登录的位置,填写用户名密码进行登录操作

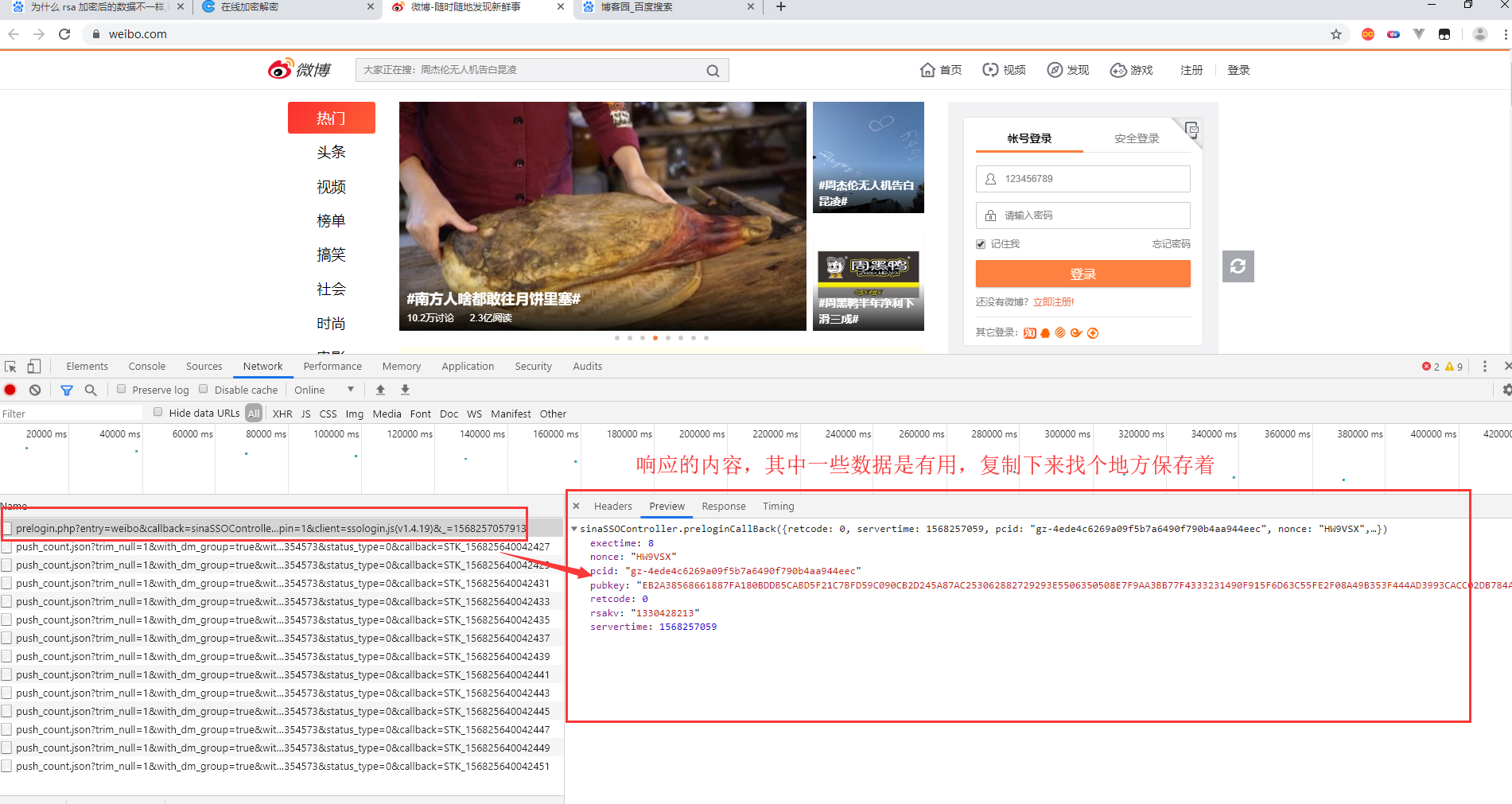

看看这次请求响应的数据是什么

这是响应得到的数据,保存下来

exectime: 8

nonce: "HW9VSX"

pcid: "gz-4ede4c6269a09f5b7a6490f790b4aa944eec"

pubkey: "EB2A38568661887FA180BDDB5CABD5F21C7BFD59C090CB2D245A87AC253062882729293E5506350508E7F9AA3BB77F4333231490F915F6D63C55FE2F08A49B353F444AD3993CACC02DB784ABBB8E42A9B1BBFFFB38BE18D78E87A0E41B9B8F73A928EE0CCEE1F6739884B9777E4FE9E88A1BBE495927AC4A799B3181D6442443"

retcode: 0

rsakv: "1330428213"

servertime: 1568257059

继续完善登录操作,输入密码,点击登录按钮

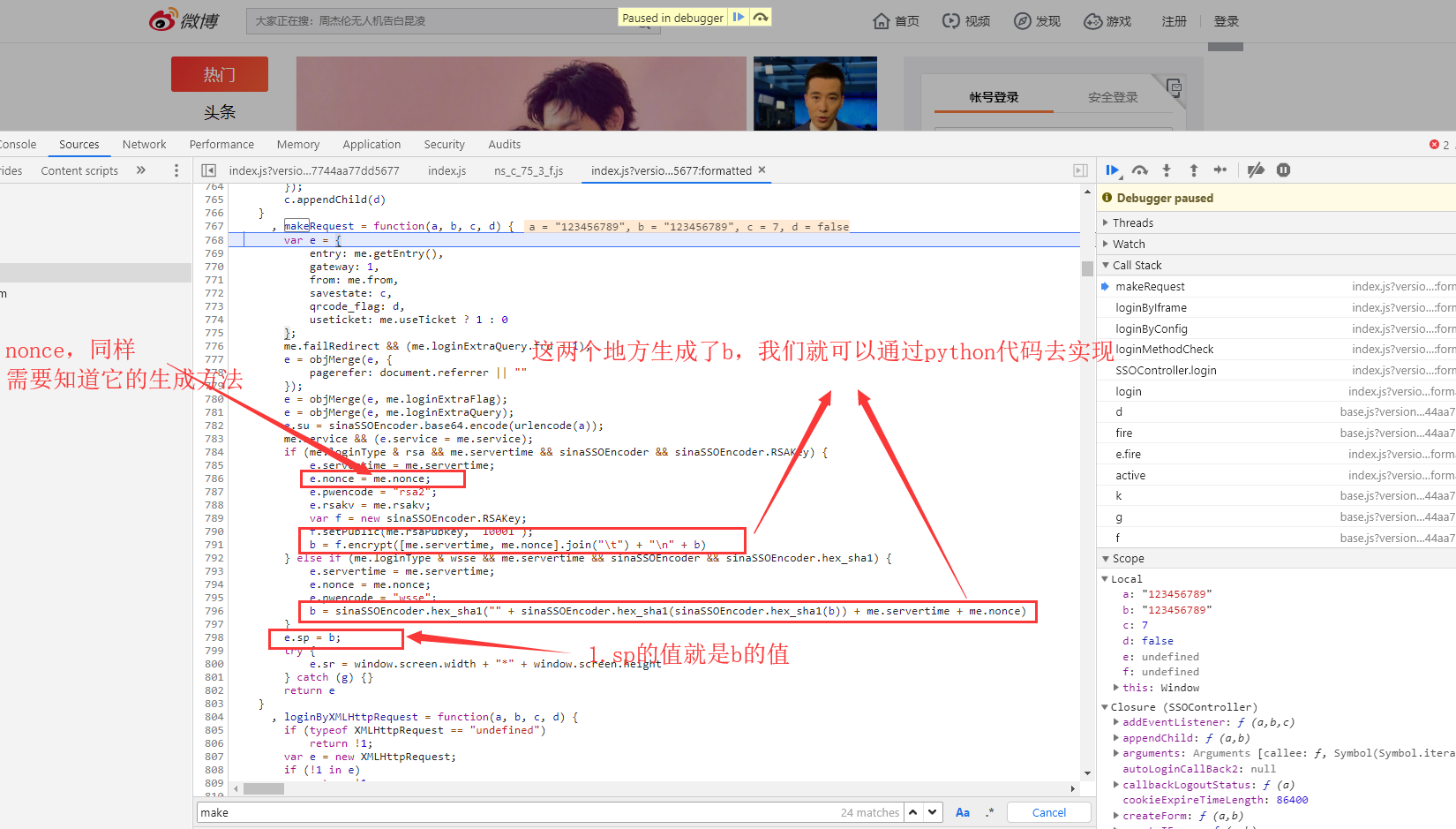

经过分析呢,发现变化的参数就是sp,nonce,servetime。servetime就是当前的时间戳,我们只需找到其他两个参数的生成方法就好了。对了su这个参数是通过base64加密生成的

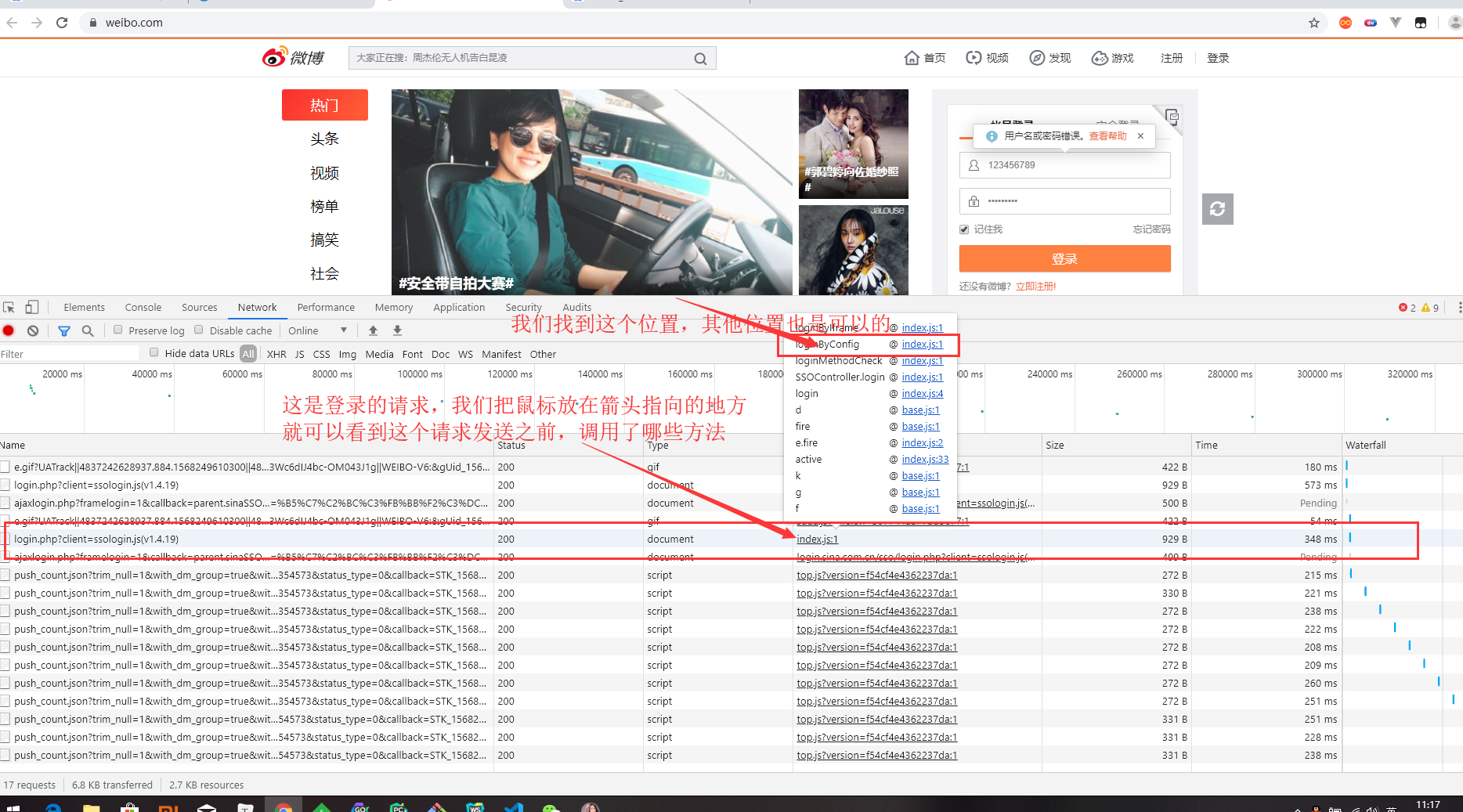

二、找到sp,nonce的加密方式

这次就不通过search关键字去找加密位置了

找到调用函数的位置,打上断点,再进行登录操作

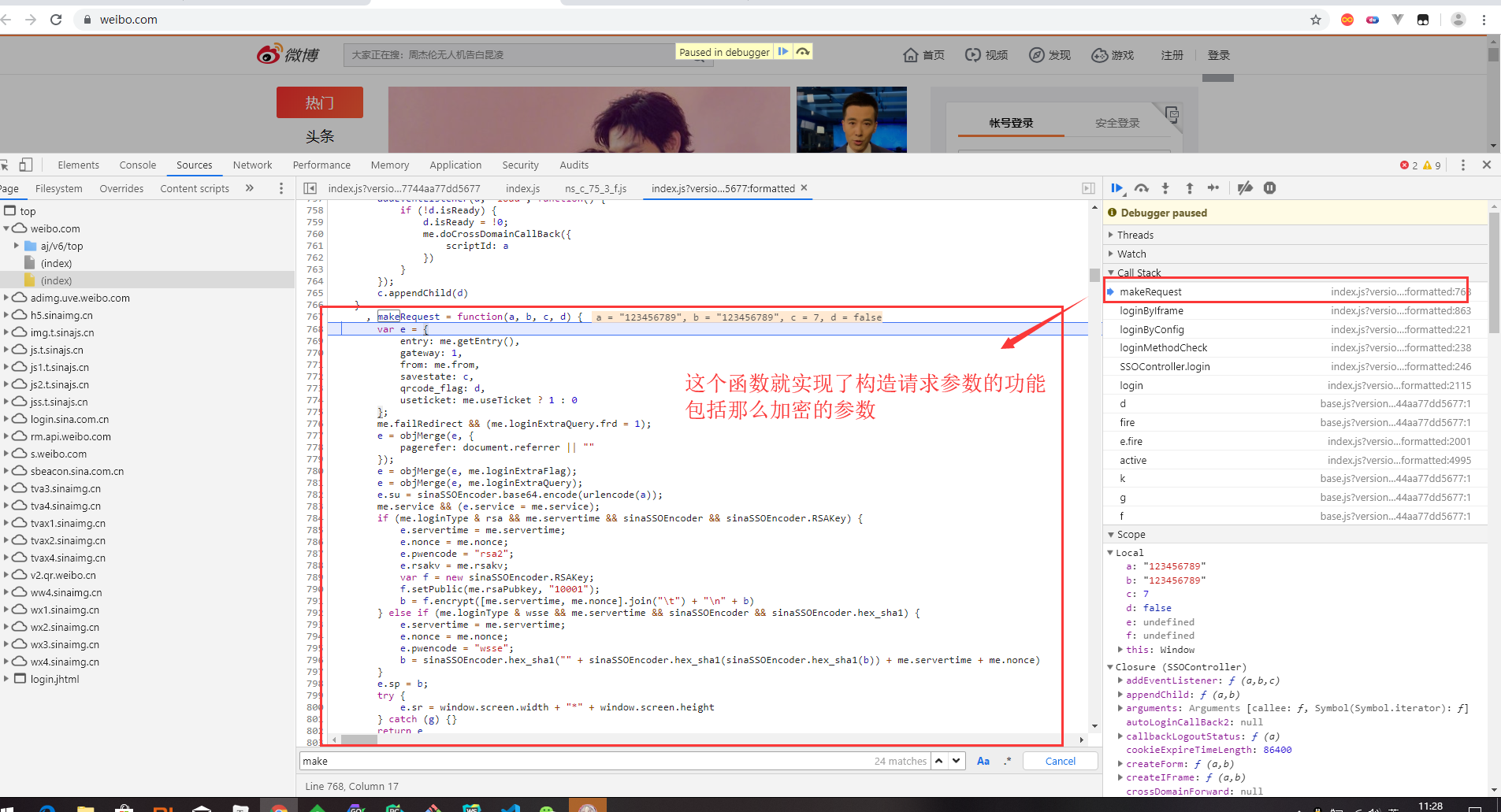

经过js代码流程调试分析,最终我们找到了加密的位置

简单介绍下怎么调试js代码

找到sp,nonce的位置,通过python代码去实现它的加密方式

sp它是通过rsa加密方式,加密生成的。rsa的具体用法可以通过百度找到。或者通过sha1加密生成。至于me.rsaPubkey他怎么得到的,他就是我们还没有点击登录前,就发了一个请求,那个请求的响应数据就有它。如果你测试的次数多了的话,会发现这个值它是固定下来的。所以我们也可以直接去用,不用请求获取。

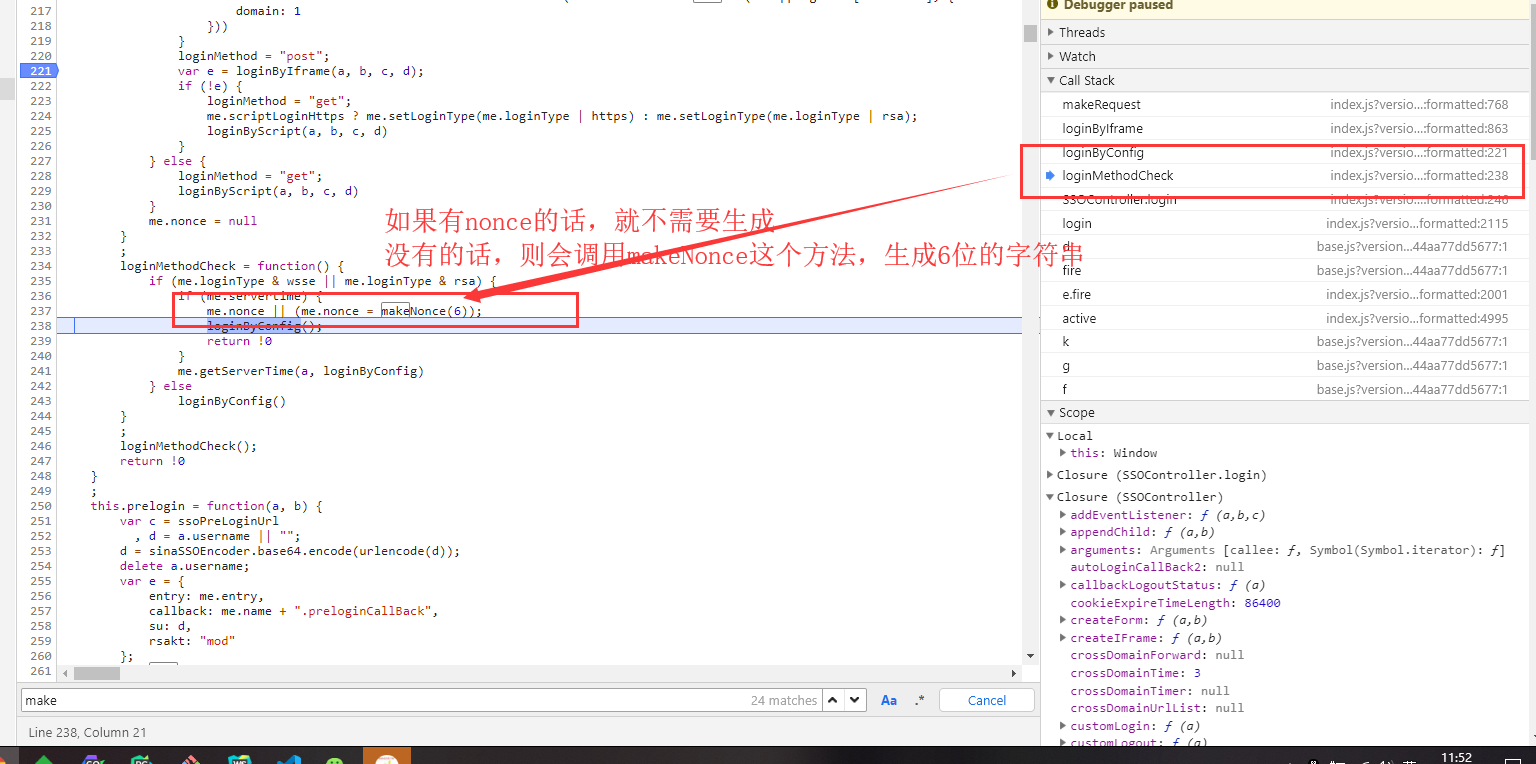

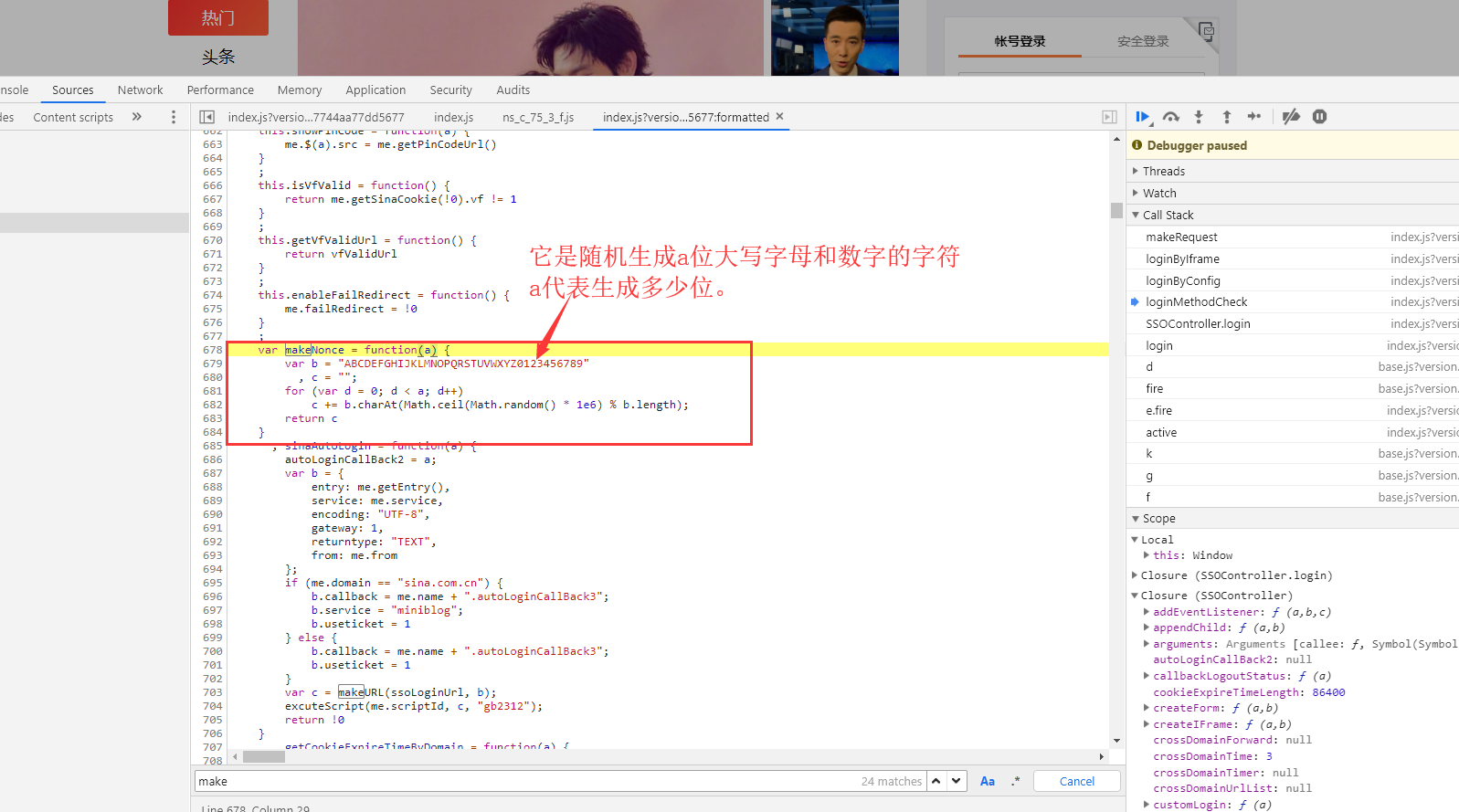

nonce:它呢也出现过在未点击登录前的那个请求响应的数据中,但是呢,我们点了几次登录,都未发现这个请求了。nonce的值每次还不一样。所以它肯定是本地js文件的某个函数生成,不用请求服务器获取。我们在这里找到了nonce的生成函数

import random

import rsa

import hashlib

from binascii import b2a_hex

def get_nonce(n):

result = ""

random_str = "ABCDEFGHIJKLMNOPQRSTUVWXYZ0123456789"

for i in range(n):

index = random.randint(0, len(random_str) - 1)

result += random_str[index]

return result

def get_sp_rsa(password, servertime, nonce):

key = "EB2A38568661887FA180BDDB5CABD5F21C7BFD59C090CB2D245A87AC253062882729293E5506350508E7F9AA3BB77F4333231490F915F6D63C55FE2F08A49B353F444AD3993CACC02DB784ABBB8E42A9B1BBFFFB38BE18D78E87A0E41B9B8F73A928EE0CCEE1F6739884B9777E4FE9E88A1BBE495927AC4A799B3181D6442443"

pubkey = rsa.PublicKey(int(key, 16), int("10001", 16))

res = rsa.encrypt(bytes("" + "\t".join([servertime, nonce]) + "\n" + password,encoding="utf-8"), pubkey)

return b2a_hex(res)

def get_sp_sha1(password, servertime, nonce):

res = hashlib.sha1(bytes("" + hashlib.sha1(bytes(hashlib.sha1(bytes(password, encoding="utf-8")).hexdigest(),encoding="utf-8")).hexdigest() + servertime + nonce,encoding="utf-8")).hexdigest()

return res

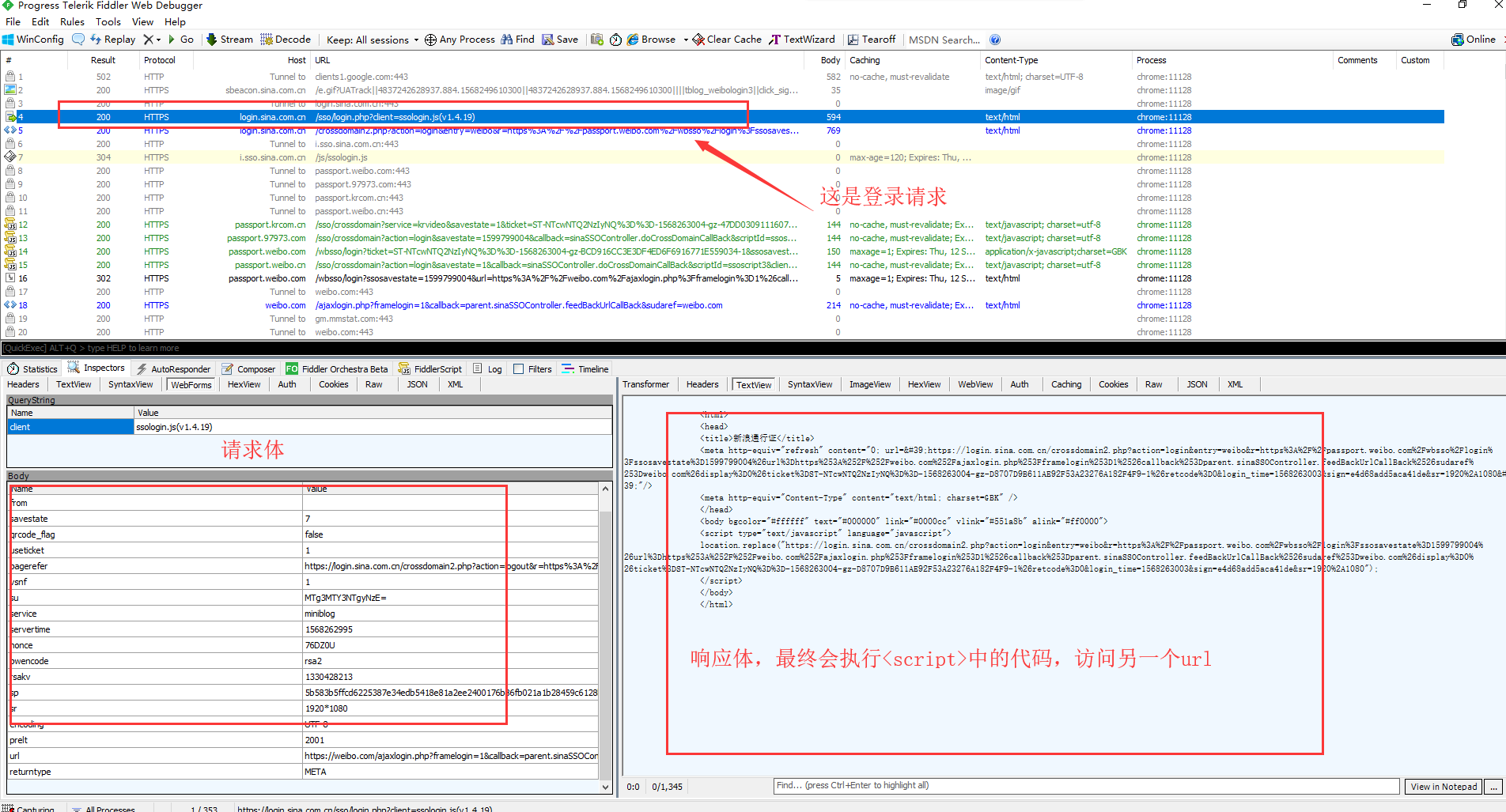

三、响应数据

请求参数分析的差不多了,这次输入正确的用户名,密码。查看响应的数据的是什么。

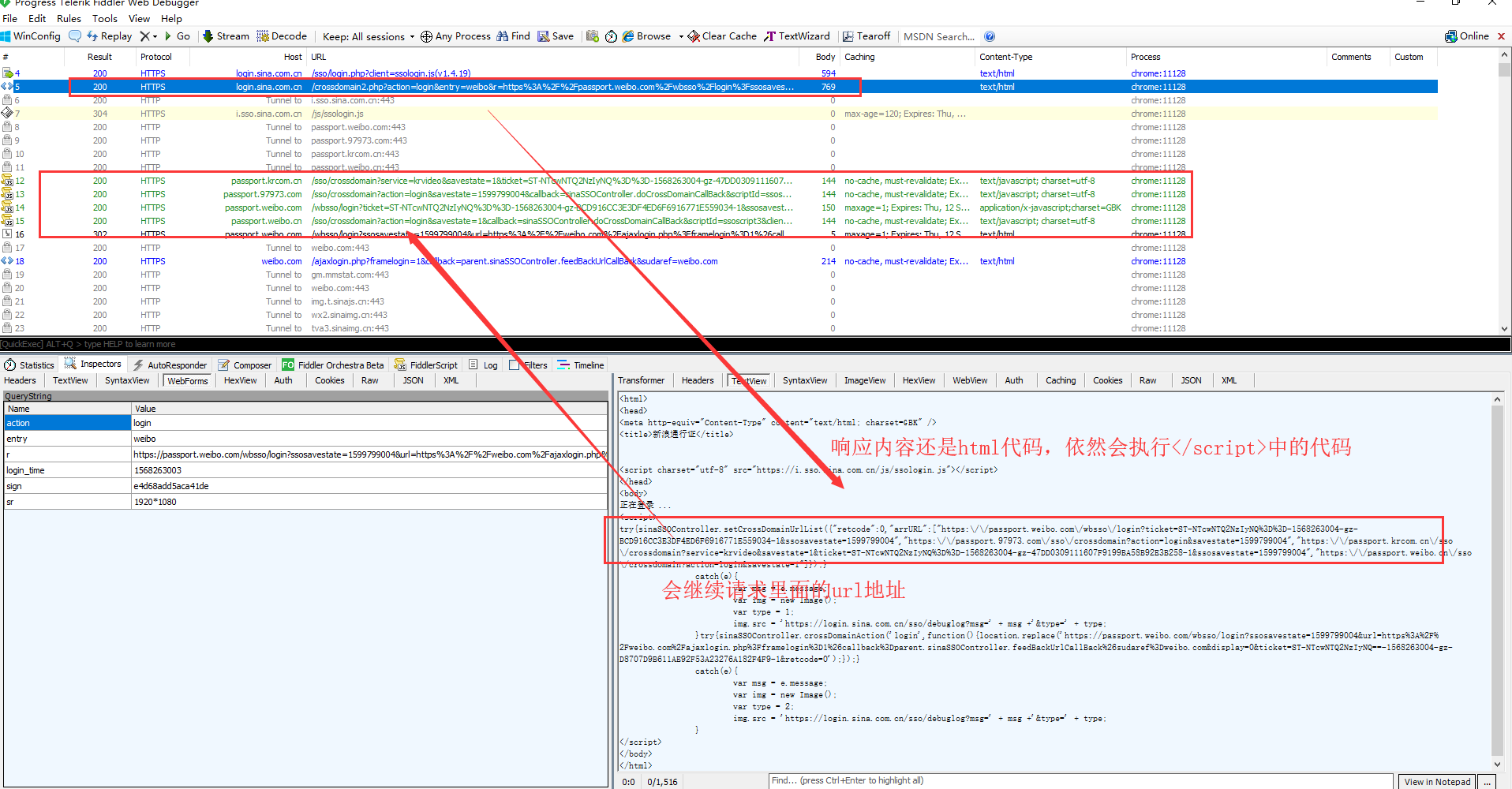

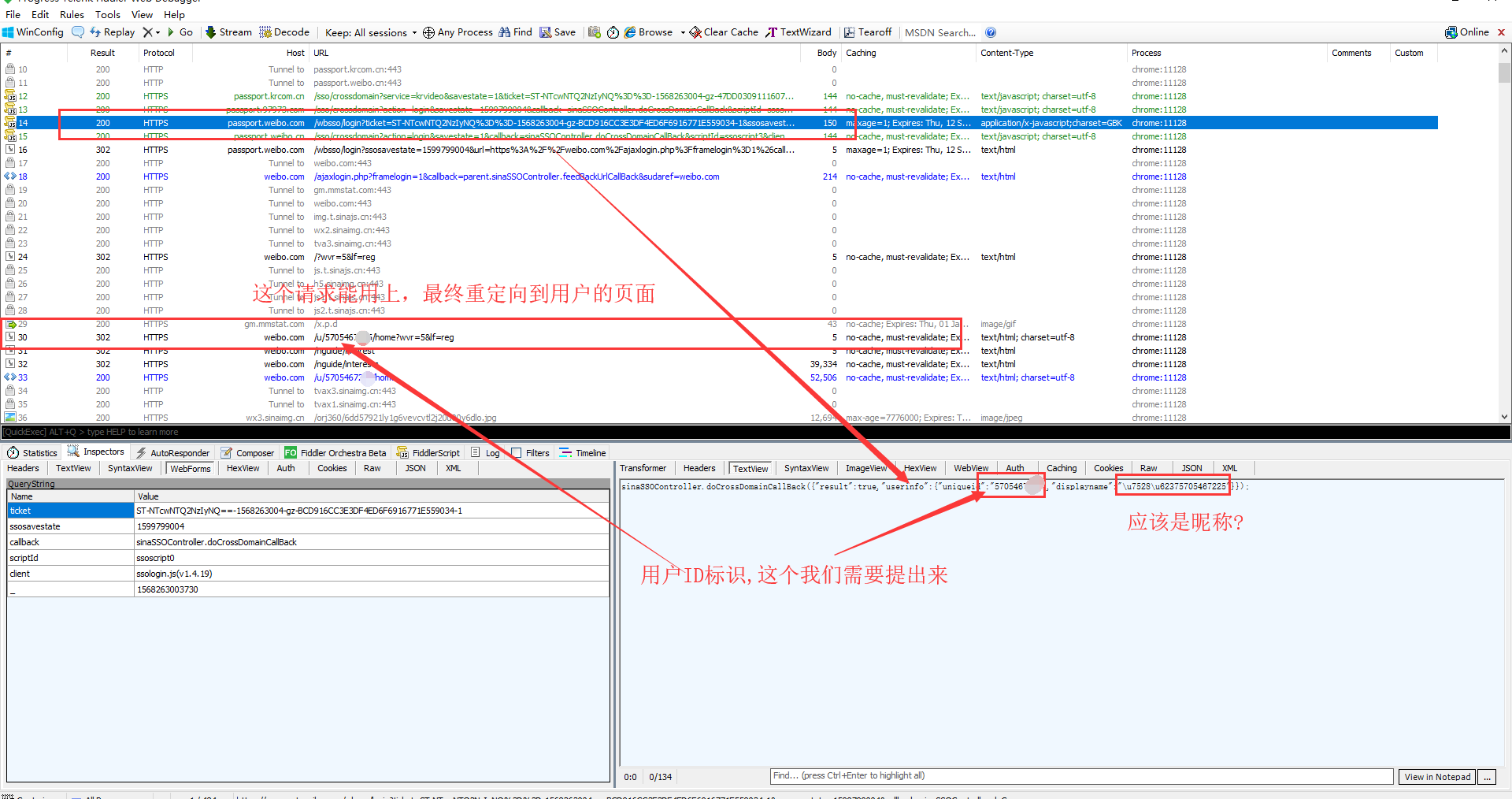

打开fiddler,然后退出当前账号,重新进行登录操作。fiddler上面就会出现很多请求。找到需要的请求,看看响应内容

这样做,每个响应都会set-cookie。所以照着上面的流程实现,标识登录的cookie肯定能得到。之后的话,只要带上这个cookie去做其他操作就行了。

最后附上代码

import requests, random, time, rsa, hashlib, base64, re, json

from binascii import b2a_hex

class WeiBo:

def __init__(self):

self.session = requests.Session()

self.headers = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/76.0.3809.132 Safari/537.36"

}

def login(self, account, password):

api = "https://login.sina.com.cn/sso/login.php?client=ssologin.js(v1.4.19)"

nonce = self._get_nonce()

servertime = self._get_now_time()

sp = self._get_sp_rsa(password, servertime, nonce)

su = self._get_su(account)

data = {

"entry": "weibo",

"gateway": "1",

"from": "",

"savestate": "7",

"qrcode_flag": "false",

"useticket": "1",

"pagerefer": "https://login.sina.com.cn/crossdomain2.php?action=logout&r=https%3A%2F%2Fpassport.weibo.com%2Fwbsso%2Flogout%3Fr%3Dhttps%253A%252F%252Fweibo.com%26returntype%3D1",

"vsnf": "1",

"su": su,

"service": "miniblog",

"servertime": servertime,

"nonce": nonce,

"pwencode": "rsa2",

"rsakv": "1330428213",

"sp": sp,

"sr": "1920*1080",

"encoding": "UTF - 8",

"prelt": "149",

"url": "https://weibo.com/ajaxlogin.php?framelogin=1&callback=parent.sinaSSOController.feedBackUrlCallBack",

"returntype": "META",

}

headers = self.headers.copy()

headers.update({

"Host": "login.sina.com.cn",

"Origin": "https://weibo.com",

"Referer": "https://weibo.com/"

})

response = self.session.post(api, headers=headers, data=data, allow_redirects=False)

search_result = self._re_search("location.replace\(\"(.*?)\"", response.text)

redirct_url = search_result and search_result.group(1)

if not redirct_url:

raise Exception("重定向url获取失败")

response = self.session.get(redirct_url, headers=headers.update({

"Referer": "https://login.sina.com.cn/sso/login.php?client=ssologin.js(v1.4.19)"

}), allow_redirects=False)

search_result = self._re_search('"arrURL":(.*?)}', response.text)

redirct_urls = search_result and search_result.group(1)

if not redirct_urls:

raise Exception("重定向url获取失败")

redirct_url_list = json.loads(redirct_urls)

userId = ""

for url in redirct_url_list:

response = self.session.get(url, headers=self.headers)

if url.startswith("https://passport.weibo.com/wbsso/login"):

userId = self._re_search('"uniqueid":"(.*?)"', response.text).group(1)

if not userId:

raise Exception("userId获取失败")

user_details_url = "https://weibo.com/u/{}/home?wvr=5&lf=reg".format(userId)

response = self.session.get(user_details_url, headers={

"Referer": "https://weibo.com/",

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/76.0.3809.132 Safari/537.36"

})

if self._re_search(userId, response.text):

print("登录成功")

print(self.session.cookies)

else:

print("登录失败")

def _get_nonce(self):

nonce = ""

random_str = "ABCDEFGHIJKLMNOPQRSTUVWXYZ0123456789"

for i in range(5):

index = random.randint(0, len(random_str) - 1)

nonce += random_str[index]

return nonce

def _get_now_time(self):

return str(int(time.time()))

def _get_sp_rsa(self, password, servertime, nonce):

key = "EB2A38568661887FA180BDDB5CABD5F21C7BFD59C090CB2D245A87AC253062882729293E5506350508E7F9AA3BB77F4333231490F915F6D63C55FE2F08A49B353F444AD3993CACC02DB784ABBB8E42A9B1BBFFFB38BE18D78E87A0E41B9B8F73A928EE0CCEE1F6739884B9777E4FE9E88A1BBE495927AC4A799B3181D6442443"

pubkey = rsa.PublicKey(int(key, 16), int("10001", 16))

res = rsa.encrypt(bytes("" + "\t".join([servertime, nonce]) + "\n" + password, encoding="utf-8"), pubkey)

return b2a_hex(res)

def _get_sp_sha1(self, password, servertime, nonce):

res = hashlib.sha1(bytes("" + hashlib.sha1(bytes(hashlib.sha1(bytes(password, encoding="utf-8")).hexdigest(),

encoding="utf-8")).hexdigest() + servertime + nonce,

encoding="utf-8")).hexdigest()

return res

def _get_su(self, account):

return str(base64.b64encode(bytes(account, encoding="utf-8")), encoding="utf-8")

def _re_search(self, pattern, html):

return re.search(pattern, html, re.S)

def test(self):

self.login("18716758777", "123456")

if __name__ == '__main__':

wb = WeiBo()

wb.test()

python爬虫-模拟微博登录的更多相关文章

- python爬虫--模拟12306登录

模拟12306登录 超级鹰: #!/usr/bin/env python # coding:utf-8 import requests from hashlib import md5 class Ch ...

- python爬虫模拟登陆

python爬虫模拟登陆 学习了:https://www.cnblogs.com/chenxiaohan/p/7654667.html 用的这个 学习了:https://www.cnblogs.co ...

- python+selenium模拟京东登录后台

python+selenium模拟京东登录后台 import json from time import sleep from selenium import webdriver #from sele ...

- python爬虫模拟登录验证码解决方案

[前言]几天研究验证码解决方案有三种吧.第一.手工输入,即保存图片后然后我们手工输入:第二.使用cookie,必须输入密码一次,获取cookie:第三.图像处理+深度学习方案,研究生也做相关课题,就用 ...

- Python 爬虫模拟登陆知乎

在之前写过一篇使用python爬虫爬取电影天堂资源的博客,重点是如何解析页面和提高爬虫的效率.由于电影天堂上的资源获取权限是所有人都一样的,所以不需要进行登录验证操作,写完那篇文章后又花了些时间研究了 ...

- python爬虫之新浪微博登录

fiddler 之前了解了一些常见到的反爬措施,JS加密算是比较困难,而微博的登录中正是用JS加密来反爬,今天来了解一下. 分析过程 首先我们去抓包,从登录到微博首页加载出来的过程.我们重点关注一下登 ...

- 用python连接数据库模拟用户登录

使用pycharm下载pymysql库,在终端输入命令: pip install mysql 使用pycharm写登入操作前需要在数据库内添加一些数据,比如用户名和密码 create database ...

- python爬虫模拟登录的图片验证码处理和会话维持

目标网站:古诗文网 登录界面显示: 打开控制台工具,输入账号密码,在ALL栏目中进行抓包 数据如下: 登录请求的url和请求方式 登录所需参数 参数分析: __VIEWSTATE和__VIEWSTAT ...

- Python爬虫常用之登录(二) 浏览器模拟登录

浏览器模拟登录的主要技术点在于: 1.如何使用python的浏览器操作工具selenium 2.简单看一下网页,找到帐号密码对应的框框,要知道python开启的浏览器如何定位到这些 一.使用selen ...

随机推荐

- [Pulsar系列] 10分钟学会Pulsar消息系统概念

Apache Pulsar Pulsar是一个支持多租户的.高性能的服务与服务之间消息通讯的解决方案,最初由雅虎开发,现在由Apache软件基金会管理. Pulsar的主要特性如下: Pulsar实例 ...

- 一文读懂JS中的原型和原型链(图解)

讲原型的时候,我们应该先要记住以下几个要点,这几个要点是理解原型的关键: 1.所有的引用类型(数组.函数.对象)可以自由扩展属性(除null以外). 2.所有的引用类型都有一个’_ _ proto_ ...

- 【Kubernetes 系列一】Kubernetes 概述

以下内容还可以通过 Google Slide 查看:https://docs.google.com/presentation/d/1eYP4bkVBojI_e6PqdpxIf0hvWO-JwAf-fy ...

- HTML5标签的使用和作用

在菜鸟教程中找了一些关于HTML5的知识点,觉得很有用,可以整理一下,以后使用. 这是一个基本的HTML5文档: <!DOCTYPE html><html><head&g ...

- 《深入理解Java虚拟机》- Java虚拟机是如何加载Java类的?

Java虚拟机是如何加载Java类的? 这个问题也就是面试常问到的Java类加载机制.在年初面试百战之后,菜鸟喜鹊也是能把这流程倒背如流啊!但是,也只是字面上的背诵,根本就是像上学时背书考试一样. ...

- 8.9 day30 并发编程 进程理论 进程方法 守护进程 互斥锁

多道技术 1.空间上的复用 多个程序共用一套计算机硬件 多道技术原理 2.时间上的复用 切换+保存状态 1.当一个程序遇到IO操作 操作系统会剥夺该程序的CPU执行权限( 提高了CPU的利用率 ...

- 面试java后端面经_1

1 自我介绍(建议提前准备:没准备的可以这样说:来自某学校 姓名 专业 学的啥 为啥学 自己陆陆续续开发的项目 毕业将近 找工作 在哪看到贵公司的招聘 准备了啥 大概这样) 例子:您好!我是来自XXX ...

- gRPC快速入门记录

为什么使用grpc 1.protocl buffer一种高效的序列化结构. 2.支持http 2.0标准化协议. http/2 1.http/2对每个源只需创建一个持久连接,在这一个连接内,可以并行的 ...

- Linux云计算高端架构师+DevOps高级虚拟化高级进阶视频

课程大纲 1.开班典礼(1)_rec.mp4 2.开班典礼(2)_rec.mp4 3.开班典礼(3)_rec.flv 4.Linux操作系统系统安装及启动流程(1)_rec.flv 5.Linux操作 ...

- C++标准库函数 end 的实现原理(非类型模板参数)

在刚开始学习<C++ Primer>的时候遇到了 end 函数,感觉很神奇,但又很迷惑:为什么能获得数组的尾后指针呢?编译器也不会在内存中申请一块空间放数组元素的个数啊!最近再一次遇到了 ...