RNN入门(一)识别MNIST数据集

RNN介绍

在读本文之前,读者应该对全连接神经网络(Fully Connected Neural Network, FCNN)和卷积神经网络( Convolutional Neural Network, CNN)有一定的了解。对于FCNN和CNN来说,他们能解决很多实际问题,但是它们都只能单独的取处理一个个的输入,前一个输入和后一个输入是完全没有关系的 。而在现实生活中,我们输入的向量往往存在着前后联系,即前一个输入和后一个输入是有关联的,比如文本,语音,视频等,因此,我们需要了解深度学习中的另一类重要的神经网络,那就是循环神经网络(Recurrent Neural Network,RNN).

循环神经网络(Recurrent Neural Network,RNN)依赖于一个重要的概念:序列(Sequence),即输入的向量是一个序列,存在着前后联系。简单RNN的结构示意图如下:

相比于之前的FCNN,RNN的结构中多出了一个自循环部分,即W所在的圆圈,这是RNN的精华所在,它展开后的结构如下:

对于t时刻的输出向量\(o_{t}\),它的输出不仅仅依赖于t时刻的输入向量\(x_{t}\),还依赖于t-1时刻的隐藏层向量\(s_{t-1}\),以下是输出向量\(o_{t}\)的计算公式:

\]

\]

其中,第二个式子为输出层的计算公式,输出层为全连接层,V为权重矩阵,g为激活函数。第一个式子中,U是输入x的权重矩阵,W是上一次隐藏层值s的输入权重矩阵,f为激活函数。注意到,RNN的所有权重矩阵U,V,W是共享的,这样可以减少计算量。

本文将会用TensorFlow中已经帮我们实现好的RNN基本函数tf.contrib.rnn.BasicRNNCell(), tf.nn.dynamic_rnn()来实现简单RNN,并且用该RNN来识别MNIST数据集。

MNIST数据集

MNIST数据集是深度学习的经典入门demo,它是由6万张训练图片和1万张测试图片构成的,每张图片都是28*28大小(如下图),而且都是黑白色构成(这里的黑色是一个0-1的浮点数,黑色越深表示数值越靠近1),这些图片是采集的不同的人手写从0到9的数字。

在TensorFlow中,已经内嵌了MNIST数据集,笔者已经下载下来了,如下:

接下来本文将要用MNIST数据集作为RNN应用的一个demo.

RNN大战MNIST数据集

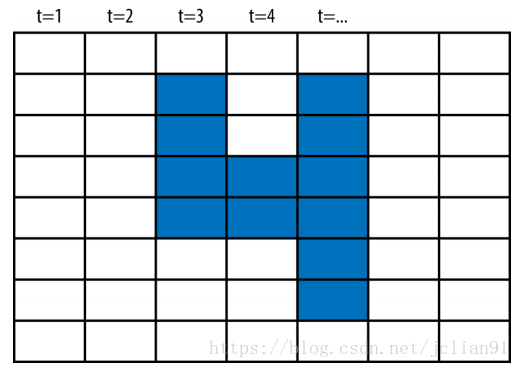

用CNN来识别MNIST数据集,我们好理解,这是利用了图片的空间信息。可是,RNN要求输入的向量是序列,那么,如何把图片看成是序列呢?

图片的大小为28*28,我们把每一列向量看成是某一时刻的向量,那么每张图片就是一个序列,里面含有28个向量,每个向量含有28个元素,如下:

下面给出如何利用TensorFlow来搭建简单RNN,用来识别MNIST数据集,完整的Python代码如下:

# -*- coding: utf-8 -*-

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

# 获取MNIST数据

mnist = input_data.read_data_sets(r"./MNIST_data", one_hot=True)

# 设置RNN结构

element_size = 28

time_steps = 28

num_classes = 10

batch_size = 128

hidden_layer_size = 150

# 输入向量和输出向量

_inputs = tf.placeholder(tf.float32, shape=[None, time_steps, element_size], name='inputs')

y = tf.placeholder(tf.float32, shape=[None, num_classes], name='inputs')

# 利用TensorFlow的内置函数BasicRNNCell, dynamic_rnn来构建RNN的基本模块

rnn_cell = tf.contrib.rnn.BasicRNNCell(hidden_layer_size)

outputs, _ = tf.nn.dynamic_rnn(rnn_cell, _inputs, dtype=tf.float32)

Wl = tf.Variable(tf.truncated_normal([hidden_layer_size, num_classes], mean=0,stddev=.01))

bl = tf.Variable(tf.truncated_normal([num_classes],mean=0,stddev=.01))

def get_linear_layer(vector):

return tf.matmul(vector, Wl) + bl

# 取输出的向量outputs中的最后一个向量最为最终输出

last_rnn_output = outputs[:,-1,:]

final_output = get_linear_layer(last_rnn_output)

# 定义损失函数并用RMSPropOptimizer优化

softmax = tf.nn.softmax_cross_entropy_with_logits(logits=final_output, labels=y)

cross_entropy = tf.reduce_mean(softmax)

train_step = tf.train.RMSPropOptimizer(0.001, 0.9).minimize(cross_entropy)

# 统计准确率

correct_prediction = tf.equal(tf.argmax(y,1), tf.argmax(final_output,1))

accuracy = (tf.reduce_mean(tf.cast(correct_prediction, tf.float32)))*100

sess=tf.InteractiveSession()

sess.run(tf.global_variables_initializer())

# 测试集

test_data = mnist.test.images[:batch_size].reshape((-1, time_steps, element_size))

test_label = mnist.test.labels[:batch_size]

# 每次训练batch_size张图片,一共训练3000次

for i in range(3001):

batch_x, batch_y = mnist.train.next_batch(batch_size)

batch_x = batch_x.reshape((batch_size, time_steps, element_size))

sess.run(train_step, feed_dict={_inputs:batch_x, y:batch_y})

if i % 100 == 0:

loss = sess.run(cross_entropy, feed_dict={_inputs: batch_x, y: batch_y})

acc = sess.run(accuracy, feed_dict={_inputs:batch_x, y: batch_y})

print ("Iter " + str(i) + ", Minibatch Loss= " + \

"{:.6f}".format(loss) + ", Training Accuracy= " + \

"{:.5f}".format(acc))

# 在测试集上的准确率

print("Testing Accuracy:", sess.run(accuracy, feed_dict={_inputs:test_data, y:test_label}))

运行上述代码,输出的结果如下:

Extracting ./MNIST_data\train-images-idx3-ubyte.gz

Extracting ./MNIST_data\train-labels-idx1-ubyte.gz

Extracting ./MNIST_data\t10k-images-idx3-ubyte.gz

Extracting ./MNIST_data\t10k-labels-idx1-ubyte.gz

Iter 0, Minibatch Loss= 2.301171, Training Accuracy= 11.71875

Iter 100, Minibatch Loss= 1.718483, Training Accuracy= 47.65625

Iter 200, Minibatch Loss= 0.862968, Training Accuracy= 71.09375

Iter 300, Minibatch Loss= 0.513068, Training Accuracy= 86.71875

Iter 400, Minibatch Loss= 0.570475, Training Accuracy= 83.59375

Iter 500, Minibatch Loss= 0.254566, Training Accuracy= 92.96875

Iter 600, Minibatch Loss= 0.457989, Training Accuracy= 85.93750

Iter 700, Minibatch Loss= 0.151181, Training Accuracy= 96.87500

Iter 800, Minibatch Loss= 0.171168, Training Accuracy= 94.53125

Iter 900, Minibatch Loss= 0.142494, Training Accuracy= 94.53125

Iter 1000, Minibatch Loss= 0.155114, Training Accuracy= 97.65625

Iter 1100, Minibatch Loss= 0.096007, Training Accuracy= 96.87500

Iter 1200, Minibatch Loss= 0.341476, Training Accuracy= 88.28125

Iter 1300, Minibatch Loss= 0.133509, Training Accuracy= 96.87500

Iter 1400, Minibatch Loss= 0.076408, Training Accuracy= 98.43750

Iter 1500, Minibatch Loss= 0.122228, Training Accuracy= 98.43750

Iter 1600, Minibatch Loss= 0.099382, Training Accuracy= 96.87500

Iter 1700, Minibatch Loss= 0.084686, Training Accuracy= 97.65625

Iter 1800, Minibatch Loss= 0.067009, Training Accuracy= 98.43750

Iter 1900, Minibatch Loss= 0.189703, Training Accuracy= 94.53125

Iter 2000, Minibatch Loss= 0.116077, Training Accuracy= 96.09375

Iter 2100, Minibatch Loss= 0.028867, Training Accuracy= 100.00000

Iter 2200, Minibatch Loss= 0.064198, Training Accuracy= 99.21875

Iter 2300, Minibatch Loss= 0.078259, Training Accuracy= 97.65625

Iter 2400, Minibatch Loss= 0.106613, Training Accuracy= 97.65625

Iter 2500, Minibatch Loss= 0.078722, Training Accuracy= 98.43750

Iter 2600, Minibatch Loss= 0.045871, Training Accuracy= 98.43750

Iter 2700, Minibatch Loss= 0.030953, Training Accuracy= 99.21875

Iter 2800, Minibatch Loss= 0.062823, Training Accuracy= 96.87500

Iter 2900, Minibatch Loss= 0.040367, Training Accuracy= 99.21875

Iter 3000, Minibatch Loss= 0.017787, Training Accuracy= 100.00000

Testing Accuracy: 97.6563

可以看到,用简单RNN来识别MNIST数据集,也能取得很好的效果!

本次分享到此结束,欢迎大家交流~

注意:本人现已开通微信公众号: 轻松学会Python爬虫(微信号为:easy_web_scrape), 欢迎大家关注哦~~

RNN入门(一)识别MNIST数据集的更多相关文章

- Python实现bp神经网络识别MNIST数据集

title: "Python实现bp神经网络识别MNIST数据集" date: 2018-06-18T14:01:49+08:00 tags: [""] cat ...

- SGD与Adam识别MNIST数据集

几种常见的优化函数比较:https://blog.csdn.net/w113691/article/details/82631097 ''' 基于Adam识别MNIST数据集 ''' import t ...

- 卷积神经网络CNN识别MNIST数据集

这次我们将建立一个卷积神经网络,它可以把MNIST手写字符的识别准确率提升到99%,读者可能需要一些卷积神经网络的基础知识才能更好的理解本节的内容. 程序的开头是导入TensorFlow: impor ...

- mxnet实战系列(一)入门与跑mnist数据集

最近在摸mxnet和tensorflow.两个我都搭起来了.tensorflow跑了不少代码,总的来说用得比较顺畅,文档很丰富,api熟悉熟悉写代码没什么问题. 今天把两个平台做了一下对比.同是跑mn ...

- 81、Tensorflow实现LeNet-5模型,多层卷积层,识别mnist数据集

''' Created on 2017年4月22日 @author: weizhen ''' import os import tensorflow as tf import numpy as np ...

- 吴裕雄 python 神经网络TensorFlow实现LeNet模型处理手写数字识别MNIST数据集

import tensorflow as tf tf.reset_default_graph() # 配置神经网络的参数 INPUT_NODE = 784 OUTPUT_NODE = 10 IMAGE ...

- 关于入门深度学习mnist数据集前向计算的记录

import osimport lr as lrimport tensorflow as tffrom pyspark.sql.functions import stddevfrom tensorfl ...

- 吴裕雄 python 神经网络——TensorFlow实现AlexNet模型处理手写数字识别MNIST数据集

import tensorflow as tf # 输入数据 from tensorflow.examples.tutorials.mnist import input_data mnist = in ...

- 机器学习(2) - KNN识别MNIST

代码 https://github.com/s055523/MNISTTensorFlowSharp 数据的获得 数据可以由http://yann.lecun.com/exdb/mnist/下载.之后 ...

随机推荐

- [Solution] JZOJ-5818 做运动

[Solution] JZOJ-5818 做运动 Time Limits:2000ms Memory Limits:524288KB Description 一天,Y 君在测量体重的时候惊讶的发现,由 ...

- openXML写Excel列组合

重要代码: DOS.SheetData sheetData = new DOS.SheetData(); DOS.Columns columns = new DOS.Columns(); DOS.Co ...

- 获取列表菜单的选项值与选项以后的VALUE

<html> <body> <select id="izan" name="" onchange='izzzz()'> &l ...

- 三级菜单,可以退出到上一级菜单和全部退出(low版本)

menu = { '北京':{ '海淀':{ '五道口':{ 'soho':{}, '网易':{}, 'google':{} }, '中关村':{ '爱奇艺':{}, '汽车之家':{}, 'youk ...

- 为程序设置多语言界面——C#

考虑到程序的国际化需求,需要为程序设置多语言界面. 1,新建一个资源文件,名字可以是对应界面+语言代码(MainForm.zh-CN).这样资源文件就会自动添加到对应界面下面. 2,更改界面属性Loc ...

- PYTHON进阶(4)

学习内容: 1.html简介 2.html标签 3.堡垒机 一.html简介 HTML是英文Hyper Text Mark-up Language(超文本标记语言)的缩写,他是一种制作万维网页面标准语 ...

- 复习java基础

十进制转换成二进制: 方法:整除法,计数方式从右往左,二进制中非0即1.例子如下: 计数方式是从右往左进行,然后填写数字的顺序是余数优先 二进制转换成十进制: 方法:乘二法,例如二进制数字为: ...

- Windows-WMI 事件 ID 10或0x80041003 死机 解药

最近笔记本重复了好几次奇怪的现象,重启后进入桌面,然后死机,木有蓝屏. 后来在安全模式里查了事件,如下 日志名称: Application 来源: Micros ...

- Docker学习笔记-Redis 安装

拉取官方的镜像 docker pull redis:3.2 查看 docker images redis 运行容器 docker run -p 6379:6379 -v $PWD/data:/data ...

- 如何获取java运行时动态生成的class文件?

查看运行时生成的文件,以更清楚运行情况. 查看动态生成的类,一般有两个方法: 1. 使用据说是jdk自带包sa-jdi.jar里的工具. 其中,不想自己搞,当然就利用下,sa-jdi.jar 里自带的 ...