hive 将hive表数据查询出来转为json对象和json数组输出

一、将hive表数据查询出来转为json对象输出

1、将查询出来的数据转为一行一行,并指定分割符的数据

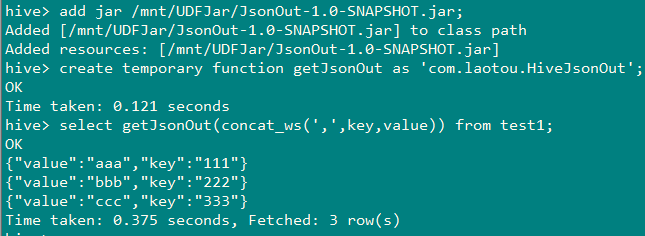

2、使用UDF函数,将每一行数据作为string传入UDF函数中转换为json再返回

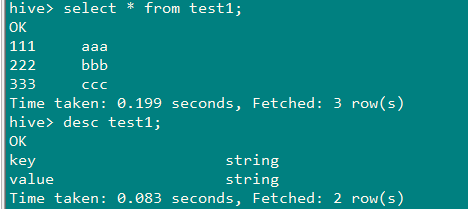

1、准备数据

2、查询出来的数据转为一行一行,并指定分割符的数据

3、准备UDF函数

package com.laotou; import org.apache.hadoop.hive.ql.exec.UDF;

import org.json.JSONException;

import org.json.JSONObject; /**

* @Author:

* @Date: 2019/8/9

*/

public class HiveJsonOut extends UDF{public static String evaluate(String jsonStr) throws JSONException {

String[] split = jsonStr.split(",");

JSONObject result = new JSONObject();

result.put("key", split[0]);

result.put("value", split[1]);

return String.valueOf(result);

}

}

package com.laotou; import org.apache.hadoop.hive.ql.exec.UDF;

import org.json.JSONException;

import org.json.JSONObject; /**

* @Author:

* string转json:{"notifyType":13,"notifyEntity":{"school":"小学","name":"张三","age":"13"}}

* @Date: 2019/8/14

*/

public class Record2Notify extends UDF {

private static final String split_char = "!";

private static final String null_char = "\002"; public static String evaluate(int type, String line) throws JSONException {

if (line == null) {

return null;

}

JSONObject notify = new JSONObject();

JSONObject entity = new JSONObject();

notify.put("notifyType", type);

String[] columns = line.split(split_char, -1);

int size = columns.length / 2;

for (int i = 0; i < size; i++) {

String key = columns[i*2];

String value = columns[i*2+1];

if (isNull(key)) {

throw new JSONException("Null key.1111111111");

}

if (!isNull(value)) {

entity.put(key, value);

}

}

notify.put("notifyEntity", entity); return notify.toString();

} private static boolean isNull(String value) {

return value == null || value.isEmpty() || value.equals(null_char);

} public static void main(String[] args) throws JSONException {

System.out.println(evaluate(13,"name!张三!age!13!school!小学"));

}

}

二、将hive表数据查询出来转为json数组输出

思路:

1、使用UDF函数(见上面内容)将查询出来的每一条数据转成json对象

select getJsonOut(concat_ws(',',key,value)) as content from test1

2、将第一步查询的结果进行列转行,并设置为逗号进行分割,得到如下字符串

select concat_ws('!!',collect_list(bb.content)) as new_value

from

(select getJsonOut(concat_ws(',',key,value)) as content from test1) bb;

结果如图:

3、使用UDF函数(JsonArray)将第2步中得到的字符串放入数组对象,准备UDF函数

package com.laotou;

import org.apache.hadoop.hive.ql.exec.UDF;

import org.json.JSONArray;

import org.json.JSONException;

/**

* create temporary function getJsonArray as 'com.laotou.HiveJson';

* @Author:

* @Date: 2019/8/9

*/

public class HiveJson extends UDF{

public static JSONArray evaluate(String jsonStr) throws JSONException {

String[] split = jsonStr.split("!!");

JSONArray jsonArray = new JSONArray();

jsonArray.put(split[0]);

jsonArray.put(split[1]);

jsonArray.put(split[2]);

jsonArray.put(split[3]);

return jsonArray;

}

}

4、测试

select getJsonArray(new_value) from

(select cast(concat_ws('!!',collect_list(bb.content)) as string) as new_value from

(select getJsonOut(concat_ws(',',key,value)) as content from test1) bb) cc;

hive 将hive表数据查询出来转为json对象和json数组输出的更多相关文章

- Hive的join表连接查询的一些注意事项

Hive支持的表连接查询的语法: join_table: table_reference JOIN table_factor [join_condition] | table_reference {L ...

- SQL Server 的表数据简单操作(表数据查询)

--表数据查询----数据的基本查询-- --数据简单的查询--select * | 字段名[,字段名2, ...] from 数据表名 [where 条件表达式] 例: use 商品管理数据库 go ...

- 10Oracle Database 数据表数据查询

Oracle Database 数据表数据查询 DML 数据操纵语言 - 数据的查看和维护 select / insert /delete /update 基本查询语句 Select [distinc ...

- MySQL多表数据查询(DQL)

数据准备: /* ------------------------------------创建班级表------------------------------------ */ CREATE TAB ...

- MySQL单表数据查询(DQL)

数据准备工作: CREATE TABLE student( sid INT PRIMARY KEY AUTO_INCREMENT, sname ), age TINYINT, city ), scor ...

- MySQL学习总结(五)表数据查询

查询数据记录,是指从数据库对象表中获取所要查询的数据记录,该操作可以说是数据最基本的操作之一,也是使用频率最高.最重要的数据操作. 1.单表数据记录查询 1.1.简单数据查询 SELECT field ...

- mybatis多表关联查询之resultMap单个对象

resultMap的n+1方式实现多表查询(多对一) 实体类 创建班级类(Clazz)和学生类(Student),并在Student中添加一个Clazz类型的属性,用于表示学生的班级信息. mappe ...

- SpringBoot之封装json对象返回json数据

/** * @description:封装json对象,所有返回结果都使用它 **/ public class Result<T> { private int code;// 业务自定义状 ...

- Hive(五)【DQL数据查询】

目录 一. 基本查询 1.1 算数运算符 1.2 常用聚合函数 1.3 limit 1.4 where 1.5 比较运算符(between|in|is null) 1.6 LIKE和RLIKE 1.7 ...

随机推荐

- 打造云原生大型分布式监控系统(四): Kvass+Thanos 监控超大规模容器集群

概述 继上一篇 Thanos 部署与实践 发布半年多之后,随着技术的发展,本系列又迎来了一次更新.本文将介绍如何结合 Kvass 与 Thanos,来更好的实现大规模容器集群场景下的监控. 有 Tha ...

- LeetCode初级算法之数组:36 有效数独

有效数独 题目地址:https://leetcode-cn.com/problems/valid-sudoku/ 判断一个 9x9 的数独是否有效.只需要根据以下规则,验证已经填入的数字是否有效即可. ...

- Java并发编程的艺术(一)——并发编程的注意问题

并发编程是为了使程序运行得更快,但是,不是启动更多得线程就能最大限度地执行并发,也不是线程更多就能使得程序运行得更快,而且并发编程更容易产生错误,如果要高效且正确地执行并发,就需要注意这三种问题 上下 ...

- ps查看完整程序执行路径

在linux下查看进程大家都会想到用 ps -ef|grep ***可是看到的不是全路径,怎么看全路径呢?每个进程启动之后在 /proc下面有一个于pid对应的路径例如:ps -ef|grep jav ...

- Chrome DevTools — Network -- 转载

转载地址:https://segmentfault.com/a/1190000008407729 记录网络请求 默认情况下,只要DevTools在开启状态,DevTools会记录所有的网络请求,当然, ...

- SnowFlakeldWorker

SnowFlakeldWorker java /** * Twitter_Snowflake * SnowFlake的结构如下(每部分用-分开): * 0 - 0000000000 000000000 ...

- JavaScript:记录一些字符串和数组常用的方法

字符串: 字符串的方法:注意:都不会改变原来的字符串,返回值为新的字符串.如果(1,2),一般是包含小标1,不包含下标2 str.charAt(i): 取str的第i+1个字符,类似数组的arr[i] ...

- js实现元素范围内拖动

元素拖拽,网上一堆的实现,其中很多是原生js写的,都不够简洁,甚至运行后看不到效果. 于是乎,安静地想了下,拖动元素貌似就是一个滑动事件的监听处理,具体操作如下: 1.一个外层DIV,或者直接用根节点 ...

- Struts2-059 漏洞复现

0x00 漏洞简介 Apache Struts框架, 会对某些特定的标签的属性值,比如id属性进行二次解析,所以攻击者可以传递将在呈现标签属性时再次解析的OGNL表达式,造成OGNL表达式注入.从而可 ...

- Eureka 集群Demo

由于自己遇到了一些eureka集群疑问,就自己搭了一个集群demo进行测试.测试中通过两个eureka相互注册形成集群,两个服务提供者向eureka中注册服务,两个服务消费者通过feign进行服务调用 ...