2.2、Softmax Regression算法实践

Softmax Regression算法实践

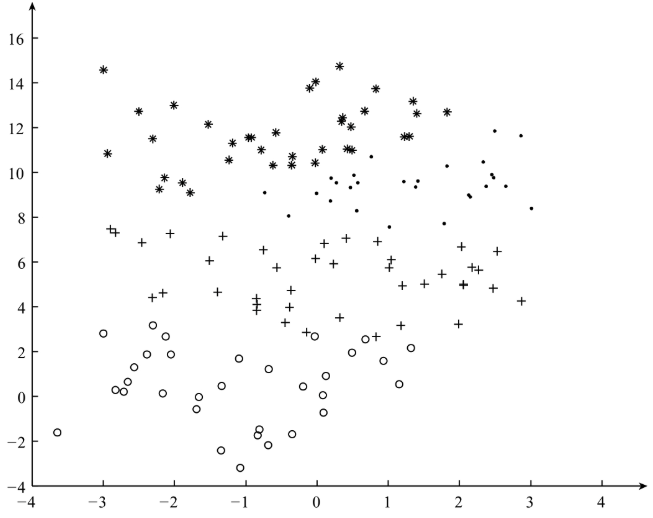

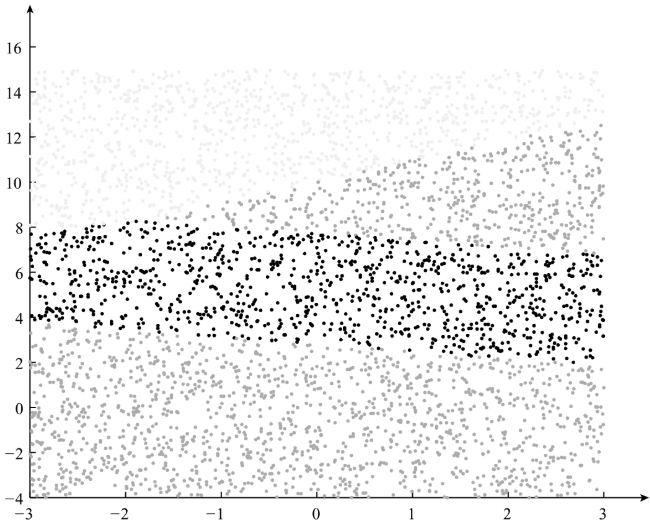

有了上篇博客的理论知识,我们可以利用实现好的函数,来构建Softmax Regression分类器,在训练分类器的过程中,我们使用多分类数据作为训练数据:如图

1、利用训练数据对模型进行训练:

完整代码为:

# -*- coding: UTF- -*-

# date://

# User:WangHong

import numpy as np

def gradientAscent(feature_data,label_data,k,maxCycle,alpha):

'''利用梯度下降法训练Softmax模型

:param feature_data: 特征

:param label_data: 标签

:param k: 类别个数

:param maxCycle: 最大迭代次数

:param alpha: 学习率

:return weights: 权重

'''

m,n = np.shape(feature_data)

weights = np.mat(np.ones((n,k)))#初始化权重

i =

while i<=maxCycle:

err = np.exp(feature_data*weights)

if i % == :

print("\t--------iter:",i,\

",cost:",cost(err,label_data))

rowsum = -err.sum(axis=)

rowsum = rowsum.repeat(k,axis = )

err = err/rowsum

for x in range(m):

err[x,label_data[x,]]+=

weights = weights+(alpha/m)*feature_data.T*err

i+=

return weights def cost(err,label_data):

'''

:param err: exp的值

:param label_data: 标签的值

:return: 损失函数的值

'''

m = np.shape(err)[]

sum_cost = 0.0

for i in range(m):

if err[i,label_data[i,]]/np.sum(err[i,:])>:

sum_cost -=np.log(err[i,label_data[i,]]/np.sum(err[i,:]))

else:

sum_cost -=

return sum_cost / m def load_data(inputfile):

'''导入训练数据

input: inputfile(string)训练样本的位置

output: feature_data(mat)特征

label_data(mat)标签

k(int)类别的个数

'''

f = open(inputfile) # 打开文件

feature_data = []

label_data = []

for line in f.readlines():

feature_tmp = []

feature_tmp.append() # 偏置项

lines = line.strip().split("\t")

for i in range(len(lines) - ):

feature_tmp.append(float(lines[i]))

label_data.append(int(lines[-])) feature_data.append(feature_tmp)

f.close() # 关闭文件

return np.mat(feature_data), np.mat(label_data).T, len(set(label_data)) def save_model(file_name, weights):

'''保存最终的模型

input: file_name(string):保存的文件名

weights(mat):softmax模型

'''

f_w = open(file_name, "w")

m, n = np.shape(weights)

for i in range(m):

w_tmp = []

for j in range(n):

w_tmp.append(str(weights[i, j]))

f_w.write("\t".join(w_tmp) + "\n")

f_w.close() if __name__=="__main__":

inputfile = "SoftInput.txt"

#导入数据

print("--------------1.load data-------------")

feature,label,k = load_data(inputfile)

#训练模型

print("--------------2.traing----------------")

weights = gradientAscent(feature,label,k,,0.2)

#保存模型

print("--------------3.save model------------")

save_model("weights",weights)

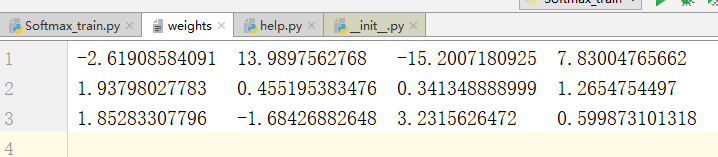

训练结果为

weights文件内容

2、用训练好的模型对数据进行预测:

预测的代码:

# -*- coding: UTF-8 -*-

# date:2018/5/29

# User:WangHong

import numpy as np

import random as rd

def load_weights(weights_path):

'''导入训练好的Softmax模型

input: weights_path(string)权重的存储位置

output: weights(mat)将权重存到矩阵中

m(int)权重的行数

n(int)权重的列数

'''

f = open(weights_path)

w = []

for line in f.readlines():

w_tmp = []

lines = line.strip().split("\t")

for x in lines:

w_tmp.append(float(x))

w.append(w_tmp)

f.close()

weights = np.mat(w)

m, n = np.shape(weights)

return weights, m, n def load_data(num, m):

'''导入测试数据

input: num(int)生成的测试样本的个数

m(int)样本的维数

output: testDataSet(mat)生成测试样本

'''

testDataSet = np.mat(np.ones((num, m)))

for i in range(num):

testDataSet[i, 1] = rd.random() * 6 - 3 # 随机生成[-3,3]之间的随机数

testDataSet[i, 2] = rd.random() * 15 # 随机生成[0,15]之间是的随机数

return testDataSet def predict(test_data, weights):

'''利用训练好的Softmax模型对测试数据进行预测

input: test_data(mat)测试数据的特征

weights(mat)模型的权重

output: h.argmax(axis=1)所属的类别

'''

h = test_data * weights

return h.argmax(axis=1) # 获得所属的类别 def save_result(file_name, result):

'''保存最终的预测结果

input: file_name(string):保存最终结果的文件名

result(mat):最终的预测结果

'''

f_result = open(file_name, "w")

m = np.shape(result)[0]

for i in range(m):

f_result.write(str(result[i, 0]) + "\n")

f_result.close() if __name__ == "__main__":

# 1、导入Softmax模型

print("---------- 1.load model ----------------")

w, m, n = load_weights("weights")

# 2、导入测试数据

print("---------- 2.load data -----------------")

test_data = load_data(4000, m)

# 3、利用训练好的Softmax模型对测试数据进行预测

print("---------- 3.get Prediction ------------")

result = predict(test_data, w)

# 4、保存最终的预测结果

print("---------- 4.save prediction ------------")

save_result("result", result)

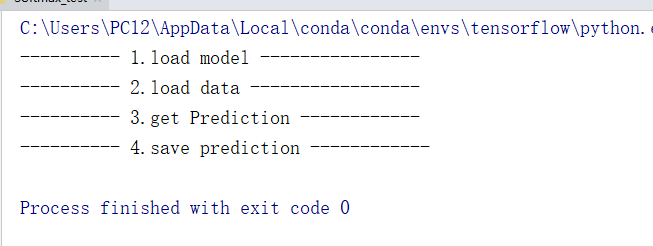

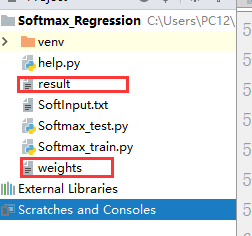

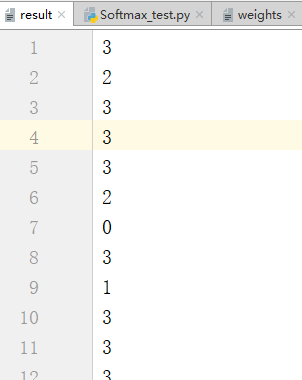

预测结果;

会生成一个result文件用于存储预测结果

在本次测试中随机生成4000个样本,最终分类的结果为:

2.2、Softmax Regression算法实践的更多相关文章

- 1.2、Logistics Regression算法实践

1.1.Logistics Regression算法实践 有了上篇博客的理论准备后,接下来,我们用以及完成的函数,构建Logistics Regression分类器.我们利用线性可分的数据作为训练样 ...

- 学习笔记TF024:TensorFlow实现Softmax Regression(回归)识别手写数字

TensorFlow实现Softmax Regression(回归)识别手写数字.MNIST(Mixed National Institute of Standards and Technology ...

- 2.1、Softmax Regression模型

Softmax Regression模型 由于Logistics Regression算法复杂度低,容易实现等特点,在工业中的到广泛的使用,但是Logistics Regression算法主要用于处理 ...

- TensorFlow实现Softmax Regression识别手写数字

本章已机器学习领域的Hello World任务----MNIST手写识别做为TensorFlow的开始.MNIST是一个非常简单的机器视觉数据集,是由几万张28像素*28像素的手写数字组成,这些图片只 ...

- ufldl学习笔记和编程作业:Softmax Regression(softmax回报)

ufldl学习笔记与编程作业:Softmax Regression(softmax回归) ufldl出了新教程.感觉比之前的好,从基础讲起.系统清晰,又有编程实践. 在deep learning高质量 ...

- ufldl学习笔记与编程作业:Softmax Regression(vectorization加速)

ufldl学习笔记与编程作业:Softmax Regression(vectorization加速) ufldl出了新教程,感觉比之前的好.从基础讲起.系统清晰,又有编程实践. 在deep learn ...

- Softmax回归(Softmax Regression)

转载请注明出处:http://www.cnblogs.com/BYRans/ 多分类问题 在一个多分类问题中,因变量y有k个取值,即.例如在邮件分类问题中,我们要把邮件分为垃圾邮件.个人邮件.工作邮件 ...

- (六)6.10 Neurons Networks implements of softmax regression

softmax可以看做只有输入和输出的Neurons Networks,如下图: 其参数数量为k*(n+1) ,但在本实现中没有加入截距项,所以参数为k*n的矩阵. 对损失函数J(θ)的形式有: 算法 ...

- UFLDL实验报告1: Softmax Regression

PS:这些是今年4月份,跟斯坦福UFLDL教程时的实验报告,当时就应该好好整理的…留到现在好凌乱了 Softmax Regression实验报告 1.Softmax Regression实验描述 So ...

随机推荐

- How to fix apt-get GPG error NO_PUBKEY Ubuntu 14

This morning when I do apt-get update on my new Ubuntu 14.04 server, I got these error messages: R ...

- Oracle & SQL Server 数据传输

在开发中用到的Oracle与SQL Server间数据传输的不同方法的整理,比较.包括原理的简介,配置和实现方法,优缺点的比较,使用平台和DB,适合的应用范围和效能的比较. 整理的方法有如下六种: 1 ...

- 主机不能访问虚拟机中的web服务【解决方案】

百度了其它一些方法都不行,最后实在没辙,关了windows防火墙和Linux防火墙,居然能够访问了,我服. 总结一下,原来是Red Hat Linux 6.0防火墙没有开启端口80,开启的方法为(老版 ...

- DataTable 常用操作

//定义表结构 DataTable dt = new DataTable(); dt.Columns.Add("FactoryId"); 或dt.Columns.Add(new D ...

- 680. Valid Palindrome II 对称字符串-可删字母版本

[抄题]: Given a non-empty string s, you may delete at most one character. Judge whether you can make i ...

- js数值和字符串比较的规则

1.数值和字符串比较时 a.若字符串为数字字符串,则将字符串转为数字,再比较 b.若字符串不为数字字符串,则直接返回false,因为这里把字符串转为了NaN, 数字与NaN比较,都返回false

- Entity Framework 6.0 Tutorials(8):Custom Code-First Conventions

Custom Code-First Conventions: Code-First has a set of default behaviors for the models that are ref ...

- MySQL性能调优与架构设计——第2章 MySQL架构组成

第2章 MySQL架构组成 前言 麻雀虽小,五脏俱全.MySQL 虽然以简单著称,但其内部结构并不简单.本章从MySQL物理组成.逻辑组成,以及相关工具几个角度来介绍 MySQL 的整体架构组成, ...

- 设计模式02: Abstract Factory 抽象工厂(创建型模式)

Abstract Factory 抽象工厂(创建型模式) 常见的对象创建方法: //创建一个Road对象 Road road=new Road(); new的问题: -实现依赖 ...

- Hacker News排名算法工作原理

这篇文章我要向大家介绍Hacker News网站的文章排名算法工作原理,以及如何在自己的应用里使用这种算法,这个算法非常简单,但却在突出热门文章和遴选新文章上表现的非常优秀.本质上,这段Hacker ...