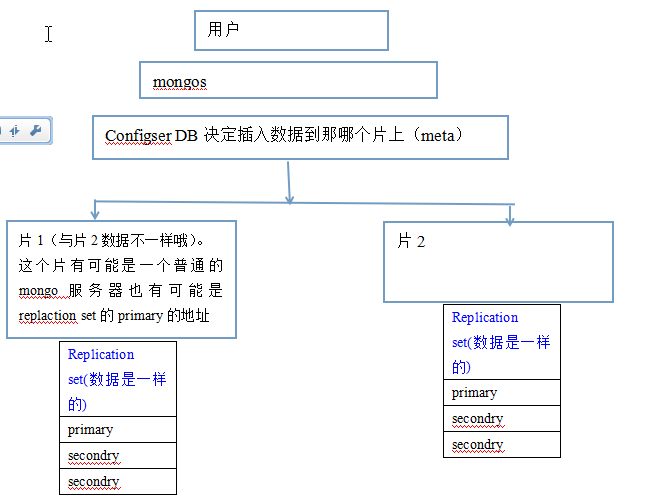

mongo13----application set与分片结合

replation set配合分片 打开3台服务器,B服务器(202)放configserv, C,D服务器(203.204)放置复制集 192.168.1.203和192.168.1.204分别运行之前的sh start.sh(要把ip和rs的名字改了),那么就在这2个ip上搭建了一个replation set.

192.168.1.203>192.168.1.204> sh start.sh reset

192.168.1.203>192.168.1.204> sh start.sh install //复制集创建完毕(2个片创建完毕)

192.168.1.203>192.168.1.204> sh start.sh repl //接下来202 ip创建mongos和configsrv,

192.168.1.202> sh start.sh reset //清理初始化

192.168.1.202> mkdir -p /home/m20 /home/mlog //初始化configsrv(一般也是分在不同的服务器上,防止down掉)

192.168.1.202> /usr/local/mongodb/bin/mongod --dbpath /home/m20/ --logpath /home/mlog/m20.log --port 27020 --fork --configsvr //27020端口

//初始化mongos

192.168.1.202> /usr/local/mongodb/bin/mongos --logpath /data/mlog/r30.log --port 30000 --configdb 192.168.202:27020 --fork //端口是30000,configser是192.168.202:27020,mongos和configsvr连在了一起 ps aux | grep momgo //连接30000(最好用ip连接,不要只输入端口)

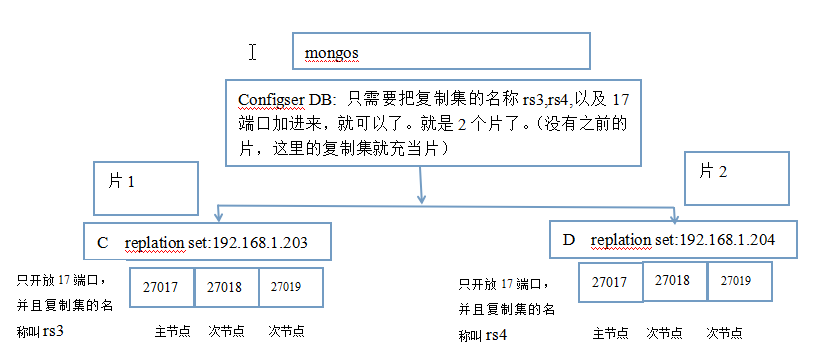

192.168.1.202> ./bin/mongo 192.168.1.202:30000 //添加repl set为片,现在3者都连接到一起了,

192.168.1.202> sh.addShard('rs3/192.168.1.203:27017') //17端口的复制集加进去

192.168.1.202> sh.addShard('rs4/192.168.1.204:27018') //18端口的复制集加进去 192.168.1.202> sh.status(); //看到建立好了 192.168.1.202> sh.enableSharding('shop'); //shop库是要分片的

192.168.1.202> sh.shardCollection('shop.user',{id:1}); //shop库的user表,用id来做片键,分到哪个片上, //手动分片,id遇到1000的整数倍就拆一下

192.168.1.202> sh.splitAt('shop.user',{id:1000}) //1000拆一下

192.168.1.202> sh.splitAt('shop.user',{id:2000}) //2000拆一下

192.168.1.202> sh.splitAt('shop.user',{id:3000}) //3000拆一下,多的话可以写一个for循环。 192.168.1.202> sh.status() 192.168.1.202> use shop

192.168.1.202> for(var i=1;i<=4000;i++) {//一共4000条

db.user.insert({userid:i,name:"kitty"})

} //现在03,04是片,并且还在复制集有2个拷贝。1---2000在203,2000----4000在204上 192.168.1.203> ./bin/mongo

192.168.1.203> use shop

192.168.1.203> show tables //自动创建了库和表

192.168.1.203> db.user.find().count() //2001条

192.168.1.203> db.user.find().skip(1980) 192.168.1.203> ./bin/mongo --port 27018 //片上的secondary次节点

192.168.1.203> use shop

192.168.1.203> rs.slaveok() //不然不能看

192.168.1.203> db.user.find().count() //2001条

192.168.1.203> db.user.find().skip(1980) //完全一样了 192.168.1.204> ./bin/mongo

192.168.1.204> use shop

192.168.1.204> show tables //自动创建了库和表

192.168.1.204> db.user.find().count() //1999条

192.168.1.204> db.user.find().skip(1980) 192.168.1.204> ./bin/mongo --port 27018 //片上的secondary次节点

192.168.1.204> use shop

192.168.1.204> rs.slaveok() //不然不能看

192.168.1.204> db.user.find().count() //2001条

192.168.1.204> db.user.find().skip(1980) //完全一样了 start.sh文件:

#!/bin/bash

IP='192.168.1.202'

NA='rsb' if [ "$1" = "reset" ]

then

pkill -9 mongo

rm -rf /home/m*

exit

fi if [ "$1" = "install" ]

then mkdir -p /home/m0 /home/m1 /home/m2 /home/mlog /usr/local/mongodb/bin/mongod --dbpath /home/m0 --logpath /home/mlog/m17.log --logappend --port 27017 --fork

--replSet ${NA}

/usr/local/mongodb/bin/mongod --dbpath /home/m1 --logpath /home/mlog/m18.log --logappend --port 27018 --fork

--replSet ${NA}

/usr/local/mongodb/bin/mongod --dbpath /home/m2 --logpath /home/mlog/m19.log --logappend --port 27019 --fork

--replSet ${NA} exit

fi if [ "$1" = "repl" ]

then

/usr/local/mongodb/bin/mongo <<EOF use admin

rsconf = {

_id:'${NA}',

members:[

{_id:0,host:'${IP}:27017'},

{_id:1,host:'${IP}:27018'},

{_id:2,host:'${IP}:27019'},

]

}

rs.initiate(rsconf)

EOF

fi

mongo13----application set与分片结合的更多相关文章

- websocket protocal

same-orgins:浏览器同源策略的安全模型 持久化协议 双向双工 多路复用, 同时发信息 区别HTTP连接特点: http只能由客户端发起,一个request对应一个respon ...

- Flink架构(一)- 系统架构

1. 系统架构 Flink是一个分布式系统,用于有状态的并行数据流处理.也就是说,Flink会分布式地运行在多个机器上.在分布式系统中,常见的挑战有:如何对集群中的资源进行分配与管理.协调进程.数据存 ...

- MongoDB 分片管理

在MongoDB(版本 3.2.9)中,分片集群(sharded cluster)是一种水平扩展数据库系统性能的方法,能够将数据集分布式存储在不同的分片(shard)上,每个分片只保存数据集的一部分, ...

- MongoDB 搭建分片集群

在MongoDB(版本 3.2.9)中,分片是指将collection分散存储到不同的Server中,每个Server只存储collection的一部分,服务分片的所有服务器组成分片集群.分片集群(S ...

- MyCat 安装部署,实现数据库分片存储

一.安装MySQL或MariaDB(本文以MariaDB为例) MySQL手动安装方法:点击查看 MariaDB安装: 1.下载MariaDB的repo $ vi /etc/yum.repos.d/M ...

- spring boot application.properties 属性详解

2019年3月21日17:09:59 英文原版: https://docs.spring.io/spring-boot/docs/current/reference/html/common-appli ...

- Hadoop InputFormat 输入文件分片

1. Mapper 与 Reducer 数量 对于一个默认的MapReduce Job 来说,map任务的数量等于输入文件被划分成的分块数,这个取决于输入文件的大小以及文件块的大小(如果此文件在 HD ...

- webuploader分片上传

屁话不多说直接上主题; webuploader,sj(WebUploader 0.1.6)网上有下 powerUpload.js 自己写的基与楼上的插件 asp.net mvc/Api 实现效果: H ...

- Akka-Cluster(6)- Cluster-Sharding:集群分片,分布式交互程序核心方式

在前面几篇讨论里我们介绍了在集群环境里的一些编程模式.分布式数据结构及具体实现方式.到目前为止,我们已经实现了把程序任务分配给处于很多服务器上的actor,能够最大程度的利用整体系统的硬件资源.这是因 ...

- LwIP Application Developers Manual1---介绍

1.前言 本文主要是对LwIP Application Developers Manual的翻译 2.读者(应用开发手册的读者) 谁适合读这份手册 网络应用的开发者 想了解lwIP的网络应用开发者 阅 ...

随机推荐

- 【POJ 1061】青蛙的约会(EXGCD)

Description 两只青蛙在网上相识了,它们聊得很开心,于是觉得很有必要见一面.它们很高兴地发现它们住在同一条纬度线上,于是它们约定各自朝西跳,直到碰面为止.可是它们出发之前忘记了一件很重要的事 ...

- LA 4064 (计数 极角排序) Magnetic Train Tracks

这个题和UVa11529很相似. 枚举一个中心点,然后按极角排序,统计以这个点为钝角的三角形的个数,然后用C(n, 3)减去就是答案. 另外遇到直角三角形的情况很是蛋疼,可以用一个eps,不嫌麻烦的话 ...

- php基础 数组 遍历

//参数默认值// function abc($a,$b,$c=0){// echo $a,$b,$c;// }// abc(1,3); //可变参数//function def(){// $arr= ...

- springcloud了解

学习springcloud 文章标题:[置顶] 史上最简单的 SpringCloud 教程 | 终章 学习地址:http://blog.csdn.net/forezp/article/details/ ...

- The 16th Zhejiang University Programming Contest-

Handshakes Time Limit: 2 Seconds Memory Limit: 65536 KB Last week, n students participated in t ...

- _063_Android_Android内存泄露

深入内存泄露 Android应用的内存泄露,其实就是java虚拟机的堆内存泄漏. 当然,当应用有ndk,jni时,没有及时free,本地堆也会出现内存泄漏. 本文只是针对JVM内存泄漏应用,进行阐述分 ...

- hdu3516 Tree Construction (四边形不等式)

题意:给定一些点(xi,yi)(xj,yj)满足:i<j,xi<xj,yi>yj.用下面的连起来,使得所有边的长度最小? 题解:直接给出吧 f[i][j]=min(f[i][k]+f ...

- [NOIP2002] 提高组 洛谷P1031 均分纸牌

题目描述 有 N 堆纸牌,编号分别为 1,2,…, N.每堆上有若干张,但纸牌总数必为 N 的倍数.可以在任一堆上取若于张纸牌,然后移动. 移牌规则为:在编号为 1 堆上取的纸牌,只能移到编号为 2 ...

- bitset初始化问题

在C++primer上面说,bitset可以用unsigned long来进行初始化,但是上面的例子只是采用了常数如0xffff,而在实际中,当在vs2010中,我采用unsigned long类型的 ...

- 组队训练2 回放(转载至cxhscst2's blog)

2017/3/4 12:00-17:00 Solve 9 / 13 Penalty 717 练习赛过程回放: 开场5分中J题签到(cst) 12分钟时qw签到A 这时qw继续开写M,WA,检查代码. ...