【python实现卷积神经网络】池化层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch

卷积神经网络中卷积层Conv2D(带stride、padding)的具体实现:https://www.cnblogs.com/xiximayou/p/12706576.html

激活函数的实现(sigmoid、softmax、tanh、relu、leakyrelu、elu、selu、softplus):https://www.cnblogs.com/xiximayou/p/12713081.html

损失函数定义(均方误差、交叉熵损失):https://www.cnblogs.com/xiximayou/p/12713198.html

优化器的实现(SGD、Nesterov、Adagrad、Adadelta、RMSprop、Adam):https://www.cnblogs.com/xiximayou/p/12713594.html

卷积层反向传播过程:https://www.cnblogs.com/xiximayou/p/12713930.html

全连接层实现:https://www.cnblogs.com/xiximayou/p/12720017.html

批量归一化层实现:https://www.cnblogs.com/xiximayou/p/12720211.html

包括D的平均池化和最大池化:

class PoolingLayer(Layer):

"""A parent class of MaxPooling2D and AveragePooling2D

"""

def __init__(self, pool_shape=(2, 2), stride=1, padding=0):

self.pool_shape = pool_shape

self.stride = stride

self.padding = padding

self.trainable = True def forward_pass(self, X, training=True):

self.layer_input = X batch_size, channels, height, width = X.shape _, out_height, out_width = self.output_shape() X = X.reshape(batch_size*channels, 1, height, width)

X_col = image_to_column(X, self.pool_shape, self.stride, self.padding) # MaxPool or AveragePool specific method

output = self._pool_forward(X_col) output = output.reshape(out_height, out_width, batch_size, channels)

output = output.transpose(2, 3, 0, 1) return output def backward_pass(self, accum_grad):

batch_size, _, _, _ = accum_grad.shape

channels, height, width = self.input_shape

accum_grad = accum_grad.transpose(2, 3, 0, 1).ravel() # MaxPool or AveragePool specific method

accum_grad_col = self._pool_backward(accum_grad) accum_grad = column_to_image(accum_grad_col, (batch_size * channels, 1, height, width), self.pool_shape, self.stride, 0)

accum_grad = accum_grad.reshape((batch_size,) + self.input_shape) return accum_grad def output_shape(self):

channels, height, width = self.input_shape

out_height = (height - self.pool_shape[0]) / self.stride + 1

out_width = (width - self.pool_shape[1]) / self.stride + 1

assert out_height % 1 == 0

assert out_width % 1 == 0

return channels, int(out_height), int(out_width) class MaxPooling2D(PoolingLayer):

def _pool_forward(self, X_col):

arg_max = np.argmax(X_col, axis=0).flatten()

output = X_col[arg_max, range(arg_max.size)]

self.cache = arg_max

return output def _pool_backward(self, accum_grad):

accum_grad_col = np.zeros((np.prod(self.pool_shape), accum_grad.size))

arg_max = self.cache

accum_grad_col[arg_max, range(accum_grad.size)] = accum_grad

return accum_grad_col class AveragePooling2D(PoolingLayer):

def _pool_forward(self, X_col):

output = np.mean(X_col, axis=0)

return output def _pool_backward(self, accum_grad):

accum_grad_col = np.zeros((np.prod(self.pool_shape), accum_grad.size))

accum_grad_col[:, range(accum_grad.size)] = 1. / accum_grad_col.shape[0] * accum_grad

return accum_grad_col

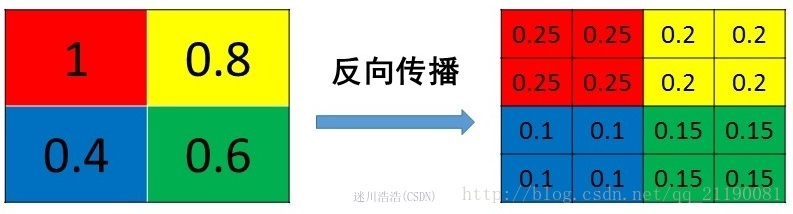

需要注意的是池化层是没有可学习的参数的(如果不利用带步长的卷积来代替池化的作用),还有就是池化层反向传播的过程,这里参考:https://blog.csdn.net/Jason_yyz/article/details/80003271

为了结合代码看直观些,就将其内容摘了下来:

【python实现卷积神经网络】池化层实现的更多相关文章

- tensorflow的卷积和池化层(二):记实践之cifar10

在tensorflow中的卷积和池化层(一)和各种卷积类型Convolution这两篇博客中,主要讲解了卷积神经网络的核心层,同时也结合当下流行的Caffe和tf框架做了介绍,本篇博客将接着tenso ...

- tensorflow中的卷积和池化层(一)

在官方tutorial的帮助下,我们已经使用了最简单的CNN用于Mnist的问题,而其实在这个过程中,主要的问题在于如何设置CNN网络,这和Caffe等框架的原理是一样的,但是tf的设置似乎更加简洁. ...

- 【python实现卷积神经网络】padding2D层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】Flatten层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】Dropout层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】激活层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 基于深度学习和迁移学习的识花实践——利用 VGG16 的深度网络结构中的五轮卷积网络层和池化层,对每张图片得到一个 4096 维的特征向量,然后我们直接用这个特征向量替代原来的图片,再加若干层全连接的神经网络,对花朵数据集进行训练(属于模型迁移)

基于深度学习和迁移学习的识花实践(转) 深度学习是人工智能领域近年来最火热的话题之一,但是对于个人来说,以往想要玩转深度学习除了要具备高超的编程技巧,还需要有海量的数据和强劲的硬件.不过 Tens ...

- tensorflow CNN 卷积神经网络中的卷积层和池化层的代码和效果图

tensorflow CNN 卷积神经网络中的卷积层和池化层的代码和效果图 因为很多 demo 都比较复杂,专门抽出这两个函数,写的 demo. 更多教程:http://www.tensorflown ...

- Python3 卷积神经网络卷积层,池化层,全连接层前馈实现

# -*- coding: utf-8 -*- """ Created on Sun Mar 4 09:21:41 2018 @author: markli " ...

随机推荐

- 暴力+辗转相除法——N个数求和

题目来源 PTA 团体程序设计天梯赛-练习集 L1-009 N个数求和 (20分) https://pintia.cn/problem-sets/994805046380707840/problems ...

- mvc5+ET6入门第一章

这一篇主要讲的是MVC也就是Model--View--Controller的缩写,没有讲ET.其中 Model(模型)表示应用程序核心(比如数据库记录列表).通常模型对象在数据库中存取数据. View ...

- 为什么Mysql的常用引擎都默认使用B+树作为索引?

一.前言 为了讲清楚这个问题,我们要先了解什么是索引. 我记得刚刚学习数据库的时候,老师喜欢用书本的目录来类比数据库的索引,并告诉我们索引能够像目录一样,让我们更快地找到想要找到的数据. 如果是第一次 ...

- angular自启动过程

angularJS的源代码整体上来说是一个自执行函数,在angularJS加载完成后,就会自动执行了. 即,在window上暴露一个唯一的全局对象angular, 如果window.angular已经 ...

- [UWP]使用AlphaMaskEffect提升故障艺术动画的性能(顺便介绍怎么使用性能探测器分析UWP程序)

前几天发布了抄抄<CSS 故障艺术>的动画这篇文章,在这篇文章里介绍了如何使用Win2D绘制文字然后配合BlendEffect制作故障艺术的动画.本来打算就这样收手不玩这个动画了,但后来又 ...

- msys2 mingw64安装

(1)安装msys2 (2)更新\etc\pacman.d\下的源文件 mirrorlist.msys Server = http://repo.msys2.org/msys/$arch/ Serve ...

- YII2自动初始化脚本

#!/usr/bin/expect spawn ./init expect "Which environment do you want the application to be init ...

- iOS UmbrellaHeader

Lexical or Preprocessor Issue - Umbrella header for module 'xxx' does not include header 'xxx.h' fra ...

- 深入理解NIO(三)—— NIO原理及部分源码的解析

深入理解NIO(三)—— NIO原理及部分源码的解析 欢迎回到淦™的源码看爆系列 在看完前面两个系列之后,相信大家对NIO也有了一定的理解,接下来我们就来深入源码去解读它,我这里的是OpenJDK-8 ...

- Django-on_delete

一.外键的删除 关于on_delete的总结 1.常见的使用方式(设置为null) class BookModel(models.Model): """ 书籍表 &quo ...