python爬虫实战之爬取智联职位信息和博客文章信息

1.python爬取招聘信息

简单爬取智联招聘职位信息

# !/usr/bin/env python

# -*-coding:utf-8-*-

"""

@Author : xiaofeng

@Time : 2018/12/18 16:31

@Desc : Less interests,More interest. (爬取智联招聘职位数据)

@Project : python_appliction

@FileName: zhilianzhaopin.py

@Software: PyCharm

@Blog :https://blog.csdn.net/zwx19921215

""" import pymysql as db

import requests # mysql配置信息

mysql_config = {

'host': '101.0.2.110',

'user': 'test',

'password': 'test',

'database': 'xiaofeng',

'charset': 'utf8'

} # url

url = 'https://data.highpin.cn/api/JobSearch/Search' """

爬取智联招聘职位数据

@:param page 页码

@:param position 职位关键字

""" def zhilian(page, position):

# 封装头信息

headers = {

'Referer': 'https://www.highpin.cn/zhiwei/',

'Origin': 'https://www.highpin.cn',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Accept': 'application/json, text/javascript, * / *; q=0.01',

}

# 表单信息

datas = {

'Q': position,

'pageIndex': page

}

resp = requests.post(url, data=datas, headers=headers)

result = resp.json()

return result """

控制台输出

""" def print_data(result):

body = result['body']['JobList']

print(body) """

数据入库

""" def insert(result):

print("insert......")

database = db.connect(**mysql_config)

for item in result:

print(item)

sql = "INSERT INTO zhilian(JobID,JobTitle,ReferrerType,CompanyName,AnnualSalaryMin," \

"AnnualSalaryMax,JobLactionStr,JobLactionID,JobTags\

,JobDegree,JobDegreeId,WorkExperience,WorkExperienceID,CompanyIndustry,CompanyIndustryID," \

"CompanyType,CompanyTypeID,PublishDate,CompanyScale,SalaryWhite) \

VALUES (%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s,%s)" # list convert to str

JobLactionID = str(item['JobLactionID'])

CompanyIndustryID = str(item['CompanyIndustryID']) if 'JobTags' in item:

JobTags = str(item['JobTags'])

else:

JobTags = ''

cursor = database.cursor()

cursor.execute(sql, (

item['JobID'], item['JobTitle'], item['ReferrerType'], item['CompanyName'], item['AnnualSalaryMin'],

item['AnnualSalaryMax'],

item['JobLactionStr'], JobLactionID, JobTags, item['JobDegree'], item['JobDegreeId'],

item['WorkExperience'],

item['WorkExperienceID'], item['CompanyIndustry'], CompanyIndustryID, item['CompanyType'],

item['CompanyTypeID'], item['PublishDate'], item['CompanyScale'], item['SalaryWhite']))

database.commit()

cursor.close()

database.close() def main(position):

result = zhilian(1, position)

page_count = result['body']['PageCount']

print("---------------共", page_count, "页-------------")

page = 1

while page <= page_count:

print('----------------第', page, '页-----------------')

result = zhilian(page, position)

# print_data(result)

body = result['body']['JobList']

insert(body)

page = page + 1 if __name__ == '__main__':

main('java')

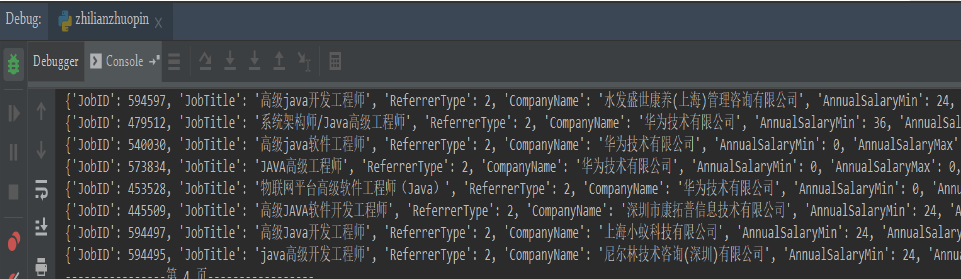

控制台输出信息

入库数据

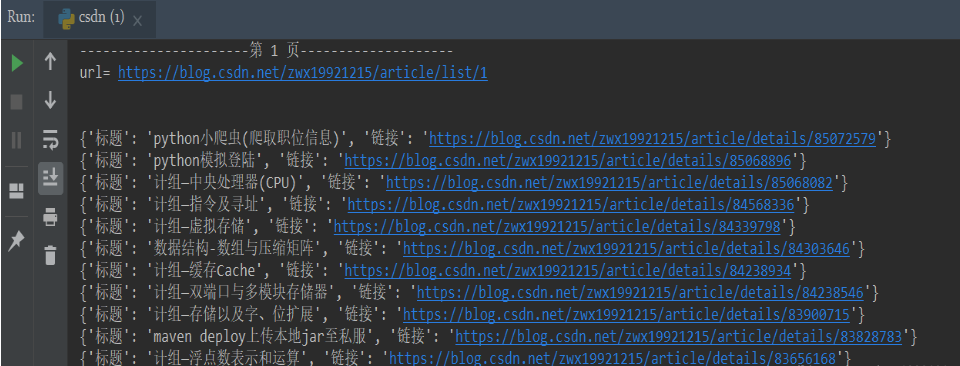

2.python爬取csdn博客文章

python简单爬取csdn博客文章列表(仅供学习)

步骤:

1.分页获取博客url

2.解析html 获取指定信息

# !/usr/bin/env python

# -*-coding:utf-8-*-

"""

@Author : xiaofeng

@Time : 2018/12/20 11:30

@Desc : Less interests,More interest.(爬取csdn博客文章列表)

@Project : python_appliction

@FileName: csdn.py

@Software: PyCharm

@Blog :https://blog.csdn.net/zwx19921215

"""

import requests

from lxml import html # 声明头信息

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36 SE 2.X MetaSr 1.0'

} """

解析html,获取相关数据

@:param url 网页路径

""" def parse_html(url):

response = requests.get(url=url, headers=headers)

text = html.fromstring(response.text)

hrefs = text.xpath('//h4/a/@href')

title = text.xpath('//h4/a/text()')

"""

文章摘要、发布日期、阅读数、评论数等其余属性自行按需获取即可

"""

# 移出第一个元素链接,不知道为啥 csdn 博客默认都多了一条数据,也就多了一个链接

hrefs.pop(0)

titles = []

# 格式化标题

for item in title:

st = str(item).replace('\n', '').strip()

if st != '':

titles.append(st) # 组合输出

# 移出第一个元素,不知道为啥 csdn 博客默认都多了一条数据 “帝都的凛冬”

titles.pop(0)

i = 0

for item in titles:

results = {

'标题': titles[i],

'链接': hrefs[i]

}

i = i + 1

print(results) """

自动判断页数

@:param page_url 页面路径

@:param page 页号

""" def get_page(page_url, page):

url = page_url + str(page)

print('url=', url)

response = requests.get(url=url, headers=headers)

text = html.fromstring(response.text)

next_page = text.xpath(

'//div[@class="ui-paging-container"]/ul/li[@class="js-page-next js-page-action ui-pager"]/text()')

if next_page:

parse_html(url)

page = page + 1

get_page(page_url, page)

else:

return -1 """

分页爬取相关数据

@:param page_url 页面路径

@:param page 页号

""" def get_page2(page_url, page):

url = page_url + str(page)

while page <= 10:

print('\n')

print("----------------------第", page, "页--------------------")

print('url=', url)

print('\n')

parse_html(url)

page = page + 1

url = page_url + str(page) if __name__ == '__main__':

page_url = 'https://blog.csdn.net/zwx19921215/article/list/'

get_page2(page_url, 1)

希望能帮到你们,最后分享一些小福利

链接:https://pan.baidu.com/s/1sMxwTn7P2lhvzvWRwBjFrQ

提取码:kt2v

链接容易被举报过期,如果失效了就在这里领取吧

python爬虫实战之爬取智联职位信息和博客文章信息的更多相关文章

- Python爬虫实战之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 本篇目标 对百度贴吧的任意帖子进行抓取 指定是否只抓取楼主发帖 ...

- python爬虫实战(五)--------智联招聘网

前些天帮同事爬取一些智联招聘网上的关于数据分析的职位信息,他说要做一些数据分析看看,现在已经帮他爬完了.我本来想用Scrapy来爬的,但是不知道为什么爬取的数据和真实搜到的数据不太一样,比如:搜索到的 ...

- Python爬虫实战:爬取腾讯视频的评论

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: 易某某 PS:如有需要Python学习资料的小伙伴可以加点击下方链 ...

- Python爬虫实战之爬取糗事百科段子

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

- Python爬虫实战之爬取糗事百科段子【华为云技术分享】

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

- 芝麻HTTP:Python爬虫实战之爬取糗事百科段子

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

- python 爬虫实战1 爬取糗事百科段子

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 本篇目标 抓取糗事百科热门段子 过滤带有图片的段子 实现每按一次回车显示一个段子的发布时间,发布人 ...

- python 爬虫实战4 爬取淘宝MM照片

本篇目标 抓取淘宝MM的姓名,头像,年龄 抓取每一个MM的资料简介以及写真图片 把每一个MM的写真图片按照文件夹保存到本地 熟悉文件保存的过程 1.URL的格式 在这里我们用到的URL是 http:/ ...

- 原创:Python爬虫实战之爬取美女照片

这个素材是出自小甲鱼的python教程,但源码全部是我原创的,所以,猥琐的不是我 注:没有用header(总会报错),暂时不会正则表达式(马上要学了),以下代码可能些许混乱,不过效果还是可以的. 爬虫 ...

随机推荐

- POI2014 FAR-FarmCraft 树形DP+贪心

题目链接 https://www.luogu.org/problem/P3574 题意 翻译其实已经很明确了 分析 这题一眼就是贪心啊,但贪心的方法要思索一下,首先是考虑先走时间多的子树,但不太现实, ...

- what the fuck!(二分查找 / 暴力模拟)

what the fuck! Description 现在有一家公司有nnn个员工(nnn为奇数),他们的工资发放是基本工资+提成,现在这家公司计划再招一批人.要写一篇招聘启事,但是对于这个招聘启事中 ...

- P3381 【模板】最小费用最大流(MCMF)

P3381 [模板]最小费用最大流 题目描述 如题,给出一个网络图,以及其源点和汇点,每条边已知其最大流量和单位流量费用,求出其网络最大流和在最大流情况下的最小费用. 输入格式 第一行包含四个正整数N ...

- STM32F103ZET6通用定时器的输入捕获

1.通用定时器输入捕获功能简介 通用定时器的输入捕获模式可以用来测量脉冲宽度或者测量频率. STM32的每个通用定时器都有4个输入捕获的通道,分别是TIMx_CH1.TIMx_CH2.TIMx_CH3 ...

- 拿万元月薪必备的书单,学JAVA的程序员必看的5本书!

点击蓝色"程序员黄小斜"关注我哟 加个"星标",每天带你读好书! 文/黄小斜 转载请注明出处 每一年的年初都是买书学习热情高涨的时候,虽然不知道你们是让这些书吃 ...

- Please enter a commit message to explain why this merge is necessary, # especially if it merges an updated upstream into a topic branch. # # Lines starting with '#' will be ignored, and an empty messa

1.git提交的时候遇到: # Please enter the commit message for your changes. Lines starting with '#' will be ig ...

- 搭建DVWA Web渗透测试靶场

文章更新于:2020-04-13 按照惯例,需要的文件附上链接放在文首. 文件名:DVWA-1.9-2020.zip 文件大小:1.3 M 文件说明:这个是新版 v1.9 (其实是 v1.10开发版) ...

- 虚拟机的vmnet8网卡找不到了

不知道我设置了什么,在我于Linux中配置网络时发现怎么都不行,检查了一下发现用于NAT的网卡没有了. 我重启了电脑之后发现还是没有. 于是按照网上的办法在虚拟网络编辑器将其重置,如下图. 问题解决. ...

- MathJax的基本使用

MathJax是一个开放源代码的JavaScript显示引擎,适用于所有现代浏览器中的LaTeX.MathML和AsciMath表示法. MathJax官网为 https://www.mathjax. ...

- k8s~helm镜像版本永远不要用latest

对于容器编排工具k8s来说,你可以使用它规定的yaml格式的脚本,使用客户端kubectl来与k8s进行通讯,将你定义好的yaml部署脚本应用到k8s集群上,而这对yaml脚本一般来说都是很像的,就是 ...