python爬虫之12306网站--车站信息查询

python爬虫查询车站信息

目录:

1.找到要查询的url

2.对信息进行分析

3.对信息进行处理

python爬虫查询全拼相同的车站

目录:

1.找到要查询的url

2.对信息进行分析

3.对信息进行处理

1.找到车站信息的url

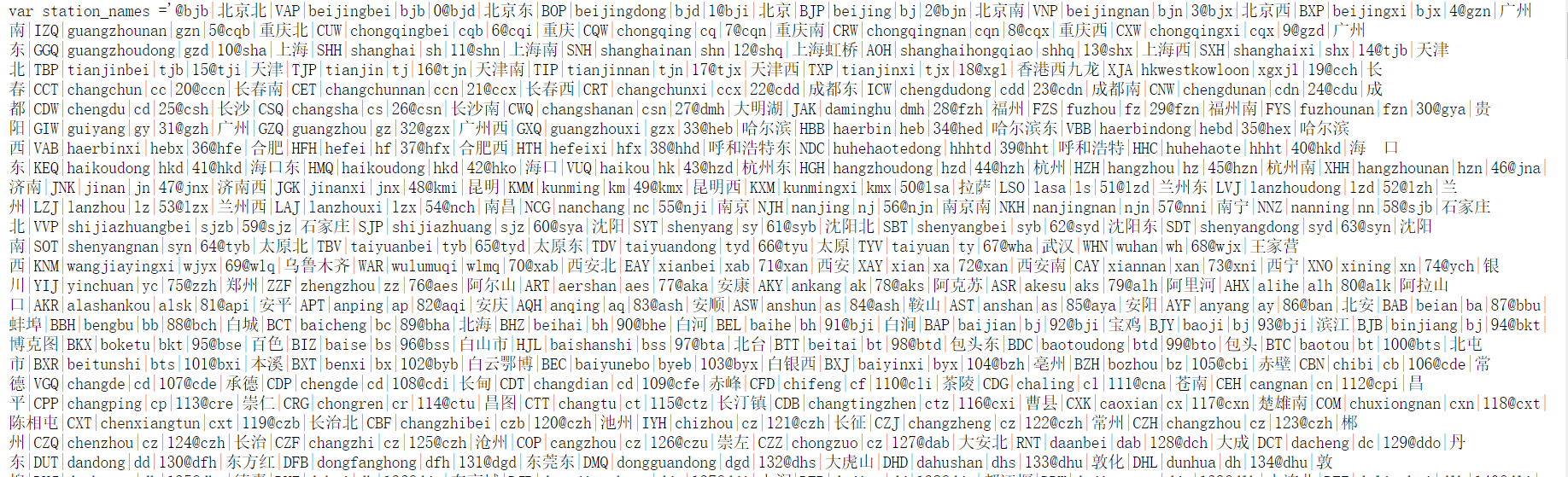

2.分析车站信息,发现每个车站信息以"@"分隔

车站信息查询

#车站信息查询

import requests

#1.获得url(存取车站信息的url)并读取,根据获得信息的特点去掉无用的信息并转换存储到列表中

url="https://kyfw.12306.cn/otn/resources/js/framework/station_name.js?station_version=1.9090"

txt=requests.get(url).text

#print(txt)

inf=txt[:-2].split("@")[1:] #得到的是存储所有车站信息的列表

#print(inf)

#2.通过循环把列表在进行分割转换成新的列表,取其中一项(车站顺序编号)当做字典的key,其余当作值,存储到新的字典中

stations={}

for record in inf:

rlist=record.split("|")

stations[int(rlist[-1])]={"cname":rlist[1],"id":rlist[2],"qp":rlist[3],"jx":rlist[4]} #print(stations[0])

#print(stations.get(2848))

#print(stations.values())

#3.判断查询条件是否存在,存在如果唯一则打印并跳出循环,不唯一则显示查询的所有的结果,提供选择,根据选择的信息打印出结果然后跳出循环,不存在则打印提示信息,重新输出

while True:

s1=input("出发站:")

flag=0

result=[]

for station in stations.values():

if s1 in station.values():

#print(station)

result.append(station)

flag=1

if flag:

break

else:

print("没有这个车站!")

print("请重新输入!")

if len(result)==1:

resultId=result[0]["id"]

print("你输入的出发车站是%s,对应的车站ID是%s"%(result[0]["cname"],resultId))

else:

print("你输入的条件比较模糊,请在以下站中进行选择:")

for i in range(len(result)):

print(i+1,result[i]["cname"],result[i]["id"])

sel=int(input("你的选择:"))-1

resultId=result[sel]["id"]

print("你输入的出发车站是%s,对应的车站ID是%s"%(result[sel]["cname"],resultId))

while True:

s2=input("目的站:")

flag2=0

result2=[]

for station in stations.values():

if s2 in station.values():

#print(station)

result2.append(station)

flag2=1

if flag2:

break

else:

print("没有这个车站!")

print("请重新输入!")

if len(result2)==1:

result2Id=result2[0]["id"]

print("你输入的目的车站是%s,对应的车站ID是%s"%(result2[0]["cname"],result2Id))

else:

print("你输入的条件比较模糊,请在以下站中进行选择:")

for i in range(len(result2)):

print(i+1,result2[i]["cname"],result2[i]["id"])

sel2=int(input("你的选择:"))-1

result2Id=result2[sel2]["id"]

print("你输入的目的车站是%s,对应的车站ID是%s"%(result2[sel]["cname"],result2Id))

#生成一条带查询的url(url在浏览器开发者模式查找)

qurl="https://kyfw.12306.cn/otn/leftTicket/queryZ?leftTicketDTO.train_date=2019-01-14&leftTicketDTO.from_station=%s&leftTicketDTO.to_station=%s&purpose_codes=ADULT"

print(qurl %(resultId,result2Id))

运行效果如下:

2.查询出所有全拼相同的所有车站名称

#python 查询出所有全拼相同的所有车站名称

import requests

url="https://kyfw.12306.cn/otn/resources/js/framework/station_name.js?station_version=1.9090"

txt=requests.get(url).text

inf=txt[:-2].split("@")[1:]

stations={}

for record in inf:

rlist=record.split("|")

stations[int(rlist[-1])]={"cname":rlist[1],"id":rlist[2],"qp":rlist[3],"jx":rlist[4]} pyin=[]

for station in stations.values(): #把获得的信息所有的"qp"所对应的值全部放到列表中(pyin)

pyin.append(station["qp"])

npy=list(set(pyin)) #利用集合的去重特性对列表进行去掉重复项

npy.sort() #对列表进行排序

c={}

for station in stations.values(): #分别把所有的全拼当作键,值加入到新的字典当中

c[station["qp"]]=c.get(station["qp"],0)+1

#print(c)

c2=[]

for k,v in c.items(): #判断字典的值是否大于1,大于则说明存在全拼相同的车站名

if v>1:

c2.append(k) #把满足条件的所有的全拼加入到新的列表中

c2.sort()

#print(c2)

for p in c2: #遍历列表,打印出符合条件的车站

print(p,end=":")

for station in stations.values():

if p==station["qp"]:

print(station["cname"])

运行效果如下:

python爬虫之12306网站--车站信息查询的更多相关文章

- python爬虫之12306网站--火车票信息查询

python爬虫之12306网站--火车票信息查询 思路: 1.火车票信息查询是基于车站信息查询,先完成车站信息查询,然后根据车站信息查询生成的url地址去查询当前已知出发站和目的站的所有车次车票信息 ...

- python爬虫之天气预报网站--查看最近(15天)的天气信息(正则表达式)

python爬虫之天气预报网站--查看最近(15天)的天气信息(正则表达式) 思路: 1.首先找到一个自己想要查看天气预报的网站,选择自己想查看的地方,查看天气(例:http://www.tianqi ...

- python+splinter实现12306网站刷票并自动购票流程

python+splinter实现12306网站刷票并自动购票流程 通过python+splinter,实现在12306网站刷票并自动购票流程(无法自动识别验证码). 此类程序只是提高了12306网站 ...

- python爬虫抓取哈尔滨天气信息(静态爬虫)

python 爬虫 爬取哈尔滨天气信息 - http://www.weather.com.cn/weather/101050101.shtml 环境: windows7 python3.4(pip i ...

- python爬虫之小说网站--下载小说(正则表达式)

python爬虫之小说网站--下载小说(正则表达式) 思路: 1.找到要下载的小说首页,打开网页源代码进行分析(例:https://www.kanunu8.com/files/old/2011/244 ...

- Python爬虫某招聘网站的岗位信息

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者:阿尔法游戏 PS:如有需要Python学习资料的小伙伴可以加点击下方链 ...

- 简单的python爬虫--爬取Taobao淘女郎信息

最近在学Python的爬虫,顺便就练习了一下爬取淘宝上的淘女郎信息:手法简单,由于淘宝网站本上做了很多的防爬措施,应此效果不太好! 爬虫的入口:https://mm.taobao.com/json/r ...

- python爬虫1——获取网站源代码(豆瓣图书top250信息)

# -*- coding: utf-8 -*- import requests import re import sys reload(sys) sys.setdefaultencoding('utf ...

- python爬虫--模拟12306登录

模拟12306登录 超级鹰: #!/usr/bin/env python # coding:utf-8 import requests from hashlib import md5 class Ch ...

随机推荐

- noteless的博客导航页 所有文章的导航页面

导航 <spring springmvc mybatis maven 项目整合示例系列-导航页> <JAVA 基础知识点拾遗系列 JAVA学习 -1层 导航页> <计 ...

- Python多进程操作同一个文件,文件锁问题

最近工作当中做了一个项目,这个项目主要是操作文件的. 在操作耗时操作的时候,我们一般采用多线程或者多进程.在开发中,如果多个线程需要对文件进行读写操作,就需要用到线程锁或者是文件锁. 使用fcntl ...

- Redis基础认识及常用命令使用(一)--技术流ken

Redis简介 redis是一个key-value存储系统.和Memcached类似,它支持存储的value类型相对更多,包括string(字符串).list(链表).set(集合)和zset(有序集 ...

- 【转载】C#常用数据库Sqlserver通过SQL语句查询数据库以及表的大小

在Sqlserver数据库中,一般我们查看数据库的大小可以通过查找到数据库文件来查看,但如果要查找数据表Table的大小的话,则不可通过此方法,在Sqlserver数据库中,提供了相应的SQL语句来查 ...

- IIS中注册.net4.0

1.开始-运行: 2.运行框中输入 cmd ; 3.输入命令 %windir%\Microsoft.NET\Framework\v4.0.30319\aspnet_regiis.exe -i 4.回车 ...

- Jquery里的特定小技巧

jQuery 动态设置样式: https://blog.csdn.net/xiaoyuncc/article/details/70854925 jquery如 ...

- 8. 同步锁Lock

package com.gf.demo07; import java.util.concurrent.locks.Lock; import java.util.concurrent.locks.Ree ...

- 1:Python开发:初识Python

1.开发语言: 高级语言:Python, Java, PHP ,C# ,Go, ruby, c++ ==>字节码 低级语言:C,汇编 ==>机器码 2.开发语言的对比: PHP类:适用于写 ...

- Javascript动态引用CSS文件的2种方法介绍

最近做一个项目,需要javascript动态插入样式,结果以前的方法失效了!查了2个小时的原因竟然是自己手贱,这个最后再说! javascript插入样式在前端开发中应用比较广泛,特别是在修改前端表现 ...

- nodejs+expressjs+ws实现了websocket即时通讯,服务器和客户端互相通信

nodejs代码 // 导入WebSocket模块: const WebSocket = require('ws'); // 引用Server类: const WebSocketServer = We ...