spark与hive的集成

一:介绍

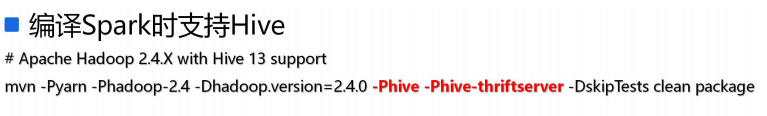

1.在spark编译时支持hive

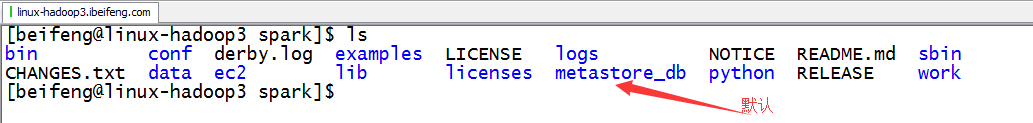

2.默认的db

当Spark在编译的时候给定了hive的支持参数,但是没有配置和hive的集成,此时默认使用hive自带的元数据管理:Derby数据库。

二:具体集成

1.将hive的配合文件hive-site.xml添加到spark应用的classpath中(相当于拷贝)

2.第二步集成

根据hive的配置参数hive.metastore.uris的情况,采用不同的集成方式

分别为(区别):

-1. hive.metastore.uris没有给定配置值,为空(默认情况)

SparkSQL通过hive配置的javax.jdo.option.XXX相关配置值直接连接metastore数据库直接获取hive表元数据

--1.1 需要将连接数据库的驱动添加到Spark应用的classpath中

-2. hive.metastore.uris给定了具体的参数值

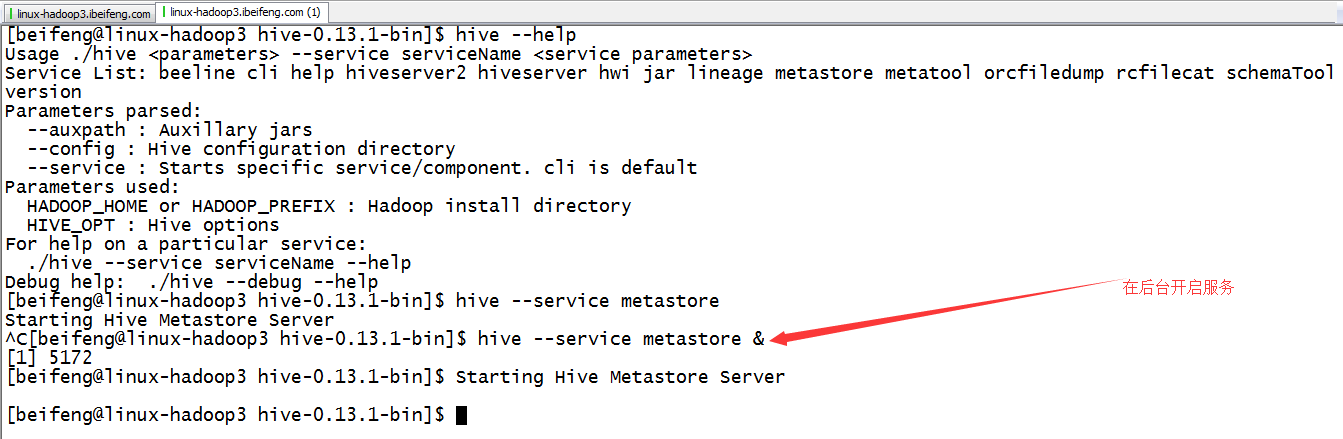

SparkSQL通过连接hive提供的metastore服务来获取hive表的元数据

--2.1 直接启动hive的metastore服务即可完成SparkSQL和Hive的集成

$ hive --service metastore &

3.使用hive-site.xml配置的方式

4.启动hive service metastore服务

三:测试

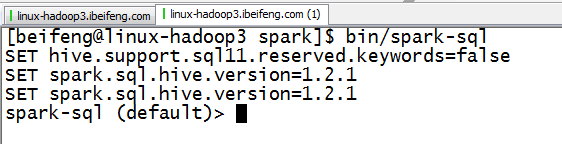

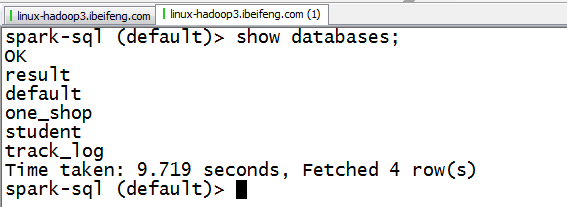

1.spark-sql

2.使用

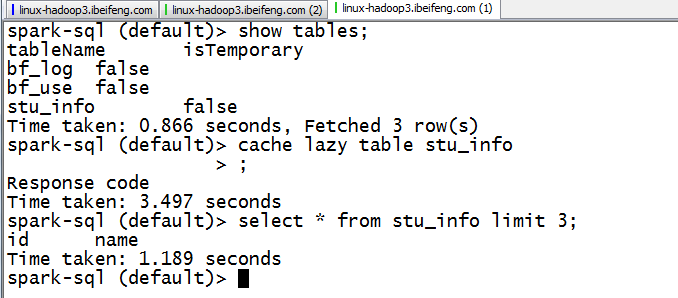

四:特殊点(其他在hive中可以使用的sql,在spark-sql中都可以使用)

1.cache

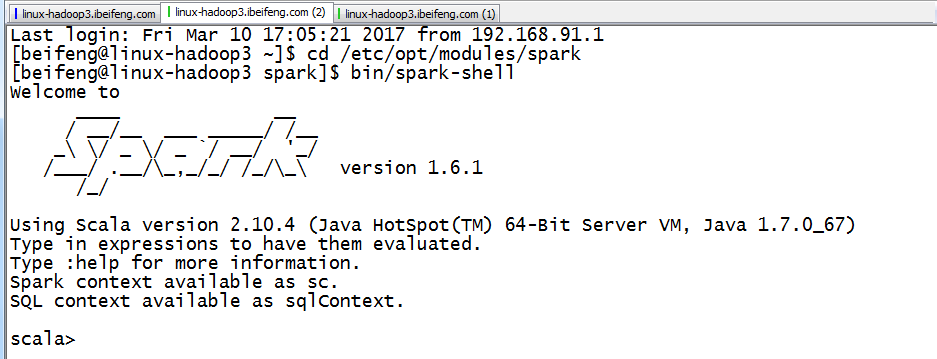

五:使用spark-shell

1.启动

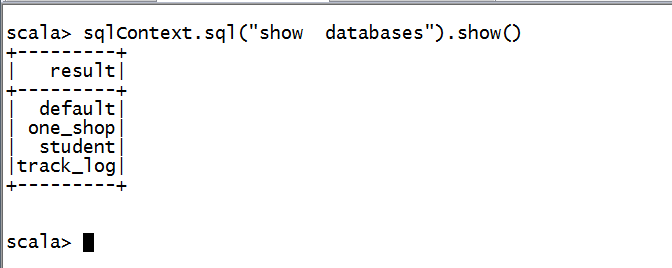

2.使用

六:补充说明:Spark应用程序第三方jar文件依赖解决方案

1. 将第三方jar文件打包到最终形成的spark应用程序jar文件中

这种使用的场景是,第三方的jar包不是很大的情况。

2. 使用spark-submit提交命令的参数: --jars

这个使用的场景:使用spark-submit命令的机器上存在对应的jar文件

至于集群中其他机器上的服务需要该jar文件的时候,通过driver提供的一个http接口来获取该jar文件的(http://192.168.187.146:50206/jars/mysql-connector-java-5.1.27-bin.jar Added By User)

$ bin/spark-shell --jars /opt/cdh-5.3.6/hive/lib/mysql-connector-java-5.1.27-bin.jar

3. 使用spark-submit提交命令的参数: --packages

这个场景是:如果找不到jar会自动下载,也可以自己设定源。

--packages Comma-separated list of maven coordinates of jars to include on the driver and executor classpaths. Will search the local maven repo, then maven central and any additional remote repositories given by --repositories.

The format for the coordinates should be groupId:artifactId:version.

http://mvnrepository.com/artifact/mysql/mysql-connector-java/5.1.27

$ bin/spark-shell --packages mysql:mysql-connector-java:5.1.27 --repositories http://maven.aliyun.com/nexus/content/groups/public/

# 默认下载的包位于当前用户根目录下的.ivy/jars文件夹中

4.更改Spark的配置信息:SPARK_CLASSPATH, 将第三方的jar文件添加到SPARK_CLASSPATH环境变量中

使用场景:要求Spark应用运行的所有机器上必须存在被添加的第三方jar文件

做法:

-4.1 创建一个保存第三方jar文件的文件夹:

$ mkdir external_jars

-4.2 修改Spark配置信息

$ vim conf/spark-env.sh

SPARK_CLASSPATH=$SPARK_CLASSPATH:/opt/cdh-5.3.6/spark/external_jars/*

-4.3 将依赖的jar文件copy到新建的文件夹中

$ cp /opt/cdh-5.3.6/hive/lib/mysql-connector-java-5.1.27-bin.jar ./external_jars/

-4.4 测试

$ bin/spark-shell

scala> sqlContext.sql("select * from common.emp").show

备注:

如果spark on yarn(cluster),如果应用依赖第三方jar文件,最终解决方案:将第三方的jar文件copy到${HADOOP_HOME}/share/hadoop/common/lib文件夹中(Hadoop集群中所有机器均要求copy)

备注:如果spark on yarn(cluster),如果应用依赖第三方jar文件,最终解决方案:

spark与hive的集成的更多相关文章

- 035 spark与hive的集成

一:介绍 1.在spark编译时支持hive 2.默认的db 当Spark在编译的时候给定了hive的支持参数,但是没有配置和hive的集成,此时默认使用hive自带的元数据管理:Derby数据库. ...

- Spark&Hive:如何使用scala开发spark访问hive作业,如何使用yarn resourcemanager。

背景: 接到任务,需要在一个一天数据量在460亿条记录的hive表中,筛选出某些host为特定的值时才解析该条记录的http_content中的经纬度: 解析规则譬如: 需要解析host: api.m ...

- 使用spark对hive表中的多列数据判重

本文处理的场景如下,hive表中的数据,对其中的多列进行判重deduplicate. 1.先解决依赖,spark相关的所有包,pom.xml spark-hive是我们进行hive表spark处理的关 ...

- Spark 读写hive 表

spark 读写hive表主要是通过sparkssSession 读表的时候,很简单,直接像写sql一样sparkSession.sql("select * from xx") 就 ...

- 大数据核心知识点:Hbase、Spark、Hive、MapReduce概念理解,特点及机制

今天,上海尚学堂大数据培训班毕业的一位学生去参加易普软件公司面试,应聘的职位是大数据开发.面试官问了他10个问题,主要集中在Hbase.Spark.Hive和MapReduce上,基础概念.特点.应用 ...

- 使用spark访问hive错误记录

在spark集群中执行./spark-shell时报以下错误: 18/07/23 10:02:39 WARN DataNucleus.Connection: BoneCP specified but ...

- Spark访问Hive表

知识点1:Spark访问HIVE上面的数据 配置注意点:. 1.拷贝mysql-connector-java-5.1.38-bin.jar等相关的jar包到你${spark_home}/lib中(sp ...

- [Spark][Hive][Python][SQL]Spark 读取Hive表的小例子

[Spark][Hive][Python][SQL]Spark 读取Hive表的小例子$ cat customers.txt 1 Ali us 2 Bsb ca 3 Carls mx $ hive h ...

- Spark SQL -- Hive

使用Saprk SQL 操作Hive的数据 前提准备: 1.启动Hdfs,hive的数据存储在hdfs中; 2.启动hive -service metastore,元数据存储在远端,可以远程访问; 3 ...

随机推荐

- Wireshark使用drcom_2011.lua插件协助分析drcom协议

drcom_2011.lua是来源于Google code上的一个开源项目中的一个插件,感谢网络大神的分享 需要使用drcom_2011.lua分析drcom协议的话,需要把drcom_2011.lu ...

- Intellij Idea 13 快捷键(与Eclipse比对)以及基本的设置

详见:http://blog.yemou.net/article/query/info/tytfjhfascvhzxcyt404 刚到新公司,用的台式机配置不给力,Eclipse很不给力,几个项目一起 ...

- poj 2553 强连通

题意:给出一个有向图,定义:若节点v所有能到达的点{wi},都能反过来到达v,那么称节点v是sink.题目要求所有的sink点. 思路:强连通缩点找出出度为零的点,输出即可. 这题主要问题是读题,了解 ...

- 使用vs2015编写c语言程序

使用vs2015编写c语言程序 转载Yanky--博客园 http://www.cnblogs.com/yankyblogs/p/7058036.html 编写c语言程序的软件有很多,当年刚开始学 ...

- 关于SpringMVC项目报错:java.io.FileNotFoundException: Could not open ServletContext resource [/WEB-INF/xxxx.xml]

关于SpringMVC项目报错:java.io.FileNotFoundException: Could not open ServletContext resource [/WEB-INF/xxxx ...

- 结对作业--基于GUI的四则运算生成器

组员:201421123015 陈麟凤 201421123019 张志杰 201421123020 黄海鸿 coding 地址 :https://coding.net/u/zhang1995/p/wo ...

- 201521123114 《Java程序设计》第2周学习总结

#1. 本周学习总结 1. 学会了使用码云管理代码,使用eclipse关联jdk源代码: 2. 学习了包管理机制,包的作用:主要是管理java文件,解决同名文件冲突; 3. ArrayList可以处理 ...

- 201521123030《Java程序设计》第1周学习总结

#1. 本章学习总结 你对于本章知识的学习总结 了解了java的发展简介 认识了jvm/jre/jdk的联系,学习安装jdk java好麻烦的说... 1.为什么java程序可以跨平台运行?执行jav ...

- 201521123105 《Java程序设计》第1周学习总结

1.学习总结 简单学习jave 了解并区分JVM JRE JDK 了解JAVA语言的发展史 2.书面作业 Q:为什么java程序可以跨平台运行?执行java程序的步骤是什么?( ...

- 201521123078 《Java程序设计》第11周学习总结

1. 本周学习总结 1.1 以你喜欢的方式(思维导图或其他)归纳总结多线程相关内容. 2. 书面作业 1.互斥访问与同步访问 1.1 除了使用synchronized修饰方法实现互斥同步访问,还有什么 ...