ELK系列~log4-nxlog-Fluentd-elasticsearch写json数据需要注意的几点

经验与实践

前两篇文章里我们介绍了nxlog的日志收集和转发《ELK系列~Nxlog日志收集加转发(解决log4日志换行导致json转换失败问题)》,今天我们主要总结一下,在与log4和fluentd及elasticsearch配合工作时需要注意的几个点,这几个点也是我们经常遇到的坑,希望可以帮到大家!我们从日志产生端log4开始说。

- log4需要注意的,编码与时间戳格式

- nxlog需要注意output里对内容处理

- fluentd需要注意类型和format的规定

1 log4产生日志,格式必须是utf-8,ansi编码对中文解析时有问题,主要表示在fluentd到elasticsearch写数据时

<datePattern value="yyyyMMdd"Error.log"" />

<encoding value="utf-8" />

<layout type="log4net.Layout.PatternLayout">

</layout>

</appender>

2 log4日志里,时间戳@timestamp,需要是UTC时间,格式为yyyy-MM-ddTHH:mm:ss.fff+0800

private static string FormatStr(string level, string message, Exception ex)

{

var json = JsonConvert.SerializeObject(new

{

target_index = projectName,

timestamp = DateTime.Now.ToUniversalTime().ToString("yyyy-MM-ddTHH:mm:ss.fff+0800"),

Level = level.ToString(),

Message = message,

StackTrace = ex?.StackTrace

});

json = json.Replace("target_index", "@target_index").Replace("timestamp", "@timestamp");

return json;

}

3 nxlog日志收集时,由于log4产生的数据都是\r符号,所以在nxlog.conf里需要对output进行过滤,当然\n,使它变成两条消息,这样主体消息里就没有\r了,json解析时就不会有问题

<Output out>

Module om_tcp

Host 192.168.200.214

Port Exec $raw_event =$raw_event + "\n";

</Output>

4 fluentd的配置里,类型需要是tcp,格式format需要是none

<source>

@type tcp

tag windows.log

format none

port

bind 0.0.0.0

</source>

<filter docker.**>

type parser

format json

time_format %Y-%m-%dT%H:%M:%S.%L%Z

key_name log

reserve_data true

</filter>

<match **>

@type stdout

</match>

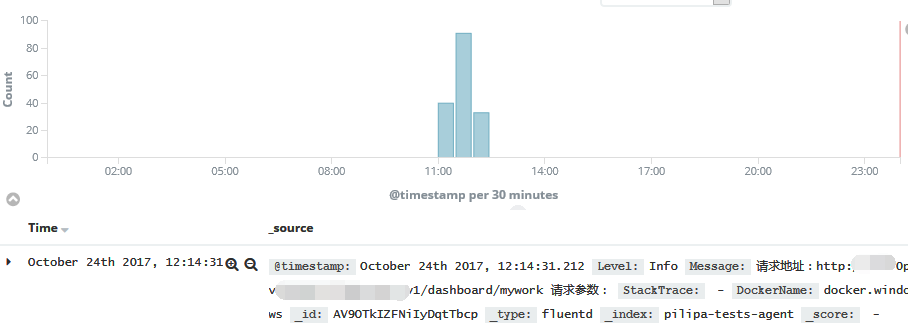

5 最后就是成功写入elasticsearch,通过kibana就可以查看日志了

请把学习作为一种习惯!

请把积累和总结变成一种学习的方式!

感谢各位的阅读!

ELK系列~log4-nxlog-Fluentd-elasticsearch写json数据需要注意的几点的更多相关文章

- ELK系列~NLog.Targets.Fluentd到达如何通过tcp发到fluentd

最近火的不能再火的日志框架就是ELK,其中E(Elasticsearch)表示日志存储,L(Logstash)表示日志收集,K(kibana)表示日志的UI界面,用来查询和分析,而其中的L可以使用Fl ...

- Logstash学习之路(二)Elasticsearch导入json数据文件

一.数据从文件导入elasticsearch 1.数据准备: 1.数据文件:test.json 2.索引名称:index 3.数据类型:doc 4.批量操作API:bulk {"index& ...

- ELK系列~Nxlog日志收集加转发(解决log4日志换行导致json转换失败问题)

本文章将会继承上一篇文章,主要讲通过工具来进行日志的收集与发送,<ELK系列~NLog.Targets.Fluentd到达如何通过tcp发到fluentd> Nxlog是一个日志收集工具, ...

- ELK系列~nxlog实现多位置文件的收集

前几天我写了几篇关于ELK日志收集,存储和分析的文章: ELK系列~NLog.Targets.Fluentd到达如何通过tcp发到fluentd ELK系列~Nxlog日志收集加转发(解决log4日志 ...

- 2. 妈呀,Jackson原来是这样写JSON的

没有人永远18岁,但永远有人18岁.本文已被 https://www.yourbatman.cn 收录,里面一并有Spring技术栈.MyBatis.JVM.中间件等小而美的专栏供以免费学习.关注公众 ...

- ELK系列~Fluentd对大日志的处理过程~16K

Fluentd是一个日志收集工具,有输入端和输出端的概念,前者主要是日志的来源,你可以走多种来源方式,http,forward,tcp都可以,后者输出端主要指把日志进行持久化的过程,你可以直接把它持久 ...

- elk系列3之通过json格式采集Nginx日志【转】

转自 elk系列3之通过json格式采集Nginx日志 - 温柔易淡 - 博客园http://www.cnblogs.com/liaojiafa/p/6158245.html preface 公司采用 ...

- ELK系列七:Elasticsearch的集群配置和监控以及在部署ELK中踩的坑

1.基本下载安装 #按照ELK系列一博客安装启动即可,没有大坑,注意一下权限即可 chmod -R 777 ./elasticsearch #此外没有java的,注意安装下JDK,我这次部署的环境是C ...

- ELK系列三:Elasticsearch的简单使用和配置文件简介

1.定义模板创建索引: 首先定义好一个模板的例子 { "order":14, "template":"ids-1", "state ...

随机推荐

- 201521123015 《Java程序设计》第13周学习总结

1. 本周学习总结 2. 书面作业 1. 网络基础 1.1 比较ping www.baidu.com与ping cec.jmu.edu.cn,分析返回结果有何不同?为什么会有这样的不同? IP地址不同 ...

- 2017年AR大会上海站干货分享

怀着即兴奋又激动的心情,踏上了第二次去上海的高铁,全长约1400公里行驶6小时15分钟,不算漫长的6个多小时里,对于不长出差的我来说,可谓是一种煎熬,再加上晕车的毛病,在去高铁的路上已经渐渐发作,但好 ...

- SpringMVC第四篇【参数绑定详讲、默认支持参数类型、自定义参数绑定、RequestParam注解】

参数绑定 我们在Controller使用方法参数接收值,就是把web端的值给接收到Controller中处理,这个过程就叫做参数绑定- 默认支持的参数类型 从上面的用法我们可以发现,我们可以使用req ...

- SimpleRpc-网络事件响应Reactor设计模式

前言 这篇文章主要介绍整个框架用到的最核的一个设计模式:反应器模式.这个设计模式可以在<面向对象的软件架构>中详细了解,没有这本书的小伙伴不要急,我通过咱们的SimpleRpc来告诉大家这 ...

- 记一次【模拟点击】,WinForm小软件开发过程

前言 年初四月份的时候,有朋友找到我,说想开发一个模拟点击的软件.最终软件做完后,发现效果不理想.唯一开发的我是认为最好是放弃了,做运营的他,坚持说这个没问题,说是改变合作方式.最终也是不了了之了. ...

- 【个人笔记】《知了堂》MySQL中的数据类型

MySQL中的数据类型 1.整型 MySQL数据类型 含义(有符号) tinyint(m) 1个字节 范围(-128~127) smallint(m) 2个字节 范围(-32768~32767) ...

- Spring MVC中Filter Servlet Interceptor 执行顺序

<servlet> <servlet-name>springmvc</servlet-name> <servlet-class>org.springfr ...

- 深入理解计算机系统chapter5

编写高效的程序需要:1.选择合适的数据结构和算法 2.编译器能够有效优化以转换为高效可执行代码的源代码 3.利用并行性 优化编译器的局限性 程序示例: combine3的汇编代码: load-> ...

- 02_Java运行环境搭建

1.Java运行环境搭建,对于初学者来说,主要下载安装jdk即可,windows操作系统再配合记事本,即可进行java程序开发.后续的学习以及工作中需要使用IDE工具进行开发,常用IDE工具是ecli ...

- 基于React Native的移动平台研发实践分享

转载:http://blog.csdn.net/haozhenming/article/details/72772787 本文目录: 一.React Native 已经成为了移动前端技术的趋势 二.基 ...