使用java API操作hdfs--拷贝部分文件到hdfs

要求如下:

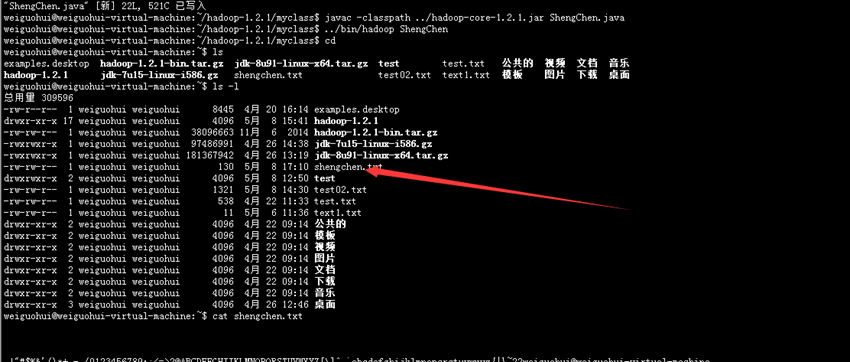

自行在本地文件系统生成一个大约一百多字节的文本文件,写一段程序(可以利用Java API或C API),读入这个文件,并将其第101-120字节的内容写入HDFS成为一个新文件。

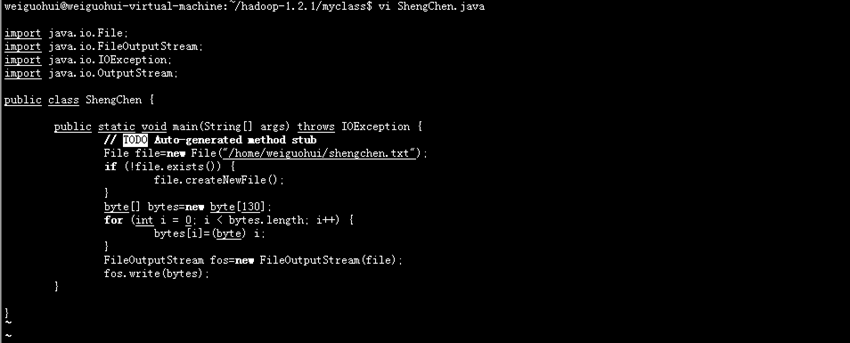

import java.io.File;

import java.io.FileOutputStream;

import java.io.IOException;

import java.io.OutputStream;

public class ShengChen {

public static void main(String[] args) throws IOException {

// TODO Auto-generated method stub

File file=new File("/home/weiguohui/shengchen.txt");

if (!file.exists()) {

file.createNewFile();

}

byte[] bytes=new byte[130];

for (int i = 0; i < bytes.length; i++) {

bytes[i]=(byte) i;

}

FileOutputStream fos=new FileOutputStream(file);

fos.write(bytes);

}

}

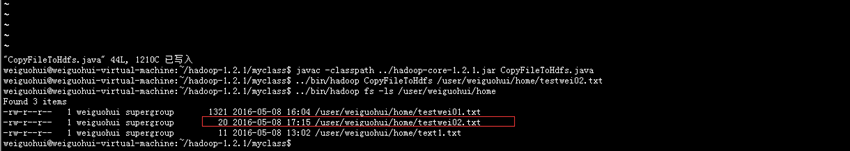

正好写入了20个字节

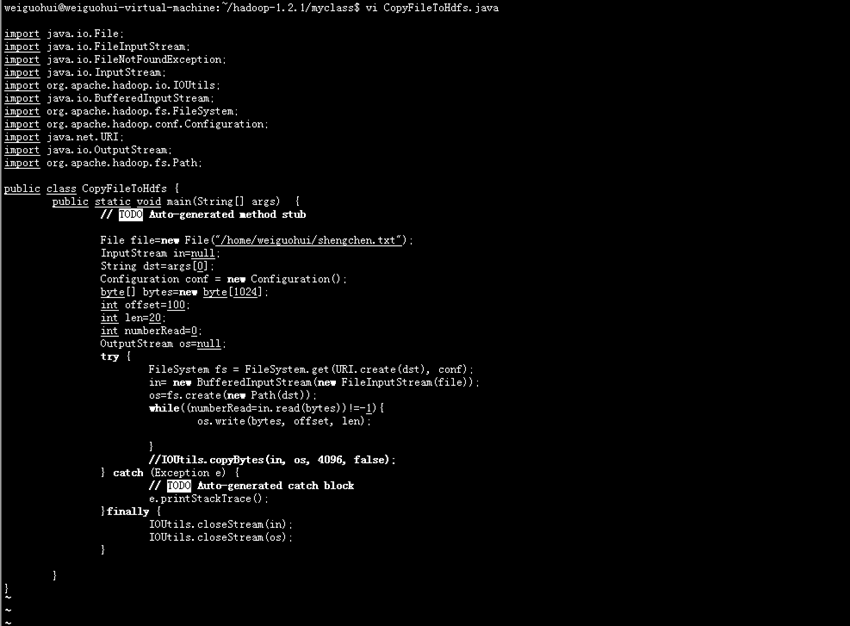

代码:

import java.io.File;

import java.io.FileInputStream;

import java.io.FileNotFoundException;

import java.io.InputStream;

import org.apache.hadoop.io.IOUtils;

import java.io.BufferedInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.conf.Configuration;

import java.net.URI;

import java.io.OutputStream;

import org.apache.hadoop.fs.Path;

public class CopyFileToHdfs {

public static void main(String[] args) {

// TODO Auto-generated method stub

File file=new File("/home/weiguohui/shengchen.txt");

InputStream in=null;

String dst=args[0];

Configuration conf = new Configuration();

byte[] bytes=new byte[1024];

int offset=100;

int len=20;

int numberRead=0;

OutputStream os=null;

try {

FileSystem fs = FileSystem.get(URI.create(dst), conf);

in= new BufferedInputStream(new FileInputStream(file));

os=fs.create(new Path(dst));

while((numberRead=in.read(bytes))!=-1){

os.write(bytes, offset, len);

}

//IOUtils.copyBytes(in, os, 4096, false);

} catch (Exception e) {

// TODO Auto-generated catch block

e.printStackTrace();

}finally {

IOUtils.closeStream(in);

IOUtils.closeStream(os);

}

}

}

使用java API操作hdfs--拷贝部分文件到hdfs的更多相关文章

- 使用java API操作hdfs--拷贝部分文件到本地

要求:和前一篇的要求正好相反.. 在HDFS中生成一个130KB的文件: 代码如下: import java.io.IOException; import org.apache.hadoop.conf ...

- HDFS 05 - HDFS 常用的 Java API 操作

目录 0 - 配置 Hadoop 环境(Windows系统) 1 - 导入 Maven 依赖 2 - 常用类介绍 3 - 常见 API 操作 3.1 获取文件系统(重要) 3.2 创建目录.写入文件 ...

- 使用Java API操作HDFS文件系统

使用Junit封装HFDS import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.*; import org ...

- Hadoop之HDFS(三)HDFS的JAVA API操作

HDFS的JAVA API操作 HDFS 在生产应用中主要是客户端的开发,其核心步骤是从 HDFS 提供的 api中构造一个 HDFS 的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS ...

- hadoop2-HBase的Java API操作

Hbase提供了丰富的Java API,以及线程池操作,下面我用线程池来展示一下使用Java API操作Hbase. 项目结构如下: 我使用的Hbase的版本是 hbase-0.98.9-hadoop ...

- Kafka系列三 java API操作

使用java API操作kafka 1.pom.xml <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xs ...

- MongoDB Java API操作很全的整理

MongoDB 是一个基于分布式文件存储的数据库.由 C++ 语言编写,一般生产上建议以共享分片的形式来部署. 但是MongoDB官方也提供了其它语言的客户端操作API.如下图所示: 提供了C.C++ ...

- hive-通过Java API操作

通过Java API操作hive,算是测试hive第三种对外接口 测试hive 服务启动 package org.admln.hive; import java.sql.SQLException; i ...

- zookeeper的java api操作

zookeeper的java api操作 创建会话: Zookeeper(String connectString,int sessionTimeout,Watcher watcher) Zookee ...

随机推荐

- [转载]或许您还不知道的八款Android开源游戏引擎

或许您还不知道的八款Android开源游戏引擎 分类: 技术文章 2010-08-04 20:27 17430人阅读 ...

- spring(一) IOC讲解

spring基本就两个核心内容,IOC和AOP.把这两个学会了基本上就会用了. --WH 一.什么是IOC? IOC:控制反转,通俗点讲,将对象的创建权交给spring,我们需要new对象,则由spr ...

- ajax使用及代码表示

最近学习了ajax,记录一下学习写过的代码和一些问题 一.原生ajax var xhr = null; if(window.XMLHttpRequest) { xhr = new XMLHttpReq ...

- Plupload上传插件简单整理

Plupload Plupload是有TinyMCE的开发者开发的,为您的内容管理系统或是类似上传程序提供一个高度可用的上传插件.Plupload 目前分为一个核心API 和一个jQuery上传队列部 ...

- socket模拟通信实现ARQ停止等待协议

//服务端 import java.awt.*; import java.awt.event.ActionEvent; import java.awt.event.ActionListener; im ...

- Java开发—乘风破浪

最近需要上线很多新的JAVA项目,然而很多JAVA的相关库都不太熟悉,项目实现起来遇到了不小阻力,熬了好几天夜.手头的基本完成了,因此打算好好来熟悉下java的相关工具库,需要借助你们,好好的在JAV ...

- sql连接查询中on筛选与where筛选的区别

sql查询这个东西, 要说它简单, 可以很简单, 通常情况下只需使用增删查改配合编程语言的逻辑表达能力,就能实现所有功能. 但是增删查改并不能代表sql语句的所有, 完整的sql功能会另人望而生畏. ...

- 【shell编程基础2】shell组合应用之一:重定向和逻辑

这篇主要讲下 数据的重定向,在shell脚本中有些重要的输出重定向为文件的形式输出来 逻辑方式的多个命令组合,可以很方便的进行一些判断 数据流重定向 数据流重定向:大致上的意思就是本该输出到屏幕上的数 ...

- JSSDK微信自定义分享

背景:15年之前的微信分享只需要加入一段js就可以实现.后来微信官方全部禁止了.现在的微信分享全部得使用jssdk. 一.分享功能: 在微信内(必须在微信里)打开网站页面,分享给朋友或者分享到朋友圈时 ...

- css系列(布局):实现一个元素在浏览器中水平、垂直居中的几个方案

在开发中偶遇需要一个元素垂直居中的需求,之前都是水平居中,垂直居中使用的比较少,经过一通研究,选择了几种相对比较实用的方案分享,抛砖引玉,如有遗漏不足,还望不吝指正. 方案一(IE7下该方案无法实现垂 ...