在 IDEA中运行 WordCount

一、新建一个maven项目

二、pom.xml 中内容

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion> <groupId>1</groupId>

<artifactId>1</artifactId>

<version>1.0-SNAPSHOT</version> <repositories>

<repository>

<id>apache</id>

<url>http://maven.apache.org</url>

</repository>

</repositories> <dependencies>

<!--<dependency>-->

<!--<groupId>org.apache.hadoop</groupId>-->

<!--<artifactId>hadoop-core</artifactId>-->

<!--<version>2.7.2</version>-->

<!--</dependency>-->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.2</version>

</dependency> <dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.2</version>

</dependency> <dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>3.8.1</version>

<scope>test</scope>

</dependency>

</dependencies> <build>

<plugins>

<plugin>

<artifactId>maven-dependency-plugin</artifactId>

<configuration>

<excludeTransitive>false</excludeTransitive>

<stripVersion>true</stripVersion>

<outputDirectory>./lib</outputDirectory>

</configuration> </plugin>

</plugins>

</build>

</project>

三、准备数据文件

注意点:因为Windows当前用户是 Administrator ,所以需要在 hdfs://master:8020/user/ 目录下创建文件夹 Administrator ,以后进行本地测试都使用此文件夹。

文件夹创建好之后,还需要给与写的权限。此处直接给最大权限。

su hdfs

hdfs dfs -mkdir -p /user/Administrator/input

hdfs dfs -chmod -R 777 /user/Administrator

hdfs dfs -put ./wordCountData.txt /user/Administrator/input

exit

四、创建 WordCount.java 文件

注意点: 因为是在 Windows 上提交 mapreduce 任务,需要在 conf 中设置下面内容。

conf.set("mapreduce.app-submission.cross-platform", "true"); // 跨平台,保证在 Windows 下可以提交 mr job

否则报错:/bin/bash: line 0: fg: no job control

package com.zjc.mr; import java.io.IOException;

import java.util.StringTokenizer; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class WordCount { public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> { // 下面的IntWritable 跟 Text 类是hadoop内部类,相当于 java 中的 int 与 String

// MapReduce 程序中互相传递的是这种类型的参数

private final static IntWritable one = new IntWritable(1);

private Text word = new Text(); public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());//java 自带的字符串分割函数

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

/*

*eg map output:

* hello 1

* word 1

* hello 1

* hadoop 1

*/

}

}

} /*

* Reduce 输入:

* key: hello

* value: [1,1]

*

* Hadoop负责将Map产生的<key,value>处理成{具有相同key的value集合},传给Reducer

输入:<key,(listof values)>

输出:<key,value>

reduce函数(必须是这个名字)的参数,(输入key,输入具有相同key的value集合,Context)其中,

输入的key,value必须类型与map的输出<key,value>相同,这一点适用于map,reduce类及函数

*

*/

public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable(); public void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

System.out.println("-----------------------------------------");

System.out.println("key: "+key);

for (IntWritable val : values) {

System.out.println("val: "+val);

sum += val.get();

}

result.set(sum);

System.out.println("result: "+result.toString());

context.write(key, result);

}

} public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

conf.set("mapreduce.app-submission.cross-platform", "true"); // 跨平台,保证在 Windows 下可以提交 mr job

Job job = Job.getInstance(conf, "word count"); // 任务名

job.setJarByClass(WordCount.class); // 指定Class

job.setMapperClass(TokenizerMapper.class); // 指定 Mapper Class

job.setCombinerClass(IntSumReducer.class); // 指定 Combiner Class,与 reduce 计算逻辑一样

job.setReducerClass(IntSumReducer.class); // 指定Reucer Class

job.setOutputKeyClass(Text.class); // 指定输出的KEY的格式

job.setOutputValueClass(IntWritable.class); // 指定输出的VALUE的格式

job.setNumReduceTasks(1); //设置Reducer 个数默认1

// Mapper<Object, Text, Text, IntWritable> 输出格式必须与继承类的后两个输出类型一致

String args_0 = "hdfs://master:8020/user/Administrator/input";

String args_1 = "hdfs://master:8020/user/Administrator/output";

FileInputFormat.addInputPath(job, new Path(args_0)); // 输入路径

FileOutputFormat.setOutputPath(job, new Path(args_1)); // 输出路径

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

// 每次运行都需要先删除hdfs中,上一次执行生成的 output 文件夹。 hdfs dfs -rm -R /user/Administrator/output

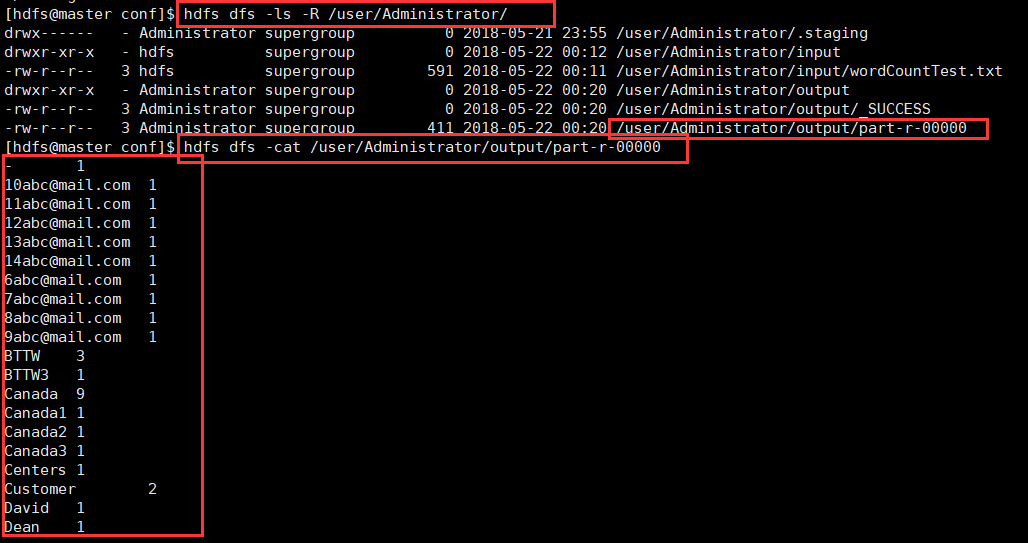

五、查看结果

在 IDEA中运行 WordCount的更多相关文章

- Spark学习笔记——在远程机器中运行WordCount

1.通过realy机器登录relay-shell ssh XXX@XXX 2.登录了跳板机之后,连接可以用的机器 XXXX.bj 3.在本地的idea生成好程序的jar包(word-count_2.1 ...

- CDH quick start VM 中运行wordcount例子

需要注意的事情: 1. 对于wordcount1.0 ,按照http://www.cloudera.com/content/cloudera/en/documentation/HadoopTutori ...

- 在eclipse中运行wordcount,控制台打印log4j警告

log4j:WARN No appenders could be found for logger (org.apache.hadoop.util.Shell).log4j:WARN Please i ...

- Hadoop3 在eclipse中访问hadoop并运行WordCount实例

前言: 毕业两年了,之前的工作一直没有接触过大数据的东西,对hadoop等比较陌生,所以最近开始学习了.对于我这样第一次学的人,过程还是充满了很多疑惑和不解的,不过我采取的策略是还是先让环 ...

- (二)Hadoop例子——运行example中的wordCount例子

Hadoop例子——运行example中的wordCount例子 一. 需求说明 单词计数是最简单也是最能体现MapReduce思想的程序之一,可以称为 MapReduce版"Hello ...

- 021_在Eclipse Indigo中安装插件hadoop-eclipse-plugin-1.2.1.jar,直接运行wordcount程序

1.工具介绍 Eclipse Idigo.JDK1.7-32bit.hadoop1.2.1.hadoop-eclipse-plugin-1.2.1.jar(自己网上下载) 2.插件安装步骤 1)将ha ...

- Spark源码编译并在YARN上运行WordCount实例

在学习一门新语言时,想必我们都是"Hello World"程序开始,类似地,分布式计算框架的一个典型实例就是WordCount程序,接触过Hadoop的人肯定都知道用MapRedu ...

- eclipse运行WordCount

1) 可以完全参考http://www.cnblogs.com/archimedes/p/4539751.html在eclipse下创建MapReduce工程,创建了MR工程,并完成WordCount ...

- 解决在windows的eclipse上面运行WordCount程序出现的一系列问题详解

一.简介 要在Windows下的 Eclipse上调试Hadoop2代码,所以我们在windows下的Eclipse配置hadoop-eclipse-plugin- 2.6.0.jar插件,并在运行H ...

随机推荐

- python datetime操作

#datetime object转化为timestamp import datetime now = datetime.datetime.now() now_timestamp = time.mkti ...

- C#格式化

格式化表示的一般格式 { N [ , M ] [ :格式码 ] } N: 指定参数序列中的输出序号,比如{0} , {1}, {2}等. M: 指定参数输出的最小长度. 如果参数长度小于M,则空格填 ...

- C#事件与委托详解

from https://www.cnblogs.com/sjqq/p/6917497.html C#事件与委托详解[精华 多看看] Delegatedelegate是C#中的一种类型,它实际上是一个 ...

- The xp_cmdshell proxy account information cannot be retrieved or is invalid. Verify that the '##xp_cmdshell_proxy_account##' credential exists and contains valid information.

In one of our recent migrations, we got the following error when the client tried to fire xp_cmdshel ...

- Vue.js01:跑马灯效果

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- Ubuntu 16.04 安装系统监视器System Monitor

安装好Ubuntu 16.04 之后,如何查看系统进程,CPU等的使用情况呢,System Monitor可以做到, 安装步骤: sudo add-apt-repository ppa:fossfre ...

- 每日PA -2019年1月帖-每天更新

开篇 "每日PA"有什么亮点?

- eclipse中使用Lombok(转)

原文链接:https://www.cnblogs.com/justuntil/p/7120534.html windows环境 1.下载lombok.jar包https://projectlombok ...

- HTTP对静态资源的优化

HTTP的If-Modified-Since和Modified-Since标签 在第一次请求静态资源时响应头会携带一个Modified-Since标签,里面存放的是静态资源的最后修改时间,在之后对该静 ...

- 【新特性速递】FineUIPro/Mvc/Core 全新移动端访问体验(示例首页)!

移动端支持 虽然 FineUIPro 早在 2016 年就已经完成对移动端的适配工作,并新增了 50 多个官网示例. 并且,我们也新增了一个移动端的首页 http://pro.fineui.com/m ...