关于怎么获取kafka指定位置offset消息(转)

1.在kafka中如果不设置消费的信息的话,一个消息只能被一个group.id消费一次,而新加如的group.id则会被“消费管理”记录,并指定从当前记录的消息位置开始向后消费。如果有段时间消费者关闭了,并有发送者发送消息那么下次这个消费者启动时也会接收到,但是我们如果想要从这个topic的第一条消息消费呢?

public class SimpleConsumerPerSonIndex2 {

public static void main(String[] args) throws Exception {

//Kafka consumer configuration settings

String topicName = "mypartition001";

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "partitiontest112");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("session.timeout.ms", "30000");

//要发送自定义对象,需要指定对象的反序列化类

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "com.ys.test.SpringBoot.zktest.encode.DecodeingKafka");

KafkaConsumer<String, Object> consumer = new KafkaConsumer<String, Object>(props);

Map<TopicPartition, OffsetAndMetadata> hashMaps = new HashMap<TopicPartition, OffsetAndMetadata>();

hashMaps.put(new TopicPartition(topicName, 0), new OffsetAndMetadata(0));

consumer.commitSync(hashMaps);

consumer.subscribe(Arrays.asList(topicName));

while (true) {

ConsumerRecords<String, Object> records = consumer.poll(100);

for (ConsumerRecord<String, Object> record : records){

System.out.println(record.toString());

}

}

}

}

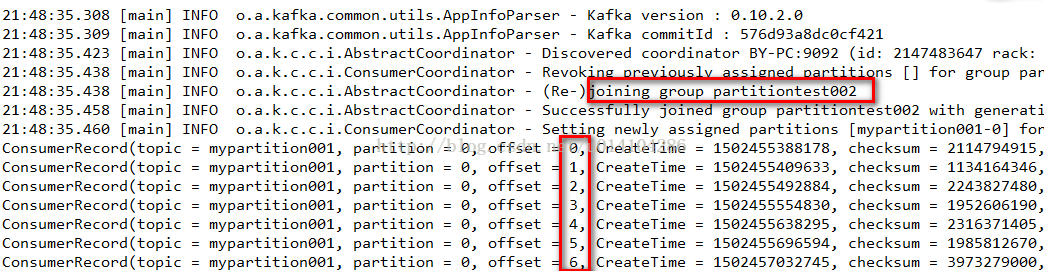

首先我们在consumer.subscribe(Arrays.asList(topicName));订阅一个topic之前要设置从这个topic的offset为0的地方获取。

注意:这样的方法要保证这个group.id是新加入,如果是以前存在的,那么会抛异常。

2.如果以前就存在的groupid想要获取指定的topic的offset为0开始之后的消息:

public class SimpleConsumerPerSonIndex2 {

public static void main(String[] args) throws Exception {

//Kafka consumer configuration settings

String topicName = "mypartition001";

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "partitiontest002");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("session.timeout.ms", "30000");

//要发送自定义对象,需要指定对象的反序列化类

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "com.ys.test.SpringBoot.zktest.encode.DecodeingKafka");

KafkaConsumer<String, Object> consumer = new KafkaConsumer<String, Object>(props);

// consumer.subscribe(Arrays.asList(topicName));

consumer.assign(Arrays.asList(new TopicPartition(topicName, 0)));

consumer.seekToBeginning(Arrays.asList(new TopicPartition(topicName, 0)));//不改变当前offset

// consumer.seek(new TopicPartition(topicName, 0), 10);//不改变当前offset

while (true) {

ConsumerRecords<String, Object> records = consumer.poll(100);

for (ConsumerRecord<String, Object> record : records){

System.out.println(record.toString());

}

}

}

}

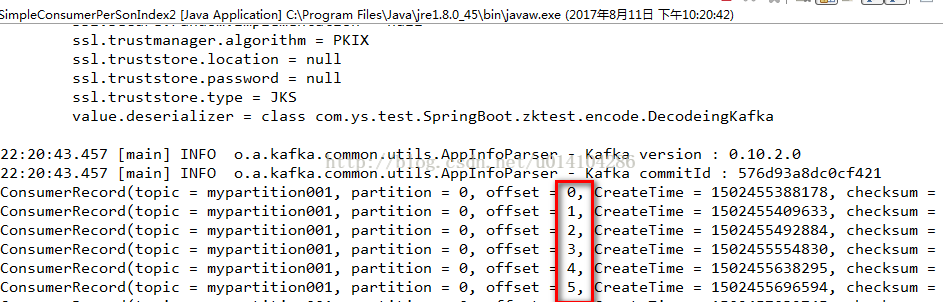

使用 consumer.assign(Arrays.asList(new TopicPartition(topicName, 0)));来分配topic和partition,

而consumer.seekToBeginning(Arrays.asList(new TopicPartition(topicName, 0)));指定从这个topic和partition的开始位置获取。

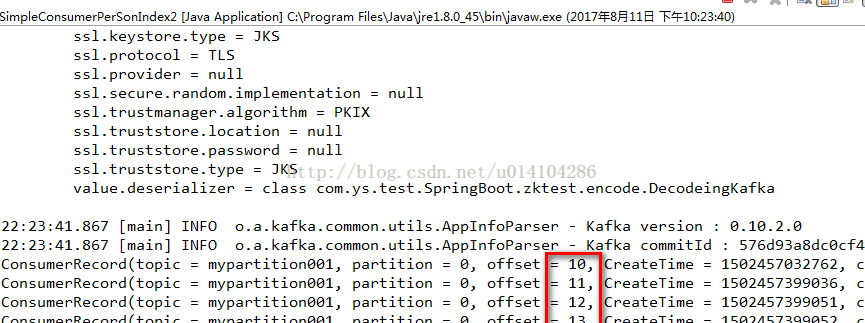

3.存在的groupid获取指定的topic任意的offset

上面的代码放开 consumer.seek(new TopicPartition(topicName, 0), 10);//不改变当前offset

并注释 consumer.seekToBeginning(Arrays.asList(new TopicPartition(topicName, 0)));//不改变当前offset;

其中consumer.seek(new TopicPartition(topicName, 0), 10)中的10是表示从这个topic的partition中的offset为10的开始获取消息。

需要注意的是 consumer.assign()是不会被消费者的组管理功能管理的,他相对于是一个临时的,不会改变当前group.id的offset,比如:

在使用consumer.subscribe(Arrays.asList(topicName));时offset为20,如果通过2和3,已经获取了最新的消息offset是最新的,

在下次通过 consumer.subscribe(Arrays.asList(topicName));来获取消息时offset还是20.还是会获取20以后的消息。

其实在2、3的结果截图中我们也可以发现没有1中结果图的joining group的日志输出,表示没有加入到group中。

————————————————

版权声明:本文为CSDN博主「也是右移」的原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/u014104286/article/details/77103541/

关于怎么获取kafka指定位置offset消息(转)的更多相关文章

- jQuery 获取元素当前位置offset()与position()

<!DOCTYPE html> <html lang="zh-CN"> <head> <meta charset="UTF-8& ...

- 获取kafka的lag, offset, logsize的shell和python脚本

python脚本 #!/usr/bin/env python import os import re import sys group_id=sys.argv[1] pn=sys.argv[2] ka ...

- 工具篇-Spark-Streaming获取kafka数据的两种方式(转载)

转载自:https://blog.csdn.net/weixin_41615494/article/details/7952173 一.基于Receiver的方式 原理 Receiver从Kafka中 ...

- Spark-Streaming获取kafka数据的两种方式:Receiver与Direct的方式

简单理解为:Receiver方式是通过zookeeper来连接kafka队列,Direct方式是直接连接到kafka的节点上获取数据 Receiver 使用Kafka的高层次Consumer API来 ...

- SparkStreaming获取kafka数据的两种方式:Receiver与Direct

简介: Spark-Streaming获取kafka数据的两种方式-Receiver与Direct的方式,可以简单理解成: Receiver方式是通过zookeeper来连接kafka队列, Dire ...

- spark-streaming获取kafka数据的两种方式

简单理解为:Receiver方式是通过zookeeper来连接kafka队列,Direct方式是直接连接到kafka的节点上获取数据 一.Receiver方式: 使用kafka的高层次Consumer ...

- jQuery滚动条回到顶部或指定位置

jQuery滚动条回到顶部或指定位置 在很多网站,为了增强用户体验,我们会看到回到顶部的按钮,不用手动拖拽滚动条就能回到顶部,非常方便.下面就介绍用jquery实现的滚动到顶部的代码 $(functi ...

- 获取kafka最新offset-java

之前笔者曾经写过通过scala的方式获取kafka最新的offset 但是大多数的情况我们需要使用java的方式进行获取最新offset scala的方式可以参考: http://www.cnblog ...

- Flink 自定义source和sink,获取kafka的key,输出指定key

--------20190905更新------- 沙雕了,可以用 JSONKeyValueDeserializationSchema,接收ObjectNode的数据,如果有key,会放在Objec ...

随机推荐

- [bzoj2288]【POJ Challenge】生日礼物_贪心_堆

[POJ Challenge]生日礼物 题目大意:给定一个长度为$n$的序列,允许选择不超过$m$个连续的部分,求元素之和的最大值. 数据范围:$1\le n, m\le 10^5$. 题解: 显然的 ...

- [转帖]差之毫厘谬之千里!带你认识CPU后缀含义

差之毫厘谬之千里!带你认识CPU后缀含义 https://diy.pconline.com.cn/718/7189243_all.html 2015-11-16 00:15 出处:PConline原创 ...

- 理解twisted中的reactor和deferred(一)

Deferred是一个延迟加载对象,这个概念类似于tornado future,是调用异步操作返回的一个对象,其中包括了操作成功后的回调处理,错误后的回调处理. 简单讲,当我们需要执行一个耗时操作,比 ...

- 使用jackson序列化json时遇到的坑

公司使用Springboot进行开发,里面默认使用了jackson进行序列化. 但是序列化的过程中一直报错,因此记录一下. ⒈jackson默认大小写敏感,且首字母转小写 在类上添加一下注解即可 @J ...

- Java实现二叉树地遍历、求深度和叶子结点的个数

一.分析 二叉树是n个结点所构成的集合,它或为空树,或为非空树.对于非空树,它有且仅有一个根结点,且除根结点以外的其余结点分为两个互不相交的子集,分别称为左子树和右子树,它们本身又都是二叉树. 显而易 ...

- 19牛客暑期多校 round2 F dfs

题目传送门//res tp nowcoder dfs 先将所有人都归于一队,之后从一队中取出人放置到另一个队. #include<iostream> #include<cstdio& ...

- 在使用selenium时出现FileNotFoundError: [WinError 2] 系统找不到指定的文件。

今天在使用selenium出现这样的错: Traceback (most recent call last): File "E:\python\lib\site-packages\selen ...

- Codeforces 1244D. Paint the Tree

传送门 首先如果某个点的度数大于 $2$ 那么显然无解 然后考虑点的度数小于等于 $2$ 的情况 发现其实是一条链 一旦确定了链开头的两个点,后面的点的颜色都可以通过之前的点推出 所以直接枚举即可 # ...

- C#.net开发 List与DataTable相互转换

1.DataTable转List集合 /// <summary> /// DataTable转化为List集合 /// </summary> /// <typeparam ...

- java web浏览器访问工程前面添加一级目录学习笔记

有的时候因为nginx和f5策略问题需要在访问系统的时候前面添加一个前缀以区分不通地方需要用同一个工程的情况: 举个例子:当访问localhost:8080/webDemo/demo/shafei.j ...