python网络爬虫(9)构建基础爬虫思路

目的意义

基础爬虫分5个模块,使用多个文件相互配合,实现一个相对完善的数据爬取方案,便于以后更完善的爬虫做准备。

这里目的是爬取200条百度百科信息,并生成一个html文件,存储爬取的站点,词条,解释。

本文思路来源书籍。其代码部分来源书籍。https://book.douban.com/subject/27061630/

功能模块

主文件:爬虫调度器,通过调用其他文件中的方法,完成最终功能实现。

其他文件:URL管理器,HTML下载器,HTML解析器,数据存储器。

设计思路

定义SpiderMan类作为爬虫调度器。输入根URL开始爬取数据然后爬取结束。

在爬取过程中,需要获取网页,和解析网页。

解析网页需要HTML解析器,获取网页需要HTML下载器。

解析网页需要解析的数据有:URL,TITLE,CONTEXT等。则需要URL管理器和数据存储器。

主文件设计

主文件添加根URL,然后提取该URL,下载该URL内容。

根据内容,调用解析器:

解析出该URL中的新URL,存入URL管理器;

解析出该URL中的标题,文本等信息,存入数据存储器。

完成后开始下一次。这时URL管理器多出了新的URL,提取出新的URL,下载,解析,不断重复即可。

重复结束以提取出的URL数量超过200则结束。

代码如下:

from BaseSpider.DataOutput import DataOutput

from BaseSpider.HtmlDownloader import HtmlDownloader

from BaseSpider.HtmlParser import HtmlParser

from BaseSpider.UrlManager import UrlManager

class SpiderMan():

def __init__(self):

self.manager=UrlManager()

self.downloader=HtmlDownloader()

self.parser=HtmlParser()

self.output=DataOutput() def crawl(self,root_url):

self.manager.add_new_url(root_url)

while(self.manager.has_new_url() and self.manager.old_url_size()<200):

new_url=self.manager.get_new_url()

text=self.downloader.download(new_url)

if text is None:

print('None text')

break

new_urls,data=self.parser.parser(new_url,text)

self.manager.add_new_urls(new_urls)

self.output.store_data(data)

print(self.manager.old_url_size())

self.output.output_html() if __name__ == "__main__":

spider_man=SpiderMan()

spider_man.crawl("https://baike.baidu.com/item/%E7%BD%91%E7%BB%9C%E7%88%AC%E8%99%AB/5162711?fr=aladdin")

print('finish')

作为最初的设计,应该允许异常抛出,便于查看程序终止的原因,然后排查错误。

HTML下载器设计

下载网页,返回文本。即可。

import requests

import chardet

class HtmlDownloader(object):

def download(self,url):

if url is None:

return None

user_agent='Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36 SE 2.X MetaSr 1.0'

headers={'User-Agent':user_agent}

r=requests.get(url,headers=headers)

if r.status_code is 200:

r.encoding=chardet.detect(r.content)['encoding']

return r.text

return None

HTML解析器设计

HTML解析器将下载的文本进行解析,需要解析出的数据有:页面的新URL,页面的新数据文本。

建立相应的解析器,需要打开源码对比,然后进行使用源码分析,使用BeautifulSoup获取所需信息。

为了便于主函数调用或者其他原因,将所有数据通过parser实现返回,其parser分别调用获取URL和获取数据文本的信息。

为了处理一些不同网页可能抓取的意外情况导致程序终止,添加了一些判断。

import re

from urllib import parse

from bs4 import BeautifulSoup

class HtmlParser(object):

def parser(self,page_url,html_cont):

if page_url is None or html_cont is None:

return

soup=BeautifulSoup(html_cont,'lxml')

new_urls=self.getNewUrls(page_url,soup)

new_data=self.getNewData(page_url,soup)

return new_urls,new_data def getNewUrls(self,page_url,soup):

new_urls=set()

links=soup.find_all('a',href=re.compile(r'/item/.*'))

for link in links:

new_url=link['href']

new_full_url=parse.urljoin(page_url,new_url)

new_urls.add(new_full_url)

return new_urls def getNewData(self,page_url,soup):

data={}

data['url']=page_url

title=soup.find('dd',class_="basicInfo-item value")

if title is not None:

data['title']=title.string

summary=soup.find('meta',attrs={"name":"description"})

data['summary']=summary['content']

return data

else:

title=soup.find('meta',attrs={"name":"keywords"})

if title is not None:

data['title']=title['content']

summary=soup.find('meta',attrs={"name":"description"})

data['summary']=summary['content']

return data

else:

data['title']="ERROR!"

data['summary']="Please check the url for more information"

data['url']=page_url

return data

URL管理器设计

为了避免重复的URL,使用python的set,建立集合初始化。参阅:https://www.runoob.com/python3/python3-set.html

使用old_urls存储已经访问过的网址,使用new_urls存入将要提取的网址。

然后写好has_new_url等方法,辅助主程序调用。当得到新的URL们时,主程序调用函数将他们存入。

而主程序需要的其他URL管理方案,如提取,数量判定等,也在这里实现。

class UrlManager():

def __init__(self):

self.old_urls=set()

self.new_urls=set()

pass def has_new_url(self):

return self.new_url_size()!=0 def new_url_size(self):

return len(self.new_urls) def old_url_size(self):

return len(self.old_urls) def get_new_url(self):

new_url=self.new_urls.pop()

self.old_urls.add(new_url)

return new_url def add_new_url(self,url):

if url is None:

return

if url not in self.new_urls and url not in self.old_urls:

self.new_urls.add(url)

pass def add_new_urls(self,urls):

if urls is None or len(urls) == 0:

return for url in urls:

self.add_new_url(url)

pass

数据存储器设计

通过HTML解析器获取的数据,通过数据存储器进行存储。

而最终将数据从内存写入到本地磁盘,也在该文件实现。

为了调试美观,建议是先爬取一两个数据做好测试,写好table的宽度设定,加入style='word-break:break-all;word-wrap:break-word;'参数。参阅:https://zhidao.baidu.com/question/1385859725784504260.html

import codecs

class DataOutput(object):

def __init__(self):

self.datas=[] def store_data(self,data):

if data is None:

return

self.datas.append(data) def output_html(self):

fout=codecs.open('baike.html', 'w', encoding='utf-8')

fout.write("<html>")

fout.write("<head><meta charset='urf-8'></head>")

fout.write("<body>")

fout.write("<table border='1' width=1800 style='word-break:break-all;word-wrap:break-word;'>")

fout.write("<tr>")

fout.write("<td width='300'>URL</td>")

fout.write("<td width='100'>标题</td>")

fout.write("<td width='1200'>释义</td>")

fout.write("</tr>")

for data in self.datas:

fout.write("<tr>")

fout.write("<td><a href=%s>%s</a></td>"%(data['url'],data['url']))

fout.write("<td>%s</td>"%data['title'])

fout.write("<td>%s</td>"%data['summary'])

fout.write("</tr>")

fout.write("</table>")

fout.write("</body>")

fout.write("</html>")

fout.close()

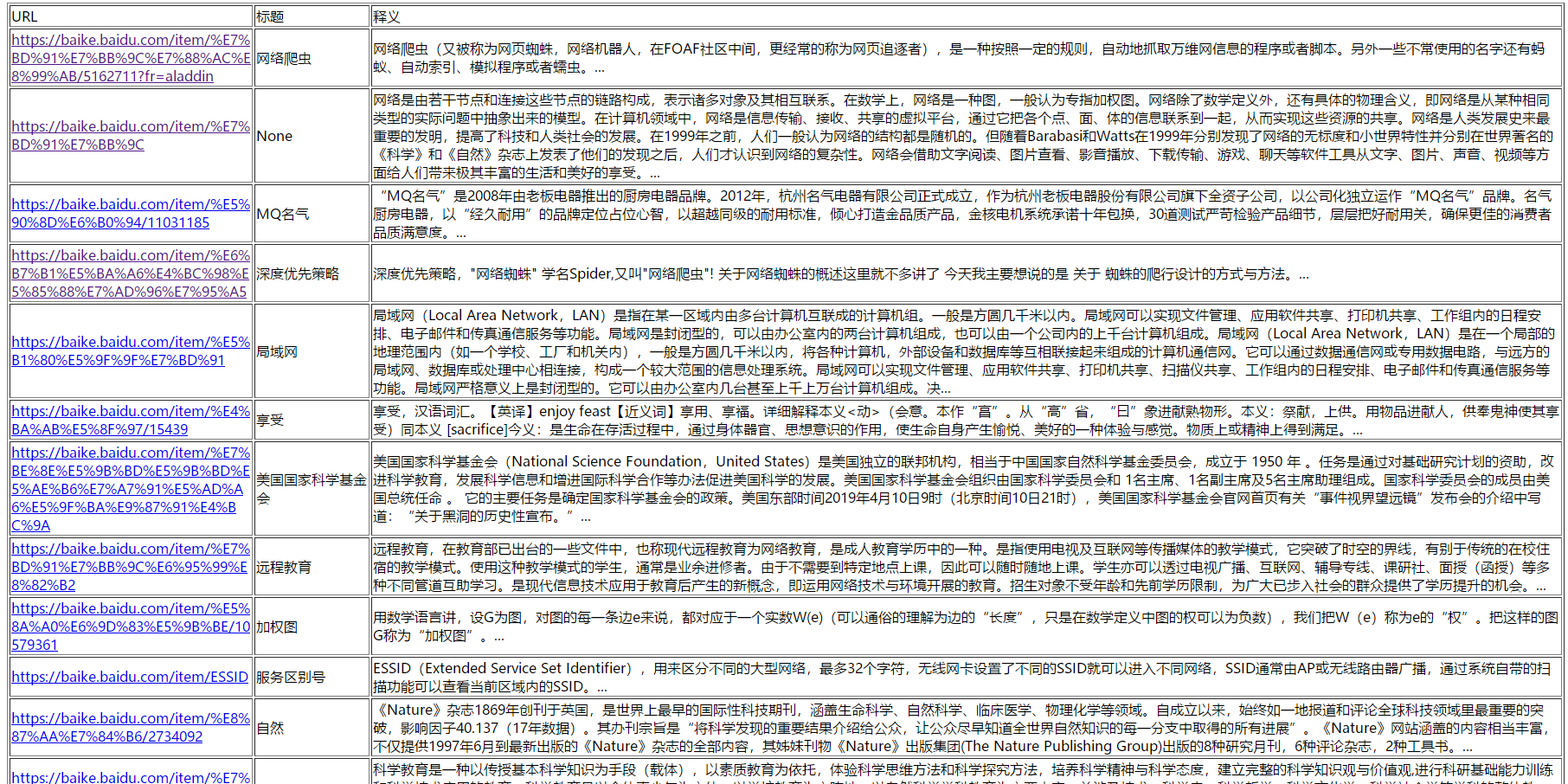

最终效果:

当然还有一些数据没有处理好。

完

python网络爬虫(9)构建基础爬虫思路的更多相关文章

- python爬虫实战:基础爬虫(使用BeautifulSoup4等)

以前学习写爬虫程序时候,我没有系统地学习爬虫最基本的模块框架,只是实现自己的目标而写出来的,最近学习基础的爬虫,但含有完整的结构,大型爬虫含有的基础模块,此项目也有,“麻雀虽小,五脏俱全”,只是没有考 ...

- 【python网络编程】新浪爬虫:关键词搜索爬取微博数据

上学期参加了一个大数据比赛,需要抓取大量数据,于是我从新浪微博下手,本来准备使用新浪的API的,无奈新浪并没有开放关键字搜索的API,所以只能用爬虫来获取了.幸运的是,新浪提供了一个高级搜索功能,为我 ...

- Python学习笔记【第十三篇】:Python网络编程一Socket基础

什么是⽹络 网络能把双方或多方连在一起的工具,即把数据从一方传递到另一方进行数据传递. 网络编程就是不同电脑上的软件能够进行数据传递.即进程间的通讯. 什么是TCP/IP协议 协议就是大家一起遵守的约 ...

- 6.Python网络编程_全局变量基础

变量作用域: 一般在函数体外定义的变量成为全局变量,在函数内部定义的变量称为局部变量.全局变量所有作用域都可用,局部变量只能在本函数可用,变量的使用顺序是,局部变量 > 全局变量, 也就是说:优 ...

- Python36 使用Redis 构建分布式爬虫(未完)

很长时间未更新了,人懒了. 最近有不少的东西,慢慢写吧,最近尝试了一下python 使用Redis 来构建分布式爬虫: 单体爬虫有很多缺点,但是在学习过程中能够学习爬虫的基本理念与运行模式,在后期构建 ...

- python代理池的构建3——爬取代理ip

上篇博客地址:python代理池的构建2--代理ip是否可用的处理和检查 一.基础爬虫模块(Base_spider.py) #-*-coding:utf-8-*- ''' 目标: 实现可以指定不同UR ...

- python网络爬虫实战PDF高清完整版免费下载|百度云盘|Python基础教程免费电子书

点击获取提取码:vg1y python网络爬虫实战帮助读者学习Python并开发出符合自己要求的网络爬虫.网络爬虫,又被称为网页蜘蛛,网络机器人,是一种按照一定的规则,自动地抓取互联网信息的程序或者脚 ...

- 爬虫(二)Python网络爬虫相关基础概念、爬取get请求的页面数据

什么是爬虫 爬虫就是通过编写程序模拟浏览器上网,然后让其去互联网上抓取数据的过程. 哪些语言可以实现爬虫 1.php:可以实现爬虫.php被号称是全世界最优美的语言(当然是其自己号称的,就是王婆 ...

- 03.Python网络爬虫第一弹《Python网络爬虫相关基础概念》

爬虫介绍 引入 之前在授课过程中,好多同学都问过我这样的一个问题:为什么要学习爬虫,学习爬虫能够为我们以后的发展带来那些好处?其实学习爬虫的原因和为我们以后发展带来的好处都是显而易见的,无论是从实际的 ...

随机推荐

- 域内信息收集 powershell收集域内信息

POwershell收集域内信息 Powershell(你可以看做CMD的升级版 但是和cmd完全不一样) 原来的powershe是不能执行任何脚本的 更改执行策略 这个是一个绕过的脚本 接下来我们了 ...

- springMVC中的ModelAndView说明

ModelAndView 类别就如其名称所示,是代表了Spring Web MVC程式中呈现画面时所使用Model资料物件与View资料物件,由于Java程式中一次只能返回一个物件,所以ModelAn ...

- SpringBoot的文件上传&下载

前言:不多BB直接上代码 文件上传 pom依赖添加commons-io <!-- 上传/下载jar https://mvnrepository.com/artifact/commons-io/c ...

- SpringMVC @ResponseBody返回中文乱码

SpringMVC的@ResponseBody返回中文乱码的原因是SpringMVC默认处理的字符集是ISO-8859-1, 在Spring的org.springframework.http.conv ...

- [学习笔记] Uplift Decision Tree With KL Divergence

Uplift Decision Tree With KL Divergence Intro Uplift model 我没找到一个合适的翻译,这方法主要应用是,探究用户在给予一定激励之后的表现,也就是 ...

- golang 性能剖析pprof

作为一个golang coder,使用golang编写代码是基本的要求. 能够写出代码,并能够熟悉程序执行过程中各方面的性能指标,则是更上一层楼. 如果在程序出现性能问题的时候,可以快速定位和解决问题 ...

- jQuery获取元素值以及设置元素值总结

html(): 1:用户获取元素内的HTML内容,如果元素包含子标签,会以整体的形式返回 2:只获取第一个元素的内容 3:只获取普通元素的内容,表单元素内容无法获取 html(val): 1:用来设置 ...

- LC 650. 2 Keys Keyboard

Initially on a notepad only one character 'A' is present. You can perform two operations on this not ...

- JavaFx入门(一)

JavaFx和Swing的对比: javaFX确实比swing好看些,但没有swing的事件按钮等写法爽快,特别是使用eclipse的matisse开发视图,托拉拽的方式.可javaFX不只是有swi ...

- Centos7桥接网络、DNS、时间同步配置

Centos配置桥接网络.DNS服务和时间同步 1.配置桥接网络 2.配置虚拟机网卡,采用的是静态ip方式 重启network服务 3.配置dns 4.关闭防火墙和selinux 5.ping外网域名 ...