Spark-2.0原理分析-shuffle过程

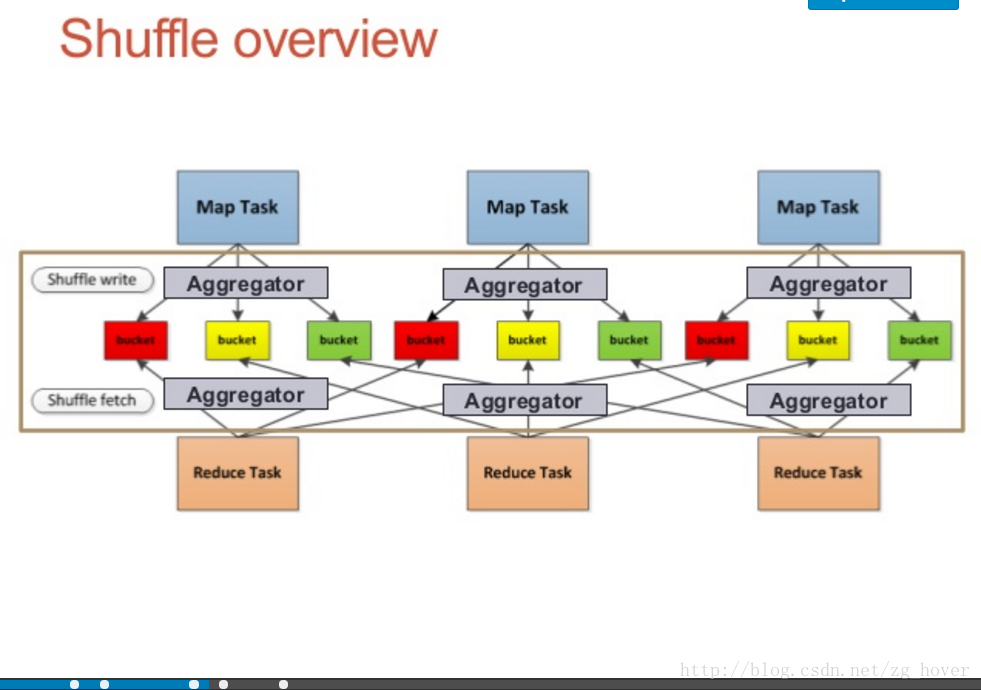

shuffle概览

shuffle过程概览

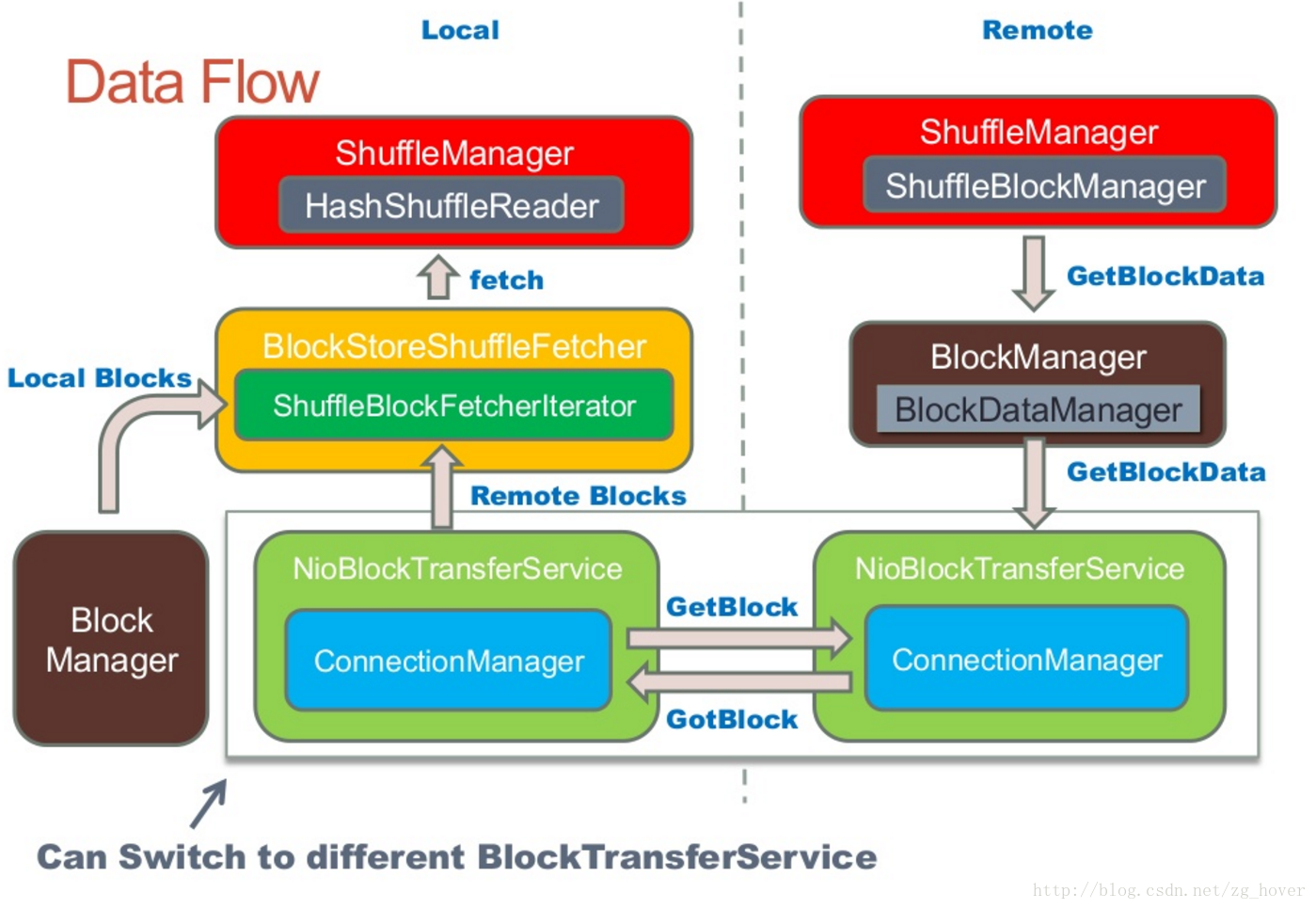

shuffle数据流概览

shuffle数据流

shuffle工作流程

在运行job时,spark是一个stage一个stage执行的。先把任务分成stage,在任务提交阶段会把任务形成taskset,在执行任务。

spark的DAGScheduler根据RDD的ShuffleDependency来构建Stages:

- 例如:ShuffleRDD/CoGroupedRDD有一个ShuffleDependency。

- 很多操作通过钩子函数来创建ShuffleRDD

每个ShuffleDependency会map到spark的job的一个stage,然后会导致一个shuffle过程。

为什么shuffle过程代价很大

这是由于shuffle过程可能需要完成以下过程:

- 重新进行数据分区

- 数据传输

- 数据压缩

- 磁盘I/O

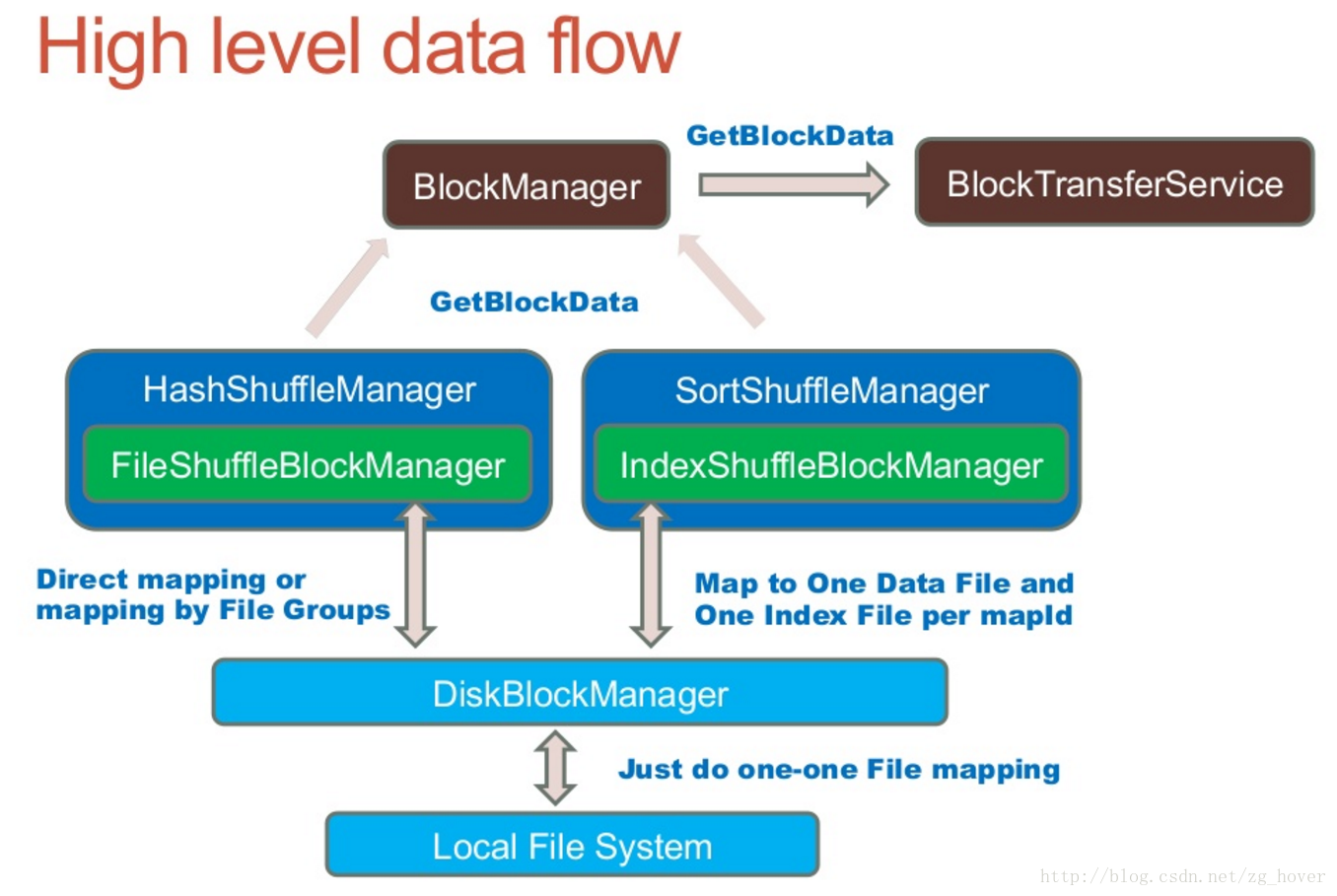

shuffle的体系结构

ShuffleManager接口

shuffleManager是spark的shuffle系统的可插拔接口。ShuffleManager将会在driver和每个executor上的SparkEnv中进行创建。可以通过参数spark.shuffle.manager进行设置。

driver通过ShuffleManager来注册shuffle,并且executor通过它来读取和写入数据。

ShuffleWriter

控制shuffle数据输出逻辑。

ShuffleReader

获取shuffle过程中用于ShuffleRDD的数据。

ShuffleBlockManager

管理抽象的bucket和计算数据块之间的mapping过程。

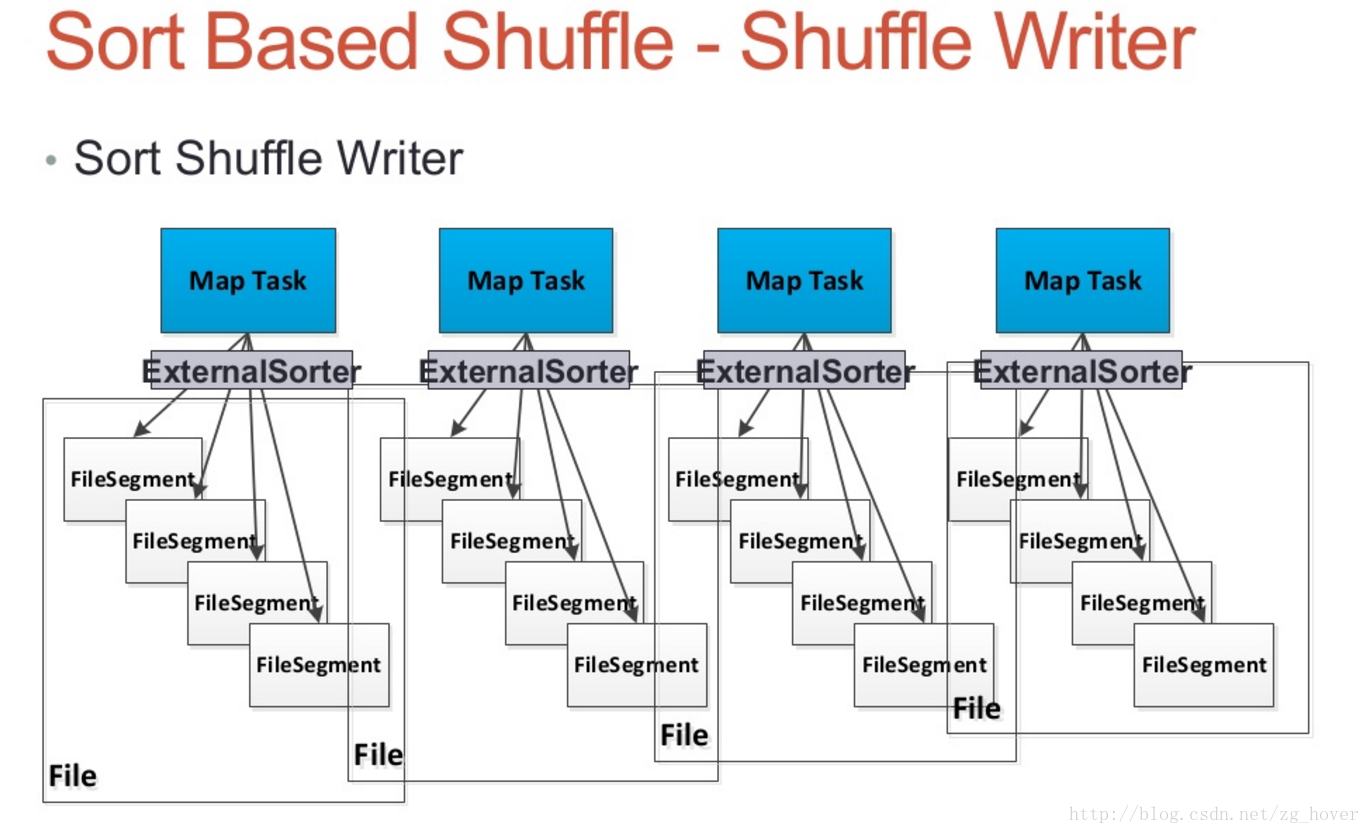

基于sort的shuffle

sort-based的shuffle,会把输入的记录根据目标分区id(partition ids)进行排序。然后写入单个的map输出文件中。为了读取map的输出部分,Reducers获取此文件的连续区域 。当map输出的数据太大而内存无法存放时,输出的排序子集可以保存到磁盘,这些磁盘文件被合并后,生成最终的输出文件。

sort shuffle有两个不同的输出路径来产生map的输出文件:

- 序列化排序(Serialized sorting)

在使用序列化排序时,需要满足以下3个条件:- shuffle不指定聚合(aggregation)或输出排序方法。

- shuffle的序列化程序支持序列化值的重定位(KryoSerializer和Spark SQL的自定义序列化程序目前支持此操作)。

- shuffle产生小于16777216个输出分区。

- 反序列化排序(Deserialized sorting)

用来处理所有其他情况。

Sort Shuffle Manager

Sort Shuffle Writer

- 每个map任务都会产生一个shuffle数据文件,和一个Index文件

- 通过外部排序类ExternalSorter对数据进行排序

- 若map-side需要进行合并(combine)操作,数据将会按key和分区进行排序,若没有合并操作数据只会根据分区进行排序。

Spark-2.0原理分析-shuffle过程的更多相关文章

- Spark之Task原理分析

在Spark中,一个应用程序要想被执行,肯定要经过以下的步骤: 从这个路线得知,最终一个job是依赖于分布在集群不同节点中的task,通过并行或者并发的运行来完成真正的工作.由此可见 ...

- 小记--------spark的worker原理分析及源码分析

- Struts1.2,struts2.0原理分析

struts1原理: 1.首先我们表单提交到action 2.进入到web.xml 3.web.xml拦截*.do 4.交给ActionServlet 5.找到path属性,获得url 6.找到nam ...

- 小记--------spark内核架构原理分析

首先会将jar包上传到机器(服务器上) 1.在这台机器上会产生一个Application(也就是自己的spark程序) 2.然后通过spark-submit(shell) 提交程序 ...

- 彻底搞懂spark的shuffle过程(shuffle write)

什么时候需要 shuffle writer 假如我们有个 spark job 依赖关系如下 我们抽象出来其中的rdd和依赖关系: E <-------n------, ...

- Spark Shuffle 过程

本文参考:http://www.cnblogs.com/cenyuhai/p/3826227.html 在数据流动的整个过程中,最复杂最影响性能的环节,就是 Shuffle 过程,本文将参考大神的博客 ...

- Hadoop计算中的Shuffle过程(转)

Hadoop计算中的Shuffle过程 作者:左坚 来源:清华万博 时间:2013-07-02 15:04:44.0 Shuffle过程是MapReduce的核心,也被称为奇迹发生的地方.要想理解Ma ...

- spark的shuffle和原理分析

概述 Shuffle就是对数据进行重组,由于分布式计算的特性和要求,在实现细节上更加繁琐和复杂. 在MapReduce框架,Shuffle是连接Map和Reduce之间的桥梁,Map阶段 ...

- Spark的RDD原理以及2.0特性的介绍

转载自:http://www.tuicool.com/articles/7VNfyif 王联辉,曾在腾讯,Intel 等公司从事大数据相关的工作.2013 年 - 2016 年先后负责腾讯 Yarn ...

随机推荐

- 《转载》Linux服务之搭建FTP服务器&&分布式文件服务器的比较

参考帖子: Linux服务之FTP vsftpd的使用 大型网站图片服务器架构的演进 rsync同步文件的艺术 rsync命令详解 深入理解Tomcat虚拟目录 (测试已经OK)

- 启用PAE后虚拟地址到物理地址的转换

34 注册:2013-10 帖子:2013 精华:34 --> [原创]启用PAE后虚拟地址到物理地址的转换 安于此生 2013-11-3 20:54 16073 由常规的两级页表转换得不到 ...

- Eclipse配色方案插件

Eclipse配色方案插件 真漂亮! 最近发现了一个Eclipse配色方案插件,这回给Eclipse配色太方便了. 插件主页:http://eclipsecolorthemes.org/ 插件提供了上 ...

- Cmd find命令 和 findstr 命令

https://blog.csdn.net/icanlove/article/details/37567591 Windows CMD中 find命令(字符串查找) https://blog.cs ...

- Kafka+Storm+HDFS 整合示例

消息通过各种方式进入到Kafka消息中间件,比如可以通过使用Flume来收集日志数据,然后在Kafka中路由暂存,然后再由实时计算程序Storm做实时分析,最后将结果保存在HDFS中,这时我们就需要将 ...

- 安装ORACLE_RAC遇到的问题与解决方法

while running: /u01/app/oracle/product/10.2.0/db_1/root.sh Checking to see if Oracle CRS stack is al ...

- PS-CC常用快捷键总结

灵活使用photoshop软件快捷键是学好该软件的基础,ps快捷键对于ps平时操作有很大帮助 熟练掌握ps的快捷键可以为了处理图片节省很多时间.现在笔者将自己平时常用的快捷键总结如下: 移动工具[V] ...

- 解决-Dmaven.multiModuleProjectDirectory system property is not set. Check $M2_HOME environment variabl

1.添加M2_HOME的环境变量 2.Preference->Java->Installed JREs->Edit 选择一个jdk, 添加 -Dmaven.multiModuleP ...

- [工具] 将Sublime Text 3配置为Java代码编辑器

新建编译器选项 选择菜单栏中的 Tools ——> Build System ——> New Build System ,输入: { "cmd": ["jav ...

- python中的null值

在一个没有接口文档的自动化测试中,只能通过抓包及查日志查看发送的信息,其中有一个接口发送的信息如下: enable_snapshot": true, "new_size" ...