Python爬虫连载1-urllib.request和chardet包使用方式

一、参考资料

1.《Python网络数据采集》图灵工业出版社

2.《精通Python爬虫框架Scrapy》人民邮电出版社

3.[Scrapy官方教程](http://scrapy-chs.readthedocs.io/zh_CN/0.24/intro/tutorial.html)

4.[Python3网络爬虫](http://blog.csdn.net/c406495762/article/details/72858983

二、前提知识

url、http协议、web前端:html\CSS\JS、ajax、re、Xpath、xml

三、基础知识

1.爬虫简介

爬虫定义:网络爬虫(又被称为网页蜘蛛、网络机器人、在FOAF社区中,更经常的称为网页追逐者)是一种按照一定的规则,自动的抓取万维网信息的程序或者脚本。两外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者如蠕虫。

2.两大特征

(1)能按作者要求下载数据或者内容

(2)能自动在网络上流窜

3.三大步骤

(1)下载网页;

(2)提取正确的信息

(3)根据一定规则自动跳到另外的网页上执行上两步内容

4.爬虫分类

(1)通用爬虫

(2)专用爬虫

5.Python网络包简介

Python2:urllib\urllib2\urllib3\httplib\httplib2\requests

Python3.x:urllib\urllib3\httplib2\requests

其中python2中urllib和urllib2配合使用,或者requests

Python3就是使用urllib.requests

6.urllib

包含模块

urllib.requests:打开和读取urls

urllib.error:包含urllib.requests产生的常见的错误,使用try捕捉

urllib.parse:包含即时url的方法

urllib.robotparse:解析roobs.txt文件

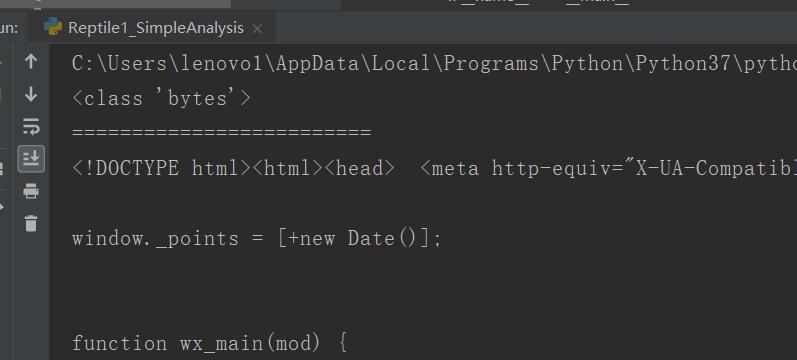

from urllib import request

"""

使用urllib,request请求一个网页内容,并把内容打印出来

"""

if __name__ == "__main__":

url = "https://mp.weixin.qq.com/cgi-bin/home?t=home/index&lang=zh_CN&token=984602018"

#打开相应的url并把相应页面作为返回

rsp = request.urlopen(url)

#返回结果读取出来

html = rsp.read()

print(type(html))##bytes类型

html = html.decode()

print(html)

7.网页编码解析方式chardet包的使用

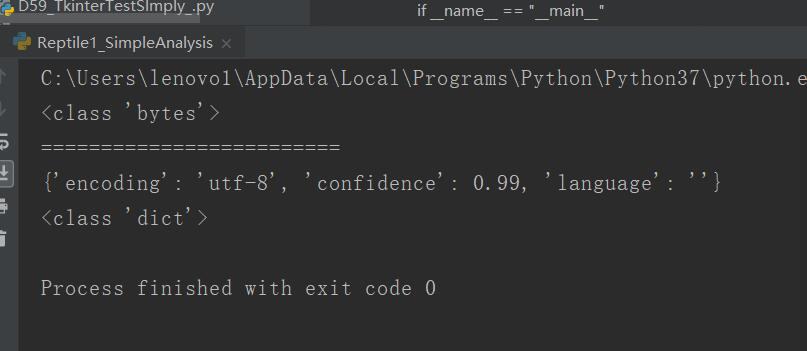

from urllib import request

import chardet

"""

使用urllib,request请求一个网页内容,并把内容打印出来

"""

if __name__ == "__main__":

url = "https://mp.weixin.qq.com/cgi-bin/home?t=home/index&lang=zh_CN&token=984602018"

#打开相应的url并把相应页面作为返回

rsp = request.urlopen(url)

#返回结果读取出来

html = rsp.read()

print(type(html))##bytes类型

print("=========================")

cs = chardet.detect(html)#利用chardet来检测这个网页使用的是什么编码方式

print(cs)

print(type(cs))

#使用get方法是为了避免如果取不到值报错,程序就崩溃了

html = html.decode(cs.get("encoding","utf-8"))#取cs字典中encoding属性,如果取不到,那么就使用utf-8

四、源码

Reptile1_SimpleAnalysis.py

https://github.com/ruigege66/PythonReptile/blob/master/Reptile1_SimpleAnalysis.py

2.CSDN:https://blog.csdn.net/weixin_44630050(心悦君兮君不知-睿)

3.博客园:https://www.cnblogs.com/ruigege0000/

4.欢迎关注微信公众号:傅里叶变换,个人公众号,仅用于学习交流,后台回复”礼包“,获取大数据学习资料

Python爬虫连载1-urllib.request和chardet包使用方式的更多相关文章

- Python爬虫入门之Urllib库的高级用法

1.设置Headers 有些网站不会同意程序直接用上面的方式进行访问,如果识别有问题,那么站点根本不会响应,所以为了完全模拟浏览器的工作,我们需要设置一些Headers 的属性. 首先,打开我们的浏览 ...

- Python爬虫入门之Urllib库的基本使用

那么接下来,小伙伴们就一起和我真正迈向我们的爬虫之路吧. 1.分分钟扒一个网页下来 怎样扒网页呢?其实就是根据URL来获取它的网页信息,虽然我们在浏览器中看到的是一幅幅优美的画面,但是其实是由浏览器解 ...

- 【学习笔记】第二章 python安全编程基础---python爬虫基础(urllib)

一.爬虫基础 1.爬虫概念 网络爬虫(又称为网页蜘蛛),是一种按照一定的规则,自动地抓取万维网信息的程序或脚本.用爬虫最大的好出是批量且自动化得获取和处理信息.对于宏观或微观的情况都可以多一个侧面去了 ...

- Python爬虫基础之Urllib

一.随时随地爬取一个网页下来 怎么爬取网页?对网站开发了解的都知道,浏览器访问Url向服务器发送请求,服务器响应浏览器请求并返回一堆HTML信息,其中包括html标签,css样式,js脚本等.Chro ...

- PYTHON 爬虫笔记二:Urllib库基本使用

知识点一:urllib的详解及基本使用方法 一.基本介绍 urllib是python的一个获取url(Uniform Resource Locators,统一资源定址器)了,我们可以利用它来抓取远程的 ...

- Python爬虫实践~BeautifulSoup+urllib+Flask实现静态网页的爬取

爬取的网站类型: 论坛类网站类型 涉及主要的第三方模块: BeautifulSoup:解析.遍历页面 urllib:处理URL请求 Flask:简易的WEB框架 介绍: 本次主要使用urllib获取网 ...

- Python爬虫连载2-reponse\parse简介

一.reponse解析 urlopen的返回对象 (1)geturl:返回网页地址 (2)info:请求反馈对象的meta信息 (3)getcode:返回的http code from urllib ...

- python爬虫起步...开发环境搭建,最简单的方式

研究一门编程语言,一般第一步就是配置安装部署相关的编程环境.我认为啊,在学习的初期,大家不是十分了解相关的环境,或者是jar包,python模块等的相关内容,就不需要花费大量的时间去研究如何去安装它. ...

- Python爬虫连载3-Post解析、Request类

一.访问网络的两种方法 1.get:利用参数给服务器传递信息:参数为dict,然后parse解码 2.post:一般向服务器传递参数使用:post是把信息自动加密处理:如果想要使用post信息,需要使 ...

随机推荐

- 0108 spring的申明式事务

背景 互联网的金融和电商行业,最关注数据库事务. 业务核心 说明 金融行业-金融产品金额 不允许发生错误 电商行业-商品交易金额,商品库存 不允许发生错误 面临的难点: 高并发下保证: 数据一致性,高 ...

- HDU 5501:The Highest Mark 01背包

The Highest Mark Accepts: 71 Submissions: 197 Time Limit: 2000/1000 MS (Java/Others) Memory Limi ...

- R语言 plot()函数 基础用法

plot(x=x轴数据,y=y轴数据,main="标题",sub="子标题",type="线型",xlab="x轴名称" ...

- 百度easydl之图像分类构建是否佩戴口罩模型

2020-02-14 今天试了下百度esaydl的图像分类方面的功能,其优点是主需要上传自己的数据集,不需要关注模型训练,就可以得到相应的结果.最后得到的模型可以调用云api在本地进行运行. 网址:h ...

- Essay写作如何提升自己的辩驳水平?

辩证思维在英文写作上的表现方式有许多种,今天来讲讲Counterargument&Rebut,广泛用于英文写作和口语辩论.其作用就是通过辩驳和你论点相反的意见,来突出自己的论点更正确. 话说衡 ...

- vue学习(八)nextTick[异步更新队列]的使用和应用

nextTick的使用 为了数据变化之后等待vue完成更新DOM,可以在数据变化之后立即使用Vue.nextTick()在当前的回调函数中能获取最新的DOM <div id="app& ...

- Linux基础命令-02

Linux基础命令-02:

- python -- 犯过的错之变量作用域

1.写代码时发现取得变量值,会被覆盖,改为图二的写法后case_id则不会覆盖. 原因:可以理解为变量是内存中一个对象的“引用”.在函数参数传值时,变量也是内存对象的引用. 当对象为可更改对象时,是引 ...

- oracle中设置主键

1.创建表 .创建表 create table "c_user"( "id" number primary key, "username" ...

- php条件判断(9.29 第十五天)

超级全局变量:$GLOBALS //包含全部变量的全局组合数组$_SERVER //包含请求头中的信息,用户的IP.用户的UA.头信息$_REQUEST //包含用户提交的所有数据(POST/GET ...