Hugging News #0602: Transformers Agents 介绍、大语言模型排行榜发布!

每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」,本期 Hugging News 有哪些有趣的消息,快来看看吧!

重磅更新

Transformers Agents 发布,通过自然语言控制超过十多万个 HF 模型!

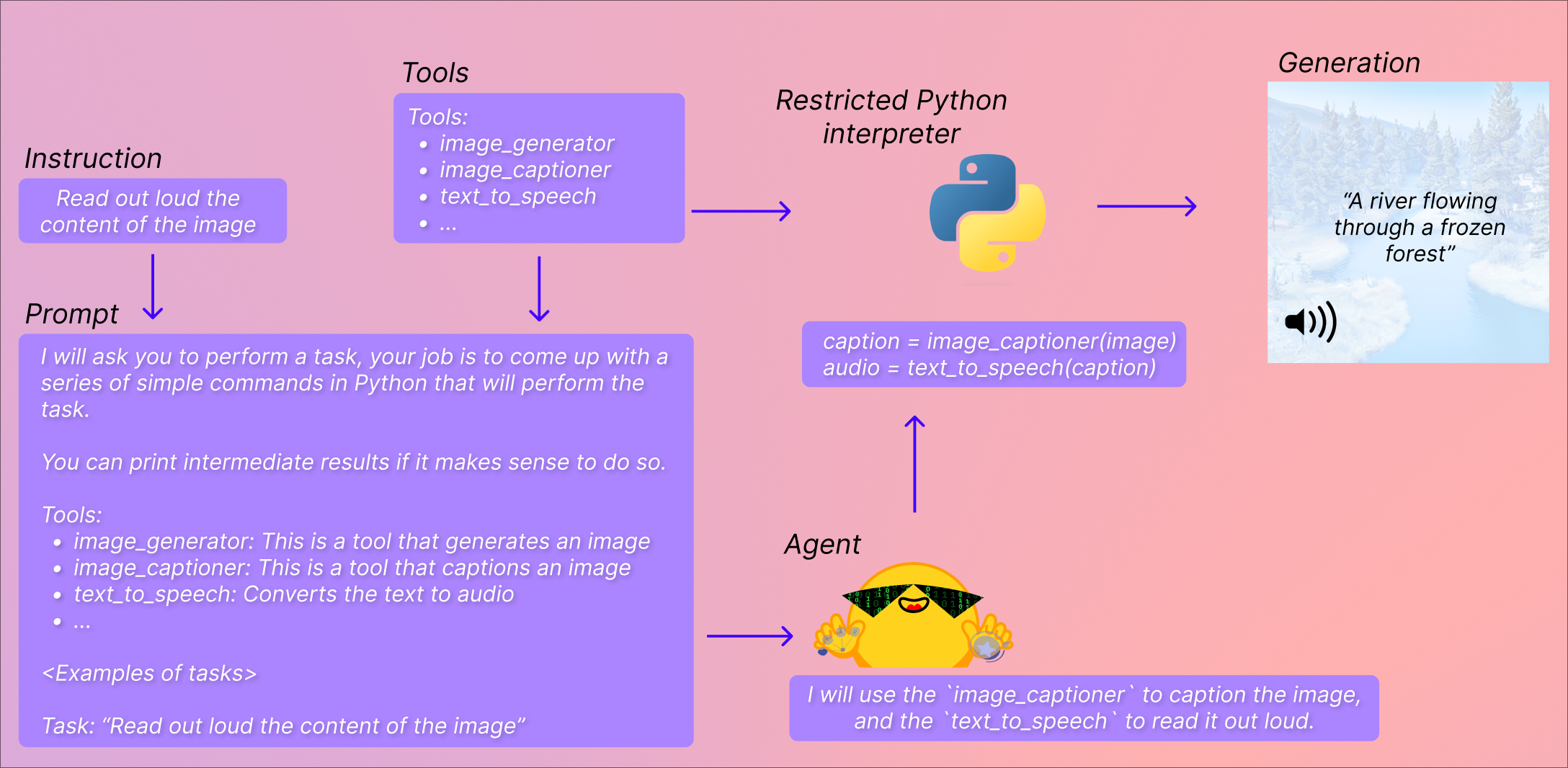

近期,我们发布了一个非常“大胆”的新特性: Transformers Agents,并加入到了 Transformers 4.29 之后的版本中。它在 Transformers 的基础上提供了一个自然语言 API,来 “让 Transformers 可以做任何事情”。这其中有两个概念:一个是 Agent (代理),另一个是 Tools (工具),我们定义了一系列默认的工具,让代理去理解自然语言并使用这些工具:

https://hf.co/docs/transformers/transformers_agents

代理这里指的是大语言模型 (LLM),你可以选择使用 OpenAI 的模型 (需要提供密钥),或者开源的 StarCoder 和 OpenAssistant 的模型,我们会提示让代理去访问一组特定的工具。

工具指的是一个个单一的功能,我们定义了一系列工具,然后使用这些工具的描述来提示代理,并展示它将如何利用工具来执行查询中请求的内容。

我们在 transformers 中集成的工具包括:文档问答、文本问答、图片配文、图片问答、图像分割、语音转文本、文本转语音、零样本文本分类、文本摘要、翻译等。不过你也可以扩展这些一些与 transformers 无关的工具,比如从网络读取文本等:

https://hf.co/docs/transformers/custom_tools

辅助生成 (Assisted Generation) 发布: 将低延迟文本生成付诸实践,本地大语言模型助手不是梦!

大语言模型目前广受欢迎,但其响应速度的缓慢限制了其用户体验。对于需要快速反应的任务,人们通常使用规模较小的模型,但这会牺牲结果质量。文本生成的延迟主要来自于模型的前向传递步骤,即模型权重加载到设备计算核心的过程,我们的一篇博文介绍了一种新的解码方法,通过这种辅助生成方法,硬件中的延迟可以降低多达 10 倍。此外,还可以通过模型优化和输入批处理来改善模型前向传递的性能问题。

欢迎阅读中文博客内容 (微信版):

https://huggingface.co/blog/zh/assisted-generation

以及这个 Space 应用:

https://hf.co/spaces/joaogante/assisted_generation_demo

开源更新

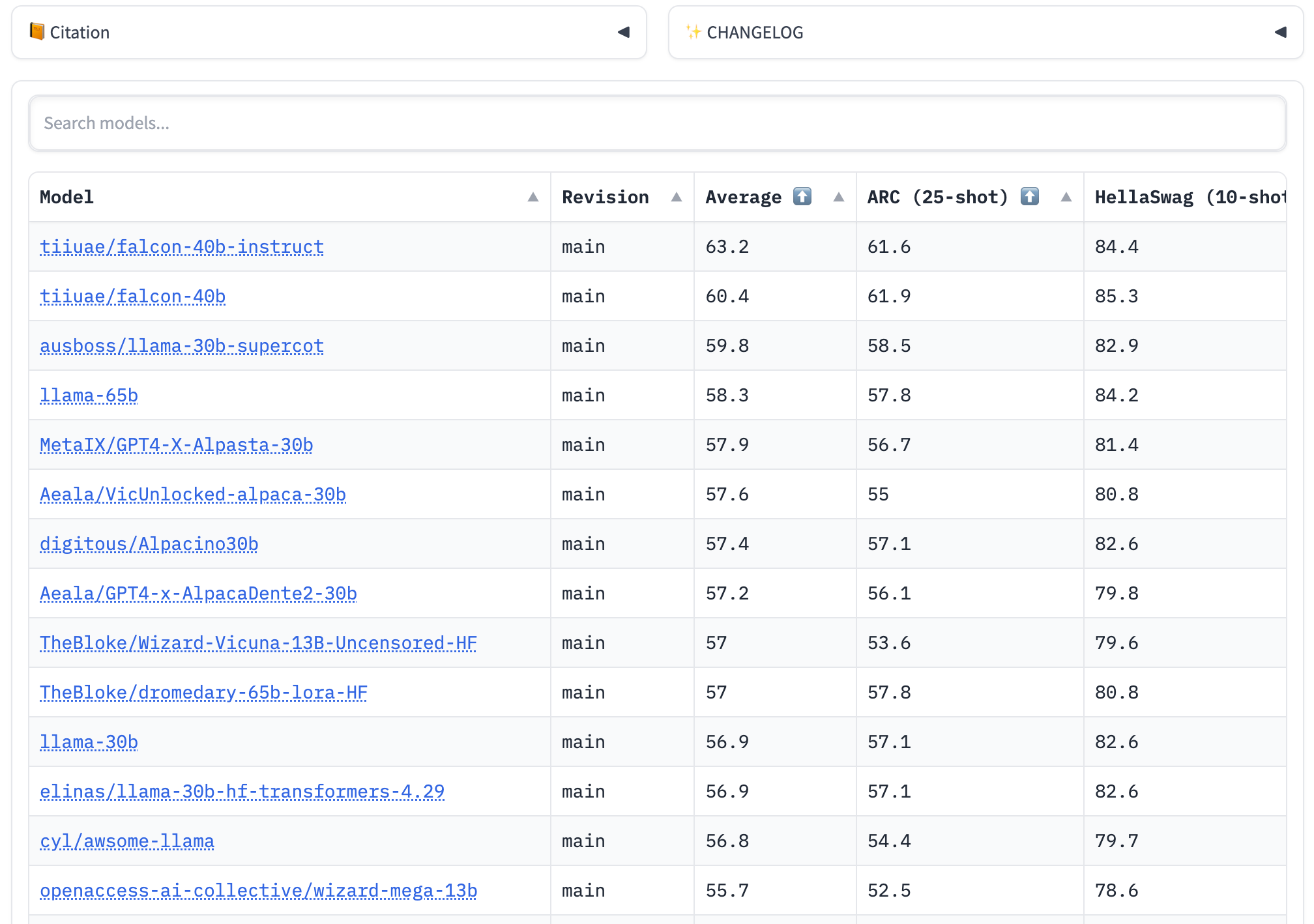

开放的开源大语言模型排行榜

每周都有大量的大型语言模型 (LLM) 和各种聊天机器人发布,令人眼花缭乱~ 我们制作了一个开放的大语言模型排行版,主要目标是跟踪、排名和评估最新的大语言模型和聊天机器人,让所有人方便的观察到开源社区的进展和评估这些模型。这个排行榜有一个关键优势,社区中的任何成员都可以提交模型,并在 Hugging Face 的 GPU 集群上自动评估。

你可以在这里看到这个排行榜:

https://hf.co/spaces/HuggingFaceH4/open_llm_leaderboard

Woodstock of AI 活动回顾视频

回顾我们在 3 月底在旧金山举办的 AI 社区会议:

Hugging News #0602: Transformers Agents 介绍、大语言模型排行榜发布!的更多相关文章

- 使用 LoRA 和 Hugging Face 高效训练大语言模型

在本文中,我们将展示如何使用 大语言模型低秩适配 (Low-Rank Adaptation of Large Language Models,LoRA) 技术在单 GPU 上微调 110 亿参数的 F ...

- Hugging News #0324: 🤖️ 黑客松结果揭晓、一键部署谷歌最新大语言模型、Gradio 新版发布,更新超多!

每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新.社区活动.学习资源和内容更新.开源库和模型更新等,我们将其称之为「Hugging Ne ...

- 保姆级教程:用GPU云主机搭建AI大语言模型并用Flask封装成API,实现用户与模型对话

导读 在当今的人工智能时代,大型AI模型已成为获得人工智能应用程序的关键.但是,这些巨大的模型需要庞大的计算资源和存储空间,因此搭建这些模型并对它们进行交互需要强大的计算能力,这通常需要使用云计算服务 ...

- pytorch在有限的资源下部署大语言模型(以ChatGLM-6B为例)

pytorch在有限的资源下部署大语言模型(以ChatGLM-6B为例) Part1知识准备 在PyTorch中加载预训练的模型时,通常的工作流程是这样的: my_model = ModelClass ...

- 本地推理,单机运行,MacM1芯片系统基于大语言模型C++版本LLaMA部署“本地版”的ChatGPT

OpenAI公司基于GPT模型的ChatGPT风光无两,眼看它起朱楼,眼看它宴宾客,FaceBook终于坐不住了,发布了同样基于LLM的人工智能大语言模型LLaMA,号称包含70亿.130亿.330亿 ...

- 大语言模型快速推理: 在 Habana Gaudi2 上推理 BLOOMZ

本文将展示如何在 Habana Gaudi2 上使用 Optimum Habana.Optimum Habana 是 Gaudi2 和 Transformers 库之间的桥梁.本文设计并实现了一个大模 ...

- LLM(大语言模型)解码时是怎么生成文本的?

Part1配置及参数 transformers==4.28.1 源码地址:transformers/configuration_utils.py at v4.28.1 · huggingface/tr ...

- FileOutputStream字节输出流和FileInputStream输入流(切记:out是输出到本地中,in是输入到程序中)这里介绍大文件和小文件的读取方式

//FileOutputStream public class FileOutputStreamDemo { /**字节流:适用于任何文件,以字节为单位,进行读写操作 *字节流操作步骤: *1.创 ...

- ILLA Cloud: 调用 Hugging Face Inference Endpoints,开启大模型世界之门

一个月前,我们 宣布了与 ILLA Cloud 与达成的合作,ILLA Cloud 正式支持集成 Hugging Face Hub 上的 AI 模型库和其他相关功能. 今天,我们为大家带来 ILLA ...

- HTML5小游戏《智力大拼图》发布,挑战你的思维风暴

一,前言 本 游戏 是鄙人研究lufylegend数日之后,闲暇之余写下的.本游戏运用全新的技术 html 5写成的.游戏引擎为国产的lufylegend.js,大家可以去它的官网看看.游戏处于测 ...

随机推荐

- 关于springboot使用mybatis查询出现空指针,以及debug出现All Elements all Null的解决方法

数据库中命名方式是带有下划线 ,然后在实体类中使用的是驼峰命名法 ,那么就需要在application.yml文件中加上 自闭了,那么简单的问题,没了解过真是摸不着头脑

- Java面试——Spring Boot

更多内容,移步IT-BLOG 一.谈谈你对 SpringBoot 的理解 简单说说我的理解:Java是一个静态语言,相比动态语言,它相对笨重,体现在我们搭建 SSM 框架写一个 Helloword 的 ...

- 探究for循环中的var与let的区别

首先饮用一篇大佬写的博客:for循环中let与var的区别,块级作用域如何产生与迭代中变量i如何记忆上一步的猜想 这篇博客对我有所启发,但是有点抽象. 再借用<JavaScript高级程序设计& ...

- 第三章3.1HTML技术与CSS技术

web中的html以及css: html(超文本标记语言:Hyper Text Markup Language):用于描述网页的一种语言: 通常其根标签使用html标签:使用尖括号表示:<htm ...

- 超全 泛微 E9 Ecology 9开发资料大全 开源资源下载 泛微E9二次开发 泛微开发实战经验 泛微开发实战例子 泛微二次开发项目例子 泛微二次开发Demo 泛微二次开发完整例子 泛微二次开发入门

由于工作需要,E9在泛微一推出来,以前所在的企业就第一时间上线了,经过四年多的运行,功能强大再加上在上面开发非常多的业务,一般的企业员工只需要打开泛微就可以处理完平时信息化的业务.后来又去外包公司专业 ...

- 机器学习(五):混合高斯聚类(求聚类标签)+PCA降维(3维降2维)习题

使用混合高斯模型 GMM,计算如下数据点的聚类过程: \(Data = np.array([1,2,6,7])\) 均值初值为: \(\mu_1, \mu_2 = 1, 5\) 权重初值为: \(w_ ...

- 19.13备库duplicate恢复新主库(二)

问题描述:主备两个库不在同一个机房,此时想从这一套库中在复制一套可读可写的新库出来.网络带宽要求比较高,需要从备库中使用备份在起一个新库,也要测试下使用duplicate从备库能够在复制一个新库.经过 ...

- python:selenium爬取boss网站被关小黑屋

问题描述:使用selenium访问次数过多,被boss反爬封掉IP,这种方式有什么好一点的解决方法,首次可以用图形验证解封,今天访问次数过多,被关进了小黑屋 首次让我用图形界面解封 不过还好,手动解封 ...

- Go语言微服务框架go-micro(入门)

Micro用于构建和管理分布式系统,是一个工具集,其中go-micro框架是对分布式系统的高度抽象,提供分布式系统开发的核心库,可插拔的架构,按需使用 简单示例 编写protobuf文件: synta ...

- boot-admin整合flowable官方editor-app进行BPMN2.0建模

正所谓百家争鸣.见仁见智.众说纷纭.各有千秋!在工作流bpmn2.0可视化建模工具实现的细分领域,网上扑面而来的是 bpmn.js 这个渲染工具包和web建模器,而笔者却认为使用flowable官方开 ...