Scrapy教程--豆瓣电影图片爬取

一、先上效果

二、安装Scrapy和使用

官方网址:https://scrapy.org/。

安装命令:pip install Scrapy

安装完成,使用默认模板新建一个项目,命令:scrapy startproject xx

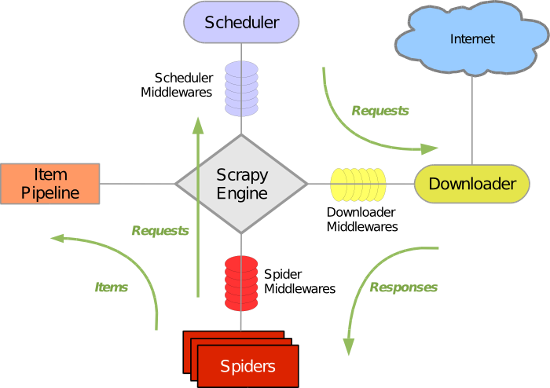

上图很形象的说明了,scrapy的运行机制。具体各部分的含义和作用,可自行百度,这里不再赘述。我们一般,需要做的是以下步骤。

1)配置settings,其他配置可根据自己的要求查看文档配置。

DEFAULT_REQUEST_HEADERS = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.10 Safari/537.36'

}

DOWNLOAD_TIMEOUT = 30

IMAGES_STORE = 'Images'

2)定义items类,相当于Model类。如:

class CnblogImageItem(scrapy.Item):

image = scrapy.Field()

imagePath = scrapy.Field()

name = scrapy.Field()

3)配置下载中间件,下载中间件的作用是自定义,怎么发请求。一般有处理代理的中间件、PhantomJs的中间件等。这里,我们只用到代理中间件。

class GaoxiaoSpiderMiddleware(object):

def process_request(self, request, spider):

if len(request.flags) > 0 and request.flags[0] == 'img':

return None

driver = webdriver.PhantomJS()

# 设置全屏

driver.maximize_window()

driver.get(request.url)

content = driver.page_source

driver.quit()

return HtmlResponse(request.url, encoding='utf-8', body=content)

class ProxyMiddleWare(object):

def process_request(self, request, spider):

request.meta['proxy'] = 'http://175.155.24.103:808'

4)编写pipeline,作用是处理从Spider中传过来的item,保存excel、数据库、下载图片等。这里给出我的下载图片代码,使用的是官方的下载图片框架。

class CnblogImagesPipeline(ImagesPipeline):

IMAGES_STORE = get_project_settings().get("IMAGES_STORE") def get_media_requests(self, item, info):

image_url = item['image']

if image_url != '':

yield scrapy.Request(str(image_url), flags=['img']) def item_completed(self, result, item, info):

image_path = [x["path"] for ok, x in result if ok] if image_path:

# 重命名

if item['name'] != None and item['name'] != '':

ext = os.path.splitext(image_path[0])[1]

os.rename(self.IMAGES_STORE + '/' +

image_path[0], self.IMAGES_STORE + '/' + item['name'] + ext)

item["imagePath"] = image_path

else:

item['imagePath'] = ''

return item

5)编写自己的Spider类,Spider的作用是配置一些信息、起始url请求、处理响应数据。这里的下载中间件配置、pipeline,可以放在settings文件中。这里我放在,各自的Spider中,因为项目中包含多个Spider,相互之间用的下载中间件不同,因此分开配置了。

# coding=utf-8

import sys

import scrapy

import gaoxiao.items

import json

reload(sys)

sys.setdefaultencoding('utf-8') class doubanSpider(scrapy.Spider):

name = 'douban'

allowed_domains = ['movie.douban.com']

baseUrl = 'https://movie.douban.com/j/search_subjects?type=movie&tag=%E7%83%AD%E9%97%A8&sort=recommend&page_limit=20&page_start='

start = 0

start_urls = [baseUrl + str(start)]

custom_settings = {

'DOWNLOADER_MIDDLEWARES': {

'gaoxiao.middlewares.ProxyMiddleWare': 1,

# 'gaoxiao.middlewares.GaoxiaoSpiderMiddleware': 544

},

'ITEM_PIPELINES': {

'gaoxiao.pipelines.CnblogImagesPipeline': 1,

}

} def parse(self, response):

data = json.loads(response.text)['subjects']

for i in data:

item = gaoxiao.items.CnblogImageItem()

if i['cover'] != '':

item['image'] = i['cover']

item['name'] = i['title']

else:

item['image'] = ''

yield item

if self.start < 400:

self.start += 20

yield scrapy.Request(self.baseUrl + str(self.start), callback=self.parse)

Scrapy教程--豆瓣电影图片爬取的更多相关文章

- 豆瓣电影信息爬取(json)

豆瓣电影信息爬取(json) # a = "hello world" # 字符串数据类型# b = {"name":"python"} # ...

- Python爬虫入门教程 8-100 蜂鸟网图片爬取之三

蜂鸟网图片--啰嗦两句 前几天的教程内容量都比较大,今天写一个相对简单的,爬取的还是蜂鸟,依旧采用aiohttp 希望你喜欢 爬取页面https://tu.fengniao.com/15/ 本篇教程还 ...

- Python爬虫入门教程 6-100 蜂鸟网图片爬取之一

1. 蜂鸟网图片--简介 国庆假日结束了,新的工作又开始了,今天我们继续爬取一个网站,这个网站为 http://image.fengniao.com/ ,蜂鸟一个摄影大牛聚集的地方,本教程请用来学习, ...

- Python爬虫入门教程 7-100 蜂鸟网图片爬取之二

蜂鸟网图片--简介 今天玩点新鲜的,使用一个新库 aiohttp ,利用它提高咱爬虫的爬取速度. 安装模块常规套路 pip install aiohttp 运行之后等待,安装完毕,想要深造,那么官方文 ...

- Python爬虫入门教程 5-100 27270图片爬取

27270图片----获取待爬取页面 今天继续爬取一个网站,http://www.27270.com/ent/meinvtupian/ 这个网站具备反爬,so我们下载的代码有些地方处理的也不是很到位, ...

- Python爬虫入门教程: 27270图片爬取

今天继续爬取一个网站,http://www.27270.com/ent/meinvtupian/ 这个网站具备反爬,so我们下载的代码有些地方处理的也不是很到位,大家重点学习思路,有啥建议可以在评论的 ...

- 豆瓣电影top250爬取并保存在MongoDB里

首先回顾一下MongoDB的基本操作: 数据库,集合,文档 db,show dbs,use 数据库名,drop 数据库 db.集合名.insert({}) db.集合名.update({条件},{$s ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

- 第一个nodejs爬虫:爬取豆瓣电影图片

第一个nodejs爬虫:爬取豆瓣电影图片存入本地: 首先在命令行下 npm install request cheerio express -save; 代码: var http = require( ...

随机推荐

- 【web】之 jquery上传插件的Plupload的使用

首先下载plupload->http://www.plupload.com 因为Plupload可配置参数比较多,所以这里讲解最常用的,结合jquery-ui展示的界面!如下: Plupload ...

- POJ 3261 出现至少K次的可重叠最长子串

题意就是给一列数字,求最长的一个子串,并且满足子串在原数串中出现至少K次,子串可以重叠. 解法是将问题转为判定性问题,二分子串的长度,判定是否满足重复至少K次.判定方法是经典的根据子串长度将Heigh ...

- [进程通信] Linux进程间通信(IPC)

简介 linux下进程间通信的几种主要手段: 1. 管道(Pipe)及有名管道(named pipe):管道可用于具有亲缘关系进程间的通信,有名管道克服了管道没有名字的限制,因此,除具有管道 ...

- iOS开发 - Swift使用GCD实现计时器功能

前言 开发中,经常会用到定时执行网络请求.倒计时.计时器等功能,本篇文章介绍在iOS开发中,Swift怎样使用GCD实现这些功能. 执行一次 下面的代码将会在5秒后执行,且只执行一次. let tim ...

- springcloud(一):大话Spring Cloud

研究了一段时间spring boot了准备向spirng cloud进发,公司架构和项目也全面拥抱了Spring Cloud.在使用了一段时间后发现Spring Cloud从技术架构上降低了对大型系统 ...

- unity 本地帮助文档 慢

unity ,打开本地帮助文档时,有时会加载很慢,主要原因是网页里嵌入了访问google的代码.解决办法:打开本地hosts文件,里面加入"127.0.0.1 fonts.googleapi ...

- hdu1166树状数组

C国的死对头A国这段时间正在进行军事演习,所以C国间谍头子Derek和他手下Tidy又开始忙乎了.A国在海岸线沿直线布置了N个工兵营地,Derek和Tidy的任务就是要监视这些工兵营地的活动情况.由于 ...

- PHP:基于百度大脑api实现OCR文字识别

有个项目要用到文字识别,网上找了很多资料,效果不是很好,偶然的机会,接触到百度大脑.百度大脑提供了很多解决方案,其中一个就是文字识别,百度提供了三种文字识别,分别是银行卡识别.身份证识别和通用文字识别 ...

- 玩一玩nodejs--一个简单的在线实时填表应用

学习nodejs三天,入了个门,感觉他和jsp.php还是存在较大的差别.本文首先复习这些天学的一些知识点,然后谈一下如何一步一步到做一个在线实时填表的小应用,进一步巩固一下这些个知识点.这里先简单介 ...

- hdu3652 B-number 数位DP

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=3652 题意就是求区间内能被13整除并且包含”13“的数字的个数 感觉是比较中等的数位DP题目 我用的记 ...