ELK:收集Docker容器日志

简介

- 之前写过一篇博客 ELK:日志收集分析平台,介绍了在Centos7系统上部署配置使用ELK的方法,随着容器化时代的到来,容器化部署成为一种很方便的部署方式,收集容器日志也成为刚需。本篇文档从 容器化部署ELK系统,收集容器日志,自动建立项目索引,ElastAlert日志监控报警,定时删除过期日志索引文件 这几个方面来介绍ELK。

- 大部分配置方法多是看官方文档,理解很辛苦,查了很多文章,走了很多弯路,分享出来,希望让有此需求的朋友少走弯路,如有错误或理解不当的地方,请批评指正。

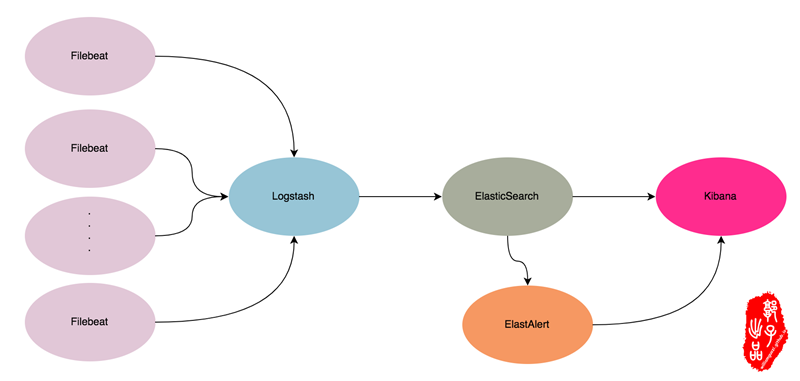

- 逻辑结构如下图

ELK之容器日志收集及索引建立

- Docker环境下,拉取官方镜像,官方镜像地址 Docker @ Elastic

docker pull docker.elastic.co/elasticsearch/elasticsearch:6.6.2

docker pull docker.elastic.co/kibana/kibana:6.6.2

docker pull docker.elastic.co/beats/filebeat:6.6.2

docker pull docker.elastic.co/logstash/logstash:6.6.2

Elasticsearch 容器部署

Elasticsearch 启动命令说明

- 启动两个端口,9200为数据查询和写入端口,也即是业务端口,9300为集群端口,同步集群数据,此处我单节点部署

- 指定日志输出格式为json格式,默认情况下也为json格式,默认输出路径

/var/lib/docker/containers/*/*.log - 日志文件最多保留三个,每个最多10M

- 容器开机自启

- 传递参数为单节点部署

- 数据存储映射至宿主机

- 需要给

/data/elasticsearch赋予权限,否则报权限不足的错误

docker run -d \

--user root \

-p 127.0.0.1:9200:9200 \

-p 9300:9300 \

--log-driver json-file \

--log-opt max-size=10m \

--log-opt max-file=3 \

--name elasticsearch \

--restart=always \

-e "discovery.type=single-node" \

-v /data/elasticsearch:/usr/share/elasticsearch/data \

docker.elastic.co/elasticsearch/elasticsearch:6.6.2

chmod 777 -R /data/elasticsearch

Logstash 容器部署

Logstash 配置文件说明

- 配置文件映射至至宿主机

match => { "message" => "%{TIMESTAMP_ISO8601:log-timestamp} %{LOGLEVEL:log-level} %{JAVALOGMESSAGE:log-msg}" }将日志做简单拆分, 时间戳重命名为log-timestamp,日志级别重命名为log-msg,如果拆分成功输出日志中就会产生这两个字段- 通过

remove_field => ["beat"]移除无用字段 - 输出到elasticsearch

- 索引通过 容器名称-时间 建立

mkdir -pv /data/conf

cat > /data/conf/logstash.conf << "EOF"

input {

beats {

host => "0.0.0.0"

port => "5043"

}

}

filter {

grok {

match => { "message" => "%{TIMESTAMP_ISO8601:log-timestamp} %{LOGLEVEL:log-level} %{JAVALOGMESSAGE:log-msg}" }

}

mutate {

# remove_field => ["message"]

remove_field => ["beat"]

}

}

output {

stdout { codec => rubydebug }

elasticsearch {

hosts => [ "elasticsearch:9200" ]

index => "%{containername}-%{+YYYY.MM.dd}"

}

}

EOF

Logstash 启动命令说明

- 通过

--link elasticsearch连接elasticsearch容器,并生成环境变量在容器中使用 - 配置文件映射如容器

docker run -p 5043:5043 -d \

--user root \

--log-driver json-file \

--log-opt max-size=10m \

--log-opt max-file=3 \

--name logstash \

--link elasticsearch \

--restart=always \

-v /data/conf/logstash.conf:/usr/share/logstash/pipeline/logstash.conf \

docker.elastic.co/logstash/logstash:6.6.2

Kibana容器部署

- 启动参数参考上述组件

docker run -p 5601:5601 -d \

--user root \

--log-driver json-file \

--log-opt max-size=10m \

--log-opt max-file=3 \

--name kibana \

--link elasticsearch \

--restart=always \

-e ELASTICSEARCH_URL=http://elasticsearch:9200 \

-v /data/conf/kibana.yml:/usr/share/kibana/config/kibana.yml \

-v /data/elastalert-kibana-plugin:/usr/share/kibana/plugins/elastalert-kibana-plugin \

docker.elastic.co/kibana/kibana:6.6.2

- 通过服务器IP地址即可访问Kibana web

http://IP:5601

Filebeat 容器部署

Filebeat 配置文件说明

- Filebeat是一个轻量级的日志收集工具,是Elastic的Beat组成员,默认情况下,docker输出的日志格式为json格式,需要解码才方便查看日志的路径为

/var/lib/docker/containers/*/*.log - type: log选择filebeat输入类型选择log,之后通过解码json的配置将docker输出的日志解码,输入类型也可选择docker,但是我试过目前版本该数据类型有些功能受限,比如后面rename时,只能rename一个- json解码: 必须至少指定设置其中之一来启用JSON解析模式,建议三行都加上,不然,有些功能会有问题

- json.overwrite_keys #如果启用了keys_under_root和此设置,那么来自解码的JSON对象的值将覆盖Filebeat通常添加的字段(type, source, offset,等)以防冲突。

- json.add_error_key #如果启用此设置,则在出现JSON解组错误或配置中定义了message_key但无法使用的情况下,Filebeat将添加“error.message”和“error.type:json”键。

- json.message_key #一个可选的配置设置,用于指定应用行筛选和多行设置的JSON密钥。 如果指定,键必须位于JSON对象的顶层,且与键关联的值必须是字符串,否则不会发生过滤或多行聚合。

- 多行合并: 将多行日志合并成一条,比如java的报错日志,规则为,如果不是以四个数字,即年份开头的日志合并到上一条日志当中

- 排除或删除通配符行: 即排除含有相关关键字的行,或只收集含有相关关键字的行

- 排除通配文件: 即不读取该含该字符的文件的日志

- 添加docker元数据: 将docker容器的相关数据收集起来,方便作为索引的字段,

match_source_index: 4为获取docker数据的索引,其数据为json格式,索引太低可能无法获取关键docker数据 - 处理器重命名和删除无用字段:

- rename:将上面收集的元数据重命名来提升其索引等级,以便交给logstash来处理,其中docker.container.name为docker容器的名字,重命名为containername字段,- drop_fields:清除掉无用索引数据,不输出到 output - 日志输出:日志输出的几种方式

output.file输出到文件,output.console输出到标准输出,通过docker logs containName查看,该两种输出方便调试

cat > /data/conf/filebeat.yml << "EOF"

filebeat.inputs:

- type: log

paths:

- '/var/lib/docker/containers/*/*.log'

# json解码

json.add_error_key: true

json.overwrite_keys: true

json.message_key: log

# 多行合并

# multiline:

# pattern: ^\d{4}

# negate: true

# match: after

#

# 排除或删除通配符行

# exclude_lines: ['^DBG']

# include_lines: ['ERROR', 'WARN', 'INFO']

# 排除通配文件

# exclude_files: ['\.gz$']

#

# 添加docker元数据

processors:

- add_docker_metadata:

match_source: true

# 选取添加docker元数据的层级

match_source_index: 4

# 处理器重命名和删除无用字段

processors:

- rename:

fields:

- from: "json.log"

to: "message"

- from: "docker.container.name"

to: "containername"

- from: "log.file.path"

to: "filepath"

- drop_fields:

fields: ["docker","metadata","beat","input","prospector","host","source","offset"]

# 日志输出

output.logstash: # 输出地址

hosts: ["192.168.30.42:5043"]

#output.elasticsearch:

# hosts: ["192.168.30.42:9200"]

# protocol: "http"

#output.file:

# path: "/tmp"

# filename: filebeat.out

#output.console:

# pretty: true

EOF

Filebeat 启动命令

-v /var/lib/docker/containers/:/var/lib/docker/containers/映射日志目录-v /var/run/docker.sock:/var/run/docker.sock:ro映射docker套接字文件,来收集docker信息,添加docker元数据

docker run -d \

--name filebeat \

--user root \

--log-driver json-file \

--log-opt max-size=10m \

--log-opt max-file=3 \

--restart=always \

-v /data/conf/filebeat.yml:/usr/share/filebeat/filebeat.yml:ro \

-v /var/lib/docker/containers/:/var/lib/docker/containers/ \

-v /var/run/docker.sock:/var/run/docker.sock:ro \

docker.elastic.co/beats/filebeat:6.6.2

- Filebeat是日志收集客户端,正常情况下其部署在需要收集日志的主机上

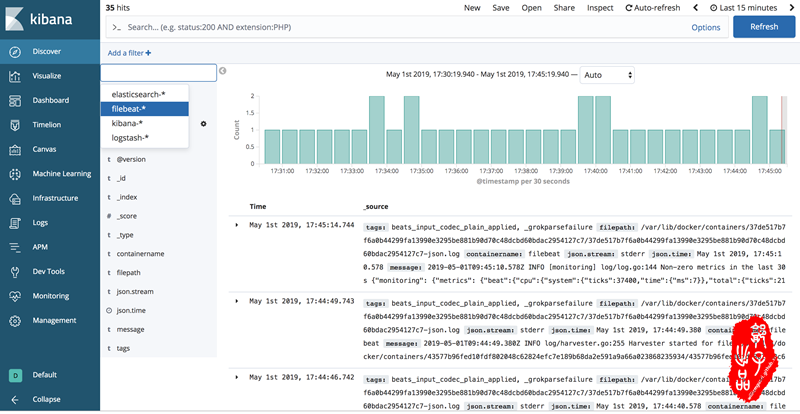

添加kibana索引

通过服务器IP地址访问Kibana web

http://IP:5601同时添加索引

如此便可查看相关日志

ELK之ElastAlert日志告警

- ElastAlert分为两部分,后端程序,项目地址 https://github.com/bitsensor/elastalert,Kibana前端页面插件地址 https://github.com/bitsensor/elastalert-kibana-plugin

- ElastAlert目前支持的报警类型:

- any:只要有匹配就报警;

- blacklist:compare_key字段的内容匹配上 blacklist数组里任意内容;

- whitelist:compare_key字段的内容一个都没能匹配上whitelist数组里内容;

- change:在相同query_key条件下,compare_key字段的内容,在 timeframe范围内发送变化;

- frequency:在相同 query_key条件下,timeframe 范围内有num_events个被过滤出来的异常;

- spike:在相同query_key条件下,前后两个timeframe范围内数据量相差比例超过spike_height。其中可以通过spike_type设置具体涨跌方向是up,down,both 。还可以通过threshold_ref设置要求上一个周期数据量的下限,threshold_cur设置要求当前周期数据量的下限,如果数据量不到下限,也不触发;

- flatline:timeframe 范围内,数据量小于threshold阈值;

- new_term:fields字段新出现之前terms_window_size(默认30天)范围内最多的terms_size (默认50)个结果以外的数据;

- cardinality:在相同 query_key条件下,timeframe范围内cardinality_field的值超过 max_cardinality 或者低于min_cardinality

- Percentage Match: 在buffer_time 中匹配所设置的字段的百分比高于或低于阈值时,此规则将匹配。默认情况下为全局的buffer_time

ElastAlert容器启动

-p 3030:3030指定映射端口,该端口需要kibana调用-v config/elastalert.yaml:/opt/elastalert/config.yaml映射ElastAlert的配置文件-v rules:/opt/elastalert/rules映射报警规则文件目录--link elasticsearchElastAlert需要连接ElasticSearch 进行数据的查询rule_templates:/opt/elastalert/rule_templates该目录下为报警规则的模版,可使用其配置并放入rules使其生效,具体配置规则参考https://elastalert.readthedocs.io/en/latest/ruletypes.html

git clone https://github.com/bitsensor/elastalert.git; cd elastalert

sed -i -e 's/localhost/elasticsearch/g' `pwd`/config/elastalert.yaml

docker run -d \

-p 3030:3030 \

-v `pwd`/config/elastalert.yaml:/opt/elastalert/config.yaml \

-v `pwd`/config/config.json:/opt/elastalert-server/config/config.json \

-v `pwd`/rules:/opt/elastalert/rules \

-v `pwd`/rule_templates:/opt/elastalert/rule_templates \

--link elasticsearch \

--name elastalert \

bitsensor/elastalert:latest

- 可通过

elastalert-test-rule rules/rule1.yaml在elastalert容器内测试报警规则

Kibana 需要更改配置

- 添加

elastalert相关的配置,包括主机名和端口

cat > /data/conf/kibana.yml << "EOF"

# Default Kibana configuration from kibana-docker.

server.name: kibana

server.host: "0"

elasticsearch.hosts: http://elasticsearch:9200

xpack.monitoring.ui.container.elasticsearch.enabled: true

elastalert-kibana-plugin.serverHost: elastalert

elastalert-kibana-plugin.serverPort: 3030

Kibana 启动参数更改

- 配置 Kibana的插件

elastalert-kibana-plugin需要注意的是,插件的下载地址 https://github.com/bitsensor/elastalert-kibana-plugin/releases 需要找到对应自己 kibana 版本,否则插件无法安装成功 - 从目前版本来看,插件的使用不是很方便,其相当于在 ElasticAlert 启动时

-v rules:/opt/elastalert/rules目录下写文件 -v /data/kibana/elastalert-kibana-plugin:/usr/share/kibana/plugins/elastalert-kibana-plugin映射插件目录

cd /data

wget https://github.com/bitsensor/elastalert-kibana-plugin/releases/download/1.0.2/elastalert-kibana-plugin-1.0.2-6.6.2.zip

unzip elastalert-kibana-plugin-1.0.2-6.6.2.zip

docker run -p 5601:5601 -d \

--user root \

--log-driver json-file \

--log-opt max-size=10m \

--log-opt max-file=3 \

--name kibana \

--link elasticsearch \

--link elastalert \

--restart=always \

-e ELASTICSEARCH_URL=http://elasticsearch:9200 \

-v /data/conf/kibana.yml:/usr/share/kibana/config/kibana.yml \

-v /data/kibana/elastalert-kibana-plugin:/usr/share/kibana/plugins/elastalert-kibana-plugin \

docker.elastic.co/kibana/kibana:6.6.2

- 启动后,可查看

http://IP:5601,可通过此来创建报警规则

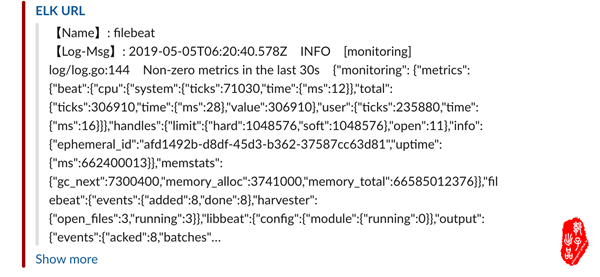

报警规则配置

- 这里给出一个报警规则的示例,更多请查看文档 https://elastalert.readthedocs.io/en/latest/ruletypes.html

es_host: elasticsearch该配置会使用docker容器中的变量name: filebeat info frequency rule报警规则的名称,需要唯一timeframe:设定查询的时间尺度,这里指定为5分钟filter指定报警条件,示例为日志中message字段还有INFO信息就示作匹配alert指定报警方式,报警方式有很多,这里使用slack,可查看文档配置

# Alert when the rate of events exceeds a threshold

# (Optional)

# Elasticsearch host

# es_host: elasticsearch.example.com

es_host: elasticsearch

# (Optional)

# Elasticsearch port

# es_port: 14900

es_port: 9200

# (OptionaL) Connect with SSL to Elasticsearch

#use_ssl: True

# (Optional) basic-auth username and password for Elasticsearch

#es_username: someusername

#es_password: somepassword

# (Required)

# Rule name, must be unique

name: filebeat info frequency rule

# (Required)

# Type of alert.

# the frequency rule type alerts when num_events events occur with timeframe time

type: frequency

# (Required)

# Index to search, wildcard supported

index: filebeat-*

# (Required, frequency specific)

# Alert when this many documents matching the query occur within a timeframe

num_events: 1

# (Required, frequency specific)

# num_events must occur within this amount of time to trigger an alert

timeframe:

# hours: 1

minutes: 5

# (Required)

# A list of Elasticsearch filters used for find events

# These filters are joined with AND and nested in a filtered query

# For more info: http://www.elasticsearch.org/guide/en/elasticsearch/reference/current/query-dsl.html

filter:

- query:

query_string:

query: "message:INFO"

# (Required)

# The alert is use when a match is found

alert:

- "slack"

alert_subject: "{} @{}"

alert_subject_args:

- containername

- log-timestamp

alert_text_type: alert_text_only

alert_text: |

> 【Name】: {}

> 【Log-Msg】: {}

alert_text_args:

- containername

- message

slack_webhook_url: "https://hooks.slack.com/services/xxxx/xxxx/xxxxxx"

slack_title_link: "https://elk.glinux.top"

slack_title: "ELK URL"

slack_username_override: "ELK Alert"

slack_channel_override: "#filebeat-test"

- 报警的效果如图

定时删除过期日志索引文件

- 该脚本用于删除7天以前的索引文件(过月日志清除),脚本为参考他人作品,做了少许更改,可查看参考文档

curl -s "http://127.0.0.1:9200/_cat/indices?v"该命令可以查看es中的索引curl -XDELETE -s "http://127.0.0.1:9200/filebeat-2019.04.27"该命令用于删除es中的filebeat-2019.04.27索引

cat > /data/delete_index.sh << "EOF"

#!/bin/bash

elastic_url=127.0.0.1

elastic_port=9200

user="username"

pass="password"

log="/data/log/delete_index.log"

# 当前日期时间戳减去索引名时间转化时间戳是否大于1

dateDiff (){

dte1=$1

dte2=$2

diffSec=$((dte1-dte2))

if ((diffSec > 6)); then

echo "1"

else

echo "0"

fi

}

# 循环获取索引文件,通过正则匹配过滤

for index in $(curl -s "${elastic_url}:${elastic_port}/_cat/indices?v" | awk -F' ' '{print $3}' | grep -E "[0-9]{4}.[0-9]{2}.[0-9]{2}$"); do

# 获取索引文件日期,并转化格式

date=$(echo $index | awk -F'-' '{print $NF}' | sed -n 's/\.//p' | sed -n 's/\.//p')

# 获取当前日期

cond=$(date '+%Y%m%d')

# 根据不同服务器,计算不同数值

diff=$(dateDiff "${cond}" "${date}")

# 打印索引名和结果数值

#echo -n "${index} (${diff})"

# 判断结果值是否大于等于1

if [ $diff -eq 1 ]; then

curl -XDELETE -s "${elastic_url}:${elastic_port}/${index}" && echo "${index} 删除成功" >> $log || echo "${index} 删除失败" >> $log

fi

done

EOF

- 该脚本可以做成定时任务,每天都执行一次,来删除过期数据

参考文档

ELK

- 使用Docker搭建ELK日志系统 https://zhuanlan.zhihu.com/p/32559371

- Beats详解(四) http://www.51niux.com/?id=204

- Offical document: https://www.elastic.co/guide/index.html

- 将日志输出到Docker容器外: https://www.jianshu.com/p/bf2eb121ac62

- elk日志大盘显示和日志监控报警配置实践: https://blog.csdn.net/yujiak/article/details/79897408

Elastalert

- elastalert github地址: https://github.com/bitsensor/elastalert

- elastalert-kibana-plugin github地址: https://github.com/bitsensor/elastalert-kibana-plugin/tree/1.0.2

- ElastAlert 官方操作文档:https://elastalert.readthedocs.io/en/latest/ruletypes.html

索引定期清除

其他

- Centos 7 Docker命令自动补全 https://medium.com/@ismailyenigul/enable-docker-command-line-auto-completion-in-bash-on-centos-ubuntu-5f1ac999a8a6

- Searchguard 插件支持OpenLdap:https://github.com/floragunncom/search-guard-kibana-plugin

- 设置登录认证: https://birdben.github.io/2017/02/08/Kibana/Kibana学习(六)Kibana设置登录认证

- SSL免费证书 https://certbot.eff.org/lets-encrypt/ubuntuxenial-nginx

ELK:收集Docker容器日志的更多相关文章

- elk-filebeat收集docker容器日志

目录 使用docker搭建elk filebeat安装与配置 docker容器设置 参考文章 首发地址 使用docker搭建elk 1.使用docker-compose文件构建elk.文件如下: ve ...

- EFK的安装和收集docker容器日志展示

在用户根目录创建个filebeat.docker.yml文件,文件内容如下 filebeat.config: modules: path: ${path.config}/modules.d/*.yml ...

- ELK:收集k8s容器日志最佳实践

简介 关于日志收集这个主题,这已经是第三篇了,为什么一再研究这个课题,因为这个课题实在太重要,而当今优秀的开源解决方案还不是很明朗: 就docker微服务化而言,研发有需求标准输出,也有需求文件输出, ...

- docker 容器日志集中 ELK + filebeat

docker 容器日志集中 ELK ELK 基于 ovr 网络下 docker-compose.yaml version: '2' networks: network-test: external: ...

- 利用 ELK 搭建 Docker 容器化应用日志中心

利用 ELK 搭建 Docker 容器化应用日志中心 概述 应用一旦容器化以后,需要考虑的就是如何采集位于 Docker 容器中的应用程序的打印日志供运维分析.典型的比如SpringBoot应用的日志 ...

- docker容器日志收集方案汇总评价总结

docker日志收集方案有太多,下面截图罗列docker官方给的日志收集方案(详细请转docker官方文档).很多方案都不适合我们下面的系列文章没有说. 经过以下5篇博客的叙述简单说下docker容器 ...

- docker容器日志收集方案(方案一 filebeat+本地日志收集)

filebeat不用多说就是扫描本地磁盘日志文件,读取文件内容然后远程传输. docker容器日志默认记录方式为 json-file 就是将日志以json格式记录在磁盘上 格式如下: { " ...

- docker容器日志收集方案(方案二 filebeat+syslog本地日志收集)

与方案一一样都是把日志输出到本地文件系统使用filebeat进行扫描采集 不同的是输出的位置是不一样的 我们对docker进行如下设置 sudo docker service update --lo ...

- docker容器日志查看

日志分两类,一类是 Docker 引擎日志:另一类是 容器日志. Docker 引擎日志 Docker 引擎日志 一般是交给了 Upstart(Ubuntu 14.04) 或者 systemd (Ce ...

随机推荐

- java线程相关基本方法

java线程中常用的基本方法有wait,notify,notifyAll,sleep,join,yield等. 线程的生命周期一共分为五个部分,分别是:新建(New).就绪(Runnable).运行( ...

- 搭建nginx

Nginx ("engine x") 是一个高性能的HTTP和反向代理服务器,也是一个IMAP/POP3/SMTP服务器.Nginx是由Igor Sysoev为俄罗斯访问量第二的R ...

- 用VSCode插件来一键填满Github的绿色格子吧-AutoCommit

autoCommit 一个用于Git自动commit的VSCode插件,它可以用来补充之前忘记提交commit,帮助你把首页的绿色格子填满. 使用效果 使用本插件来控制commit次数. 如下图,你甚 ...

- 【转】在MyEclipse 8.6上搭建Android开发环境

内容导航 第 1 页:基本环境准备 第 2 页:下载Android SDK 第 3 页:配置SDK环境变量 第 4 页:给MyEclipse安装ADT插件 第 5 页:配置MyEclipse 第 6 ...

- 【Magicodes.IE 2.0.0-beta1版本发布】已支持数据表格、列筛选器和Sheet拆分

为了更好的完善Magicodes.IE,春节期间我们会进行一次大的重构.由于精力有限,急缺文档和翻译(将文档翻译为英文文档)支持,诚邀各位加入.同时在功能方便也做了相关规划,有兴趣的朋友可以参与提交P ...

- TCP/IP协议与HTTP协议(二)

TCP/IP协议是传输层协议,主要解决数据如何在网络中传输,而HTTP是应用层协议,主要解决如何包装数据. 1.TCP连接 手机能够使用联网功能是因为手机底层实现了TCP/IP协议,可以使手机终端通过 ...

- Jquery电子签名制作_jSignature

今天用Jquery的jSignature库制作一个电子签名 后台.net core上传到指定文件夹 下载jquery库 提取码:rd9g html @{ Layout = null; } <!D ...

- Logback源码分析

在日常开发中经常通过打印日志记录程序执行的步骤或者排查问题,如下代码类似很多,但是,它是如何执行的呢? package chapters; import org.slf4j.Logger; impor ...

- Spring-cloud微服务实战【六】:接口服务feign

在上一篇文章中,我们使用了ribbon进行负载均衡,但是仔细思考一下,我们的请求封装和调用以及结果的返回都是我们自己编码完成的,如果需要调用的接口很多,那么无疑开发量是比较大的,那有没有比较好的方式呢 ...

- 深入理解Java虚拟机-类加载连接和初始化解析

不管学习什么,我一直追求的是知其然,还要知其所以然,对真理的追求可以体现在方方面面.人生短短数十载,匆匆一世似烟云,我认为,既然来了,就应该留下一些有意义的东西.本系列文章是结合张龙老师的<深入 ...