HBase 6、用Phoenix Java api操作HBase

开发环境准备:eclipse3.5、jdk1.7、window8、hadoop2.2.0、hbase0.98.0.2、phoenix4.3.0

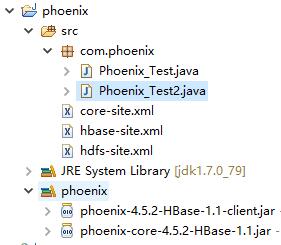

1、从集群拷贝以下文件:core-site.xml、hbase-site.xml、hdfs-site.xml文件放到工程src下

2、把phoenix的phoenix-4.3.0-client.jar和phoenix-core-4.3.0.jar添加到工程classpath

3、配置集群中各节点的hosts文件,把客户端的hostname:IP添加进去

4、在客户端host文件中加入集群的hostname和IP

5、工程截图

例子1:

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.ResultSet;

import java.sql.Statement; public class Phoenix_Test {

/**

* 使用phoenix提供的api操作hbase读取数据

*/

public static void main(String[] args) throws Throwable {

try {

// 下面的驱动为Phoenix老版本使用2.11使用,对应hbase0.94+

// Class.forName("com.salesforce.phoenix.jdbc.PhoenixDriver"); // phoenix4.3用下面的驱动对应hbase0.98+

Class.forName("org.apache.phoenix.jdbc.PhoenixDriver");

} catch (Exception e) {

e.printStackTrace();

}

// 这里配置zookeeper的地址,可单个,也可多个。可以是域名或者ip

String url = "jdbc:phoenix:node5,node6,node7";

// String url =

// "jdbc:phoenix:41.byzoro.com,42.byzoro.com,43.byzoro.com:2181";

Connection conn = DriverManager.getConnection(url);

Statement statement = conn.createStatement();

String sql = "select count(1) as num from WEB_STAT";

long time = System.currentTimeMillis();

ResultSet rs = statement.executeQuery(sql);

while (rs.next()) {

int count = rs.getInt("num");

System.out.println("row count is " + count);

}

long timeUsed = System.currentTimeMillis() - time;

System.out.println("time " + timeUsed + "mm");

// 关闭连接

rs.close();

statement.close();

conn.close();

}

}

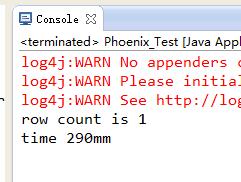

执行结果:

例子2:

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.ResultSet;

import java.sql.Statement; public class Phoenix_Test2 {

/**

* 使用phoenix提供的api操作hbase中读取数据

*/

public static void main(String[] args) throws Throwable {

try {

//下面的驱动为Phoenix老版本使用2.11使用,对应hbase0.94+

//Class.forName("com.salesforce.phoenix.jdbc.PhoenixDriver");

//phoenix4.3用下面的驱动对应hbase0.98+

Class.forName("org.apache.phoenix.jdbc.PhoenixDriver");

} catch (Exception e) {

e.printStackTrace();

}

//这里配置zk的地址,可单个,也可多个。可以是域名或者ip

String url = "jdbc:phoenix:node5,node6,node7";

Connection conn = DriverManager.getConnection(url);

Statement statement = conn.createStatement();

String sql = "select * from web_stat where core = 1";

long time = System.currentTimeMillis();

ResultSet rs = statement.executeQuery(sql);

while (rs.next()) {

//获取core字段值

int core = rs.getInt("core");

//获取core字段值

String host = rs.getString("host");

//获取domain字段值

String domain = rs.getString("domain");

//获取feature字段值

String feature = rs.getString("feature");

//获取date字段值,数据库中字段为Date类型,这里代码会自动转化为string类型

String date = rs.getString("date");

//获取db字段值

String db = rs.getString("db");

System.out.println("host:"+host+"\tdomain:"+domain+"\tfeature:"+feature+"\tdate:"+date+"\tcore:" + core+"\tdb:"+db);

}

long timeUsed = System.currentTimeMillis() - time;

System.out.println("time " + timeUsed + "mm");

//关闭连接

rs.close();

statement.close();

conn.close();

}

}

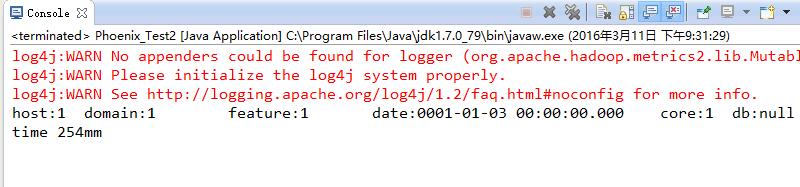

执行结果:

HBase 6、用Phoenix Java api操作HBase的更多相关文章

- linux 下通过过 hbase 的Java api 操作hbase

hbase版本:0.98.5 hadoop版本:1.2.1 使用自带的zk 本文的内容是在集群中创建java项目调用api来操作hbase,主要涉及对hbase的创建表格,删除表格,插入数据,删除数据 ...

- Java API 操作HBase Shell

HBase Shell API 操作 创建工程 本实验的环境实在ubuntu18.04下完成,首先在改虚拟机中安装开发工具eclipse. 然后创建Java项目名字叫hbase-test 配置运行环境 ...

- hadoop2-HBase的Java API操作

Hbase提供了丰富的Java API,以及线程池操作,下面我用线程池来展示一下使用Java API操作Hbase. 项目结构如下: 我使用的Hbase的版本是 hbase-0.98.9-hadoop ...

- Hbase框架原理及相关的知识点理解、Hbase访问MapReduce、Hbase访问Java API、Hbase shell及Hbase性能优化总结

转自:http://blog.csdn.net/zhongwen7710/article/details/39577431 本blog的内容包含: 第一部分:Hbase框架原理理解 第二部分:Hbas ...

- 【Hbase三】Java,python操作Hbase

Java,python操作Hbase 操作Hbase python操作Hbase 安装Thrift之前所需准备 安装Thrift 产生针对Python的Hbase的API 启动Thrift服务 执行p ...

- JAVA API访问Hbase org.apache.hadoop.hbase.client.RetriesExhaustedException: Failed after attempts=32

Java使用API访问Hbase报错: 我的hbase主节点是spark1 java代码访问hbase的时候写的是ip 结果运行程序报错 不能够识别主机名 修改主机名 修改主机hosts文 ...

- java api操作

java api操作 导入开发包 将hbase安装包中lib下包导入java项目 创建表 Configuration conf = HBaseConfiguration.create(); c ...

- hive-通过Java API操作

通过Java API操作hive,算是测试hive第三种对外接口 测试hive 服务启动 package org.admln.hive; import java.sql.SQLException; i ...

- 使用Java API操作HDFS文件系统

使用Junit封装HFDS import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.*; import org ...

随机推荐

- Java之Static静态修饰符详解

Java之Static静态修饰符详解 Java之Static静态修饰符详解 一.特点 1.随着类的加载而加载,随着类的消失而消失,生命周期最长 2.优先于对象存在 3.被所有类的对象共享 4.可以直接 ...

- Android日志系统驱动程序Logger源代码分析

文章转载至CSDN社区罗升阳的安卓之旅,原文地址:http://blog.csdn.net/luoshengyang/article/details/6595744 我们知道,在Android系统中, ...

- C. Robot(BFS)

C. Robot Time Limit: 3000ms Case Time Limit: 3000ms Memory Limit: 262144KB 64-bit integer IO format: ...

- 智能路由——ESB

SOA之我见 SOA已然是企业级开发的必定之路.有人会问:我们有了OOP,还须要SOA吗?好吧我承认,这个问题也困扰了我非常久.现现在我得出的结论是:OOP是OOP,SOA是SOA. OOP是指面向对 ...

- K贪心

<span style="color:#330099;">/* K - 贪心 基础 Time Limit:1000MS Memory Limit:32768KB 64b ...

- .Net+EF连接Oracle 10、11 开发,ODAC安装配置与使用详解

Oracle数据访问组件 (ODAC) 全称:Oracle Data Access Components 优点:由于微软在.net framework4中会将System.Data.OracleCl ...

- 1218.3——init自定义

相当于构造方法,有的时候初始化的时候有一些默认值,还有就是页面加载数据的时机问题,防止加载了页面再填数据 声明: -(instancetype)initWithName:(NSString *)aNa ...

- (原+转)ubuntu14中结束多个caffe进程中的某个

转载请注明出处: http://www.cnblogs.com/darkknightzh/p/5948237.html 参考网址: http://www.2cto.com/os/201407/3215 ...

- Hello Word!

第一次来博客园,作为技术的基站,多余的话不说了,就一个helloword! <script type="text/javascript"> //等待dom元素加载完毕. ...

- 整合spring2 + struts1.2 + hibernate3.2 .

1 可恶的myeclipse 为了开发方便,我选择了myeclipse,因为它集成了很多框架,而不致于自己去倒入很多lib.但就是因为这一点,成了我这次组合的致命伤.SSH因为其是开源框架,自 ...