PytorchZerotoAll学习笔记(三)--自动求导

Pytorch给我们提供了自动求导的函数,不用再自己再推导计算梯度的公式了

虽然有了自动求导的函数,但是这里我想给大家浅析一下:深度学习中的一个很重要的反向传播

references:https://en.wikipedia.org/wiki/Chain_rule

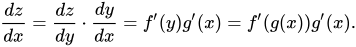

我们先来看看什么是chain- rule(链式法则)

Z是由 y经过f函数得到的,y又是x经过g函数得到

,

,

正向传播的方向是从左往右,那么反向传播的便是从右到左,梯度是一级级往回传递的

我们知道一般输出的时候都要经过一个激活函数,常用的是relu。当前的结果要往后传,

那么,这个时候便是函数的复合,一个套一个(俄罗斯套娃)(正向传播)

反向传播,就像剥洋葱,一层一层,你会发现它是没有心的.........哈哈哈哈哈哈

tips:当前层的梯度的计算需要后一层计算的梯度的结果

我们再来看看代码

import torch

from torch.autograd import Variable x_data = [1.0, 2.0, 3.0]

y_data = [2.0, 4.0, 6.0]

#这里的w,我们是用tensor来生成了,不再是一个python的变量,调用torch.Tensor 需要计算梯度,所以 requires——grad设置为true

w = Variable(torch.Tensor([1.0]), requires_grad=True) # Any random value # our model forward pass def forward(x):

return x * w # Loss function def loss(x, y):

y_pred = forward(x)

return (y_pred - y) * (y_pred - y) # Before training

print("predict (before training)", 4, forward(4).data[0]) # Training loop

for epoch in range(10):

for x_val, y_val in zip(x_data, y_data):

l = loss(x_val, y_val)

# l.backward()调用这个函数就可以让程序自动求梯度啦,是不是很神奇!

l.backward()

# 获取梯度的数值 使用 .data直接调用其属性即可

print("\tgrad: ", x_val, y_val, w.grad.data[0])

w.data = w.data - 0.01 * w.grad.data #手动清零 这里我们迭代10轮,所以下次计算之前都要清零当前的梯度值Manually zero the gradients after updating weights

w.grad.data.zero_() print("progress:", epoch, l.data[0]) # After training

print("predict (after training)", 4, forward(4).data[0]) 今天就讲到这里啦,see you next time!

PytorchZerotoAll学习笔记(三)--自动求导的更多相关文章

- Activiti工作流学习笔记(三)——自动生成28张数据库表的底层原理分析

原创/朱季谦 我接触工作流引擎Activiti已有两年之久,但一直都只限于熟悉其各类API的使用,对底层的实现,则存在较大的盲区. Activiti这个开源框架在设计上,其实存在不少值得学习和思考的地 ...

- 2018/2/13 ElasticSearch学习笔记三 自动映射以及创建自动映射模版,ElasticSearch聚合查询

终于把这些命令全敲了一遍,话说ELK技术栈L和K我今天花了一下午全部搞定,学完后还都是花式玩那种...E却学了四天(当然主要是因为之前上班一直没时间学,还有安装服务时出现的各种error真是让我扎心了 ...

- [深度学习] pytorch学习笔记(1)(数据类型、基础使用、自动求导、矩阵操作、维度变换、广播、拼接拆分、基本运算、范数、argmax、矩阵比较、where、gather)

一.Pytorch安装 安装cuda和cudnn,例如cuda10,cudnn7.5 官网下载torch:https://pytorch.org/ 选择下载相应版本的torch 和torchvisio ...

- 『PyTorch』第三弹_自动求导

torch.autograd 包提供Tensor所有操作的自动求导方法. 数据结构介绍 autograd.Variable 这是这个包中最核心的类. 它包装了一个Tensor,并且几乎支持所有的定义在 ...

- 从零开始学习MXnet(四)计算图和粗细粒度以及自动求导

这篇其实跟使用MXnet的关系不大,但对于我们理解深度学习的框架设计还是很有帮助的. 首先还是对promgramming models的一个简单介绍,这个东西实际上是在编译里面经常出现的东西,我们在编 ...

- Pytorch学习(一)—— 自动求导机制

现在对 CNN 有了一定的了解,同时在 GitHub 上找了几个 examples 来学习,对网络的搭建有了笼统地认识,但是发现有好多基础 pytorch 的知识需要补习,所以慢慢从官网 API进行学 ...

- pytorch的自动求导机制 - 计算图的建立

一.计算图简介 在pytorch的官网上,可以看到一个简单的计算图示意图, 如下. import torchfrom torch.autograd import Variable x = Variab ...

- VSTO学习笔记(三) 开发Office 2010 64位COM加载项

原文:VSTO学习笔记(三) 开发Office 2010 64位COM加载项 一.加载项简介 Office提供了多种用于扩展Office应用程序功能的模式,常见的有: 1.Office 自动化程序(A ...

- thinkphp学习笔记9—自动加载

原文:thinkphp学习笔记9-自动加载 1.命名空间自动加载 在3.2版本中不需要手动加载类库文件,可以很方便的完成自动加载. 系统可以根据类的命名空间自动定位到类库文件,例如定义了一个类Org\ ...

随机推荐

- [iOS]CIFilter滤镜

- (void)viewDidLoad { [super viewDidLoad]; // Do any additional setup after loading the view, typica ...

- 歌词解析&class

class song_song: def __init__(self,lrc_file): # 定义两个字典一个列表备用 self.song_file = lrc_file self.song_lrc ...

- JS-instanceof 与typeof

通常来讲,使用 instanceof 就是判断一个实例是否属于某种类型 而typeof 无论引用的是什么类型的对象,它都返回 "object" var arr=[1,2,3]; ...

- Hadoop启动dataNode失败,却没有任何报错

问题描述: centos7,伪分布模式下,启动datanode后,通过JPS查看发现没有相关进程,在日志文件里也没有任何提示.通过百度,网上一堆说什么vesion 的ID不一致,不能解决我的问题. 经 ...

- windows安装Oracle数据库

我装的版本是Oracle11,64位,直接网上下载即可.安装过程中也出现了一些坑,现在整理了一下. 1.下载的目录和安装的目录最好放到英文目录下,别放到中文或者特殊字符的文件夹中,点击setup.ex ...

- redis-数据类型及命令

redis五大数据类型:string(字符串),hash(哈希,类似java的Map),list(列表),set(集合),zset(有序集合) 1.redis的键(key) keys 查询数据库中的k ...

- PHP程序员的技术成长规划 第三阶段:高级阶段

第三阶段:高级阶段 (高级PHP程序员)重点:除了基本的LNMP程序,还能够在某个方向或领域有深入学习.(纵深维度发展)目标:除了能够完成基本的PHP业务开发,还能够解决大部分深入复杂的技术问题,并且 ...

- Python学习6——运算符

1.算数运算符 例1:给定一个三位数,给出每个位置上对应的参数: #方法01:当作数字来求 print("请输入一个三位数:") number = input() number = ...

- python迭代器生成器

1.生成器和迭代器.含有yield的特殊函数为生成器.可以被for循环的称之为可以迭代的.而可以通过_next()_调用,并且可以不断返回值的称之为迭代器 2.yield简单的生成器 #迭代器简单的使 ...

- 【转】ASP.NET 防止同一用户同时登陆

要防止同一用户同时登陆,首页应该记录在线用户的信息(这里与用户名为例),然后判断正在登陆的用户里面是否已存在.在这里使用一个cache存放已经登陆的用户名,但是还有一个问题就是要知道用户是什么时候离开 ...