python爬虫 抓取一个网站的所有网址链接

作者QQ:231469242

关键字:爬虫,网址抓取,python

测试

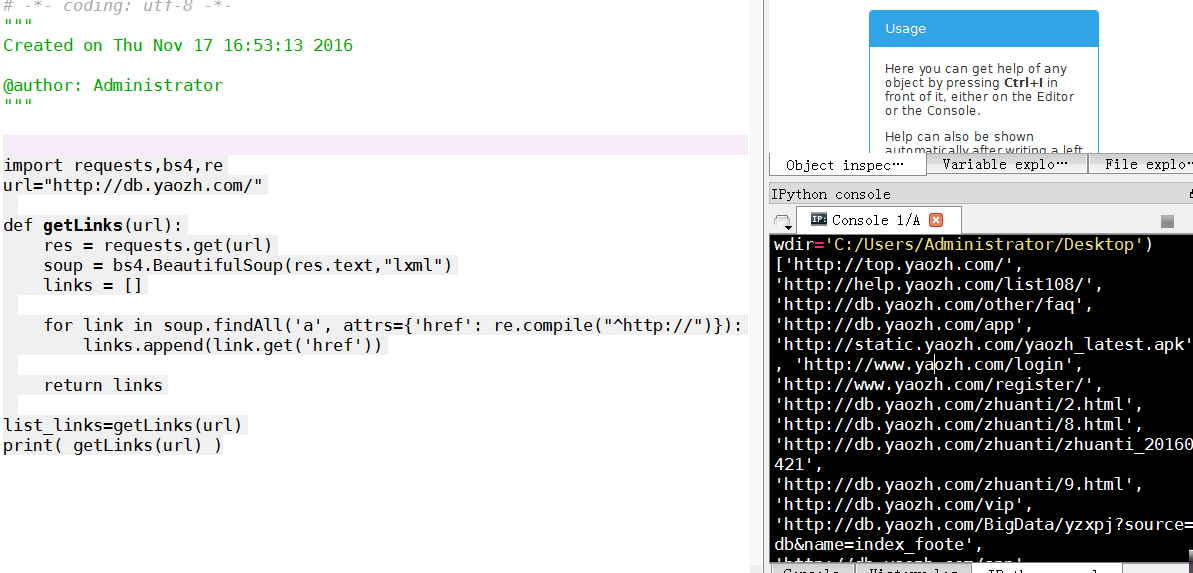

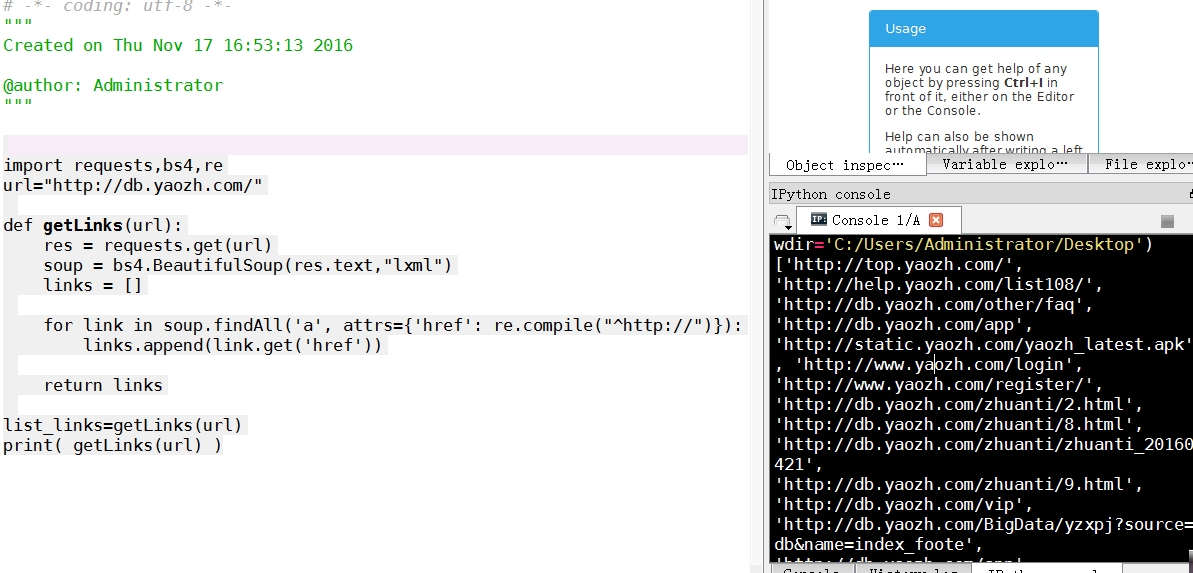

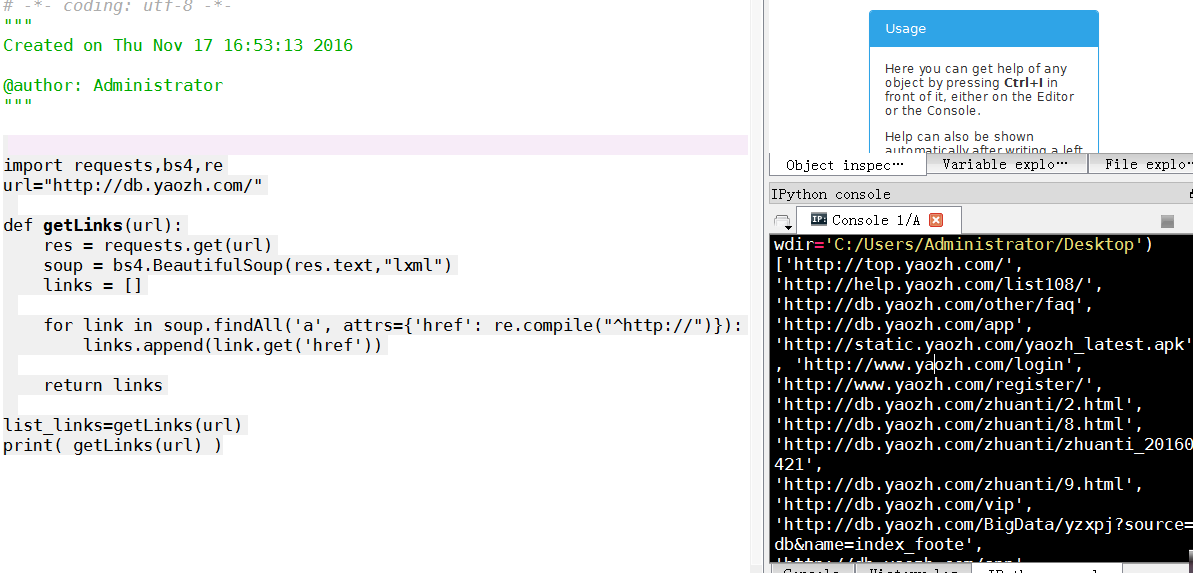

url=http://db.yaozh.com/

import requests,bs4,re

url="http://db.yaozh.com/" def getLinks(url):

res = requests.get(url)

soup = bs4.BeautifulSoup(res.text,"lxml")

links = [] for link in soup.findAll('a', attrs={'href': re.compile("^http://")}):

links.append(link.get('href')) return links list_links=getLinks(url)

print( getLinks(url) )

测试

url=http://www.yaozh.com

网址共121个

['http://db.yaozh.com', 'http://www.yaozh.com/zhihui', 'http://s.yaozh.com', 'http://news.yaozh.com', 'http://star.yaozh.com', 'http://club.yaozh.com/', 'http://edu.yaozh.com/', 'http://bbs.yaozh.com', 'http://www.35yao.com/', 'http://top.yaozh.com/', 'http://www.yaozh.com/', 'http://news.yaozh.com', 'http://db.yaozh.com', 'http://www.yaozh.com/zhihui', 'http://s.yaozh.com', 'http://bbs.yaozh.com', 'http://club.yaozh.com/', 'http://edu.yaozh.com/', 'http://star.yaozh.com/', 'http://top.yaozh.com/', 'http://db.yaozh.com/Zhuanti/zhuanti_20160721?source=www&name=index_slide', 'http://bbs.yaozh.com/thread-260886-1-1.html?source=www&name=index_slide', 'http://edu.yaozh.com/Course/84.html?source=www&name=index_slide', 'http://bbs.yaozh.com/thread-262781-1-1.html?source=www&name=index_slide', 'http://db.yaozh.com/pqf?source=www&position=index_newdb', 'http://db.yaozh.com/orangebook?source=www&position=index_newdb', 'http://db.yaozh.com/qxzhuce?source=www&position=index_newdb', 'http://db.yaozh.com/yfpw?source=www&name=index_newdb', 'http://db.yaozh.com/orangebook?source=www&name=long_banner', 'http://news.yaozh.com/Detail/index/id/16689.html', 'http://s.yaozh.com/Article/index?id=48?source=www&name=long_banner', 'http://bbs.yaozh.com/thread-262329-1-1.html?source=www&name=long_banner', 'http://bbs.yaozh.com/thread-216363-1-1.html', 'http://s.yaozh.com/3832', 'http://s.yaozh.com/3122', 'http://s.yaozh.com/1389', 'http://s.yaozh.com/1952', 'http://s.yaozh.com/4043', 'http://s.yaozh.com/4058', 'http://s.yaozh.com/3858', 'http://s.yaozh.com/1392', 'http://db.yaozh.com?source=www&name=long_banner', 'http://db.yaozh.com/app?source=www&name=db_left', 'http://news.yaozh.com/archive/12393.html', 'http://news.yaozh.com/archive/12275.html', 'http://news.yaozh.com/archive/12218.html', 'http://news.yaozh.com/archive/12138.html', 'http://news.yaozh.com/archive/11449.html', 'http://news.yaozh.com/archive/11340.html', 'http://news.yaozh.com/archive/11026.html', 'http://news.yaozh.com/archive/10433.html', 'http://news.yaozh.com/archive/10219.html', 'http://news.yaozh.com/archive/10206.html', 'http://news.yaozh.com/archive/9732.html', 'http://news.yaozh.com/archive/9648.html', 'http://news.yaozh.com/archive/9373.html', 'http://news.yaozh.com/archive/9279.html', 'http://news.yaozh.com/archive/8806.html', 'http://news.yaozh.com/archive/8479.html', 'http://news.yaozh.com/archive/8480.html', 'http://news.yaozh.com/archive/7897.html', 'http://news.yaozh.com/archive/7898.html', 'http://news.yaozh.com/archive/7899.html', 'http://db.yaozh.com/zhuangrang?from=www&position=index_hotdb', 'http://db.yaozh.com/zhuce?from=www&position=index_hotdb', 'http://db.yaozh.com/yaopinzhongbiao?from=www&position=index_hotdb', 'http://db.yaozh.com/index.php?action=foreign?from=www&position=index_hotdb', 'http://db.yaozh.com/screening?from=www&position=index_hotdb', 'http://db.yaozh.com/jiegou?from=www&position=index_hotdb', 'http://db.yaozh.com/vip/custom.html?source=www&name=db_right', 'http://www.xinyaohui.com', 'http://www.cqyjs.com/index.html', 'http://www.reed-sinopharm.com/', 'http://www.bucm.edu.cn', 'http://pharmacy.scu.edu.cn/', 'http://www.cqmu.edu.cn/', 'http://www.cqacmm.com/', 'http://www.cpri.com.cn/', 'http://www.cpu.edu.cn/', 'http://pharmacy.swu.edu.cn', 'http://www.mypharma.com', 'http://www.psyzg.com/', 'http://www.viptijian.com/0592', 'http://www.7lk.com/', 'http://www.j1.com/pd-baojianpin.html', 'http://www.3156.cn/', 'http://www.sdyyzs.cn', 'http://www.jiankangle.com', 'http://www.rmttjkw.com', 'http://www.sunyet.com', 'http://www.chinayikao.com/', 'http://www.hxyjw.com/ ', 'http://www.100xhs.com/ask/ ', 'http://www.360zhengrong.com/', 'http://www.ftxk.cn/', 'http://www.jianke.com/zypd/', 'http://www.medlive.cn/', 'http://health.qqyy.com/', 'http://www.wendaifu.com/', 'http://health.cqnews.net/', 'http://www.yaofu.cn/', 'http://www.ipathology.cn/', 'http://nk.99.com.cn/', 'http://www.baxsun.cn/', 'http://www.yiliu88.com ', 'http://www.wiki8.com/', 'http://www.39kf.com/', 'http://www.10000yao.com', 'http://www.3618med.com', 'http://www.chem960.com', 'http://www.yaojobs.com', 'http://www.hc3i.cn/', 'http://about.yaozh.com/about.html', 'http://about.yaozh.com/contact.html', 'http://about.yaozh.com/Qualification.html', 'http://about.yaozh.com/join.html', 'http://about.yaozh.com/link.html', 'http://help.yaozh.com/', 'http://bbs.yaozh.com/forum-123-1.html', 'http://bbs.yaozh.com', 'http://www.beian.gov.cn/portal/registerSystemInfo?recordcode=50010802001068']

测试3

url=http://www.dxy.cn/

丁香园网址链接是501个

测试4

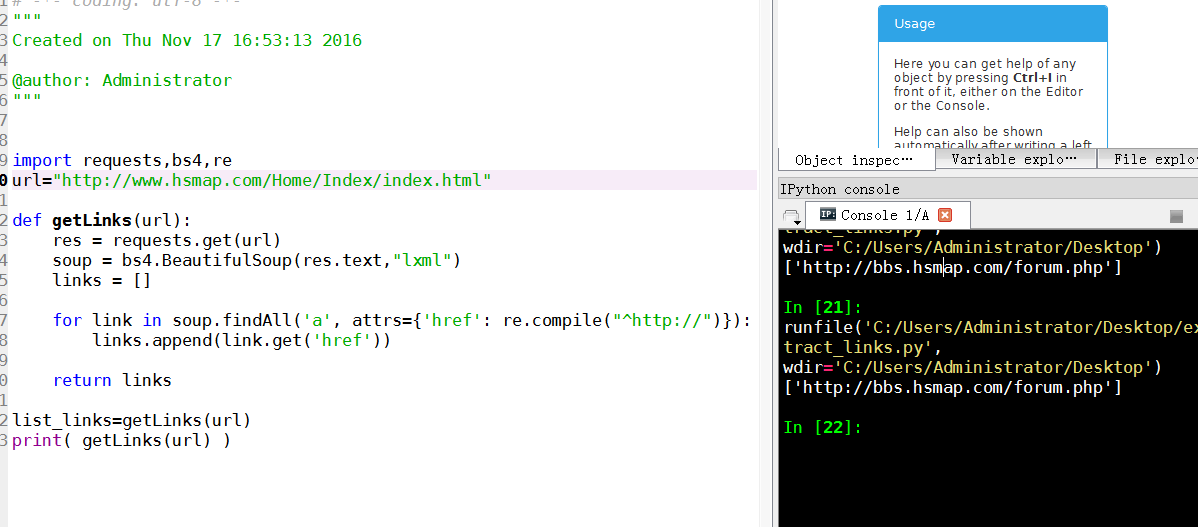

url=http://www.hsmap.com

只有一个链接

python爬虫 抓取一个网站的所有网址链接的更多相关文章

- Python 爬虫-抓取中小企业股份转让系统公司公告的链接并下载

系统运行系统:MAC 用到的python库:selenium.phantomjs等 由于中小企业股份转让系统网页使用了javasvript,无法用传统的requests.BeautifulSoup库获 ...

- python 爬虫抓取心得

quanwei9958 转自 python 爬虫抓取心得分享 urllib.quote('要编码的字符串') 如果你要在url请求里面放入中文,对相应的中文进行编码的话,可以用: urllib.quo ...

- Python爬虫----抓取豆瓣电影Top250

有了上次利用python爬虫抓取糗事百科的经验,这次自己动手写了个爬虫抓取豆瓣电影Top250的简要信息. 1.观察url 首先观察一下网址的结构 http://movie.douban.com/to ...

- Python爬虫抓取东方财富网股票数据并实现MySQL数据库存储

Python爬虫可以说是好玩又好用了.现想利用Python爬取网页股票数据保存到本地csv数据文件中,同时想把股票数据保存到MySQL数据库中.需求有了,剩下的就是实现了. 在开始之前,保证已经安装好 ...

- python爬虫抓取哈尔滨天气信息(静态爬虫)

python 爬虫 爬取哈尔滨天气信息 - http://www.weather.com.cn/weather/101050101.shtml 环境: windows7 python3.4(pip i ...

- Python爬虫抓取某音乐网站MP3(下载歌曲、存入Sqlite)

最近右胳膊受伤,打了石膏在家休息.为了实现之前的想法,就用左手打字.写代码,查资料完成了这个资源小爬虫.网页爬虫, 最主要的是协议分析(必须要弄清楚自己的目的),另外就是要考虑对爬取的数据归类,存储. ...

- Python 爬虫: 抓取花瓣网图片

接触Python也好长时间了,一直没什么机会使用,没有机会那就自己创造机会!呐,就先从爬虫开始吧,抓点美女图片下来. 废话不多说了,讲讲我是怎么做的. 1. 分析网站 想要下载图片,只要知道图片的地址 ...

- Python爬虫 -- 抓取电影天堂8分以上电影

看了几天的python语法,还是应该写个东西练练手.刚好假期里面看电影,找不到很好的影片,于是有个想法,何不搞个爬虫把电影天堂里面8分以上的电影爬出来.做完花了两三个小时,撸了这么一个程序.反正蛮简单 ...

- python爬虫--爬取某网站电影下载地址

前言:因为自己还是python世界的一名小学生,还有很多路要走,所以本文以目的为向导,达到目的即可,对于那些我自己都没弄懂的原理,不做去做过多解释,以免误人子弟,大家可以网上搜索. 友情提示:本代码用 ...

随机推荐

- ubuntu 桌面操作系统安装WPS办公软件的方法

1.打开ubuntu系统自带的firefox软件 2.打开linux.wps.cn,并点击立即下载 3. 点击下载deb安装包 4.进入下载目录,sudo dpkg -i wps-office_10. ...

- libgdx学习记录12——圆角矩形CircleRect

libgdx提供了ShapeRenderer这个工具,用它可以画点.画线.画圆.画矩形.画椭圆.画扇形,但是没有提供画圆角矩形的方法. 刚开始自己尝试分成8端,4端画直线,4端画扇形,发现多了半径几部 ...

- index索引的一些简单理解

index索引(普通索引,允许出现相同的索引内容) 1.索引 索引是在数据量和访问量较大的时候,而出现的一种优化数据库的手段 索引可以提高查询(select)的效率,但相应的,它的 INSERT 与 ...

- Qt QpushButton 实现长按下功能

做项目需要一个按钮具备长时间按下的功能,才发现Qt原始的按钮是没有这个功能,不过Qt的原生按钮是存在按下和释放信号的,有了这两个信号,再来实现按钮长时间被按下,这就简单了,看下动画演示. 录成GIF效 ...

- linux重启tomcat的shell脚本

基本思路: 先检查待重启的tomcat的进程是否存在 存在则执行shutdown. 然后再次检查进程是否还存在,不存在则执行kill 然后删除工作空间及10天前的日志. 最后执行启动. #!/bin/ ...

- DevOps架构下如何进行微服务性能测试?

一. 微服务架构下的性能测试挑战 微服务与DevOps 微服务是实现DevOps的重要架构 微服务3S原则 DevOps核心点 微服务架构下的业务特点 亿级用户的平台 单服务业务随时扩容 服务之间存在 ...

- cf 1029D

题面 题目描述 给定含n个整数的数组a. 规定数x,y的合并为xy.如:数12与数3456的合并为数123456. 有数组中的位置对(i,j)(i≠j),计算使ai,aj的合并能被k整除的位置对数量. ...

- B1015 德才论 (25 分)

19/25 #include<bits/stdc++.h> using namespace std; /* 1.de>=H && cai>=H 2.de> ...

- Intellij IDEA 文件修改提示星号

https://www.cnblogs.com/zheting/p/7594073.html

- 第三次作业--导入excel表格(完整版)

031302322 031302316 将教师排课表导入系统 使用powerdesigner设计数据库表格 设计概念模型 打开new -> Conceptual Data Model创建概念模型 ...