referer的反爬和爬虫下载视频

一、缘由

在梨视频等一些网站中会使用防盗链作为反爬的基础方法,这个反爬并不严重,只是平时的时候需要多加留意。此次实现对应链接中梨视频的下载。

二、代码实现

#1、拿到contid

#2、拿到videoStatus返回的json.-> srcURL

#3、srcURL里面的内容进行修整 成为src

#4、下载视频 import requests url="https://www.pearvideo.com/video_1731253"

contID=url.split("_")[1] videoStatus=f"https://www.pearvideo.com/videoStatus.jsp?contId={contID}&mrd=0.1439190374449233"

headers={

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.90 Safari/537.36",

"Cookie":"__secdyid=0f41d0262006d0b31968d5c88769daa2df68409fa6084e95021622815510; acw_tc=76b20f4316228155101423983e4711fbffe30112131ed2eeeb54cb88ff6047; JSESSIONID=DDBE22CF0FB70CF42DCD429215865C30; PEAR_UUID=a59220d2-0472-4705-bd25-403465b55b93; _uab_collina=162281551309942960271009; UM_distinctid=179d7579fafb-01a4416c1ec026-57442618-144000-179d7579fb062; CNZZDATA1260553744=1690517977-1622811263-https%253A%252F%252Fwww.baidu.com%252F%7C1622811263; Hm_lvt_9707bc8d5f6bba210e7218b8496f076a=1622815515; p_h5_u=0E520F02-6A99-4542-BB7C-0F1C630A2CCD; Hm_lpvt_9707bc8d5f6bba210e7218b8496f076a=1622815518; SERVERID=ed8d5ad7d9b044d0dd5993c7c771ef48|1622815789|1622815510",

"Referer": url

}

resp=requests.get(videoStatus,headers=headers)

dic=resp.json()

srcURL=dic["videoInfo"]["videos"]["srcUrl"]

systemTime=dic["systemTime"]

url_=srcURL.replace(systemTime,"cont-"+contID) with open(r'C:\Users\sunshine\Desktop\i'+contID+".mp4","ab+") as f:

f.write(requests.get(url_).content)

print('over')

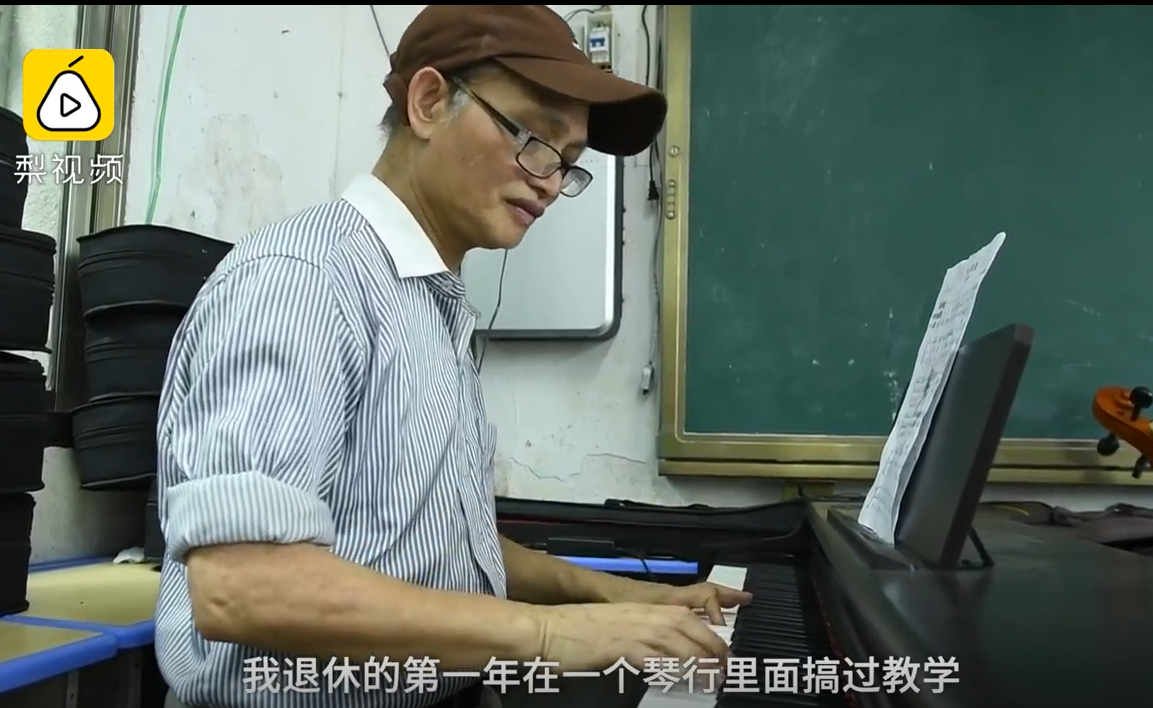

三、结果展示

视频高清

referer的反爬和爬虫下载视频的更多相关文章

- 抖音爬虫教程,python爬虫采集反爬策略

一.爬虫与反爬简介 爬虫就是我们利用某种程序代替人工批量读取.获取网站上的资料信息.而反爬则是跟爬虫的对立面,是竭尽全力阻止非人为的采集网站信息,二者相生相克,水火不容,到目前为止大部分的网站都还是可 ...

- python高级—— 从趟过的坑中聊聊爬虫、反爬以及、反反爬,附送一套高级爬虫试题

前言: 时隔数月,我终于又更新博客了,然而,在这期间的粉丝数也就跟着我停更博客而涨停了,唉 是的,我改了博客名,不知道为什么要改,就感觉现在这个名字看起来要洋气一点. 那么最近到底咋不更新博客了呢?说 ...

- Python爬虫入门教程 61-100 写个爬虫碰到反爬了,动手破坏它!

python3爬虫遇到了反爬 当你兴冲冲的打开一个网页,发现里面的资源好棒,能批量下载就好了,然后感谢写个爬虫down一下,结果,一顿操作之后,发现网站竟然有反爬措施,尴尬了. 接下来的几篇文章,我们 ...

- Python爬虫——反爬

反爬概述 网络爬虫,是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成. 但是当网络爬虫被滥用后,互联网上就出现太多同质的东西,原创得不到保护. 于是,很多网站开始反网络爬 ...

- py3+requests+re+urllib,爬取并下载不得姐视频

实现原理及思路请参考我的另外几篇爬虫实践博客 py3+urllib+bs4+反爬,20+行代码教你爬取豆瓣妹子图:http://www.cnblogs.com/UncleYong/p/6892688. ...

- python爬虫---详解爬虫分类,HTTP和HTTPS的区别,证书加密,反爬机制和反反爬策略,requests模块的使用,常见的问题

python爬虫---详解爬虫分类,HTTP和HTTPS的区别,证书加密,反爬机制和反反爬策略,requests模块的使用,常见的问题 一丶爬虫概述 通过编写程序'模拟浏览器'上网,然后通 ...

- python3爬虫系列19之反爬随机 User-Agent 和 ip代理池的使用

站长资讯平台:python3爬虫系列19之随机User-Agent 和ip代理池的使用我们前面几篇讲了爬虫增速多进程,进程池的用法之类的,爬虫速度加快呢,也会带来一些坏事. 1. 前言比如随着我们爬虫 ...

- 《C# 爬虫 破境之道》:第二境 爬虫应用 — 第六节:反爬策略研究

之前的章节也略有提及反爬策略,本节,我们就来系统的对反爬.反反爬的种种,做一个了结. 从防盗链说起: 自从论坛兴起的时候,网上就有很多人会在论坛里发布一些很棒的文章,与当下流行的“点赞”“分享”一样, ...

- python3爬虫 爬取动漫视频

起因 因为本人家里有时候网速不行,所以看动漫的时候播放器总是一卡一卡的,看的太难受了.闲暇无聊又F12看看.但是动漫网站却无法打开控制台.这就勾起了我的兴趣.正好反正无事,去寻找下视频源. 但是这里事 ...

随机推荐

- Shell脚本中判断字符串是否被包含在内并且使用grep 精确匹配

str1="abcdefgh" str2="def" result=$(echo $str1 | grep "${str2}") if [[ ...

- MySQL手动恢复数据库测试操作

事件背景 MySQL数据库每日零点自动全备 某天上午9点,二狗子不小心drop了一个数据库 我们需要通过全备的数据文件,以及增量的binlog文件进行数据恢复 主要思想与原理 利用全备的sql文件中记 ...

- Optional 常用方法总结

转载请注明出处: Optional 类是 JAVA 8 提供的判断程序是否为空提供的包装工具类:可以减少代码中的 是否为空的判断,以及减少 NullPointerExceptions:使得程序变得更为 ...

- NSIS检测并统计字符串中某个字符个数

!include "LogicLib.nsh" OutFile "检查找字符串中c出现的次数.exe" Name "test" Sectio ...

- SpringMVC访问静态资源的问题。

在项目中引用css和js文件一直出错,反复修改文件路径始终访问不到.究其原因原来是应该在web.xml 文件中添加访问静态资源的默认servlet. 如下. <servlet-mapping&g ...

- 『现学现忘』Git后悔药 — 33、revert撤销(二)

目录 4.一次移除某几次提交 (1)git revert移除某几次提交的修改 (2)git revert 移除某几次连续的提交的修改 5.revert命令常用参数 6.git revert和git r ...

- Hive之权限控制

Hive之权限 一.库级的权限 -- 授予所有权限给某个用户 grant all on msta to user {userName}; -- 授权admin privilege权限 grant AD ...

- vue项目Eslint和prettier结合使用

一.eslint介绍--代码语法检查工具 Eslint是一个代码检查工具,用来检查你的代码语法是否符合指定的规范,ECMAScript标准 二.prettier插件--代码格式化工具 prettier ...

- 齐博x1工单碎片模板制作教程

可以把工单插入到任何频道的内容里边,如下图所示 碎片模板制作标准如下 <form action="{:urls('order/add')}" class="wn_f ...

- .net core-利用PdfSharpCore和SkiaSharp.QrCode 添加PDF二维码页眉

前序 由于去年的一个项目需要在PDF 添加公司二维码 ,当时在网上找了很多操作PDF方案,第一种Aspose.PDF,很遗憾 Aspose.PDF 有添加版权的背景还是页脚我忘记了,不适合公司项目,最 ...