一个python小爬虫

自定义获取豆瓣网电影TOP250里的排名数量

主要思路:先由requests库获取html基本信息,然后用BeautifulSoup来进行html.parser格式解析,逐个获取Tag属性,并且对内容进行字符串切片,字符串匹配,保存得到电影名称,地点,日期。

from bs4 import BeautifulSoup

import requests

import re #由于中文编码的原因需要重新计算中文所占长度

def SuperLen(s):

sum_len=len(s)

chi_len=len(re.sub('[a-zA-Z]','',s))

eng_len=sum_len-chi_len

return (chi_len*2+eng_len)

#此函数功能是准确得到中英文混合字符串所占长度 #由于每页只有25个电影,所以用户需求电影数目不同页数(URL)也就不同

def Get_Page(n):

if n%25!=0:

num=int(n/25)+1

else:

num=int(n/25)

return num

#此函数功能是获取页数 #根据所需参数页数来对应不同的URL

def Num_Get_Soup(n):

url='https://movie.douban.com/top250?start='+str(n)+'&filter='

resul=requests.get(url)

soup=BeautifulSoup(resul.text,'html.parser')

return soup

#此函数功能就是对URL进行requests.get 以获取对应的BeautifulSoup #使用BeautifulSoup

def Get_Name_Date_Locat(nums):

NAME=[]

Date=[]

Locat=[]

for j in range(Get_Page(nums)): #获取页数,进行循环操作

soup=Num_Get_Soup(j*25) #根据不同页数的不同URL获取soup

Name_temp=soup.find_all('img','',limit=25) #获取名称Tag,数目最大且为25

Date_Locat_temp=soup.find_all('p','',limit=25)#获取日期 地点Tag

for i in Name_temp:

NAME.append(i.attrs['alt']) #对获取的Tag获取属性

for l in Date_Locat_temp:

stemp=str(l)

Date.append(re.sub('\D','',stemp.split('\xa0')[-5])[:4]) #对字符串切片后进行字符串匹配获取数字日期

Locat.append(stemp.split('\xa0')[-3]) #字符串切片获取地点

return (NAME,Date,Locat) #此函数功能是格式化写入文件

def Write_text(n,N,D,L):

f=open('result.txt','w')

for i in range(n):

f.write(N[i]+'{}\t'.format((35-SuperLen(N[i]))*' '))

f.write(L[i]+'{}\t'.format((70-len(L[i]*2))*' '))

f.write(D[i])

f.write('\n')

f.close() #函数的开始

def Start():

nums=eval(input('请输入要爬取排名的个数0-250均可'))

print('Please Waitng........')

Name,Date,Locat=Get_Name_Date_Locat(nums)

Write_text(nums,Name,Date,Locat)

print('Complete!') Start()

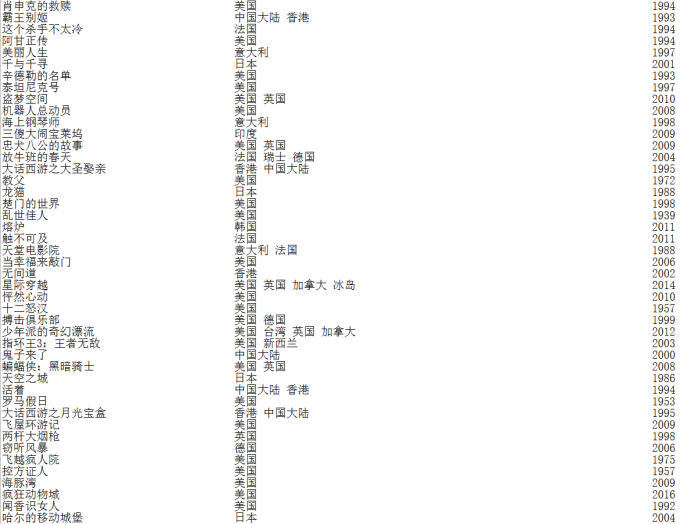

效果图:

可改进思路:正则表达和字符串切片的使用可以再合理一些,格式化保存文件也可以再简化。

一个python小爬虫的更多相关文章

- 第一个Python小爬虫

这个爬虫是参考http://python.jobbole.com/81353/这篇文章写的 这篇文章可能年代过于久远,所以有些代码会报错,然后我自己稍微修改了一下,增加了一个getContentAll ...

- 用Python 3写的一个Spider小爬虫(使用内置urllib模块and正则表达式)

用Python写了一个Spider小爬虫,爬一爬斗鱼“王者荣耀”在线直播的主播及人气

- Day1:第一个python小程序

Day1:第一个python小程序与开发工具Pycharm 一.Hello World C:\Users\wenxh>python Python 3.6.2 (v3.6.2:5fd33b5, J ...

- 第一个python小脚本

第一个python小实验 前言 作为一个工作1年的linux运维搬砖师来说,发现没点开发能力真的是不好混啊.于是下定决心学习python! 直接上刚写的语句(大神莫鄙视) 通过控制台输入一个账号密码, ...

- 【现学现卖】python小爬虫

1.给小表弟汇总一个院校列表,想来想去可以写一个小爬虫爬下来方便些,所以就看了看怎么用python写,到了基本能用的程度,没有什么特别的技巧,大多都是百度搜的,遇事不决问百度啦 2.基本流程就是: 用 ...

- python小爬虫练手

一个人无聊,写了个小爬虫爬取不可描述图片.... 代码太短,就暂时先往这里贴一下做备份吧. 注:这是很严肃的技术研究,当然爬下来的图片我会带着批判性的眼光审查一遍的.... :) #! /usr/ ...

- Python 小爬虫流程总结

接触Python3一个月了,在此分享一下知识点,也算是温故而知新了. 接触python之前是做前端的.一直希望接触面能深一点.因工作需求开始学python,几乎做的都是爬虫..第一个demo就是爬取X ...

- Python小爬虫-自动下载三亿文库文档

新手学python,写了一个抓取网页后自动下载文档的脚本,和大家分享. 首先我们打开三亿文库下载栏目的网址,比如专业资料(IT/计算机/互联网)http://3y.uu456.com/bl-197?o ...

- 发布一个Python小程序:ManHourCalendar

程序诞生的那些事儿 先聊聊背景资料档案.. 大约两年前,我只身前往岛国赚点外快.在那边的派遣制度工作中,存在一个大约叫每月的标准工作时间的概念,按照自家公司跟派遣目标公司(业界称为现场)的合同,规定了 ...

随机推荐

- phthon--------异常处理

一 什么是异常 异常就是程序运行时发生错误的信号(在程序出现错误时,则会产生一个异常,若程序没有处理它,则会抛出该异常,程序的运行也随之终止),在python中,错误触发的异常如下 而错误分成两种 # ...

- Vue的自定义组件之间的数据传递

一,父级传向子级 1,在子级的属性中添加props:['myname',......],参数可以传多个,看具体而定: 2,在父级data中定义好需要传递的变量数据,例如name:"rose& ...

- idea使用错误及技巧总结合集(一)

--- Cannot start process, the working directory 'E:\algorithm\algorithm' does not exist 1.点击run后再点击e ...

- 用户认证:基于jwt和session的区别和优缺点

背景知识: Authentication和Authorization的区别: Authentication:用户认证,指的是验证用户的身份,例如你希望以小A的身份登录,那么应用程序需要通过用户名和密码 ...

- gridview单击选中勾选框

1.Dev2005版本: gridView1.OptionsBehavior.ShowEditorOnMouseUp = false;2.Dev2013版本: gridView1.OptionsBeh ...

- 踩坑学习python自动化测试第一天!

这只是一个标题, # 迭代器与生成器# 迭代器有两个基本的方法:iter() 和 next(). # 字符串,列表或元组对象都可用于创建迭代器:"""list1 = [1 ...

- 第一次作业_ChenHong1998

我的目标 学习到软件工程的实践过程 回想一下你初入大学时对软件工程专业的畅想 当初你是如何做出选择软件工程专业的决定的? 计算机是热门专业,软件工程专业好找工作 你认为过去两年中接触到的课程是否符合你 ...

- Oracle学习笔记之触发器

触发器 触发器(trigger)是一些过程,与表关系密切,用于保护表中的数据,当一个基表被修改(INSERT.UPDATE或DELETE)时,触发器自动执行,例如通过触发器可实现多个表间数据的一致性和 ...

- 页面制作学习笔记:D2.Photoshop切图基础知识

一.什么是切图? 切图就是从网页设计稿中切出网页素材,比如一些小的按钮.小的图片.页面的LOGO.网页的背景图片等. 然后就是页面编码,引入图片资源 在HTML里通过 img 标签引入图片资源 < ...

- The server time zone value 'Öйú±ê׼ʱ¼ä' is unrecognized or represents more than one time zone.

今天用mysql连接数据库时,出现The server time zone value 'Öйú±ê׼ʱ¼ä' is unrecognized or represents more than o ...