实战 | 将Apache Hudi数据集写入阿里云OSS

1. 引入

云上对象存储的廉价让不少公司将其作为主要的存储方案,而Hudi作为数据湖解决方案,支持对象存储也是必不可少。之前AWS EMR已经内置集成Hudi,也意味着可以在S3上无缝使用Hudi。当然国内用户可能更多使用阿里云OSS作为云上存储方案,那么如果用户想基于OSS构建数据湖,那么Hudi是否支持呢?随着Hudi社区主分支已经合并了支持OSS的PR,现在只需要基于master分支build版本即可,或者等待下一个版本释出便可直接使用,经过简单的配置便可将数据写入OSS。

2. 配置

2.1 pom依赖

需要额外添加的主要pom依赖如下

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-aliyun</artifactId>

<version>3.2.1</version>

</dependency>

<dependency>

<groupId>com.aliyun.oss</groupId>

<artifactId>aliyun-sdk-oss</artifactId>

<version>3.8.1</version>

</dependency>

2.2 core-site.xml配置

若需访问OSS,需要修改core-site.xml,关键配置如下

<property>

<name>fs.defaultFS</name>

<value>oss://bucketname/</value>

</property>

<property>

<name>fs.oss.endpoint</name>

<value>oss-endpoint-address</value>

<description>Aliyun OSS endpoint to connect to.</description>

</property>

<property>

<name>fs.oss.accessKeyId</name>

<value>oss_key</value>

<description>Aliyun access key ID</description>

</property>

<property>

<name>fs.oss.accessKeySecret</name>

<value>oss-secret</value>

<description>Aliyun access key secret</description>

</property>

<property>

<name>fs.oss.impl</name>

<value>org.apache.hadoop.fs.aliyun.oss.AliyunOSSFileSystem</value>

</property>

3. 源码

示例源码如下

import org.apache.hudi.QuickstartUtils.*;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.sql.Dataset;

import org.apache.spark.sql.Row;

import org.apache.spark.sql.SparkSession;

import java.io.IOException;

import java.util.List;

import static org.apache.hudi.QuickstartUtils.convertToStringList;

import static org.apache.hudi.QuickstartUtils.getQuickstartWriteConfigs;

import static org.apache.hudi.config.HoodieWriteConfig.TABLE_NAME;

import static org.apache.spark.sql.SaveMode.Overwrite;

public class OssHudiDemo {

public static void main(String[] args) throws IOException {

SparkSession spark = SparkSession.builder().appName("Hoodie Datasource test")

.master("local[2]")

.config("spark.serializer", "org.apache.spark.serializer.KryoSerializer")

.config("spark.io.compression.codec", "snappy")

.config("spark.sql.hive.convertMetastoreParquet", "false")

.getOrCreate();

JavaSparkContext jsc = new JavaSparkContext(spark.sparkContext());

String tableName = "hudi_trips_cow";

String basePath = "/tmp/hudi_trips_cow";

DataGenerator dataGen = new DataGenerator();

List<String> inserts = convertToStringList(dataGen.generateInserts(10));

Dataset<Row> df = spark.read().json(jsc.parallelize(inserts, 2));

df.write().format("org.apache.hudi").

options(getQuickstartWriteConfigs()).

option(TABLE_NAME, tableName).

mode(Overwrite).

save(basePath);

Dataset<Row> roViewDF = spark.read().format("org.apache.hudi").load(basePath + "/*/*/*");

roViewDF.registerTempTable("hudi_ro_table");

spark.sql("select * from hudi_ro_table").show(false);

spark.stop();

}

}

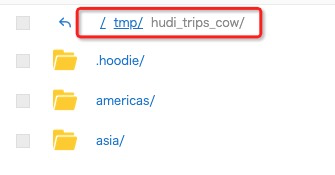

即先写入OSS,下图可以看到OSS的Bucket中已经成功写入了数据,然后再通过spark查询写入的结果。

部分查询结果如下

|20200421205942 |20200421205942_2_10 |6fd496f8-ebee-4f67-8f86-783ff3fed3ab|asia/india/chennai |1f71bed9-833b-4fca-8b4b-4cd014bdf88a-0_2-22-30_20200421205942.parquet|0.40613510977307 |0.5644092139040959 |driver-213|0.798706304941517 |0.02698359227182834|17.851135255091155|asia/india/chennai |rider-213|0.0|6fd496f8-ebee-4f67-8f86-783ff3fed3ab|

所有源代码已经上传至https://github.com/leesf/oss-hudi-demo

4. 最后

本篇文章很简单,只用作展示如何通过Hudi将数据写入OSS。当数据写入OSS后,便可打通阿里云上几乎所有产品,这使得基于阿里云技术栈进行数据湖分析将变得非常简单,比如使用DLA(Data Lake Analytics),对标AWS的Athena,对Hudi数据集进行分析查询,一体化的流程会让分析变得异常简单。

实战 | 将Apache Hudi数据集写入阿里云OSS的更多相关文章

- 上传图片到阿里云OSS和获取上传图片的外网url的步骤

啥都不说 直接上代码 1.html: <form action="/bcis/api/headImgUpload.json" method="post" ...

- 在OneThink(ThinkPHP3.2.3)中整合阿里云OSS的PHP-SDK2.0.4,实现Web端直传,服务端签名直传并设置上传回调的实现流程

在OneThink(ThinkPHP3.2.3)中整合阿里云OSS的PHP-SDK2.0.4,实现本地文件上传流程 by shuijingwan · 2016/01/13 1.SDK安装 github ...

- SpringBoot整合阿里云OSS文件上传、下载、查看、删除

1. 开发前准备 1.1 前置知识 java基础以及SpringBoot简单基础知识即可. 1.2 环境参数 开发工具:IDEA 基础环境:Maven+JDK8 所用技术:SpringBoot.lom ...

- 阿里云OSS下载pdf文件,并在pdf文件上添加水印

代码: 兵马未动,粮草先行 作者: 传说中的汽水枪 如有错误,请留言指正,欢迎一起探讨. 转载请注明出处. 公司要求从阿里云OSS下载pdf文件并且需要添加水印. 因此这里总结一下. 首先添加了一个F ...

- android 阿里云oss上传

购买了阿里云的oss空间,于是用它来存储图片,不过中间的使用算是出了些问题,导致很长的才成功. 不得不说,阿里云文档真的是无力吐槽...乱七八糟的.我完全是东拼西凑,才完成的图片上传功能. 走了很多的 ...

- thinkphp使用阿里云OSS最新SDK,文件部署

这文章是建立在你已经注册号阿里云的OSS,和创建好Bucket前提下: 其实阿里云的帮助与文档写的很详细,这里只说一下源码方式 1.phpsdk下载地址(摘自阿里云OSS的帮助与文档)(也有我自己下载 ...

- 如何用云存储和CDN加速网站图片视频、阿里云OSS的使用(转)

总有人说阿里云主机带宽小,那只是因为你还停留在单机架构上. 阿里的架构设计,云主机主要用来跑程序的,附件的存储和访问主要靠OSS. 有人又会说了,OSS按存储费+流量双重计费伤不起,只是你不知道OSS ...

- 备份MySQL数据库并上传到阿里云OSS存储

1. 环境配置 要将本地文件上传到阿里云oss中, 必须使用阿里云提供的工具 ossutil, 有32位,也有64位的, Linux和Windows都有.具体可以到阿里云官网下载 官网及文档: htt ...

- Java使用阿里云OSS对象存储上传图片

原 Java使用阿里云OSS对象存储上传图片 2017年03月27日 10:47:28 陌上桑花开花 阅读数 26804更多 分类专栏: 工作案例总结 版权声明:本文为博主原创文章,遵循CC 4.0 ...

随机推荐

- 新手必备 | 史上最全的PyTorch学习资源汇总

目录: PyTorch学习教程.手册 PyTorch视频教程 PyTorch项目资源 - NLP&PyTorch实战 - CV&PyTorch实战 PyTorch论 ...

- LightOj 1197 Help Hanzo 区间素数筛

题意: 给定一个区间a,b,a-b>=100000,1<=a<=b<=231,求出给定a,b区间内的素数的个数 区间素数筛 (a+i-1)/ ii向上取整,当a为 i 的整数倍 ...

- python中的函数及作用域的理解

内置函数 常用的几个内置函数 function des len 求长度 min 求最小值 max 求最大值 sorted 排序 reversed 反向 sum 求和 进制转换函数 function d ...

- js 的位运算

api 用途 待更...

- Spring - 事务管理概述

什么是事务管理? 第一个问题:什么是事务? 事务一般是相对数据库而言的,对于数据库一次操作就属于一个事务, 一次操作可以是几句 SQL 语句,也可以是若干行 JDBC 的 Java 语句.事务既然 ...

- iOS UIViewController的瘦身计划

代码的组织结构,以及为何要这样写. 那些场景适合使用子控制器,那些场景应该避免使用子控制器? 分离UITableView的数据源和UITableViewDataSource协议. MVVM的重点是Vi ...

- .Net Web Api返回Json数据中原对象变量名大小写问题

这两天在工作中使用SignalR的WebSocket做数据实时传递的功能开发,在后端主动向前端广播数据以Json传递时,前端获取的Json中对应类的变量名首字母默认传递的是大写.而前端一直获取到的后台 ...

- python—os模块

os模块(操作目录) 1 import os 2 os.rename('旧','新') #修改文件名 3 os.remove('') #删除文件 4 print(os.listdir('.')) # ...

- Ubuntu系统下命令行查看自己已安装的桌面环境问题

原因:有时我们进行远程连接时需要知道我们的Ubuntu系统已安装的桌面环境,这时我们可以使用[dpkg]命令. [dpkg]:dpkg命令是Debian Linux系统用来安装.创建和管理软件包的实用 ...

- flask前后端输出html页面(数组遍历)

通过flask,输出页面 后端代码文件:app.py 前端html文件:output.html 1.打开(app.py) 导入相关模块: 2.定义方法:(app.py) 3.写入与后端定义好的参数:( ...