Python爬虫_豆瓣电视剧

1 import requests

2 import json

3 import csv

4

5

6 class DoubantvSpider:

7 def __init__(self):

8 # self.proxies = {"http":"http://125.123.152.81:3000"}

9 self.url = "https://movie.douban.com/j/search_subjects?type=tv&tag=%E5%9B%BD%E4%BA%A7%E5%89%A7&sort=rank&page_limit=20&page_start={}" # 手机模式下国产剧请求网址

10 self.headers = {"User-Agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.111 Safari/537.36"}

11

12 # 发送请求,获得json,转化为字典

13 def parse_url(self, url):

14 res = requests.get(url, headers=self.headers)

15 return json.loads(res.content.decode())

16

17 # 保存数据

18 def save(self, dic):

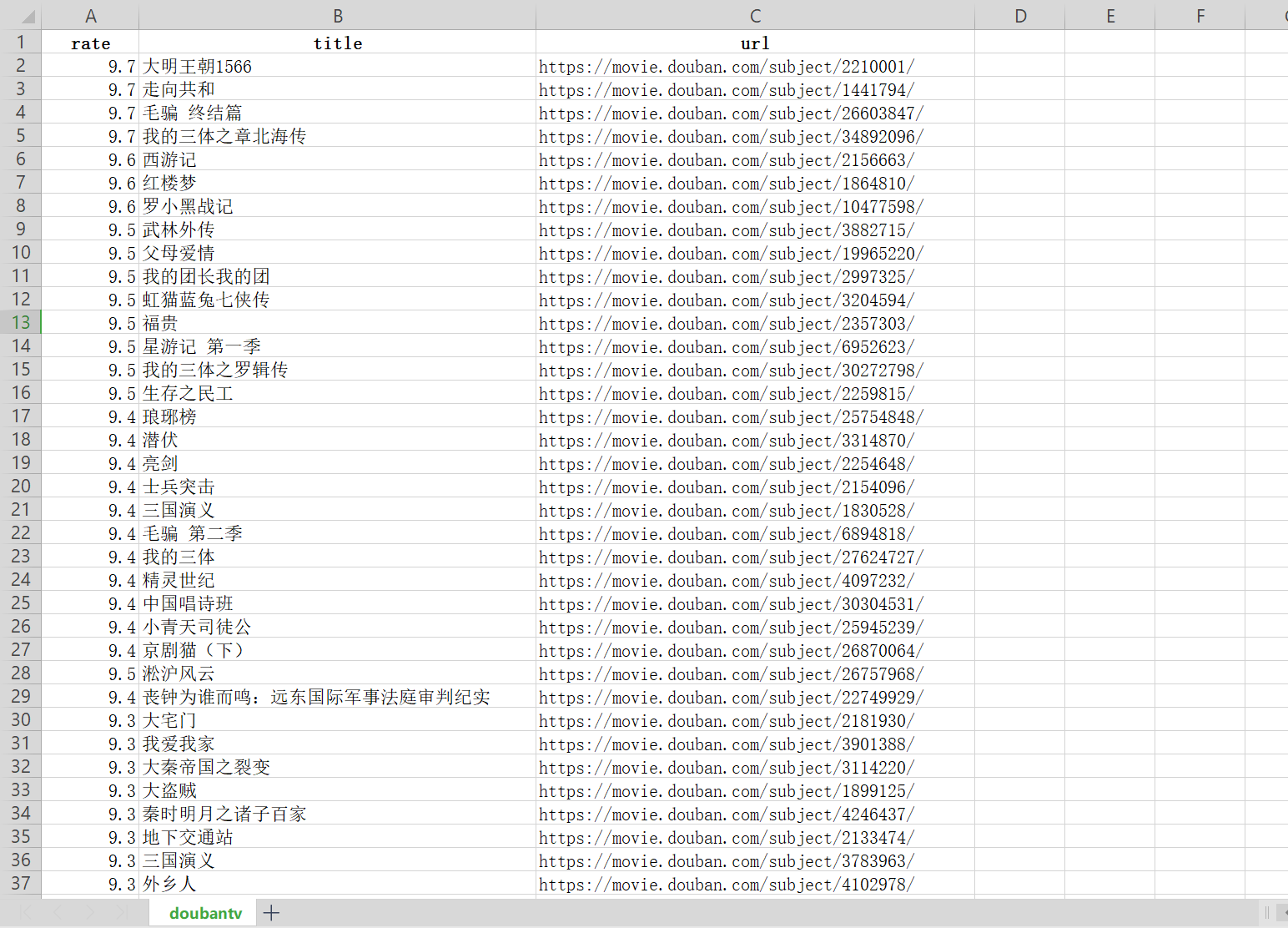

19 with open("doubantv.csv", "a", newline='', encoding="utf8") as f:

20 for data in dic["subjects"]:

21 writer = csv.writer(f, delimiter=',')

22 writer.writerow([data["rate"], data["title"], data["url"]])

23

24 # 实现主要逻辑

25 def run(self):

26 page_num = 0

27 while True:

28 # 构造url

29 url = self.url.format(page_num)

30 # 发送请求,获取响应

31 dic = self.parse_url(url)

32 # 因为动态加载,通过判断每页电视剧数量来确定是不是到了尾页

33 if len(dic["subjects"]) < 20:

34 break

35 self.save(dic)

36 page_num += 20

37 print("ok")

38

39

40 if __name__ == "__main__":

41 doubantv = DoubantvSpider()

42 doubantv.run()

Python爬虫_豆瓣电视剧的更多相关文章

- Springboot+JPA下实现简易爬虫:豆瓣电视剧数据

Springboot+JPA下实现简易爬虫:豆瓣电视剧数据 前言:今天听到产品那边讨论一些需求,好像其中一点是用户要求我们爬虫,在网页上抓取一些数据然后存到我们公司数据库中,众所周知,爬虫的实现对于p ...

- Python爬虫(四)——豆瓣数据模型训练与检测

前文参考: Python爬虫(一)——豆瓣下图书信息 Python爬虫(二)——豆瓣图书决策树构建 Python爬虫(三)——对豆瓣图书各模块评论数与评分图形化分析 数据的构建 在这张表中我们可以发现 ...

- 用Python爬虫对豆瓣《敦刻尔克》影评进行词云展示

最近很想看的一个电影,去知乎上看一下评论,刚好在学Python爬虫,就做个小实例. 代码基于第三方修改 原文链接 http://python.jobbole.com/88325/#comment-9 ...

- Python爬虫之豆瓣-新书速递-图书解析

1- 问题描述 抓取豆瓣“新书速递”[1]页面下图书信息(包括书名,作者,简介,url),将结果重定向到txt文本文件下. 2- 思路分析[2] Step1 读取HTML Step2 Xpath遍历元 ...

- Python爬虫(一)——豆瓣下图书信息

爬虫目的: 随着近年互联网的发展,网络上的信息飞速数量增长.在庞大的数据面前想要获得期望的信息往往如同大海捞针.通过合理的筛选,在百万甚至数亿计的数据中找到所需信息,无疑有着非常大的意义. 在豆瓣网下 ...

- python爬虫_入门_翻页

写出来的爬虫,肯定不能只在一个页面爬,只要要爬几个页面,甚至一个网站,这时候就需要用到翻页了 其实翻页很简单,还是这个页面http://bbs.fengniao.com/forum/10384633. ...

- python爬虫_入门

本来觉得没什么可写的,因为网上这玩意一搜一大把,不过爬虫毕竟是python的一个大亮点,不说说感觉对不起这玩意基础点来说,python2写爬虫重点需要两个模块,urllib和urllib2,其实还有r ...

- 【转】Python爬虫_示例2

爬虫项目:爬取并筛选拉钩网职位信息自动提交简历 一 目标站点分析 #一:实验前准备: 浏览器用Chrome 用Ctrl+Shift+Delete清除浏览器缓存的Cookie 打开network准备 ...

- 【转】Python爬虫_示例

爬虫项目:爬取汽车之家新闻资讯 # requests+Beautifulsoup爬取汽车之家新闻 import requests from bs4 import BeautifulSoup res ...

随机推荐

- 项目管理/Bug管理/问题管理—Phabricator

项目管理/Bug管理/问题管理-Phabricator 1.项目管理/Bug管理/问题管理工具 2.Phabricator 3.Docker 方式安装Phabricator 3.1Docker方式安装 ...

- Redis,JedisPool工具类

Redis,JedisPool工具类 1.JedisPool 详细配置解释代码 2.Jedis工具类 导入相关依赖: commons-pool2-2.3.jar jedis-2.7.0.jar 1.J ...

- 详解Java8特性之新的日期时间 API

详解Java8特性之新的日期时间 API http://blog.csdn.net/timheath/article/details/71326329 Java8中时间日期库的20个常用使用示例 ht ...

- 通过模拟数据,使用js在前端实现模糊查询下拉框功能实例教程

所谓模糊查询就是通过关键字在数据中匹配到包含关键字的数据,而得出的查询结果.本实例教程讲解在前端文本框输入关键字,显示匹配的数据列表功能. 首先得准备一个文本框和显示数据列表的div元素,html代码 ...

- Flink-v1.12官方网站翻译-P014-Flink Architecture

Flink架构 Flink是一个分布式系统,为了执行流式应用,需要对计算资源进行有效的分配和管理.它集成了所有常见的集群资源管理器,如Hadoop YARN.Apache Mesos和Kubernet ...

- HanLP 下载和配置

方式一.Maven 为了方便用户,特提供内置了数据包的Portable版,只需在pom.xml加入: <dependency> <groupId>com.hankcs</ ...

- 2020牛客暑期多校训练营(第四场) C - Count New String (字符串,广义后缀自动机,序列自动机)

Count New String 题意: 定义字符串函数 \(f(S,x,y)(1\le x\le y\le n)\),返回一个长度为y-x+1的字符串,第 i 位是 \(max_{i=x...x+k ...

- Luogu T9376 区间GCD

题目背景 无 题目描述 给定一长度为n的动态序列,请编写一种数据结构,要求支持m次操作,包括查询序列中一闭区间中所有数的GCD,与对一闭区间中所有数加上或减去一个值. 输入输出格式 输入格式: 第1行 ...

- zjnu1716 NEKAMELEONI (线段树)

Description "Hey! I have an awesome task with chameleons, 5 th task for Saturday's competition. ...

- UVA11400 Lighting System Design(DP)

You are given the task to design a lighting system for a huge conference hall. After doing a lot of ...