ubuntu 16.0安装 hadoop2.8.3

环境:ubuntu 16.0

需要软件:jdk ssh

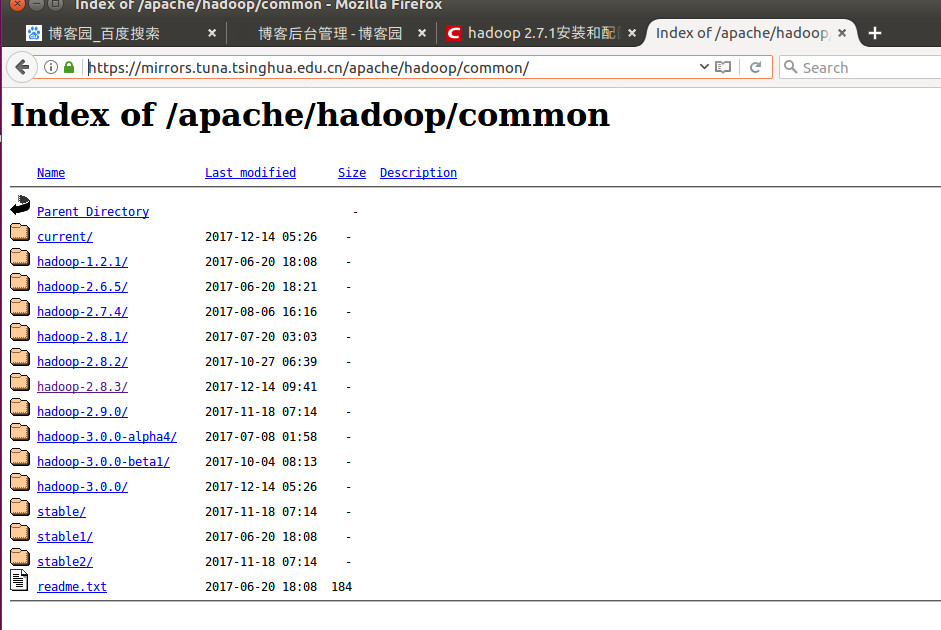

https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/

2.8.3

安装 jdk并配置环境变量

安装ssh和rshync,主要设置免密登录

sudo apt-get install ssh

sudo apt-get install rshync

sh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

ssh

安装hadoop

root@hett-virtual-machine:/usr/local/hadoop# tar -xzvf /home/hett/Downloads/hadoop-2.8.3.tar.gz

root@hett-virtual-machine:/usr/local/hadoop# mv hadoop-2.8.3 hadoop

root@hett-virtual-machine:/usr/local# cd hadoop/

root@hett-virtual-machine:/usr/local/hadoop# mkdir tmp

root@hett-virtual-machine:/usr/local/hadoop# mkdir hdfs

root@hett-virtual-machine:/usr/local/hadoop# mkdir hdfs/data

root@hett-virtual-machine:/usr/local/hadoop# mkdir hdfs/name

root@hett-virtual-machine:/usr/local/hadoop# nano /etc/profile

配置

export HADOOP_HOME=/usr/local/hadoop

export JAVA_HOME=/usr/local/jdk1.8.0_151

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH:$HADOOP_HOME/bin

root@hett-virtual-machine:/usr/local/hadoop# source /etc/profile

root@hett-virtual-machine:/usr/local/hadoop# cd etc/hadoop/

root@hett-virtual-machine:/usr/local/hadoop/etc/hadoop# ls

capacity-scheduler.xml httpfs-env.sh mapred-env.sh

configuration.xsl httpfs-log4j.properties mapred-queues.xml.template

container-executor.cfg httpfs-signature.secret mapred-site.xml.template

core-site.xml httpfs-site.xml slaves

hadoop-env.cmd kms-acls.xml ssl-client.xml.example

hadoop-env.sh kms-env.sh ssl-server.xml.example

hadoop-metrics2.properties kms-log4j.properties yarn-env.cmd

hadoop-metrics.properties kms-site.xml yarn-env.sh

hadoop-policy.xml log4j.properties yarn-site.xml

hdfs-site.xml mapred-env.cmd

root@hett-virtual-machine:/usr/local/hadoop/etc/hadoop#

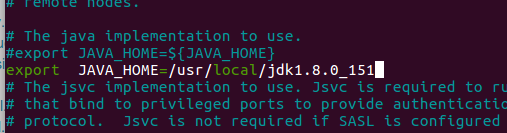

root@hett-virtual-machine:/usr/local/hadoop/etc/hadoop# nano hadoop-env.sh

export JAVA_HOME=/usr/local/jdk1.8.0_151

配置yarn-env.sh

export JAVA_HOME=/usr/local/jdk1.8.0_151

3)配置core-site.xml

添加如下配置:

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

<description>HDFS的URI,文件系统://namenode标识:端口号</description>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/hadoop/tmp</value>

<description>namenode上本地的hadoop临时文件夹</description>

</property>

</configuration>4),配置hdfs-site.xml

添加如下配置

<configuration>

<!—hdfs-site.xml-->

<property>

<name>dfs.name.dir</name>

<value>/usr/hadoop/hdfs/name</value>

<description>namenode上存储hdfs名字空间元数据 </description>

</property>

<property>

<name>dfs.data.dir</name>

<value>/usr/hadoop/hdfs/data</value>

<description>datanode上数据块的物理存储位置</description>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

<description>副本个数,配置默认是3,应小于datanode机器数量</description>

</property>

</configuration>5),配置mapred-site.xml

添加如下配置:

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>6),配置yarn-site.xml

添加如下配置:

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>192.168.241.128:8099</value>

</property>

</configuration>4,Hadoop启动

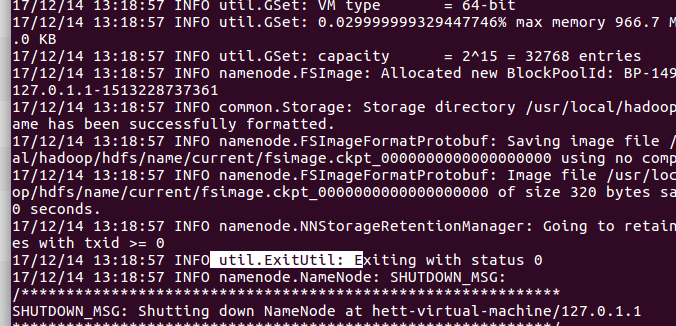

1)格式化namenode

$ bin/hdfs namenode –format

2)启动NameNode 和 DataNode 守护进程

$ sbin/start-dfs.sh3)启动ResourceManager 和 NodeManager 守护进程

$ sbin/start-yarn.sh

- $ cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

- $ ssh-keygen -t rsa # 会有提示,都按回车就可以

- $ cat id_rsa.pub >> authorized_keys # 加入授权

root@hett-virtual-machine:~# cd /usr/local/hadoop/

root@hett-virtual-machine:/usr/local/hadoop# sbin/start-all.sh

This script is Deprecated. Instead use start-dfs.sh and start-yarn.sh

Starting namenodes on [localhost]

localhost: starting namenode, logging to /usr/local/hadoop/logs/hadoop-root-namenode-hett-virtual-machine.out

localhost: starting datanode, logging to /usr/local/hadoop/logs/hadoop-root-datanode-hett-virtual-machine.out

........

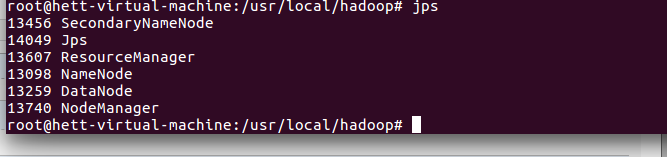

5,启动验证

1)执行jps命令,有如下进程,说明Hadoop正常启动

# jps

6097 NodeManager

11044 Jps

7497 -- process information unavailable

8256 Worker

5999 ResourceManager

5122 SecondaryNameNode

8106 Master

4836 NameNode

4957 DataNode

ubuntu 16.0安装 hadoop2.8.3的更多相关文章

- Ubuntu 16.04安装Vim8.0

Ubuntu 16.04安装Vim8.0 https://www.aliyun.com/jiaocheng/131859.html sudo add-apt-repository ppa:jonath ...

- Ubuntu 16.04 安装Mysql 5.7 踩坑小记

title:Ubuntu 16.04 安装Mysql 5.7 踩坑小记 date: 2018.02.03 安装mysql sudo apt-get install mysql-server mysql ...

- ubuntu 16.04 安装 tensorflow-gpu 包括 CUDA ,CUDNN,CONDA

ubuntu 16.04 安装 tensorflow-gpu 包括 CUDA ,CUDNN,CONDA 显卡驱动装好了,如图: 英文原文链接: https://github.com/williamFa ...

- Ubuntu 16.04 安装 VMware Tools(解决windows和Ubuntu之间不能互相复制粘贴文件的问题)

Ubuntu 16.04安装虚拟工具VMware Tools,指的是在虚拟机VMWare安装Ubuntu 16.04后再安装VMware Tools的过程.很多人接触Linux都是从虚拟机开始,而安装 ...

- Ubuntu 16.04 安装Mysql数据库

系统环境 Ubuntu 16.04; 安装步骤 1.通过以下环境安装mysql服务端与客户端软件 sudo apt-get install mysql-server apt-get isntall m ...

- Ubuntu 16.04安装sogou 拼音输入法

一.更换为国内的软件源 安装搜狗输入法之前请先更换为国内的软件源,否则无法解决依赖问题.首先,用以下命令打开源列表: sudo gedit /etc/apt/sources.list #用文本编辑器打 ...

- ubuntu 16.04 安装Tensorflow

ubuntu 16.04 安装Tensorflow(CPU) 安装python ubuntu 16.04自带python2.7,因此可以略过这一步 安装pip sudo apt-get install ...

- Ubuntu 16.04安装tensorflow_gpu的方法

参考资料: Ubuntu 16.04安装tensorflow_gpu 1.9.0的方法 装Tensorflow,运行项目报错: module compiled against API version ...

- ubuntu 16.04 安装pycharm

Ubuntu16.04下安装Cuda8.0+Caffe+TensorFlow-gpu+Pycharm过程(Simple) ubuntu 16.04 安装pycharm 1.安装java jdk 直接 ...

随机推荐

- 1.16 sqoop options-file参数进行运行任务

sqoop的options-file参数可以像hive的-f 参数那样,执行一个脚本文件,而不是直接在命令行执行: 其中,此脚本文件要遵循一定的格式:参考链接:http://sqoop.apache. ...

- 给source insight添加.cc的C++文件后缀识别(转载)

转自:http://blog.chinaunix.net/uid-9950859-id-99172.html 今天在读mysql代码的时候,发现.cc结尾的文件都没有添加进来,google下了,发现原 ...

- Linux useradd 添加用户

在 linux 中,如果我们想添加一个用户,那么使用的命令如下: 用户管理命令: useradd 基础的命令 命令名称:useradd 命令的所在路径:/usr/bin/useradd 执行权限:ro ...

- 洛谷 - P5030 - 长脖子鹿放置 - 二分图最大独立集

https://www.luogu.org/problemnew/show/P5030 写的第一道黑色题,图建对了. 隐约觉得互相攻击要连边,规定从奇数行流向偶数行. 二分图最大独立集=二分图顶点总数 ...

- 分解gif图片并保存

/** Gif的步骤 1. 拿到Gifd的数据 2. 将Gif分解为一帧帧 3. 将单帧数据转为UIImage 4. 单帧图片保存 */ #import <ImageIO/ImageIO.h&g ...

- 自然语言处理(二)——PTB数据集的预处理

参考书 <TensorFlow:实战Google深度学习框架>(第2版) 首先按照词频顺序为每个词汇分配一个编号,然后将词汇表保存到一个独立的vocab文件中. #!/usr/bin/en ...

- js 判断当前操作系统 ios, android, 电脑端

一 . js判断移动端的操作系统(ios或Android) $(function () { var u = navigator.userAgent; var isAndroid = u.index ...

- 企业级应用,如何实现服务化五(dubbo综合案例)

这是企业级应用,如何实现服务化第五篇.在上一篇企业级应用,如何实现服务化四(基础环境准备)中.已经准备好了zookeeper注册中心,和dubbo管理控制台.这一篇通过一个综合案例,看一看在企业级应用 ...

- Java | 基础归纳 | Map.Entry<String, String>

public class Test { private static Map<String,String> student; private static void init() { st ...

- Debug和Release版本区别

Debug和Release版本区别 众所周知,我们尽心iOS开发,在Xocde调试程序时,分为两种方式Debug和Release,在Target的Setting中相信大家应该能看到很多选项分别为Deb ...