sumafan:python爬虫多线程爬取数据小练习(附答案)

抓取 https://www.cnbeta.com/ 首页中新闻内容页网址,

抓取内容例子: https://hot.cnbeta.com/articles/game/825125

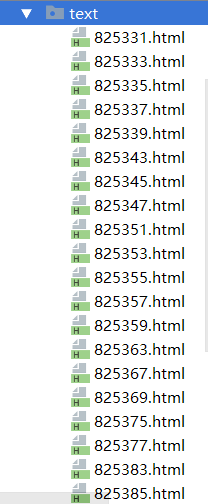

将抓取下来的内容页地址组成list,利用多线程,把所有内容页的内容写入文件,文件名以新闻id命名 以上一篇为例子就是 825125.html。

☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·..·˙˙`·..·☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·☆.·˙˙`·..·☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·..·˙˙`·..·☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·☆.·˙˙`·..·☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·..·˙˙`·..·☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·☆.·˙˙`·..·☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·..·˙˙`·..·☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·☆.·˙˙`·..·☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·..·˙˙`·..·☆`·.·˙˙`·..·˙˙`·..·˙☆`·.·˙˙`·..·˙☆`·.·˙˙`·

很久没有用到线程,看到这题的时候脑袋炸了(稳住不慌!)慌得一笔啊哈哈哈啊哈哈

import requests,time,os

from lxml import etree

import re

import threading #定义请求类

class News(object):

# # # #定义抓取方法

def get_content(self,url):

r = requests.get(url)

html = r.content.decode("utf-8")

# with open('./news.html','w',encoding='utf-8') as f:

# f.write(html)

return html #定义数据匹配方法

def get_data(self,html):

#转换格式

res = etree.HTML(html)

detailurl = res.xpath("//div[@class='item']/dl/a/@href")

# print(detailurl)

urllist = []

for i in detailurl:

a = re.compile(r'^h[\w.:/]*')

res = re.match(a,i)

if res:

urllist.append(i)

# print(urllist)

urllistname=[]

for i in urllist:

name = i[-10:-4:1]

urllistname.append(name)

# print(urllistname)

return urllistname,urllist def write_data(self,a,b):

print(a,b)

res = self.get_content(b)

with open("./text/"+a+'.html','w',encoding='utf-8') as e:

e.write(res) if __name__ == '__main__':

news = News()

html = news.get_content("https://www.cnbeta.com/")

urllistname,urllist = news.get_data(html)

# print(urllist)

for i in range(len(urllist)):

write = threading.Thread(target=news.write_data,args=(urllistname[i],urllist[i]))

write.setDaemon(True)

write.start()

write.join() print('ok')

效果: 点进去就是一个下载后的详情页。

点进去就是一个下载后的详情页。

sumafan:python爬虫多线程爬取数据小练习(附答案)的更多相关文章

- Python爬虫:爬取美拍小姐姐视频

最近在写一个应用,需要收集微博上一些热门的视频,像这些小视频一般都来自秒拍,微拍,美拍和新浪视频,而且没有下载的选项,所以只能动脑想想办法了. 第一步 分析网页源码. 例如:http://video. ...

- [Python爬虫] Selenium爬取新浪微博客户端用户信息、热点话题及评论 (上)

转载自:http://blog.csdn.net/eastmount/article/details/51231852 一. 文章介绍 源码下载地址:http://download.csdn.net/ ...

- 如何手动写一个Python脚本自动爬取Bilibili小视频

如何手动写一个Python脚本自动爬取Bilibili小视频 国庆结束之余,某个不务正业的码农不好好干活,在B站瞎逛着,毕竟国庆嘛,还让不让人休息了诶-- 我身边的很多小伙伴们在朋友圈里面晒着出去游玩 ...

- python爬虫实战---爬取大众点评评论

python爬虫实战—爬取大众点评评论(加密字体) 1.首先打开一个店铺找到评论 很多人学习python,不知道从何学起.很多人学习python,掌握了基本语法过后,不知道在哪里寻找案例上手.很多已经 ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- from appium import webdriver 使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium)

使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium) - 北平吴彦祖 - 博客园 https://www.cnblogs.com/stevenshushu/p ...

- Python爬虫之爬取淘女郎照片示例详解

这篇文章主要介绍了Python爬虫之爬取淘女郎照片示例详解,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧 本篇目标 抓取淘宝MM ...

- Python爬虫之爬取站内所有图片

title date tags layut Python爬虫之爬取站内所有图片 2018-10-07 Python post 目标是 http://www.5442.com/meinv/ 如需在非li ...

- python爬虫项目-爬取雪球网金融数据(关注、持续更新)

(一)python金融数据爬虫项目 爬取目标:雪球网(起始url:https://xueqiu.com/hq#exchange=CN&firstName=1&secondName=1_ ...

随机推荐

- docker 基础之私有仓库

docker-registry 是官方提供的工具,可以用于构建私有的镜像仓库.安装运行 docker-registry容器 在安装了 Docker 后,可以通过获取官方 registry 镜像来运行. ...

- SQL记录-ORACLE 12C初体验

1.部署 2.使用

- HTML第五耍 表格标签

HTML标记语言中可以使用table标签创建表格. 表格由 <table> 标签来定义.每个表格均有若干行(由 <tr> 标签定义),字母 tr 指表格数据(table row ...

- luogu 1484\1792 种树 奇怪的贪心可反悔

1484 种树 此版本是线性的,那么根据链表维护即可: 构建新点,点的左右分别是原整个区间的前驱及后继,再正常维护即可 注意两个版本的维护有所不同 第二个版本的维护直接将左右两点删除 1792 种树2 ...

- volatile的使用场景

单词解释: 乱序执行:指CPU对代码的执行顺序进行乱序优化,但保证各执行代码单元的顺序按指令顺序排列.以达到充分利用处理器的各处理单元的目的.(可以理解成:一个任务有不同的执行单元,这些单元之间有一定 ...

- 初入爬虫(java)

public class CrawlerUtil { public static void main(String [] args) throws IOException { // 创建默认的http ...

- Debian Security Advisory(Debian安全报告) DSA-4414-1 libapache2-mod-auth-mellon security update

Debian Security Advisory(Debian安全报告) DSA-4414-1 libapache2-mod-auth-mellon security update Package:l ...

- UE4 位置转换相关函数

get mouse positionget mouse position scaled by dpiget viewport scaleDeproject Scence to WorldLocal T ...

- 2017CCPC秦皇岛 G题Numbers&&ZOJ3987【大数】

题意: 给出一个数n,现在要将它分为m个数,这m个数相加起来必须等于n,并且要使得这m个数的或值最小. 思路: 从二进制的角度分析,如果这m个数中有一个数某一位为1,那么最后或起来这一位肯定是为1的, ...

- python日志1

import logging # logging.basicConfig(filename='app.log', # format='%(asctime)s - %(name)s - %(leveln ...