Hadoop的简单使用

Hadoop的简单使用

- 使用Hadoop提供的命令行,向文件系统中创建一个文件。

./hadoop fs -put temp.txt hdfs://localhost:8888/

说明:

- ./hadoop 是bin目录下

- fs 表明对文件系统进行操作

- -put 就是传输

- temp.txt 是我要传输的文件

- hdfs://localhost:8888 是hdfs的入口

检测是否成功上传:

然后点击browse the filesystem

可以看到:

一个简单的MapReduce任务

任务说明: 使用Hadoop自动的一个案例,来统计多个文件的的各个单词出现的次数。

步骤如下:

- 通过ssh上传一些文件。为了方便,我们最好上传文本文件。从 apache的extra目录下把文件上传到ubuntu下

- 将这些文件上传到hadoop的文件系统

2.1先创建一个目录

./hadoop fs -mkdir /task1 【如果要看 hadoop有哪些指令,可以 ./hadoop 如果要看 还可以通过 ./hadoop fs 来看分项的命令】

- 将 /home/hsp/test 的所有文件上传到 /task1目录下

./hadoop fs -put /home/hsp/test/*.* /task1

- 执行一个MapReduce任务,这个是已经写好的,自带的,后面详解,现在体验

./bin/hadoop jar hadoop-examples-1.0.3.jar wordcount /task1 /result1

说明:这个指令一定要在 hadoop的bin目录下执行,因为 hadoop-examples-1.0.3.jar 是在hadoop/bin 目录下的.

结果:

- 验证是否正确

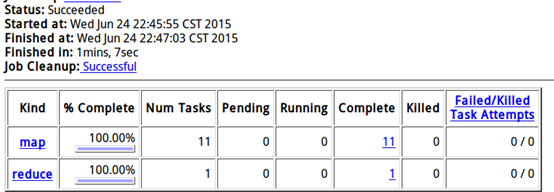

http://localhost:50030 , [这个就是MapReduce的管理界面]可以看到MapReduce 任务的完成情况

点击job_201506...可以看到详细情况,如下:

说明: 这个任务被Map了11个,有一个reduce操作。

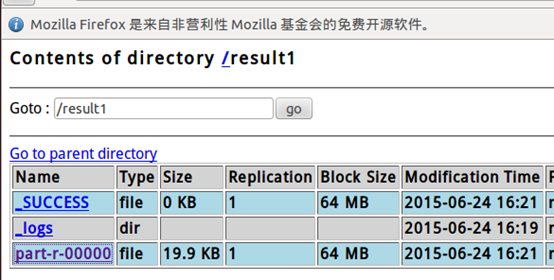

http://localhost:50070 ,点击 part-r-00000 ,就可以看到结果

both 是5次,我们在ubuntu 直接统计一下

grep both /home/hsp/test/*.* 可以看到一个5个

grep both /home/hsp/test/*.*|wc 也可以直接得到结果.

Hadoop的简单使用的更多相关文章

- 结合Hadoop,简单理解SSH

在启动dfs和yarn时,需要多次输入密码,不但启动本机进程还有辅服务器启动那些节点也需要相应密码,主与辅服务器之间是通过SSH连接的,并发送操作指令 一.ssh密码远程登录 1.使用ssh连接另一台 ...

- Linux下Hadoop的简单安装

Hadoop 的安装极为简单,一共只有三步: 安装JDK 安装Hadoop 配置Hadoop 1,安装JDK 下载JDK,ftp传到linux或者linux中下载 切换 ...

- Hadoop RPC简单例子

jdk中已经提供了一个RPC框架-RMI,但是该PRC框架过于重量级并且可控之处比较少,所以Hadoop RPC实现了自定义的PRC框架. 同其他RPC框架一样,Hadoop RPC分为四个部分: ( ...

- Hadoop之简单文件读写

文件简单写操作: import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FSDataOutputStream ...

- Hadoop RPC简单实例

1.导入Hadoop-Common-2.6.0.jar导入工程,里面的IPC实现RPC需要的文件. 2.服务器端 (1)服务接口 package com.neu.rpc.server; /** * ...

- (7)基于hadoop的简单网盘应用实现3

一.login.jsp登陆界面实现 解压bootmetro-master.zip,然后将\bootmetro-master\src\下的assets目录复制到project里. bootmetro下载 ...

- hadoop mapreduce 简单例子

本例子统计 用空格分开的单词出现数量( 这个Main.mian 启动方式是hadoop 2.0 的写法.1.0 不一样 ) 目录结构: 使用的 maven : 下面是maven 依赖. <de ...

- Hadoop的简单序列化框架

Hadoop提供了一个加单的序列化框架API,用于集成各种序列化实现.该框架由Serialization实现. 其中Serialization是一个接口,使用抽象工厂的设计模式,提供了一系列和序列化相 ...

- Hadoop的简单了解与安装

hadoop 一, Hadoop 分布式 简介Hadoop 是分布式的系统架构,是 Apache 基金会顶级金牌项目 分布式是什么?学会用大数据的思想来看待和解决问题 思 想很重要 1-1 . ...

随机推荐

- ThinkPHP空操作和空控制器的处理

所谓的空操作和空控制器,简而言之就是系统中不存在该方法或控制器,导致系统报错(本文版本3.2.3). 正确URL(测试环境): http://oa.com/index.php/admin/publi ...

- 英特尔老款CPU支持虚拟化对照表(转)

说明:一般来说新款的挤牙膏公司出的CPU都基本支持虚拟化,但不包括Atom系列的,也就是小主机低功耗机器使用的CPU. Intel® Virtualization Technology List YE ...

- eclipse and systemtap

http://wiki.eclipse.org/Linux_Tools_Project/Systemtap/User_Guide

- MVC三级联动无刷新

本篇实现有关客户.订单和产品的无刷新三级联动,先看最终效果: 没有选择时,后2个Select状态为禁用: 当选择第1个Select,第2个Select可供选择,第3个Select依旧禁用: 当选择第2 ...

- velocity+spring mvc+spring ioc+ibatis初试感觉(与struts+spring+hibernate比较)

velocity+spring mvc+spring ioc+ibatis框架是我现在公司要求采用的,原因是因为阿里巴巴和淘宝在使用这样的框架,而我公司现在还主要是以向阿里巴巴和淘宝输送外派人员为 主 ...

- java静态初始化数据

1.通过静态成员变量和静态方法组合(比较单一) public class A{ private static String t=getInit(); private static String get ...

- 让子弹飞Demo版

让子弹飞是我非常喜欢的一款游戏.今天的目标就是利用cocos2dx 3.0 和box2d 打造一款这样的类型游戏的Demo版.本来cocos2dx 3.0 已经封装了physicals模块,可是我在使 ...

- 高效的数据压缩编码方式 Protobuf

一. protocol buffers 是什么? Protocol buffers 是一种语言中立,平台无关,可扩展的序列化数据的格式,可用于通信协议,数据存储等. Protocol buffers ...

- Java开发牛人十大必备网站

以下是我收集的Java开发牛人必备的网站.这些网站可以提供信息,以及一些很棒的讲座, 还能解答一般问题.面试问题等.质量是衡量一个网站的关键因素,我个人认为这些网站质量都很好.接下来,我会跟大家分享我 ...

- GUI程序设计2

8. 按钮(JButton)使用示例 例14. 按钮使用示例. package GUI; import java.awt.BorderLayout; import java.awt.Container ...