[DB] Kafka

介绍

- 一种高吞吐量的分布式发布订阅消息系统

- 消息类型:主体Topic(广播)、队列Queue(一对一)

- 消息系统类型:同步消息系统、异步消息系统

- 常见消息产品:Redis、Kafka、JMS

术语

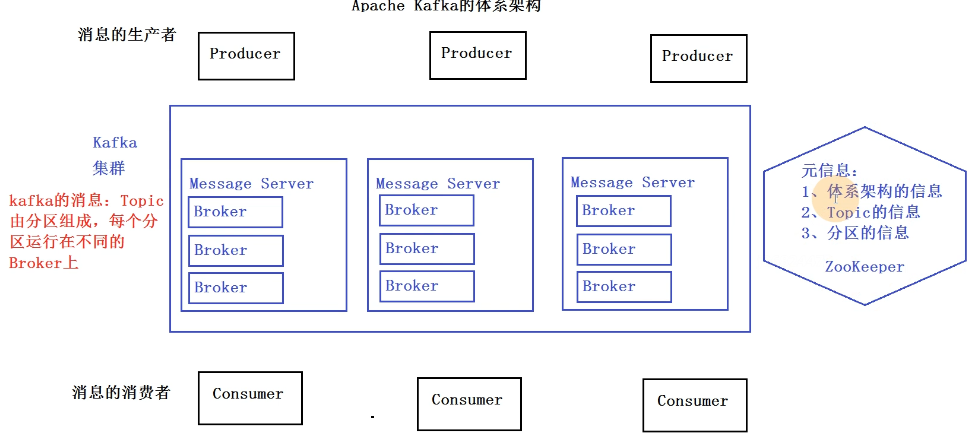

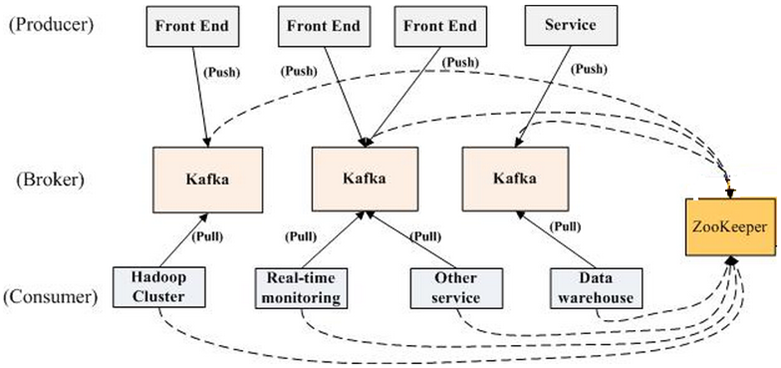

- Producer:生产者,向 Kafka Broker 上的 Topic 发布消息的应用程序

- Broker:缓存代理服务进程,一个Kafka 集群由多个 Broker 组成,Broker 负责接收和处理客户端发送过来的请求,以及对消息进行持久化

- Message:消息,通信的基本单位,每个 Producer 可以向一个 Topic 发布消息

- Topic:承载消息的逻辑容器,在实际使用中多用来区分具体的业务

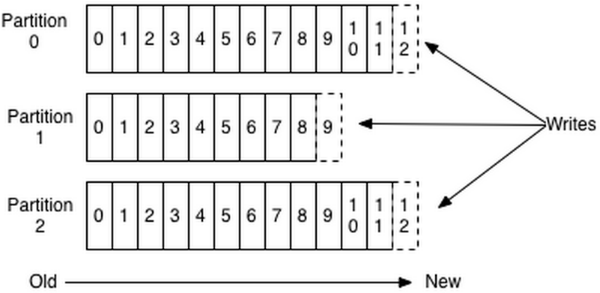

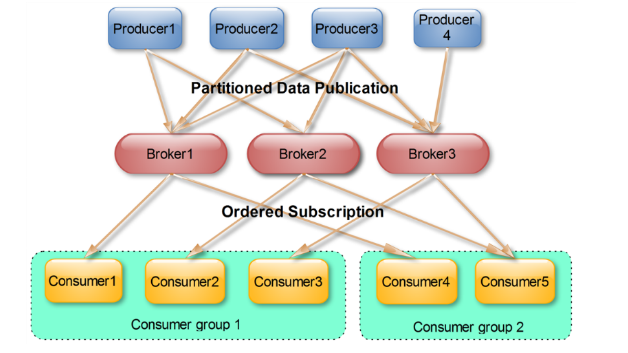

- Partition:Topic物理上的分组,一个Topic可以分为多个Partition,每个Partition是一个有序的队列。Partition中的每条消息都会被分配一个有序的id(Offset),一个分区对应一个消费者

- Consumer:消费者,订阅 Topics 并从上面拉取消息的应用程序

- Group:消费组,多个消费者组成一个消费组

- Offset:表示分区中每条消息的位置信息,是一个单调递增且不变的值,消费者在消费的过程中使用 Offset 记录自己消费了多少数据。老版本用zookeeper存储offset,当consumer宕机重启后读取offset,从上次消费截止的地方继续消费。新版本将offset作为普通消息存在kafka中,提交到__consumer_offsets中保存

- Coordinator:协调者,为 Consumer Group 服务,负责为 Group 执行 Rebalance 以及提供位移管理和组成员管理等,所有 Broker 都有各自的 Coordinator 组件

流程

- Producer将消息推送到Broker,Consumer从Broker拉取消息

- 每条消息被顺序写入到Partition中

- 同一Topic的一条消息只能被同一个Consumer Group内的一个Consumer消费,多个Consumer Group可同时消费这一消息

- 将 Consumer 的位移数据作为一 条条普通的 Kafka 消息,提交到位移主题 __consumer_offsets 中

- Kafka 集群中的第一个 Consumer 程序启动时,Kafka 会自动创建位移主题

设计要点

- 内存访问:使用Linux文件系统的cache,高效缓存数据

- 磁盘持久化:不再内存中cache,直接顺序写入磁盘

- zero-copy:减少IO操作

- 消息处理:支持数据批量发送压缩

- 主题分区:Topic 划分为多个 Partition,提高消息处理并行度

- 负载均衡:Producer 根据用户指定算法,将消息发送到指定的 Partition

- 消息拉取:简化kafka设计,Consumer根据消费能力自主控制消息拉取速度,自主选择消费模式

- 可扩展性:需要增加 Broker结点时,新增 Broker向 ZK 注册,Procucer 和 Consumer根据 ZK 上的 Watcher 调整

应用场景

- 消息队列

- 行为跟踪

- 元信息监控

- 日志收集

- 流处理

命令

- Broker配置文件:config/server.properties

- id:0

- 端口:9092

- zookeeper:localhost:2181

- 启动:bin/kafka-server-start.sh config/server.properties &

- 创建主题:bin/kafka-topics.sh --create --zookeeper localhost:2181 -replication-factor 1 --partitions 3 --topic mydemo1

- 列出主题:bin/kafka-topics.sh --zookeeper bigdata111:2181 --list

- 删除主题:bin/kafka-topics.sh --zookeeper bigdata111:2181 --delete --topic mydemo1

- 生产者(发送消息):bin/kafka-console-producer.sh --broker-list localhost:9092 --topic mydemo1

- 消费者(接收消息)

- bin/kafka-console-consumer.sh --zookeeper localhost:2181 --topic mydemo1(老版本)

- bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic mydemo1(新版本)

参考

Kafka 教程

https://blog.csdn.net/hmsiwtv/article/details/46960053

https://www.orchome.com/kafka/index

https://www.cnblogs.com/wq3435/p/8001094.html

Kafka 中 bootstrap-server broker-list 和 zookeeper的区别

https://www.cnblogs.com/tonglin0325/p/8810313.html

Kafka offset

https://www.cnblogs.com/wq3435/p/8001094.html

CDH Kafka

https://www.cnblogs.com/yangshibiao/p/10868615.html

SparkStreaming Kafka

https://www.jianshu.com/p/667e0f58b7b9

Exactly Once

https://blog.csdn.net/liangyihuai/article/details/82931140

Resetting first dirty offset of __consumer_offsets

https://www.pianshen.com/article/3368623605/

[DB] Kafka的更多相关文章

- Kafka监控系统Kafka Eagle:支持kerberos认证

在线文档:https://ke.smartloli.org/ 作者博客:https://www.cnblogs.com/smartloli/p/9371904.html 源码地址:https://gi ...

- Kafka监控系统Kafka Eagle剖析

1.概述 最近有同学留言反馈了使用Kafka监控工具Kafka Eagle的一些问题,这里笔者特意整理了这些问题.并且希望通过这篇博客来解答这些同学的在使用Kafka Eagle的时候遇到的一些困惑, ...

- kafka监控kafka-eagle 容器化配置

由于kafka.zk 集群已经部署在k8s中, kafka的服务名 kafka-hs, zk的服务名为:zk-cs ,对kafka进行监控,所以需要把监控部署到k8s中,选择使用kafka-eagl ...

- Kafka集群监控工具之二--Kafka Eagle

基于kafka: kafka_2.11-0.11.0.0.tgz kafka-eagle-bin-1.2.1.tar.gz 1.下载解压 tar -zxvf kafka-eagle-bin-1.2.1 ...

- Kafka学习之(七)搭建kafka可视化服务Kafka Eagle

一.下载安装包 kafka-eagle-bin-1.2.4.tar.gz 百度云链接:链接:https://pan.baidu.com/s/1SNIkpsvs20A_Ljtx5PaMuA 密码:o4 ...

- 使用canal获取mysql的binlog传输给kafka,并交由logstash获取实验步骤

1. 实验环境 CPU:4 内存:8G ip:192.168.0.187 开启iptables防火墙 关闭selinux java >=1.5 使用yum方式安装的java,提前配置好JAVA_ ...

- Kafka Eagle 安装

Kafka Eagle 是一款开源的 Kafka 集群监控系统. 一.下载 https://download.kafka-eagle.org/ 二.安装 # 解压 .tar.gz -C /opt/ / ...

- 使用kafka-eagle监控Kafka

# 监控kafka集群,开启监控趋势图使用 # 有一个问题,需要在kafka-server-start.sh文件中配置端口,有如下三种办法 # 第一种:复制并修改kafka目录,比如kafka-1,k ...

- Kafka Eagle安装详情及问题解答

1.概述 最近有很多同学给笔者留言,说在安装Kafka Eagle的时候,会遇到一些问题,请教如何解决?今天笔者就在这里总结一下安装步骤,和一些安装的注意事项,以及解决方式. 2.内容 在安装Kafk ...

随机推荐

- Codecept实现前端自动化测试

前言 CodeceptJS是一款UI测试自动框架,它结合了很多市面常见的UI测试自动化框架,封装了大量的API,使得我们编写自动化脚本非常方便,而且相关文档也非常齐全.Codecept.js官网htt ...

- 如何在O(1)时间复杂度获取栈中最大值和最小值

问题描述: 如何在O(1)时间复杂度获取栈中的最大值和最小值? 问题分析: 普通栈规定的push(入栈).pop(出栈).peek(查看栈顶)等操作都只能在栈顶上操作,如果栈中元素是有序的,那么我们就 ...

- CodeForces CF877D题解(BFS+STL-set)

解法\(1:\) 正常的\(bfs\)剪枝是\(\Theta(nm4k)\),这个时间复杂度是只加一个\(vis\)记录的剪枝的,只能保证每个点只进队一次,并不能做到其他的减少时间,所以理论上是过不了 ...

- Elasticsearch中最重要的文档CRUD要牢记

Elasticsearch文档CRUD要牢记 转载参考:https://juejin.im/post/5ddbf298e51d4523053c42e7 在Elasticsearch中,文档(docum ...

- python3使用tracemalloc追踪mmap内存变化

技术背景 在前面一篇博客中我们介绍了一些用python3处理表格数据的方法,其中重点包含了vaex这样一个大规模数据处理的方案.这个数据处理的方案是基于内存映射(memory map)的技术,通过创建 ...

- JS基础学习第三天

条件分支语句switch语句语法: 1234567891011121314 switch(条件表达式){ case 表达式: 语句... break; case 表达式: 语句... break; c ...

- SQL Server如何将查询的内容保存到新的sql 表中

我是采用语句将 查询后的数据保存到一个新表中 1)采用into table 语句,需要保存到的这个新表不需要提前创建 select *into NewTable from Table --插入新表的语 ...

- day14.面向对象编程

一 对象的概念 "面向对象"的核心是"对象"二字,而对象的精髓在于"整合" 所有的程序都是由"数据"与"功能& ...

- Day06_30_抽象类(Abstract)

抽象类 Abstract 什么是抽象类? 在面向对象的概念中,所有的对象都是通过类来描绘的,但是反过来,并不是所有的类都是用来描绘对象的,如果一个类中没有包含足够的信息来描绘一个具体的对象,这样的类就 ...

- Appium 自动化测试框架:关键字驱动+数据驱动

1. 关键字驱动框架简介 2. 框架结构说明 3. 框架代码实现 action 包 page_action.py business_process 包 case_process.py data_so ...