论文《policy-gradient-methods-for-reinforcement-learning-with-function-approximation 》的阅读——强化学习中的策略梯度算法基本形式与部分证明

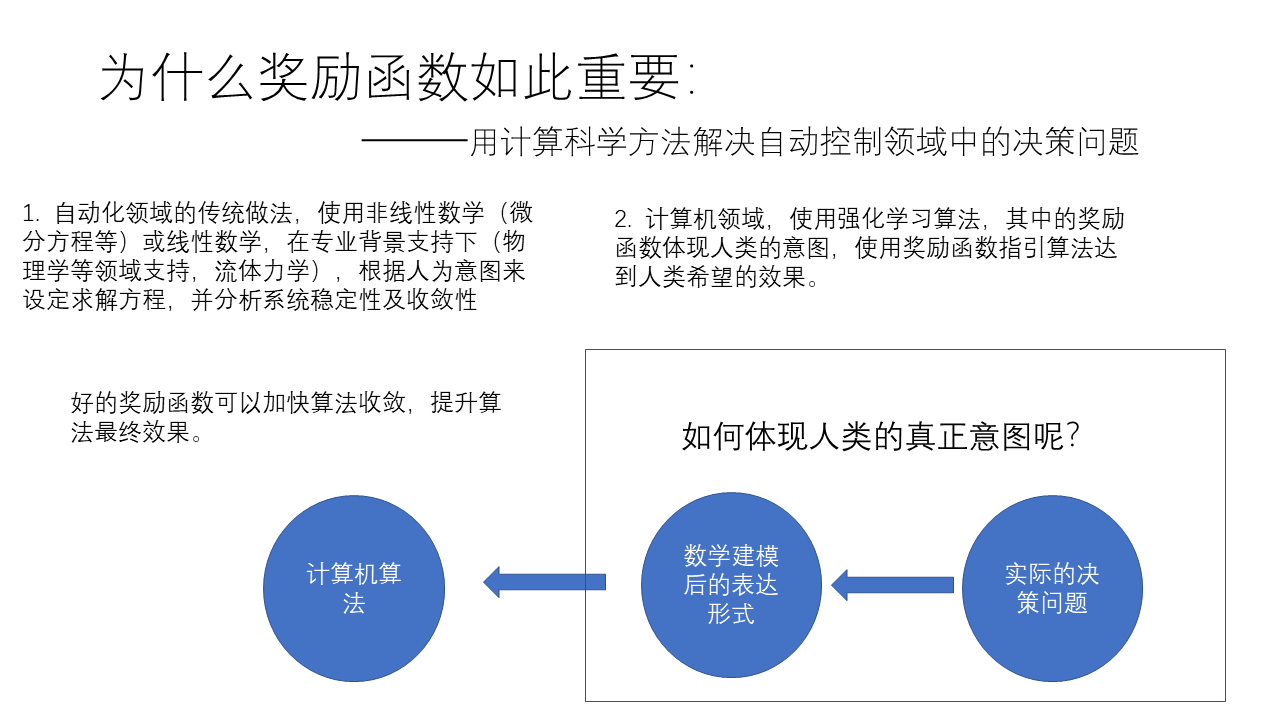

最近组会汇报,由于前一阵听了中科院的教授讲解过这篇论文,于是想到以这篇论文为题做了学习汇报。论文《policy-gradient-methods-for-reinforcement-learning-with-function-approximation 》虽然发表的时间很早,但是确实很有影响性,属于这个领域很有里程牌的一篇论文,也是属于这个领域的研究者多少应该了解些的文章。以下给出根据自己理解做成的PPT。

---------------------------------------------------------------------------------

后注:

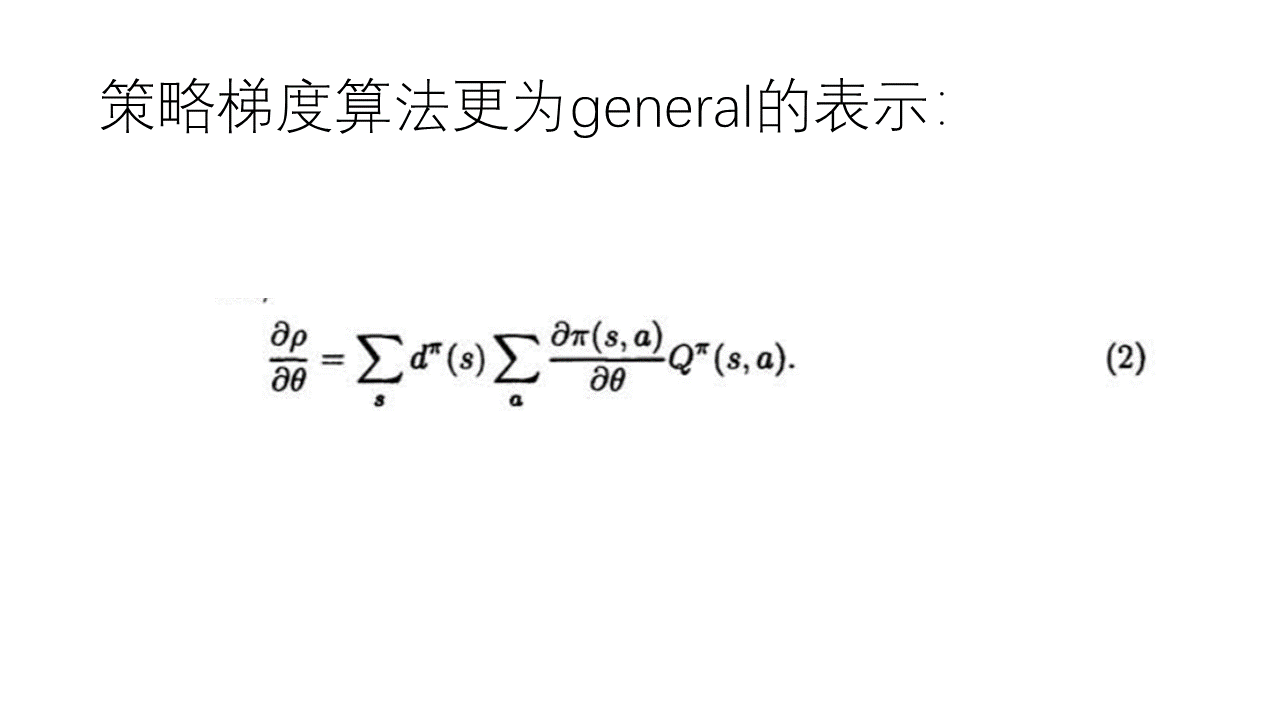

其实,很多人觉得这个推导就是多此一举,这个公式和证明根本没有必要,因为这个公式本身就是显而易见的,原因如下:

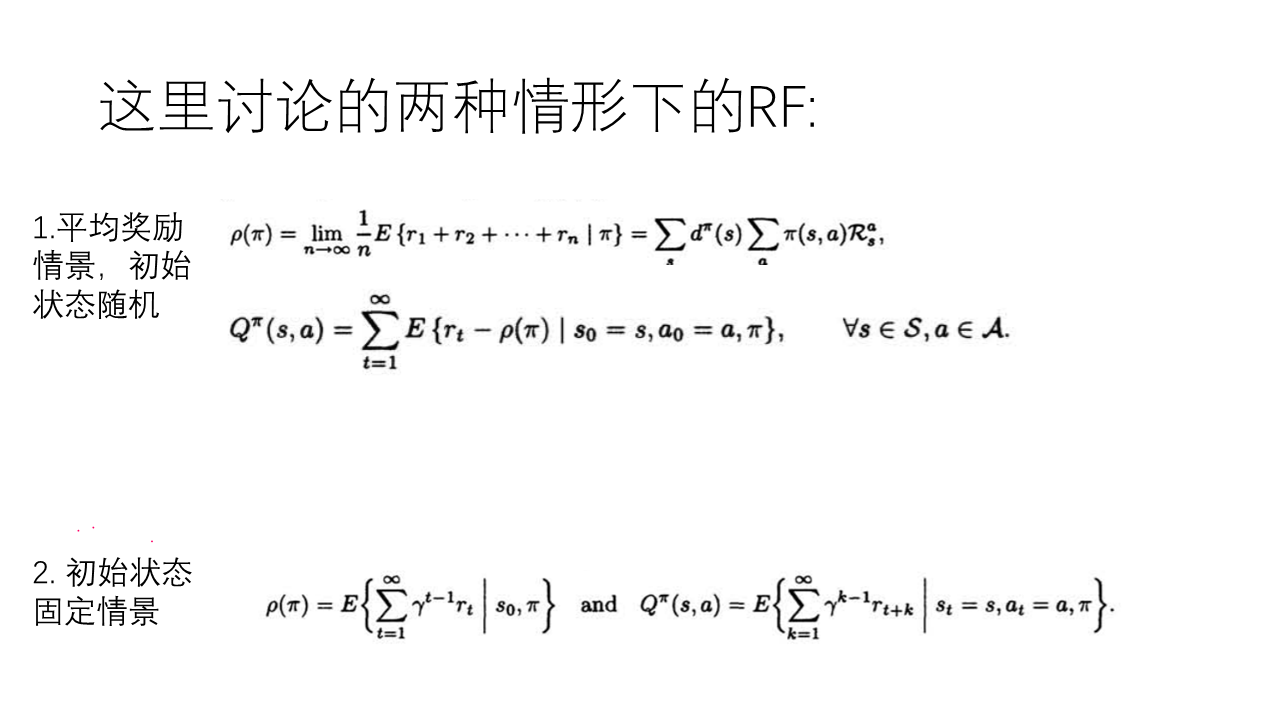

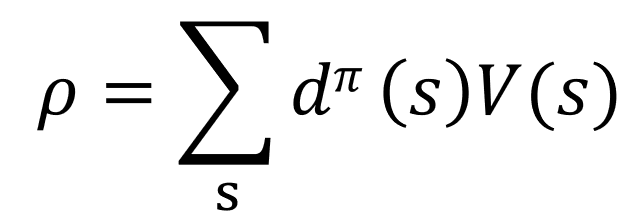

已知(根据MDP及强化学习的定义有):

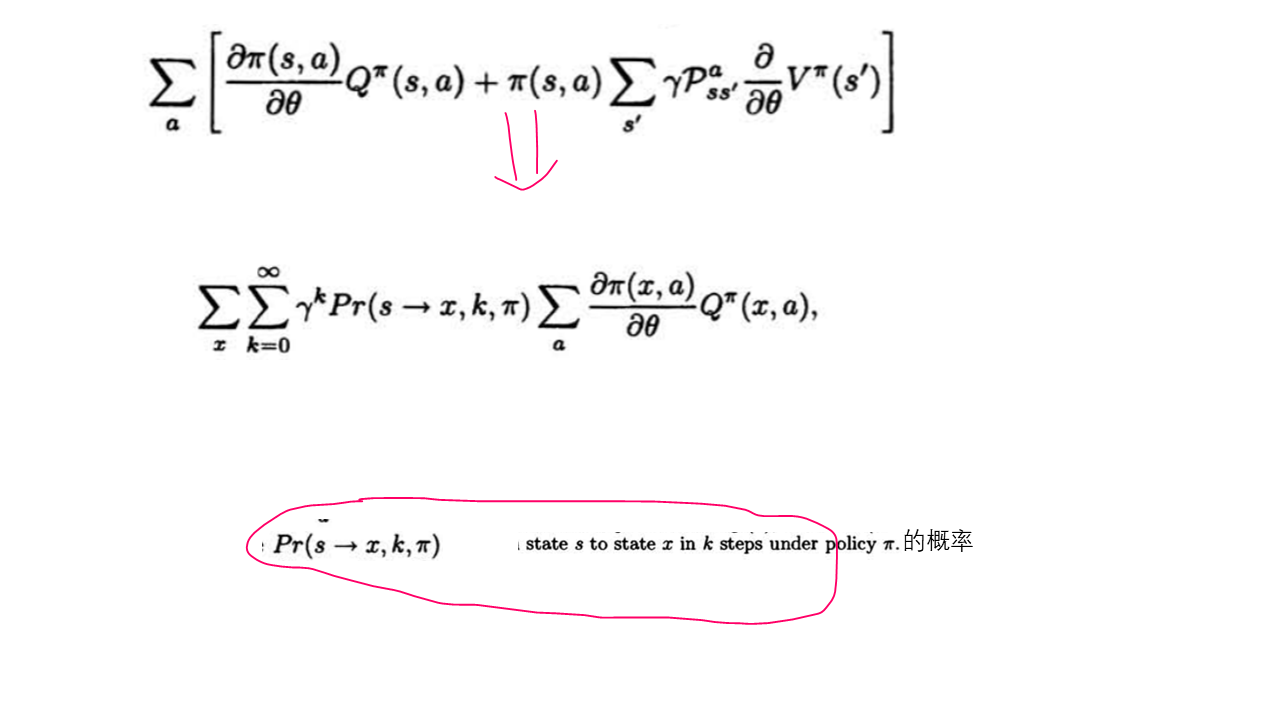

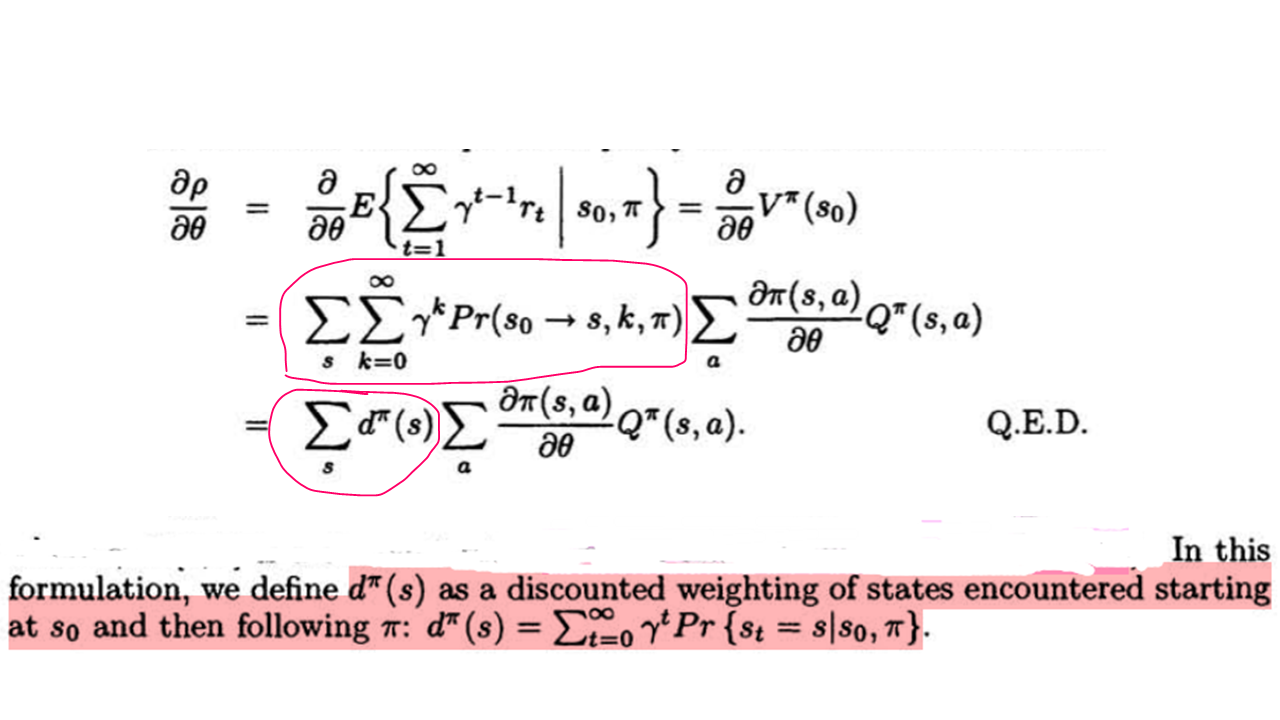

公式(1):

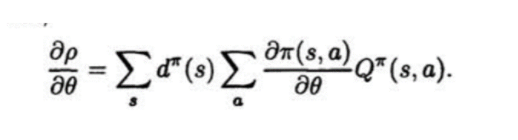

公式(2):

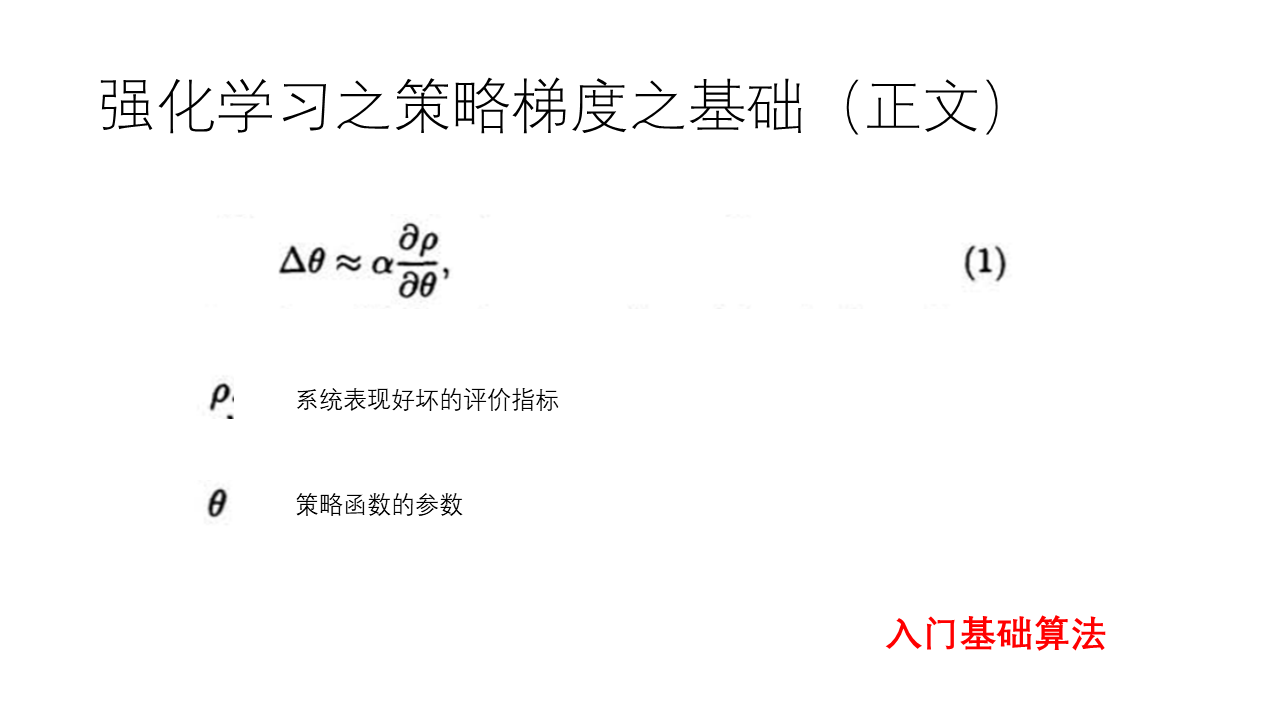

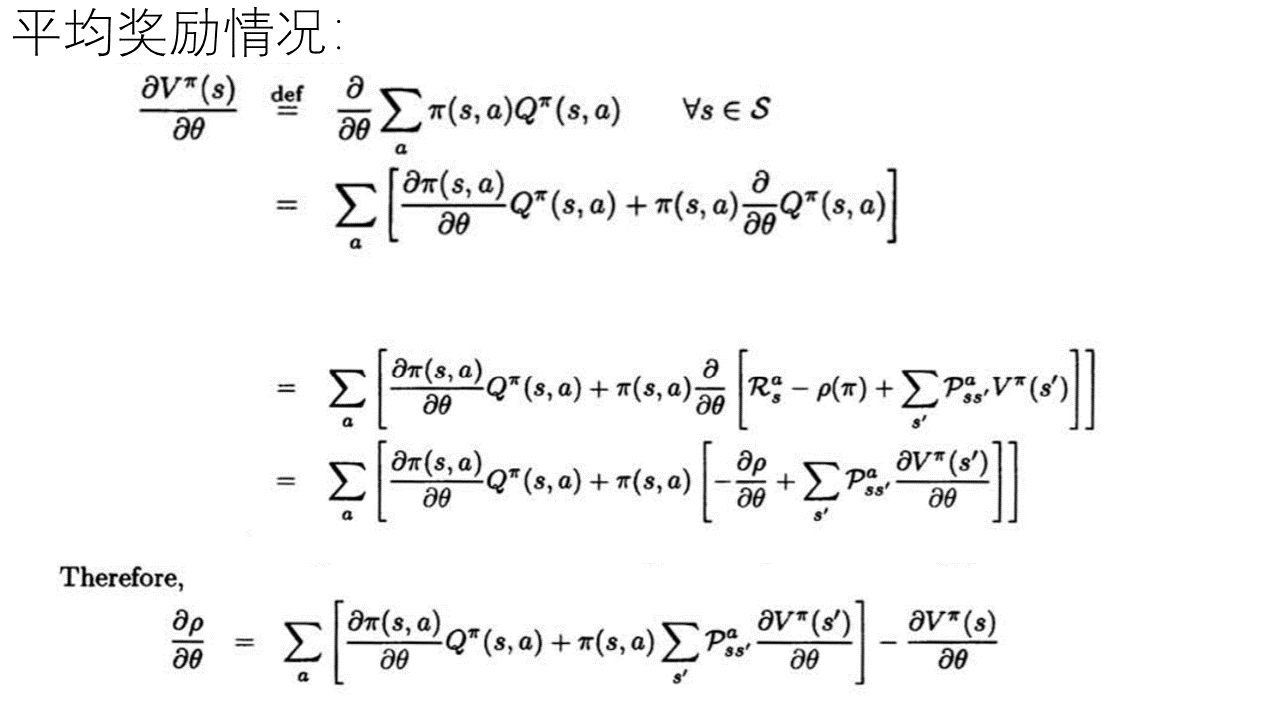

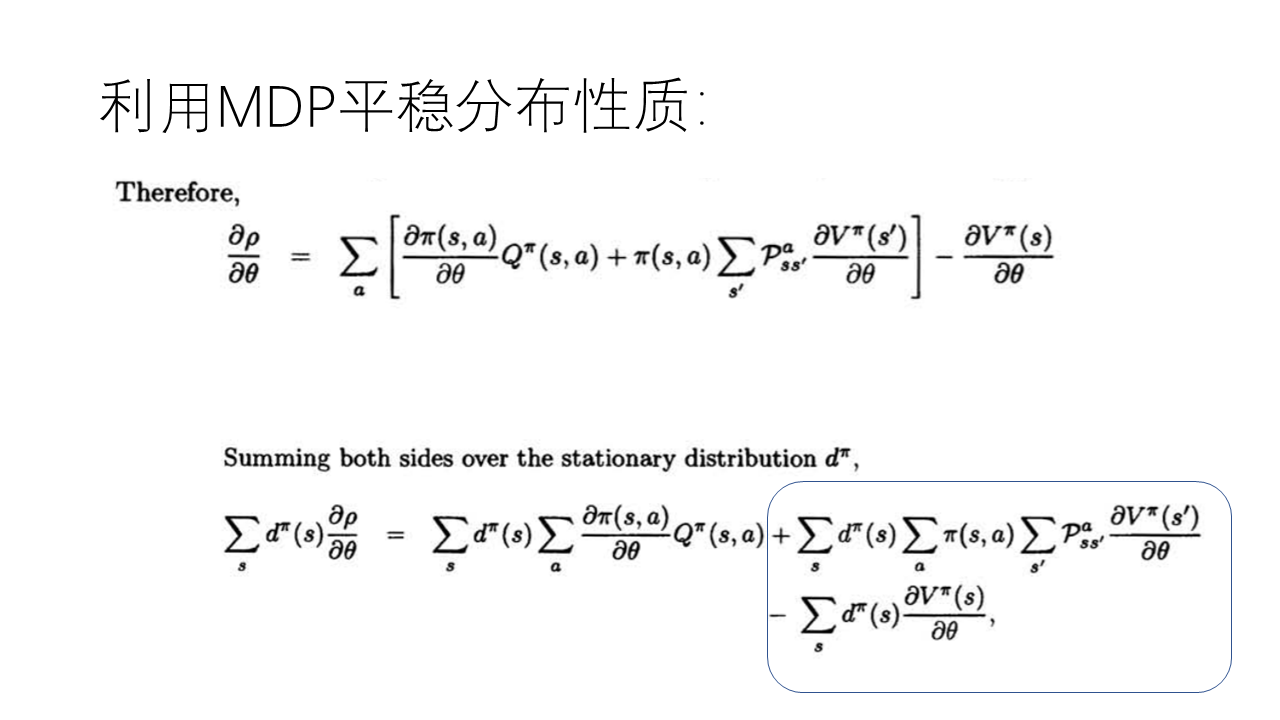

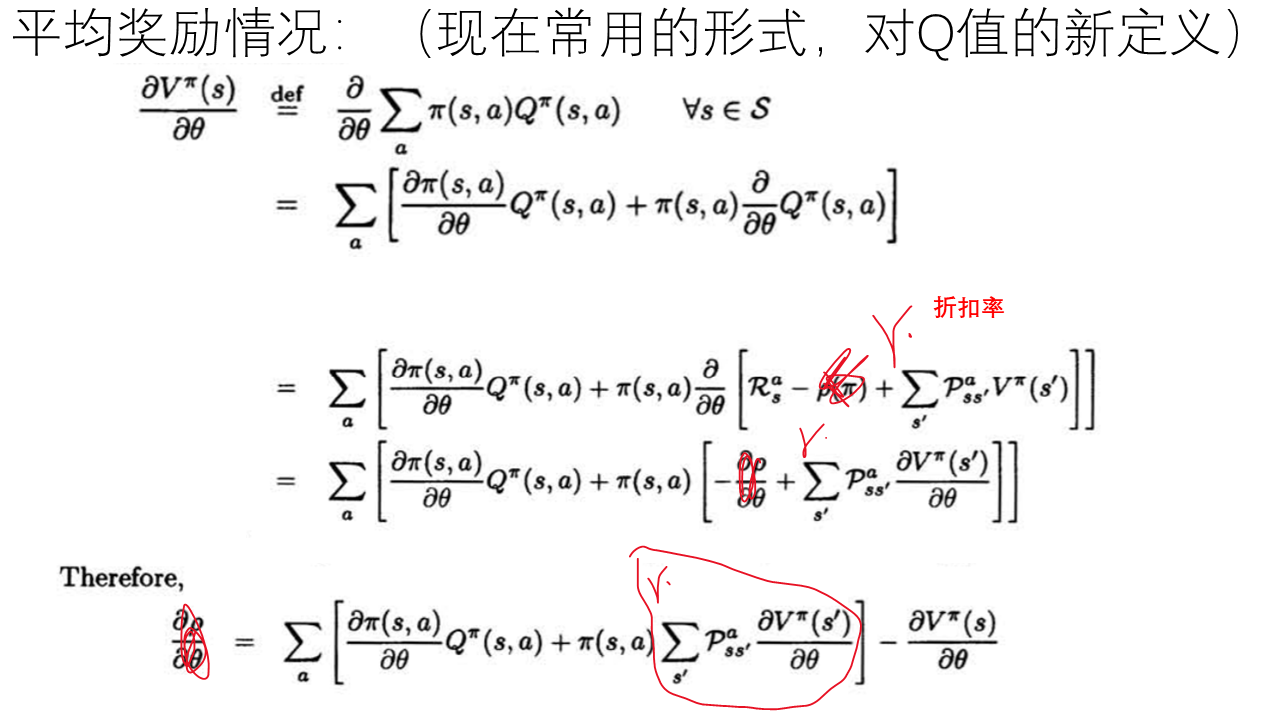

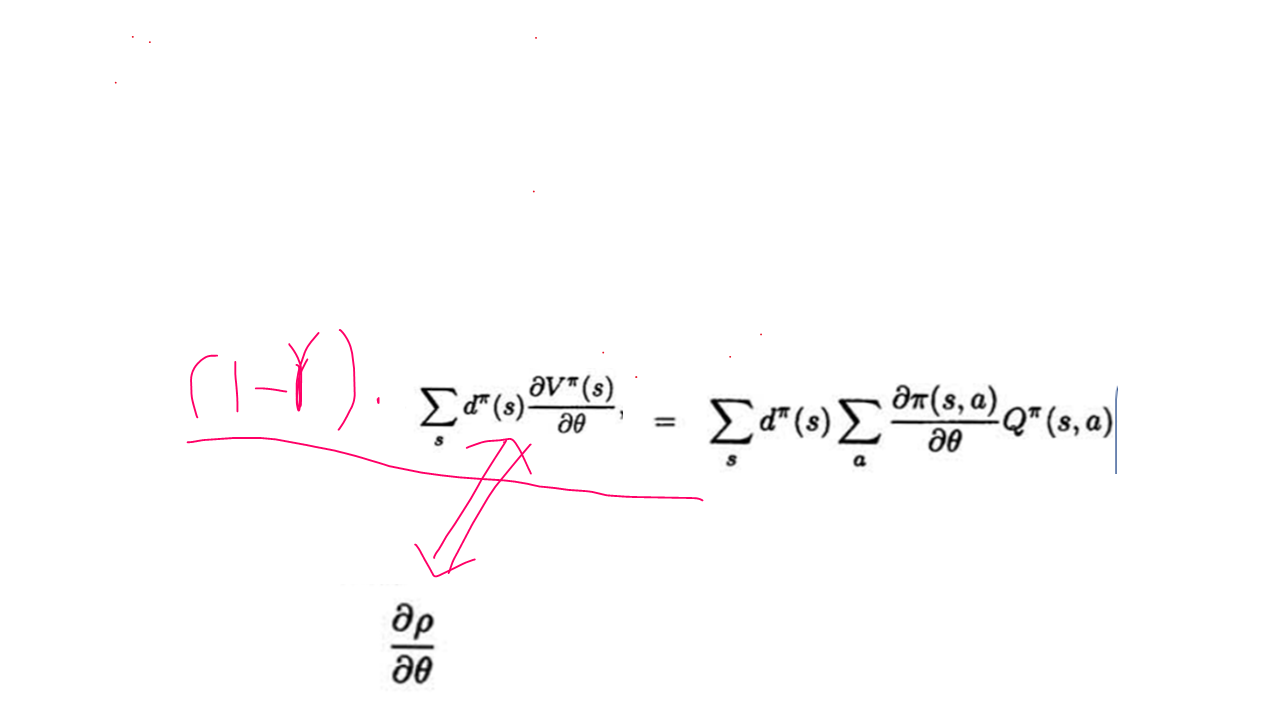

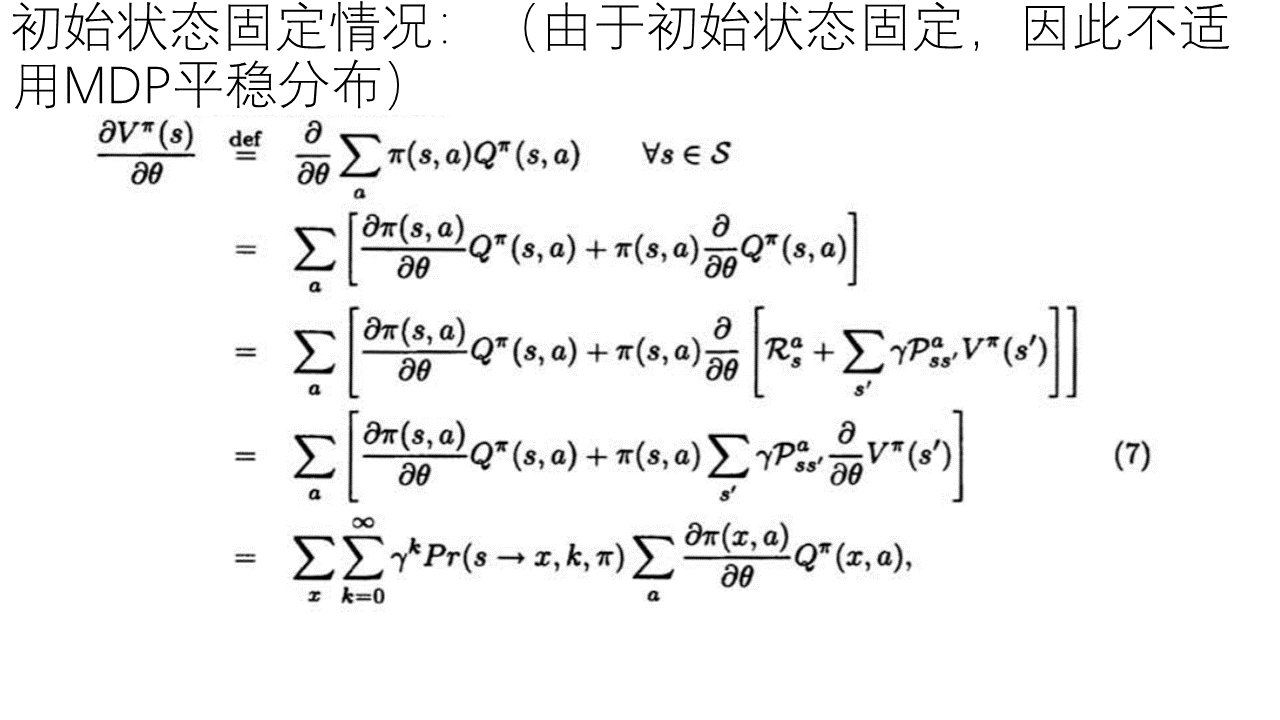

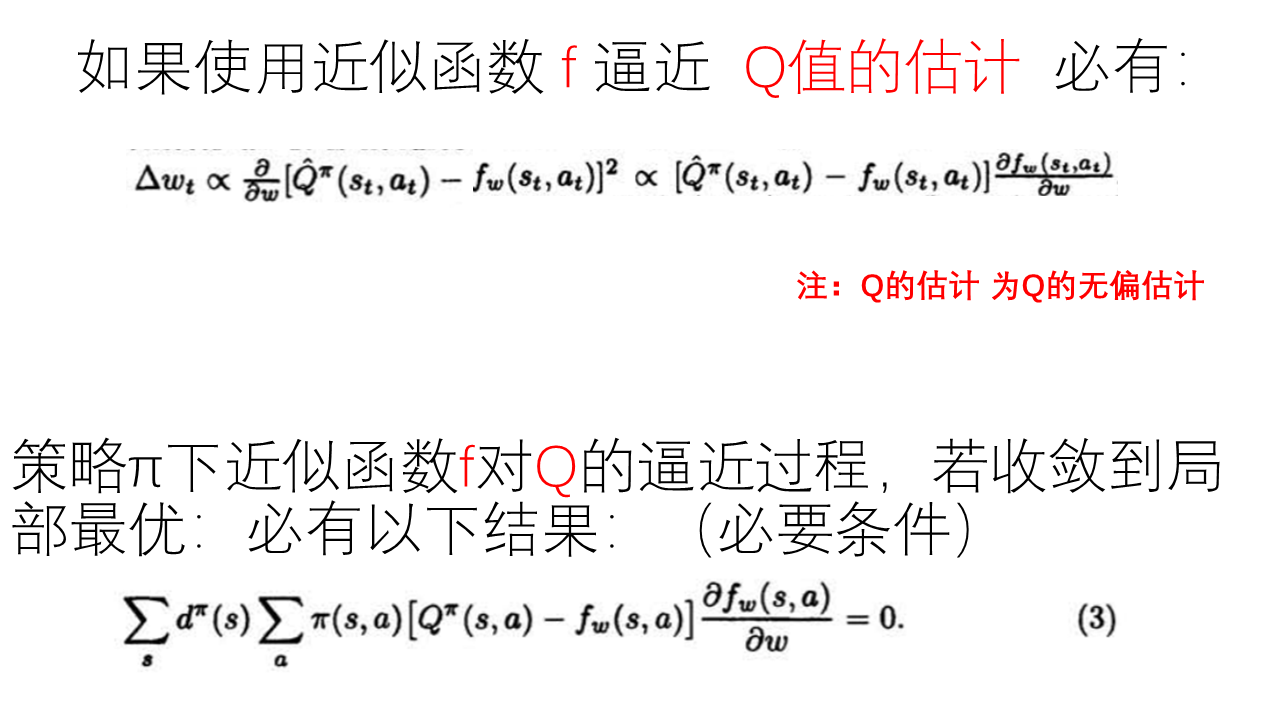

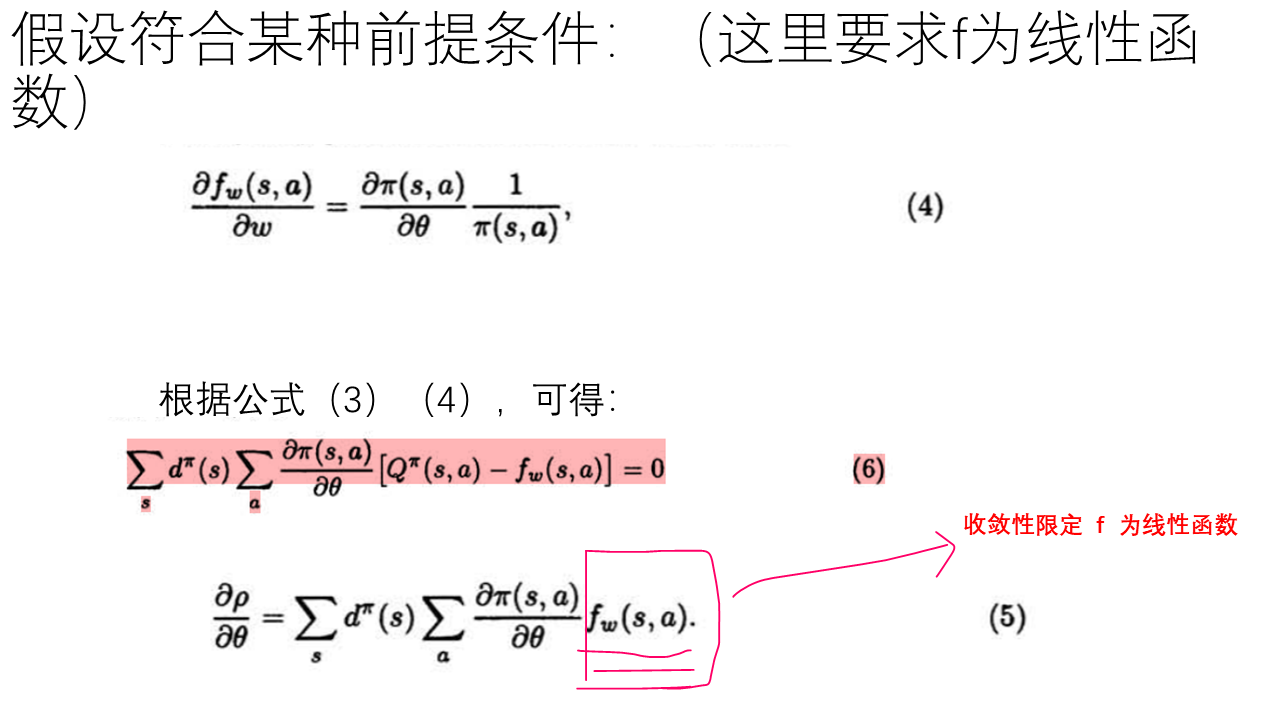

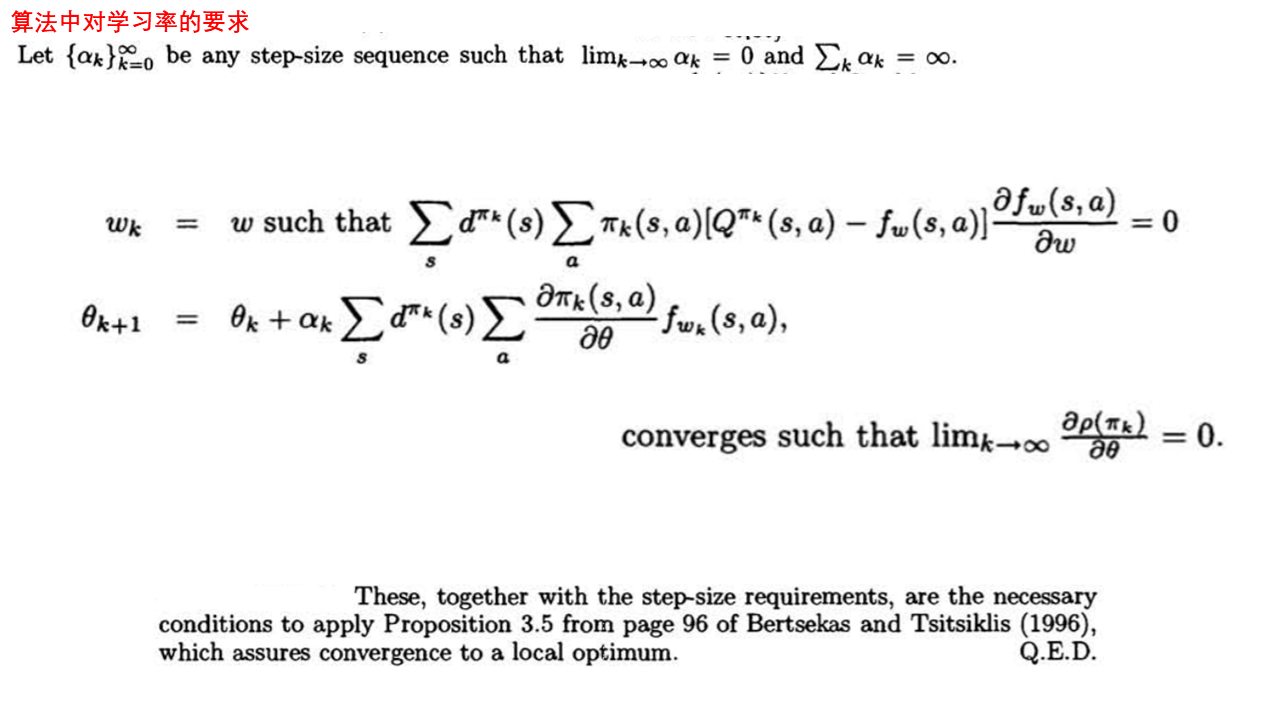

而上面的这篇论文通篇要做的就是下面的公式成立,并且满足逼近函数f为向量且上面的公式(4)及step_size的要求可以收敛到局部最优:

根据后注中的公式(1)和(2),不是直接就可以得到论文中的这个公式嘛,而且而这个公式必然在理想条件下收敛(对整体环境有很好的抽样的情况下),那么把Q换成逼近函数f ,不是也会收敛的嘛,又何必费力去推导最后还得到一个在多个条件下收敛到局部解的结论,这不是显而易见的事情还非得花无用功去为了推导公式而去推导公式和证明收敛的吗?

在此,回答一下 这方面的提问:

首先,要说的就是提出这个问题的人本身就忽略了下面的事情:

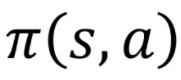

与

与  本身都是对策略依赖的,或者说这两个item本身就含有策略参数θ , 所以根本就不存在由后注中的(1),(2)公式可以推导出论文的最终公式的形式。

本身都是对策略依赖的,或者说这两个item本身就含有策略参数θ , 所以根本就不存在由后注中的(1),(2)公式可以推导出论文的最终公式的形式。

换句话说就是策略pi和Q 对策略参数θ来说都不是常数的,由此才有上面论文中的各种情况下的推导。

对于收敛的问题:

虽然我们可以知道在完全抽样的情况下策略梯度用策略和Q来表示是收敛的,都是实际Q并不知道,我们需要用函数近似和采样的方法来获得,而在这样的整个动态的学习过程中即要优化策略梯度的参数,又要优化近似函数f的参数,而这样的情况下是否收敛却并不知道的。

如果在某个学习过程中 近似函数f 对 Q值的估计 过程收敛到局部最优,则有论文中的公式 (3), 而在近似值函数f 和 策略函数pi 满足论文中的公式(4),则有论文中的公式(5),(6), 在有对step_size的限制下才有 满足以上条件的值函数近似策略梯度算法收敛都局部最优的结论。

---------------------------------------

论文《policy-gradient-methods-for-reinforcement-learning-with-function-approximation 》的阅读——强化学习中的策略梯度算法基本形式与部分证明的更多相关文章

- 《DRN: A Deep Reinforcement Learning Framework for News Recommendation》强化学习推荐系统

摘要 新闻推荐系统中,新闻具有很强的动态特征(dynamic nature of news features),目前一些模型已经考虑到了动态特征. 一:他们只处理了当前的奖励(ctr);. 二:有一些 ...

- [Reinforcement Learning] Value Function Approximation

为什么需要值函数近似? 之前我们提到过各种计算值函数的方法,比如对于 MDP 已知的问题可以使用 Bellman 期望方程求得值函数:对于 MDP 未知的情况,可以通过 MC 以及 TD 方法来获得值 ...

- Ⅶ. Policy Gradient Methods

Dictum: Life is just a series of trying to make up your mind. -- T. Fuller 不同于近似价值函数并以此计算确定性的策略的基于价 ...

- 强化学习读书笔记 - 13 - 策略梯度方法(Policy Gradient Methods)

强化学习读书笔记 - 13 - 策略梯度方法(Policy Gradient Methods) 学习笔记: Reinforcement Learning: An Introduction, Richa ...

- 论文翻译--StarCraft Micromanagement with Reinforcement Learning and Curriculum Transfer Learning

(缺少一些公式的图或者效果图,评论区有惊喜) (个人学习这篇论文时进行的翻译[谷歌翻译,你懂的],如有侵权等,请告知) StarCraft Micromanagement with Reinforce ...

- [Reinforcement Learning] Policy Gradient Methods

上一篇博文的内容整理了我们如何去近似价值函数或者是动作价值函数的方法: \[ V_{\theta}(s)\approx V^{\pi}(s) \\ Q_{\theta}(s)\approx Q^{\p ...

- 强化学习七 - Policy Gradient Methods

一.前言 之前我们讨论的所有问题都是先学习action value,再根据action value 来选择action(无论是根据greedy policy选择使得action value 最大的ac ...

- DRL之:策略梯度方法 (Policy Gradient Methods)

DRL 教材 Chpater 11 --- 策略梯度方法(Policy Gradient Methods) 前面介绍了很多关于 state or state-action pairs 方面的知识,为了 ...

- 深度学习课程笔记(十三)深度强化学习 --- 策略梯度方法(Policy Gradient Methods)

深度学习课程笔记(十三)深度强化学习 --- 策略梯度方法(Policy Gradient Methods) 2018-07-17 16:50:12 Reference:https://www.you ...

- 论文选读一: Towards end-to-end reinforcement learning of dialogue agents for information access

Towards end-to-end reinforcement learning of dialogue agents for information access KB-InfoBot 与知识库交 ...

随机推荐

- 图形库使用 Direct3d

1 里面的数学 矩阵是三角函数组合出来的 旋转的时候 xy 两个变量距离变 第三轴被影响角度 2视锥 远近四棱锥双剪切平面 3 三维点 A点 B点 C点 确定三位坐标 ,初始坐标是坐标中中心值 x,y ...

- 蓝屏rtux64w10.sys

蓝屏rtux64w10.sys 环境: WIN10 + Realtek USB RTL8156B 2.5G网卡 表现: 局域网复制时,间隔性速度变为0,多次后,最终蓝屏. 解决方法: 更新驱动. 地 ...

- FlashDuty Changelog 2023-12-18 | 值班管理、服务日历、自定义操作和邮件集成

FlashDuty:一站式告警响应平台,前往此地址免费体验! 值班管理 UI 交互优化 [个人日程]从头像下拉菜单调整到值班列表页面,快速查看个人值班日程 [值班列表]支持原地预览最近一周值班情况,包 ...

- FlashDuty Changelog 2023-10-30 | 告警路由与 Slack 应用

FlashDuty:一站式告警响应平台,前往此地址免费体验! 告警路由 什么是告警路由? FlashDuty已经与Zabbix.Prometheus等监控系统实现无缝集成,通过一个简单的webhook ...

- Vue学习:12.生命周期实例

两个小例子,巩固一下生命周期钩子函数. 实例1:初始化渲染 实现功能: 在 Vue 实例数据为空的情况下,用户在一进入页面就向服务器发送请求获取数据,并在数据返回后进行动态渲染. 思路: 创建一个 V ...

- Java正则表达式语法及简单示例

import java.util.regex.Matcher; import java.util.regex.Pattern; public class TestMatcher { public st ...

- @Valid + BindingResult 拦截接口错误信息

@Valid + BindingResult 拦截接口错误信息###测试发现: HttpServletRequest request, HttpServletResponse response, 需要 ...

- ssm框架使springmvc放行资源(java配置类)

在springmvc中,如果配置了拦截所有请求交给springmvc处理,会出现一些静态web资源加载不出来的情况,或者想放行指定web资源可以通过修改通过修改配置达到相应目的,这里使用覆写WebMv ...

- 无法启动 IIS Express Web 服务器.....另一个程序正在使用此文件,进程无法访问。 问题解决

一般是由于端口被占用导致的,但是这个端口你在命令行netstat -a里 排除 如果发现被占用,那么就kill进程就可以了 如果没有发现被占用,依然无法启动,可以尝试以下方法 解决方案1: 修改iis ...

- 专用M4F+四核A53,异构多核AM62x让工业控制“更实时、更安全” Tronlong创龙科技5 秒前 1 德州仪器 TI芯片

Cortex-M4F + Cortex-A53异构多核给工业控制带来何种意义? 创龙科技SOM-TL62x工业核心板搭载TI AM62x最新处理器,因其Cortex-M4F + Cortex-A53异 ...