Spark集群新增节点方法

Spark集群处理能力不足需要扩容,如何在现有spark集群中新增新节点?本文以一个实例介绍如何给Spark集群新增一个节点。

1. 集群环境

现有Spark集群包括3台机器,用户名都是cdahdp,主目录/home/ap/cdahdp,配置是2C8G虚拟机,集群基于yarn架构。

Master:128.196.54.112/W118PC01VM01

Slave1:128.196.54.113/W118PC02VM01

Slave2:128.196.54.114/W118PC03VM01

相关软件版本:jdk1.7、scala2.10.4、hadoop2.6.0、spark1.1

现在需要新增一个节点:128.196.54.115/W118PC04VM01,2C8G

首先停止当前集群:停止spark,停止hdfs和yarn。

2. 新节点要求

(1)新节点需要增加用户cdahdp,主目录/home/ap/cdahdp。与集群现有机器一致。

(2)修改所有节点的/etc/hosts文件,更新新节点的ip hostname配置。

(3)配置ssh,使新节点与集群中各节点能够无密码互相ssh登录。

(4)在新节点上安装jdk、scala、hadoop和spark。其版本,安装目录,环境变量设置与集群中现有节点保持一致。比如可以直接从集群节点赋值。

3. 配置文件修改

(1)修改$HADOOP_HOME/etc/hadoop/slaves文件,增加新节点作为slave节点。

(2)修改$SPARK_HOME/conf/slaves文件,增加新节点作为slave节点。

(3)格式化新节点的namenode:

cd $HADOOP_HOME/bin

./hdfs namenode -format

4. 启动新集群

启动hdfs,yarn,以及spark。

cd $HADOOP_HOME/sbin

./start-dfs.sh && ./start-yarn.sh

cd $SPARK_HOME/sbin

./start-all.sh

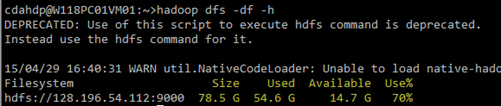

扩容以前:

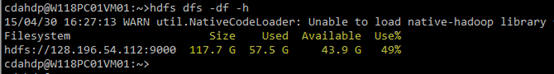

扩容以后:

5. 集群的负载均衡

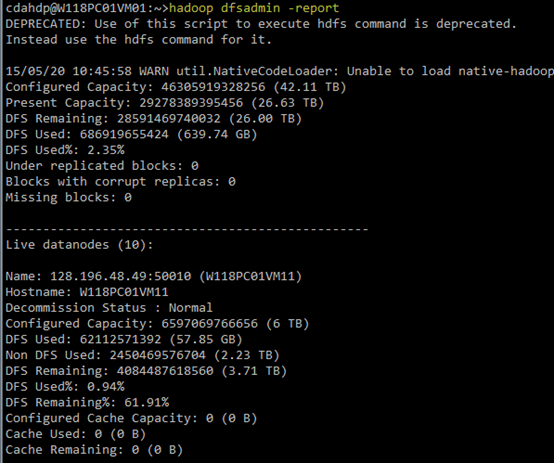

(1)查看HDFS集群的基本信息:执行hadoop dfsadmin -report

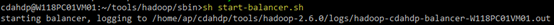

(2)负载均衡:在$HADOOP_HOME/sbin/下执行start-balancer.sh

说明:balancer操作是一个较慢的过程,所以在后台执行。balance过程中,数据在各节点之间迁移的速度默认是1M/s。

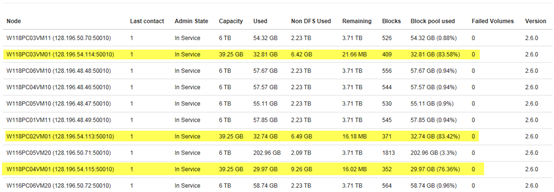

负载均衡之前:

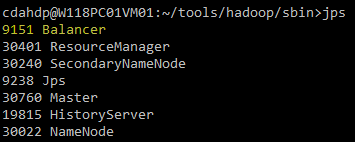

执行负载均衡:

负载均衡之后:

至此,在spark集群增加新节点完毕。

Spark集群新增节点方法的更多相关文章

- Elastic search集群新增节点(同一个集群,同一台物理机,基于ES 7.4)

一开始,在电脑上同一个集群新增节点(node)怎么试也不成功,官网guide又语焉不详?集群健康值yellow(表示主分片全部可用,部分复制分片不可用) 最后,在stackoverflow上找到了答案 ...

- redis 集群新增节点,slots槽分配,删除节点, [ERR] Calling MIGRATE ERR Syntax error, try CLIENT (LIST | KILL | GET...

redis reshard 重新分槽(slots) https://github.com/antirez/redis/issues/5029 redis 官方已确认该bug redis 集群重新(re ...

- CDH5.16.1集群新增节点

如果是全新安装集群的话,可以参考<Ubuntu 16.04上搭建CDH5.16.1集群> 下面是集群新增节点步骤: 1.已经存在一个集群,有两个节点 192.168.100.19 hado ...

- 使用fabric解决百度BMR的spark集群各节点的部署问题

前言 和小伙伴的一起参加的人工智能比赛进入了决赛之后的一段时间里面,一直在构思将数据预处理过程和深度学习这个阶段合并起来.然而在合并这两部分代码的时候,遇到了一些问题,为此还特意写了脚本文件进行处理. ...

- k8s集群新增节点

节点为centos7.4 一.node节点基本环境配置 1.配置主机名 2.配置hosts文件(master和node相互解析) 3.时间同步 ntpdate pool.ntp.org date ec ...

- Eclipse提交代码到Spark集群上运行

Spark集群master节点: 192.168.168.200 Eclipse运行windows主机: 192.168.168.100 场景: 为了测试在Eclipse上开发的代码在Spa ...

- Spark集群基础概念 与 spark架构原理

一.Spark集群基础概念 将DAG划分为多个stage阶段,遵循以下原则: 1.将尽可能多的窄依赖关系的RDD划为同一个stage阶段. 2.当遇到shuffle操作,就意味着上一个stage阶段结 ...

- 十、scala、spark集群搭建

spark集群搭建: 1.上传scala-2.10.6.tgz到master 2.解压scala-2.10.6.tgz 3.配置环境变量 export SCALA_HOME=/mnt/scala-2. ...

- 【Spark】Spark必不可少的多种集群环境搭建方法

目录 Local模式运行环境搭建 小知识 搭建步骤 一.上传压缩包并解压 二.修改Spark配置文件 三.启动验证进入Spark-shell 四.运行Spark自带的测试jar包 standAlone ...

随机推荐

- 【转】JSON.parse()与JSON.stringify()的区别

JSON.parse()[从一个字符串中解析出json对象] 例子: //定义一个字符串 var data='{"name":"goatling"}' //解析 ...

- 怎样关闭占用80端口的pid为4的进程

我也被这个问题给纠结了好几天.重装系统都三次了.终于找到原因了:我用的是sqlserver 2008;解决方法:window-sqlserver 2008-配置工具-sqlserver 配置管理器 找 ...

- JS学习-基础运动

多物体运动 多个物体用同一个函数时,函数里定义的定时器应该要每个物体对应一个定时器名称,不然会导致未完成运动就被关闭了,因为定时器名称一样,而开启定时器前会清除一下. obj.timer 多值同时运动 ...

- linux父子进程问题

今天遇到一个linux进程启动时指定Max open files不对的问题,导致程序建立socket异常,进而导致fullgc问题,影响正常服务.所以顺带又温习了下linux下的父子进程的特性. 孤儿 ...

- 浅谈回归Regression(一)

一.什么是回归? 孩子的身高是否与父母有关? 实际上,父母和孩子的身高是受到回归效应影响的.在时间纵轴上受影响.具有随机性的事物,无不遵循这一规律. 只要数据足够大,人类的身高或者智商,都有趋于平均值 ...

- Qt 日志输出文件

在Qt开发过程当中经常使用qDebug等一些输出来调试程序,但是到了正式发布的时候,都会被注释或者删除,采用日志输出来代替. 做过项目的童鞋可能都使用过日志功能,以便有异常错误能够快速跟踪.定 ...

- SQL Server ->> SQL Server 2016重要功能改进之 -- INSERT SELECT时并发插入数据

SQL Server 2016对INSERT INTO XXXX SELECT语句进行了优化,在某些情况下可以触发数据的并行插入,但是要求兼容模式是130(SQL Server 2016)以及在插入的 ...

- Oracle案例02——ORA-12034: "SCOTT"."USER_TABLE" 上的实体化视图日志比上次刷新后的内容新

最近同事在交接工作时,发现有几个schedule job没有执行成功,我这边给看了下,其中一个是由于数据库迁移,调用dblink的host主机IP在tnsnames中没有变更导致,还有一个是无法视图的 ...

- 如果使用没有提供选项值的 SqlDependency,必须先调用 SqlDependency.Start(),然后才能执行添加到 SqlDependency 实例中的命令

如标题错误,解决办法及出现错误情况,见图片 出现如图错误

- VS2010 调试启动特别慢

调试选项里有 _NT_SYMBOL_PATH 这一项,并且不能取消选择.只好删除这个环境变量,此来源于windbg环境中需要.重启windows后,VS2010调试里已没有此项,F5调试飞快--