bigdata learning unit two--Spark environment setting

1、下载

Spark安装之前的准备

文件的解压与改名

tar -zxvf spark-2.2.0-bin-hadoop2.7.tgzrm -rf spark-2.2.0-bin-hadoop2.7.tgz为了我后面方便配置spark,在这里我把文件夹的名字给改了

mv spark-2.2.0-bin-hadoop2.7 spark-2.2.0

-----------------------------------------------------------------------------------------

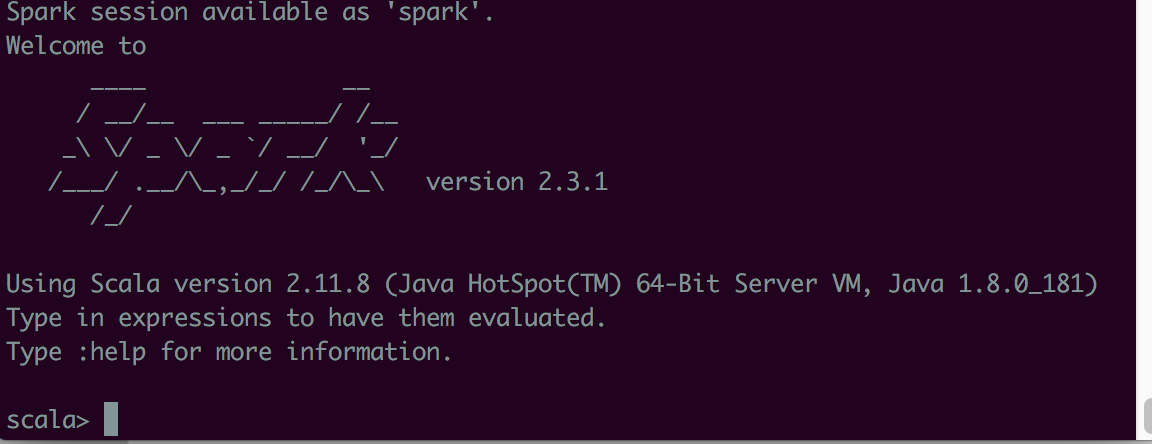

打开spark-shell 后,方能打开下面网址

退出的正确操作是:- :quit

http://10.167.202.135:4040/jobs/

配置环境变量

vi /etc/profile在最尾巴加入

export SPARK_HOME=/usr/local/spark-2.2.0

export PATH=$PATH:$SPARK_HOME/bin首先我们把缓存的文件spark-env.sh.template改为spark识别的文件spark-env.sh

cp conf/spark-env.sh.template conf /spark-env.sh

vi conf/spark-env.sh

- OPENBLAS_NUM_THREADS=1 Disable multi-threading of OpenBLAS

export JAVA_HOME=/usr/local/jdk1.8

export SCALA_HOME=/usr/local/scala-2.11.7

export HADOOP_HOME=/usr/local/hadoop-3.1.0/

export HADOOP_CONF_DIR=/usr/local/hadoop-3.1.0/etc/hadoop

export SPARK_MASTER_IP=localhost

export SPARK_WORKER_MEMORY=4g

export SPARK_WORKER_CORES=2

export SPARK_WORKER_INSTANCES=1

--------

*****下面是修改默认端口8080为8086*****

spark master web ui 默认端口为8080,当系统有其它程序也在使用该接口时,启动master时也不会报错,spark自己会改用其它端口,自动端口号加1,但为了可以控制到指定的端口,我们可以自行设置,修改方法:

1、cd SPARK_HOME/sbin

2、vi start-master.sh

3、定位到下面部分内容:

if [ "$SPARK_MASTER_WEBUI_PORT" = "" ]; then

SPARK_MASTER_WEBUI_PORT=8080

fi

4、修改上面的端口为其它可用端口就行

bigdata learning unit two--Spark environment setting的更多相关文章

- bigdata learning unit one--Hadoop environment setting

1.配置ssh,使集群服务器之间的通讯,不再每次都输入密码进行认证. 2. [root@hc--uatbeta2 hadoop]# start-all.shStarting namenodes on ...

- Java Environment Setting

As a non-Java developer, I am quit stuck in Java environment setting because I am not familiar with ...

- [Keras] Install and environment setting

Documentation: https://keras.io/ 1. 利用anaconda 管理python库是明智的选择. conda update conda conda update anac ...

- bigdata之hadoop and spark

目前正在学习Hadoop和spark之类的东西,一个月把Hadoop的基础东西过了一遍,但是感觉好动都没跟上老师的课程,哪位前辈了解这方面的东西希望给指点迷津.接下来我们还要学习spark和nosql ...

- How to change Visual Studio default environment setting

如何改变 Visual Studio 的默认环境设置: 1. 工具栏 Tools --> Import and Export Settings... 2. 选择 Reset All Settin ...

- Deep Learning - Install the Development Environment

WLS(Windows Subsystem for Linux) Base WLS Installation Guide Initializing a newly installed distro W ...

- Mac environment setting

java 7 jdk http://www.ifunmac.com/2013/04/mac-jdk-7/ http://blog.sina.com.cn/s/blog_6dce99b101016744 ...

- 英特尔深度学习框架BigDL——a distributed deep learning library for Apache Spark

BigDL: Distributed Deep Learning on Apache Spark What is BigDL? BigDL is a distributed deep learning ...

- <译>Spark Sreaming 编程指南

Spark Streaming 编程指南 Overview A Quick Example Basic Concepts Linking Initializing StreamingContext D ...

随机推荐

- 三、ASP.NET Core 部署Linux

预备工作 1.删除dotnet core sdk sudo yum erase libunwind libicu 2.删除链接 sudo rm -rf /usr/local/bin 3.sudo yu ...

- 解决post、get端中文乱码问题

在web.xml中配置: <filter> <filter-name>CharacterEncodingFilter</filter-name> <filte ...

- maven项目 报错 org.apache.ibatis.binding.BindingException: Invalid bound statement (not found):

ssm的项目如果在mapper.xml mapper接口 配置没问题的情况下 项目依然报org.apache.ibatis.binding.BindingException: Invalid bo ...

- Qt 网格布局

把十六个button放到网格布局的界面上 #include "mainwindow.h" #include <QApplication> #include<QtW ...

- 在 Activity 中实现 getContentView 操作

2017/9/8 17:17:03 前言 最近接到个需要优化Android原生系统设置APK的任务.这个任务里面有一个更换应用背景图片的需求.我手里的这个设备是一个平板设备,使用了一下这个 ...

- poj 2226 Muddy Fields(水二分图)

Rain has pummeled the cows' field, a rectangular grid of R rows and C columns (1 <= R <= 50, 1 ...

- 【XSY1551】往事 广义后缀数组 线段树合并

题目大意 给你一颗trie树,令\(s_i\)为点\(i\)到根的路径上的字符组成的字符串.求\(max_{u\neq v}(LCP(s_u,s_v)+LCS(s_u,s_v))\) \(LCP=\) ...

- C/C++ 程序库

C/C++ 程序库 // --------------------------------------------- 来几个不常见但是很变态的库吧: bundle: 把几乎所有常见的压缩库封装成了一个 ...

- Shell 字符截取命令 Cut

1.Cut 命令 # cut [选项] 文件名 选项 : -f 列号 提取第几列 -d 分隔符,按照指定分隔符分割列 2.例子 cut -f 1,4 -d ":" /etc/p ...

- DP及其优化

常见DP模型及其构造 序列DP ARC074 RGB Sequence 题意 给你一个长度为 \(n\) 的序列和 \(m\) 组约束条件,每组条件形如 \(l_i,r_i,x_i\),表示序列上的 ...