机器学习实战基础(十九):sklearn中数据集

sklearn提供的自带的数据集

sklearn 的数据集有好多个种

- 自带的小数据集(packaged dataset):sklearn.datasets.load_<name>

- 可在线下载的数据集(Downloaded Dataset):sklearn.datasets.fetch_<name>

- 计算机生成的数据集(Generated Dataset):sklearn.datasets.make_<name>

- svmlight/libsvm格式的数据集:sklearn.datasets.load_svmlight_file(...)

- 从买了data.org在线下载获取的数据集:sklearn.datasets.fetch_mldata(...)

①自带的数据集

其中的自带的小的数据集为:sklearn.datasets.load_<name>

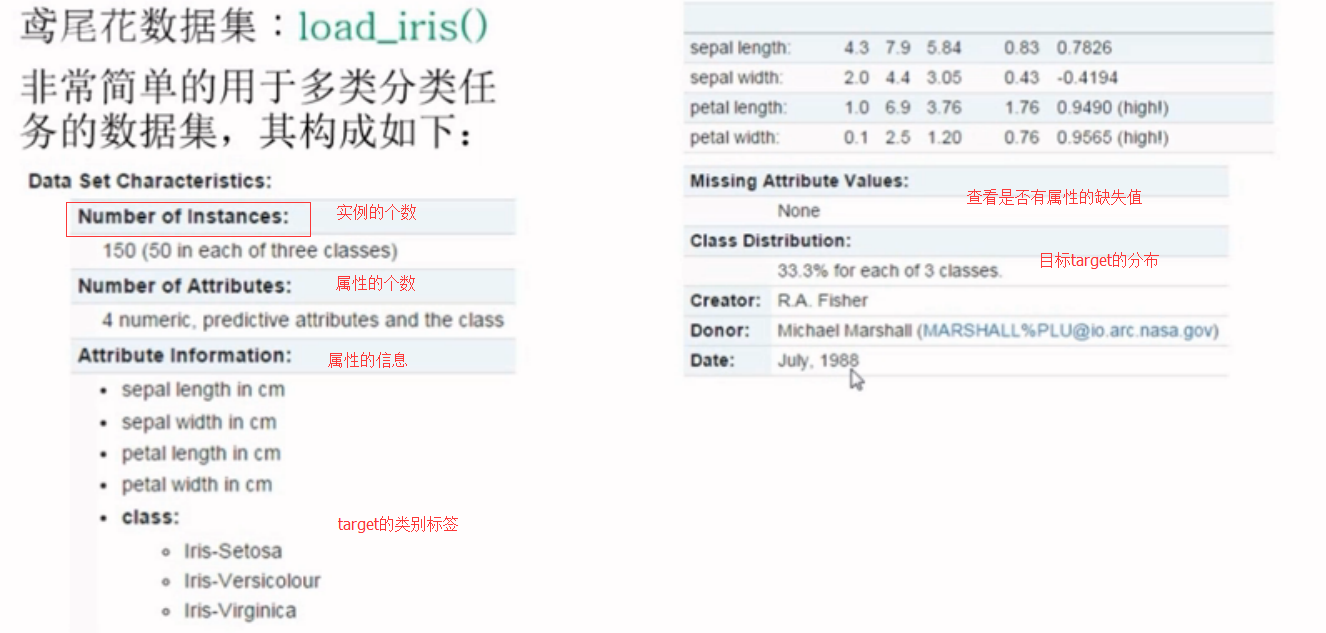

这些数据集都可以在官网上查到,以鸢尾花为例,可以在官网上找到demo,http://scikit-learn.org/stable/auto_examples/datasets/plot_iris_dataset.html

from sklearn.datasets import load_iris

#加载数据集

iris=load_iris()

iris.keys() #dict_keys(['target', 'DESCR', 'data', 'target_names', 'feature_names'])

#数据的条数和维数

n_samples,n_features=iris.data.shape

print("Number of sample:",n_samples) #Number of sample: 150

print("Number of feature",n_features) #Number of feature 4

#第一个样例

print(iris.data[0]) #[ 5.1 3.5 1.4 0.2]

print(iris.data.shape) #(150, 4)

print(iris.target.shape) #(150,)

print(iris.target)

"""

[0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0

0 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1

1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 2 2 2 2 2 2 2 2 2 2 2

2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2

2 2]

"""

import numpy as np

print(iris.target_names) #['setosa' 'versicolor' 'virginica']

np.bincount(iris.target) #[50 50 50] import matplotlib.pyplot as plt

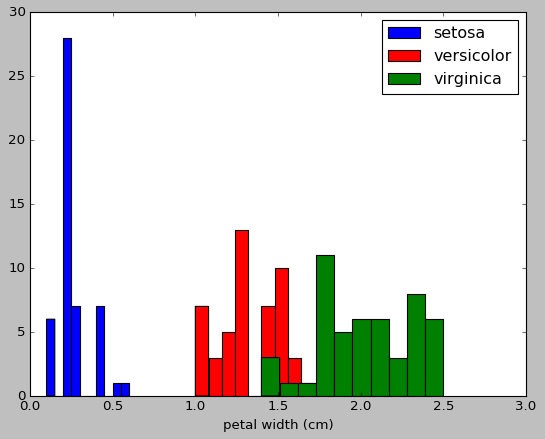

#以第3个索引为划分依据,x_index的值可以为0,1,2,3

x_index=3

color=['blue','red','green']

for label,color in zip(range(len(iris.target_names)),color):

plt.hist(iris.data[iris.target==label,x_index],label=iris.target_names[label],color=color) plt.xlabel(iris.feature_names[x_index])

plt.legend(loc="Upper right")

plt.show()

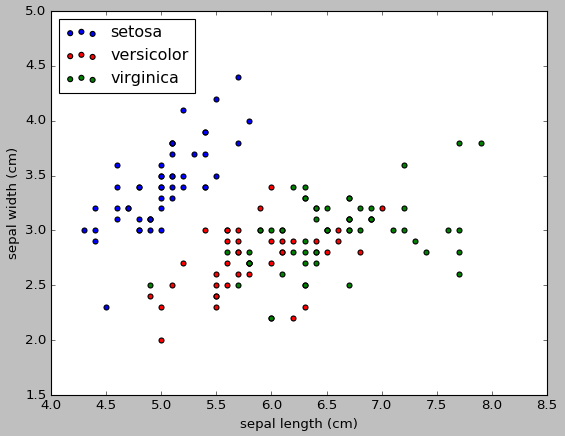

#画散点图,第一维的数据作为x轴和第二维的数据作为y轴

x_index=0

y_index=1

colors=['blue','red','green']

for label,color in zip(range(len(iris.target_names)),colors):

plt.scatter(iris.data[iris.target==label,x_index],

iris.data[iris.target==label,y_index],

label=iris.target_names[label],

c=color)

plt.xlabel(iris.feature_names[x_index])

plt.ylabel(iris.feature_names[y_index])

plt.legend(loc='upper left')

plt.show()

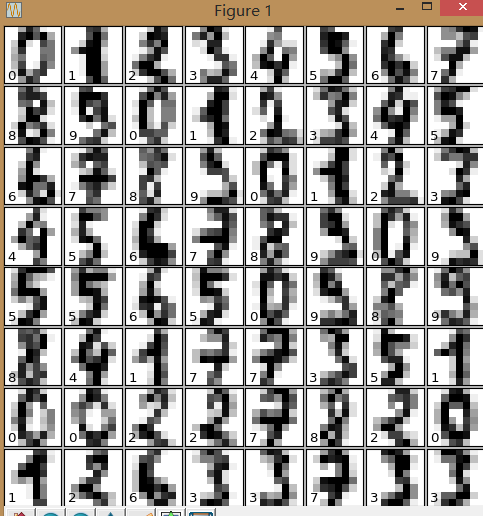

手写数字数据集load_digits():用于多分类任务的数据集

from sklearn.datasets import load_digits

digits=load_digits()

print(digits.data.shape)

import matplotlib.pyplot as plt

plt.gray()

plt.matshow(digits.images[0])

plt.show() from sklearn.datasets import load_digits

digits=load_digits()

digits.keys()

n_samples,n_features=digits.data.shape

print((n_samples,n_features)) print(digits.data.shape)

print(digits.images.shape) import numpy as np

print(np.all(digits.images.reshape((1797,64))==digits.data)) fig=plt.figure(figsize=(6,6))

fig.subplots_adjust(left=0,right=1,bottom=0,top=1,hspace=0.05,wspace=0.05)

#绘制数字:每张图像8*8像素点

for i in range(64):

ax=fig.add_subplot(8,8,i+1,xticks=[],yticks=[])

ax.imshow(digits.images[i],cmap=plt.cm.binary,interpolation='nearest')

#用目标值标记图像

ax.text(0,7,str(digits.target[i]))

plt.show()

乳腺癌数据集load-barest-cancer():简单经典的用于二分类任务的数据集

糖尿病数据集:load-diabetes():经典的用于回归认为的数据集,值得注意的是,这10个特征中的每个特征都已经被处理成0均值,方差归一化的特征值,

波士顿房价数据集:load-boston():经典的用于回归任务的数据集

体能训练数据集:load-linnerud():经典的用于多变量回归任务的数据集,其内部包含两个小数据集:Excise是对3个训练变量的20次观测(体重,腰围,脉搏),physiological是对3个生理学变量的20次观测(引体向上,仰卧起坐,立定跳远)

svmlight/libsvm的每一行样本的存放格式:

<label><feature-id>:<feature-value> <feature-id>:<feature-value> ....

这种格式比较适合用来存放稀疏数据,在sklearn中,用scipy sparse CSR矩阵来存放X,用numpy数组来存放Y

from sklearn.datasets import load_svmlight_file

x_train,y_train=load_svmlight_file("/path/to/train_dataset.txt","")#如果要加在多个数据的时候,可以用逗号隔开

②生成数据集

生成数据集:可以用来分类任务,可以用来回归任务,可以用来聚类任务,用于流形学习的,用于因子分解任务的

用于分类任务和聚类任务的:这些函数产生样本特征向量矩阵以及对应的类别标签集合

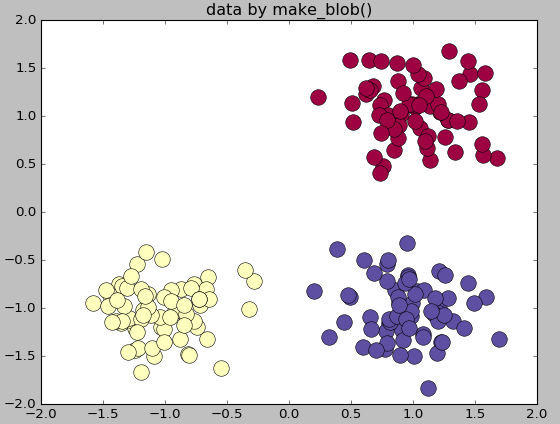

make_blobs:多类单标签数据集,为每个类分配一个或多个正太分布的点集

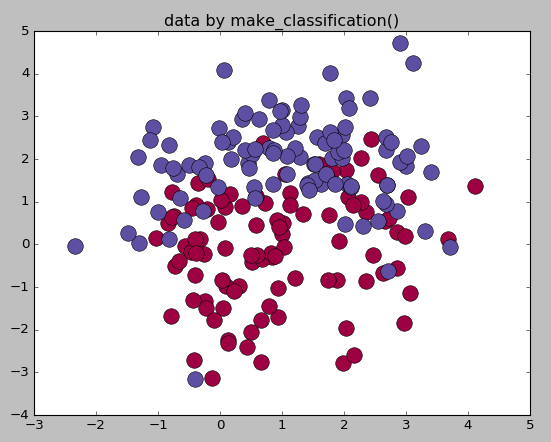

make_classification:多类单标签数据集,为每个类分配一个或多个正太分布的点集,提供了为数据添加噪声的方式,包括维度相关性,无效特征以及冗余特征等

make_gaussian-quantiles:将一个单高斯分布的点集划分为两个数量均等的点集,作为两类

make_hastie-10-2:产生一个相似的二元分类数据集,有10个维度

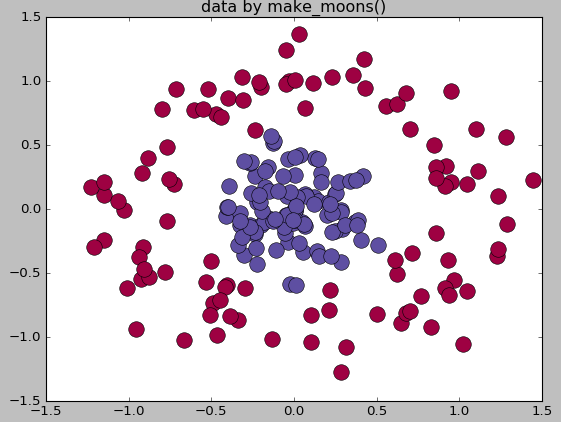

make_circle和make_moom产生二维二元分类数据集来测试某些算法的性能,可以为数据集添加噪声,可以为二元分类器产生一些球形判决界面的数据

#生成多类单标签数据集

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets.samples_generator import make_blobs

center=[[1,1],[-1,-1],[1,-1]]

cluster_std=0.3

X,labels=make_blobs(n_samples=200,centers=center,n_features=2,

cluster_std=cluster_std,random_state=0)

print('X.shape',X.shape)

print("labels",set(labels)) unique_lables=set(labels)

colors=plt.cm.Spectral(np.linspace(0,1,len(unique_lables)))

for k,col in zip(unique_lables,colors):

x_k=X[labels==k]

plt.plot(x_k[:,0],x_k[:,1],'o',markerfacecolor=col,markeredgecolor="k",

markersize=14)

plt.title('data by make_blob()')

plt.show()

#生成用于分类的数据集

from sklearn.datasets.samples_generator import make_classification

X,labels=make_classification(n_samples=200,n_features=2,n_redundant=0,n_informative=2,

random_state=1,n_clusters_per_class=2)

rng=np.random.RandomState(2)

X+=2*rng.uniform(size=X.shape) unique_lables=set(labels)

colors=plt.cm.Spectral(np.linspace(0,1,len(unique_lables)))

for k,col in zip(unique_lables,colors):

x_k=X[labels==k]

plt.plot(x_k[:,0],x_k[:,1],'o',markerfacecolor=col,markeredgecolor="k",

markersize=14)

plt.title('data by make_classification()')

plt.show() #生成球形判决界面的数据

from sklearn.datasets.samples_generator import make_circles

X,labels=make_circles(n_samples=200,noise=0.2,factor=0.2,random_state=1)

print("X.shape:",X.shape)

print("labels:",set(labels)) unique_lables=set(labels)

colors=plt.cm.Spectral(np.linspace(0,1,len(unique_lables)))

for k,col in zip(unique_lables,colors):

x_k=X[labels==k]

plt.plot(x_k[:,0],x_k[:,1],'o',markerfacecolor=col,markeredgecolor="k",

markersize=14)

plt.title('data by make_moons()')

plt.show()

机器学习实战基础(十九):sklearn中数据集的更多相关文章

- 机器学习实战基础(九):sklearn中的数据预处理和特征工程(二) 数据预处理 Preprocessing & Impute 之 数据无量纲化

1 数据无量纲化 在机器学习算法实践中,我们往往有着将不同规格的数据转换到同一规格,或不同分布的数据转换到某个特定分布的需求,这种需求统称为将数据“无量纲化”.譬如梯度和矩阵为核心的算法中,譬如逻辑回 ...

- Bootstrap <基础十九>分页

Bootstrap 支持的分页特性.分页(Pagination),是一种无序列表,Bootstrap 像处理其他界面元素一样处理分页. 分页(Pagination) 下表列出了 Bootstrap 提 ...

- 机器学习实战基础(二十九):决策树(二)DecisionTreeClassifier与红酒数据集

DecisionTreeClassifier与红酒数据集 1 sklearn.tree.DecisionTreeClassifier class sklearn.tree.DecisionTreeCla ...

- 机器学习实战基础(十):sklearn中的数据预处理和特征工程(三) 数据预处理 Preprocessing & Impute 之 缺失值

缺失值 机器学习和数据挖掘中所使用的数据,永远不可能是完美的.很多特征,对于分析和建模来说意义非凡,但对于实际收集数据的人却不是如此,因此数据挖掘之中,常常会有重要的字段缺失值很多,但又不能舍弃字段的 ...

- 机器学习实战基础(二十四):sklearn中的降维算法PCA和SVD(五) PCA与SVD 之 重要接口inverse_transform

重要接口inverse_transform 在上周的特征工程课中,我们学到了神奇的接口inverse_transform,可以将我们归一化,标准化,甚至做过哑变量的特征矩阵还原回原始数据中的特征矩阵 ...

- 机器学习实战基础(二十):sklearn中的降维算法PCA和SVD(一) 之 概述

概述 1 从什么叫“维度”说开来 我们不断提到一些语言,比如说:随机森林是通过随机抽取特征来建树,以避免高维计算:再比如说,sklearn中导入特征矩阵,必须是至少二维:上周我们讲解特征工程,还特地提 ...

- 机器学习实战基础(二十三):sklearn中的降维算法PCA和SVD(四) PCA与SVD 之 PCA中的SVD

PCA中的SVD 1 PCA中的SVD哪里来? 细心的小伙伴可能注意到了,svd_solver是奇异值分解器的意思,为什么PCA算法下面会有有关奇异值分解的参数?不是两种算法么?我们之前曾经提到过,P ...

- 机器学习实战基础(十一):sklearn中的数据预处理和特征工程(四) 数据预处理 Preprocessing & Impute 之 处理分类特征:编码与哑变量

处理分类特征:编码与哑变量 在机器学习中,大多数算法,譬如逻辑回归,支持向量机SVM,k近邻算法等都只能够处理数值型数据,不能处理文字,在sklearn当中,除了专用来处理文字的算法,其他算法在fit的 ...

- 机器学习实战基础(八):sklearn中的数据预处理和特征工程(一)简介

1 简介 数据挖掘的五大流程: 1. 获取数据 2. 数据预处理 数据预处理是从数据中检测,纠正或删除损坏,不准确或不适用于模型的记录的过程 可能面对的问题有:数据类型不同,比如有的是文字,有的是数字 ...

随机推荐

- 使用redis实现nodejs并发服务

const redisClient = require('redis').createClient(6379, '127.0.0.1'); const crypto = require('crypto ...

- (八)利用 Profile 构建不同环境的部署包

接上回继续,项目开发好以后,通常要在多个环境部署,象我们公司多达5种环境:本机环境(local).(开发小组内自测的)开发环境(dev).(提供给测试团队的)测试环境(test).预发布环境(pre) ...

- PHP丨PHP基础知识之流程控制for循环「理论篇」

今天公司同事在看for循环,那么我们今天就来讲讲for循环吧! for循环是编程语言中一种循环语句,而循环语句由循环体及循环的判定条件两部分组成,其表达式为:for(单次表达式;条件表达式;末尾循环体 ...

- Redis:rdb和aof

由于redis的数据都直接存储在内存里,在服务器发生宕机时内存的数据会瞬间清空,那么必须要有重启时恢复数据的方法. redis通过持久化机制将数据存储到磁盘中从而在服务器重启时恢复数据,这篇文章主要简 ...

- layer.open弹框中的表单数据无法获取

layer.open弹框中的表单数据无法获取 表单数据模板 layer.open() 页面效果: 当点击确定后,radio和textarea获取的值总是为空,解决办法: var setPriCustB ...

- AbstractQueuedSynchronizer和ReentranLock基本原理

先把我主要学习参考的文章放上来先,这篇文章讲的挺好的,分析比较到位,最好是先看完这篇文章,在接下去看我写的.不然你会一脸懵逼,不过等你看完这篇文章,可能我的文章对你也用途不大了 深入分析Abstrac ...

- keras训练函数fit和fit_generator对比,图像生成器ImageDataGenerator数据增强

1. [深度学习] Keras 如何使用fit和fit_generator https://blog.csdn.net/zwqjoy/article/details/88356094 ps:解决样本数 ...

- Mariadb之日志相关配置

前面我们聊到了mariadb的事务,以及事务隔离级别,回顾请参考https://www.cnblogs.com/qiuhom-1874/p/13198186.html:今天我们来聊一聊mariadb的 ...

- docker推送镜像到私有仓库

配置私有仓库源 私有仓库地址:registry.supos.ai 修改/etc/docker/daemon.json文件,增加insecure-registries,如下所示: { "ins ...

- 表达式计算开源组件(NCalc.NetCore)

首先,这款组件是开源的,NCalc是.net中的一个数学表达式求值程序.NCalc可以解析任何表达式并计算结果,包括静态或动态参数和自定义函数. 官网地址:http://ncalc.codeplex. ...