Spark的checkpoint源码讲解

一、Checkpoint相关源码分为四个部分

1、Checkpoint的基本使用:spark_core & spark_streaming

2、初始化的源码

3、Checkpoint的job生成及执行的过程

4、读Checkpoint的过程

二、Checkpoint的基本使用

Checkpoint可以是还原药水。辅助Spark应用从故障中恢复。SparkStreaming宕机恢复,适合调度器有自动重试功能的。对于 SparkCore 则适合那些计算链条超级长或者计算耗时的

关键点进行 Checkpoint, 便于故障恢复 。

Checkpoint和persist从根本上是不一样的:

1、Cache or persist:

Cache or persist保存了RDD的血统关系,假如有部分cache的数据丢失可以根据血缘关系重新生成。

2、Checkpoint

会将RDD数据写到hdfs这种安全的文件系统里面,并且抛弃了RDD血缘关系的记录。即使persist存储到了磁盘里面,在driver停掉之后会被删除,而checkpoint可以被下次启动使用。

Checkpoint基本使用

对于spark_streaming的checkpoint:

spark streaming有一个单独的线程CheckpointWriteHandler,每generate一个batch interval的RDD数据都会触发checkpoint操作。对于kafka的DirectKafkaInputDStreamCheckpointData,实质是重写DStreamCheckpointData的update和restore方法,这样checkpoint的数据就是topic,partition,fromOffset和untilOffset。更多请参考源码例子RecoverableNetworkWordCount

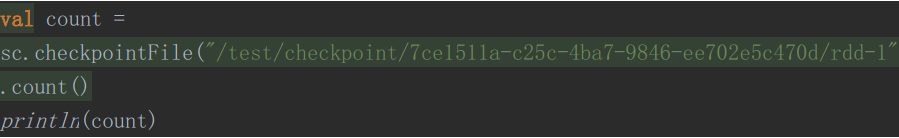

对于spark_core的checkpoint:

docheckpoint:

recover:

二、Checkpoint的初始化源码

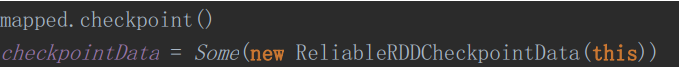

1、设置Checkpoint目录

2、调用Checkpoint方法,构建checkpointData

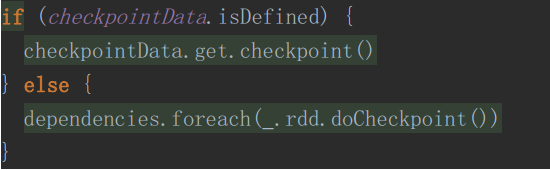

三、DoCheckpoint源码

在SparkContext的runjob方法中

进入之后

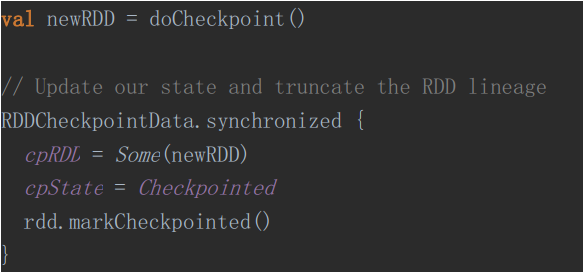

RDDCheckpointData中真正做Checkpoint返回一个新的RDD并清除掉依赖关系

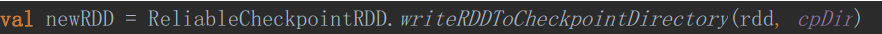

ReliableRDDCheckpointData中真正进行Checkpoint操作

在该方法中

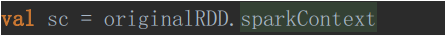

1、获取sc

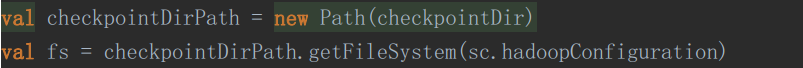

2、创建输出目录

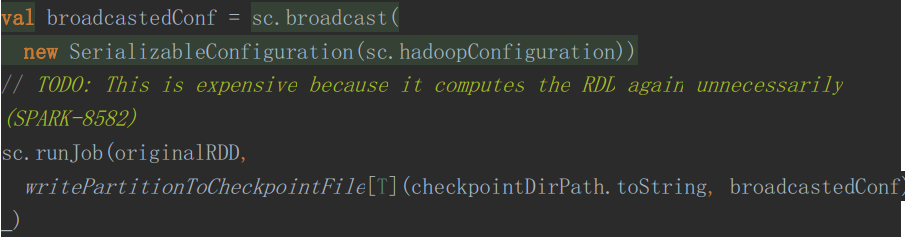

3、以Job的方式进行Checkpoint操作

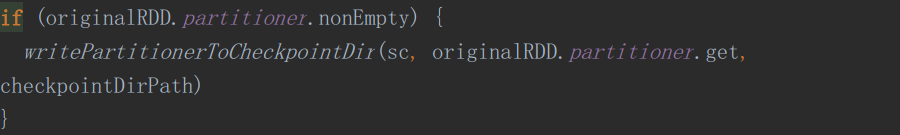

4、将分区策略写入Checkpoint目录

四、读取Checkpoint数据

三个方法:

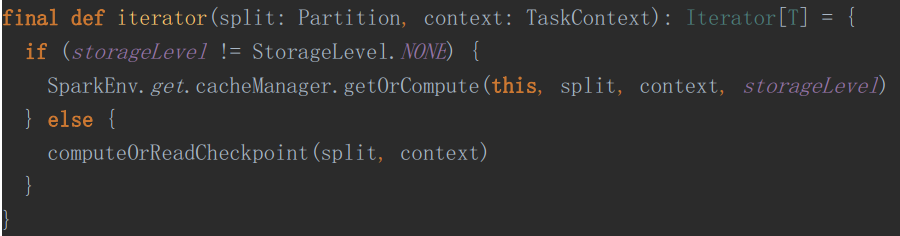

1、同一个Spark任务,共有了Checkpoint的RDD,在该RDD的iterator方法中

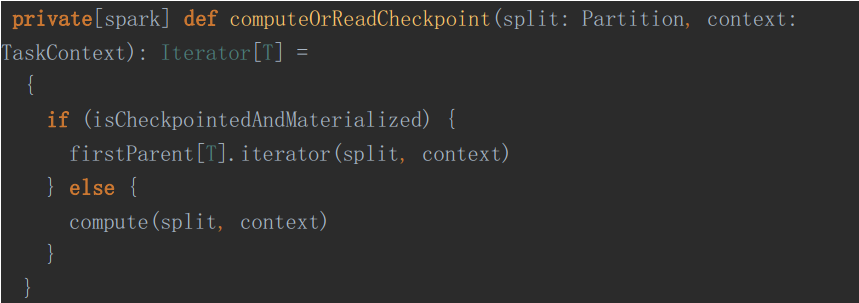

进入 computeOrReadCheckpoint

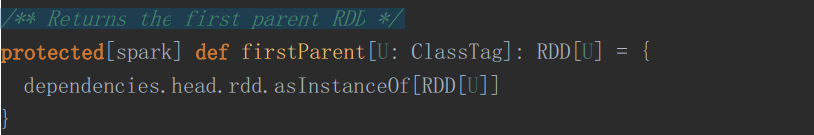

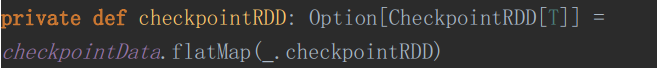

如果进行了 Checkpoint, 条件为真firstParent[T].iterator(split, context)其中, firstParent 为

/** Returns the first parent RDD */

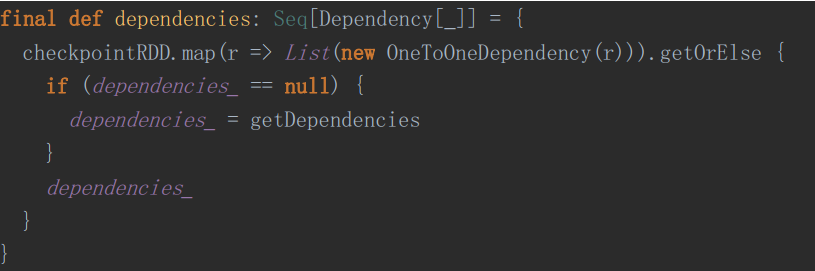

接着是获取依赖

假如进行了Checkpoint,那么CheckpointRDD就是存在

在初始化Checkpoint的时候,我们已经初始化了CheckpointData了。

2、RDD的计算链条失败,主动去读Checkpoint文件的过程

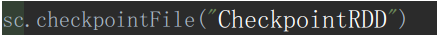

这个要求我们的入口类在下面这个包

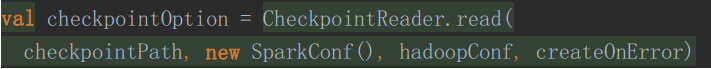

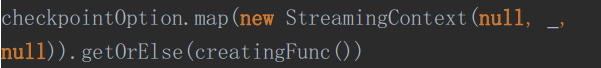

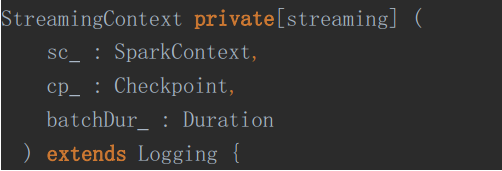

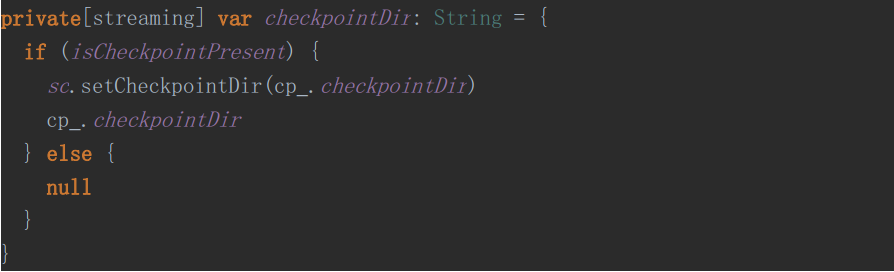

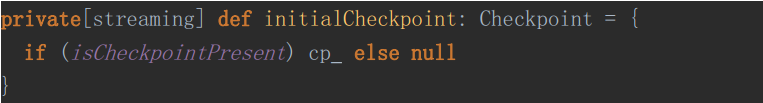

3、SparkStreaming的故障恢复

首先,看一下SteamingContext的需要

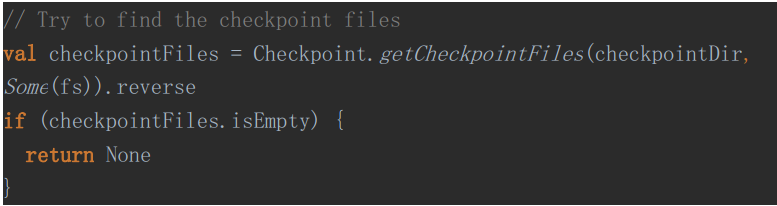

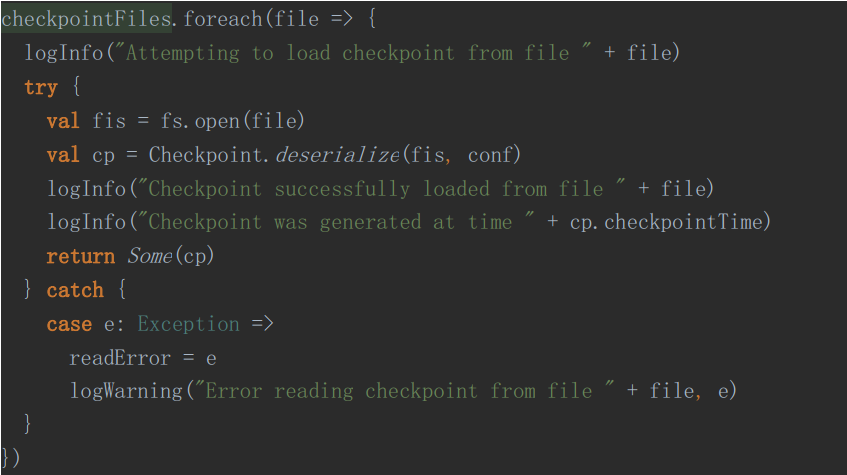

然后去读取Checkpoint

分两个步骤:

A、获取最新的Checkpoint目录

B、迭代找到最新的Checkpoint就返回

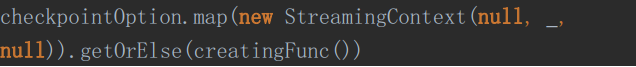

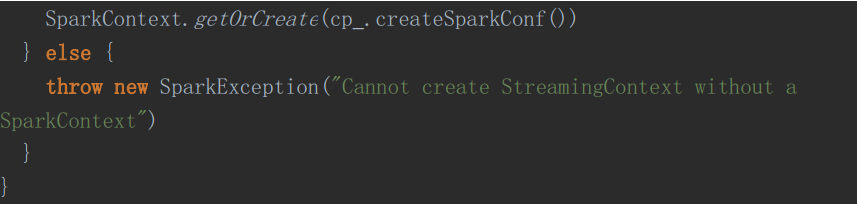

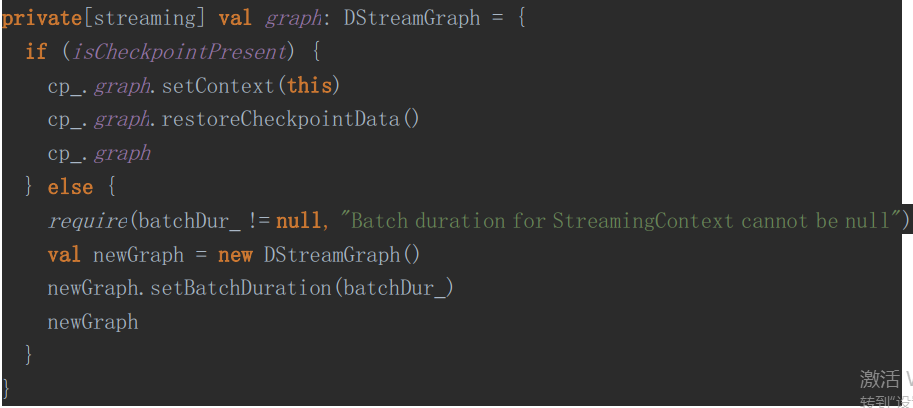

最后就是使用获取的Checkpoint去构建ssc

主要是做了一下动作

Spark的checkpoint源码讲解的更多相关文章

- Qt5.5.0使用mysql编写小软件源码讲解---顾客信息登记表

Qt5.5.0使用mysql编写小软件源码讲解---顾客信息登记表 一个个人觉得比较简单小巧的软件. 下面就如何编写如何发布打包来介绍一下吧! 先下载mysql的库文件链接:http://files. ...

- 【原】Spark中Client源码分析(二)

继续前一篇的内容.前一篇内容为: Spark中Client源码分析(一)http://www.cnblogs.com/yourarebest/p/5313006.html DriverClient中的 ...

- 【原】Spark中Master源码分析(二)

继续上一篇的内容.上一篇的内容为: Spark中Master源码分析(一) http://www.cnblogs.com/yourarebest/p/5312965.html 4.receive方法, ...

- 【原】 Spark中Worker源码分析(二)

继续前一篇的内容.前一篇内容为: Spark中Worker源码分析(一)http://www.cnblogs.com/yourarebest/p/5300202.html 4.receive方法, r ...

- 源码讲解 node+mongodb 建站攻略(一期)第二节

源码讲解 node+mongodb 建站攻略(一期)第二节 上一节,我们完成了模拟数据,这次我们来玩儿真正的数据库,mongodb. 代码http://www.imlwj.com/download/n ...

- Spark Scheduler模块源码分析之TaskScheduler和SchedulerBackend

本文是Scheduler模块源码分析的第二篇,第一篇Spark Scheduler模块源码分析之DAGScheduler主要分析了DAGScheduler.本文接下来结合Spark-1.6.0的源码继 ...

- Spark Scheduler模块源码分析之DAGScheduler

本文主要结合Spark-1.6.0的源码,对Spark中任务调度模块的执行过程进行分析.Spark Application在遇到Action操作时才会真正的提交任务并进行计算.这时Spark会根据Ac ...

- Spark RPC框架源码分析(一)简述

Spark RPC系列: Spark RPC框架源码分析(一)运行时序 Spark RPC框架源码分析(二)运行时序 Spark RPC框架源码分析(三)运行时序 一. Spark rpc框架概述 S ...

- Spark RPC框架源码分析(二)RPC运行时序

前情提要: Spark RPC框架源码分析(一)简述 一. Spark RPC概述 上一篇我们已经说明了Spark RPC框架的一个简单例子,Spark RPC相关的两个编程模型,Actor模型和Re ...

随机推荐

- Python中高级知识(非专题部分)学习随笔

Python学习随笔:使用xlwings读取和操作Execl文件 Python学习随笔:使用xlwings新建Execl文件和sheet的方法 博客地址:https://blog.csdn.net/L ...

- 【系统设计】WMS系统中 库存、盘点、移库、拆库功能的设计(库内管理)

最近负责WMS系统 盘点 移库 两个功能模块的功能及数据库设计. 物流仓储系统的搭建,要基于仓库的实际情况,整理内部员工需求,再参考其他WMS系统,经过长时间的讨论和研究,最终转化为产品需求. 这里先 ...

- 使用Fiddle修改请求数据

修改请求数据 以淘宝网为例 命令行中输入bpu 及要拦截的请求地址,如bpu https://s.taobao.com/search 在搜索栏中输入"面包机" 可以看到拦截到的请求 ...

- Eclipse配置反编译

Eclipse配置反编译 之前用IDEA一直让我很喜欢的点就是,什么东西都自动集成,下载.但是终归是学(po)习(jie)版,在正式企业开发中,要小心版权的问题(公司给你买了当我没说).抛开插件能 ...

- (数据科学学习手札99)掌握pandas中的时序数据分组运算

本文示例代码及文件已上传至我的Github仓库https://github.com/CNFeffery/DataScienceStudyNotes 1 简介 我们在使用pandas分析处理时间序列数据 ...

- AcWing 361. 观光奶牛

01规划 设答案为 \(ans\). 二分答案,设当前二分值为 \(mid\). 设一个环 \(S\) 的边权为 \(t_1, t_2, t_3...\),点权为 \(f_1, f_2, f_3... ...

- linux 下指定配置文件安装mongodb

下载 官网下载地址:https://www.mongodb.com/try/download/community,并上传linux 服务器 二.mongon目录结构下 /data/mongo . lo ...

- sql server添加单独新用户

- centos 7 让脚本开机运行

按照网上搜索的文章指导,有三种方式可以实现,个人觉得比较简单的是修改/etc/rc.d/rc.local,添加要开机执行的命令. 修改后,重启,发现要运行的服务没有启动. 搜索发现下面这篇博客解释了原 ...

- [日常摸鱼]poj2778 DNA Sequence

这题太神啦 题意:求长度为$n$的不包含给定DNA序列的DNA序列个数,给定的不超过10个 构建出Trie图,用$danger[i]$来表示不能走到$i$,对于DNA序列结尾的结点$danger$设为 ...