理解Spark运行模式(三)(STANDALONE和Local)

前两篇介绍了Spark的yarn client和yarn cluster模式,本篇继续介绍Spark的STANDALONE模式和Local模式。

下面具体还是用计算PI的程序来说明,examples中该程序有三个版本,分别采用Scala、Python和Java语言编写。本次用Java程序JavaSparkPi做说明。

package org.apache.spark.examples; import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.sql.SparkSession; import java.util.ArrayList;

import java.util.List; /**

* Computes an approximation to pi

* Usage: JavaSparkPi [partitions]

*/

public final class JavaSparkPi { public static void main(String[] args) throws Exception {

SparkSession spark = SparkSession

.builder()

.appName("JavaSparkPi")

.getOrCreate(); JavaSparkContext jsc = new JavaSparkContext(spark.sparkContext()); int slices = (args.length == 1) ? Integer.parseInt(args[0]) : 2;

int n = 100000 * slices;

List<Integer> l = new ArrayList<>(n);

for (int i = 0; i < n; i++) {

l.add(i);

} JavaRDD<Integer> dataSet = jsc.parallelize(l, slices); int count = dataSet.map(integer -> {

double x = Math.random() * 2 - 1;

double y = Math.random() * 2 - 1;

return (x * x + y * y <= 1) ? 1 : 0;

}).reduce((integer, integer2) -> integer + integer2); System.out.println("Pi is roughly " + 4.0 * count / n); spark.stop();

}

}

程序逻辑与之前的Scala和Python程序一样,就不再多做说明了。对比Scala、Python和Java程序,同样计算PI的逻辑,程序分别是26行、30行和43行,可以看出编写Spark程序,使用Scala或者Python比Java来得更加简洁,因此推荐使用Scala或者Python编写Spark程序。

下面来以STANDALONE方式来执行这个程序,执行前需要启动Spark自带的集群服务(在master上执行$SPARK_HOME/sbin/start-all.sh),最好同时启动spark的history server,这样即使在程序运行完以后也可以从Web UI中查看到程序运行情况。启动Spark的集群服务后,会在master主机和slave主机上分别出现Master守护进程和Worker守护进程。而在Yarn模式下,就不需要启动Spark的集群服务,只需要在客户端部署Spark即可,而STANDALONE模式需要在集群每台机器都部署Spark。

输入以下命令:

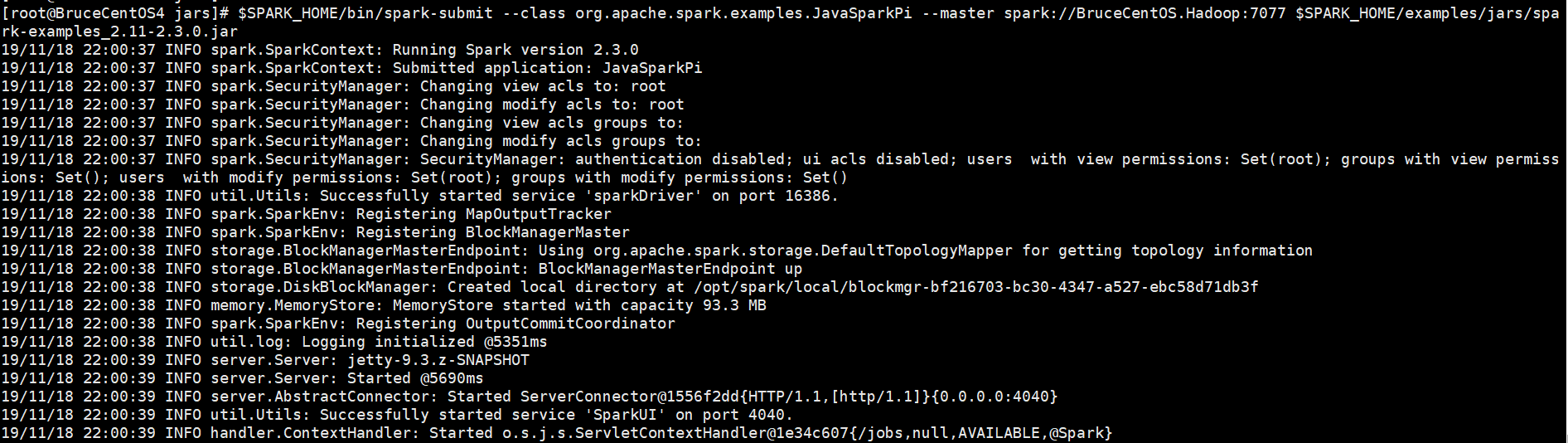

[root@BruceCentOS4 jars]# $SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master spark://BruceCentOS.Hadoop:7077 $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

以下是程序运行输出信息部分截图,

开始部分:

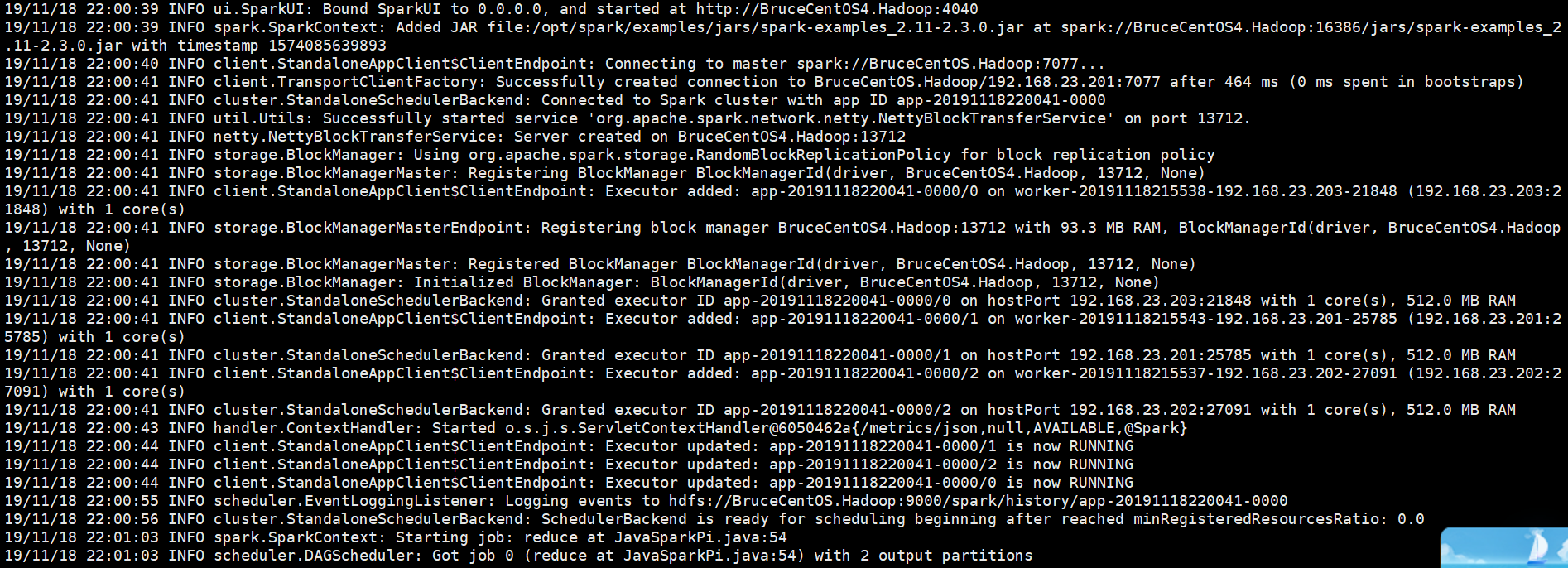

中间部分:

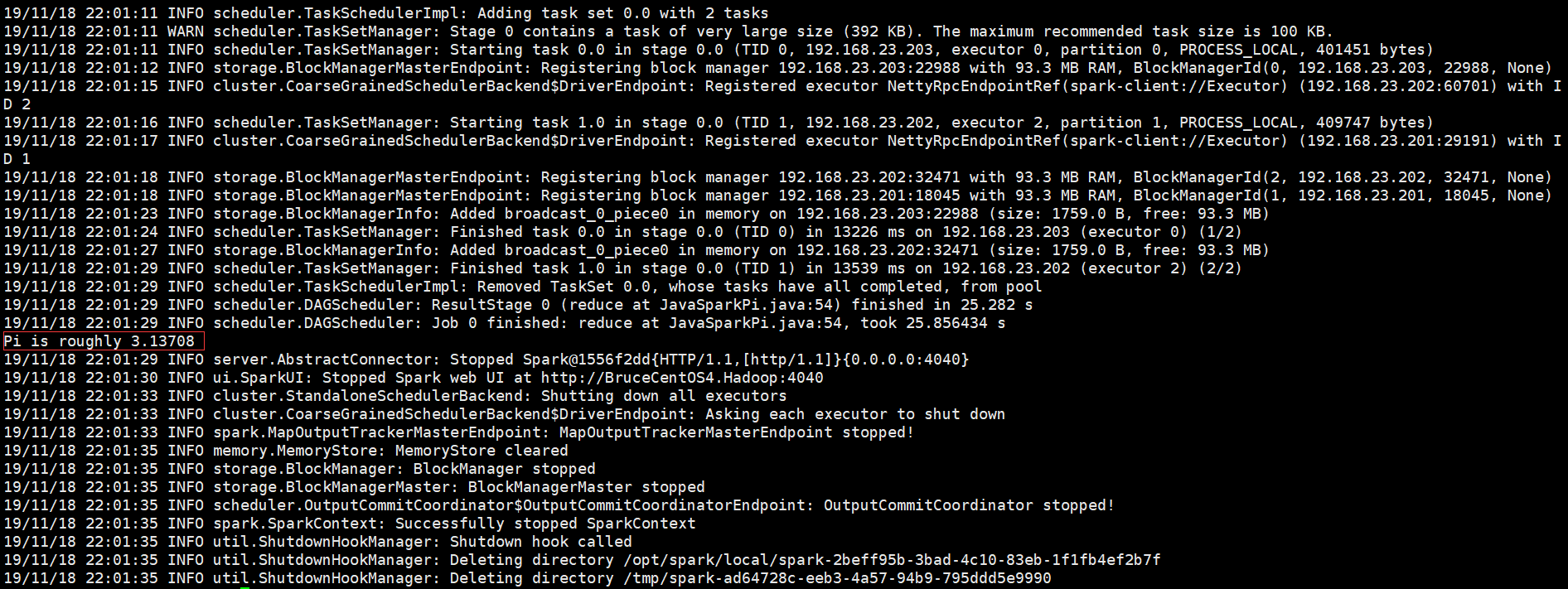

结束部分:

从上面的程序输出信息科看出,Spark Driver是运行在客户端BruceCentOS4上的SparkSubmit进程当中的,集群是Spark自带的集群。

SparkUI上的Executor信息:

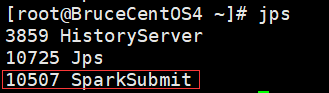

BruceCentOS4上的客户端进程(包含Spark Driver):

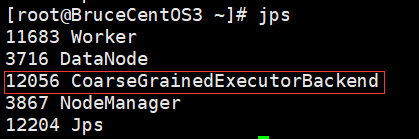

BruceCentOS3上的Executor进程:

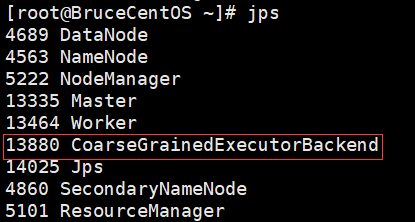

BruceCentOS上的Executor进程:

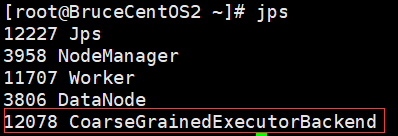

BruceCentOS2上的Executor进程:

下面具体描述下Spark程序在standalone模式下运行的具体流程。

这里是一个流程图:

- SparkContext连接到Master,向Master注册并申请资源(CPU Core 和Memory)。

- Master根据SparkContext的资源申请要求和Worker心跳周期内报告的信息决定在哪个Worker上分配资源,然后在该Worker上获取资源,然后启动CoarseGrainedExecutorBackend。

- CoarseGrainedExecutorBackend向SparkContext注册。

- SparkContext将Applicaiton代码发送给CoarseGrainedExecutorBackend;并且SparkContext解析Applicaiton代码,构建DAG图,并提交给DAG Scheduler分解成Stage(当碰到Action操作时,就会催生Job;每个Job中含有1个或多个Stage,Stage一般在获取外部数据和shuffle之前产生),然后以Stage(或者称为TaskSet)提交给Task Scheduler,Task Scheduler负责将Task分配到相应的Worker,最后提交给CoarseGrainedExecutorBackend执行。

- CoarseGrainedExecutorBackend会建立Executor线程池,开始执行Task,并向SparkContext报告,直至Task完成。

- 所有Task完成后,SparkContext向Master注销,释放资源。

最后来看Local运行模式,该模式就是在单机本地环境执行,主要用于程序测试。程序的所有部分,包括Client、Driver和Executor全部运行在客户端的SparkSubmit进程当中。Local模式有三种启动方式。

#启动1个Executor运行任务(1个线程)

[root@BruceCentOS4 ~]#$SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master local $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

#启动N个Executor运行任务(N个线程),这里N=2

[root@BruceCentOS4 ~]#$SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master local[2] $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

#启动*个Executor运行任务(*个线程),这里*指代本地机器上的CPU核的个数。

[root@BruceCentOS4 ~]#$SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master local[*] $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

以上就是个人对Spark运行模式(STANDALONE和Local)的一点理解,其中参考了“求知若渴 虚心若愚”博主的“Spark(一): 基本架构及原理”的部分内容(其中基于Spark2.3.0对某些细节进行了修正),在此表示感谢。

理解Spark运行模式(三)(STANDALONE和Local)的更多相关文章

- Spark运行模式与Standalone模式部署

上节中简单的介绍了Spark的一些概念还有Spark生态圈的一些情况,这里主要是介绍Spark运行模式与Spark Standalone模式的部署: Spark运行模式 在Spark中存在着多种运行模 ...

- 理解Spark运行模式(二)(Yarn Cluster)

上一篇说到Spark的yarn client运行模式,它与yarn cluster模式的主要区别就是前者Driver是运行在客户端,后者Driver是运行在yarn集群中.yarn client模式一 ...

- 理解Spark运行模式(一)(Yarn Client)

Spark运行模式有Local,STANDALONE,YARN,MESOS,KUBERNETES这5种,其中最为常见的是YARN运行模式,它又可分为Client模式和Cluster模式.这里以Spar ...

- spark运行模式之二:Spark的Standalone模式安装部署

Spark运行模式 Spark 有很多种模式,最简单就是单机本地模式,还有单机伪分布式模式,复杂的则运行在集群中,目前能很好的运行在 Yarn和 Mesos 中,当然 Spark 还有自带的 Stan ...

- spark运行模式之一:Spark的local模式安装部署

Spark运行模式 Spark 有很多种模式,最简单就是单机本地模式,还有单机伪分布式模式,复杂的则运行在集群中,目前能很好的运行在 Yarn和 Mesos 中,当然 Spark 还有自带的 Stan ...

- spark运行模式

一.Spark运行模式 Spark有以下四种运行模式: local:本地单进程模式,用于本地开发测试Spark代码; standalone:分布式集群模式,Master-Worker架构,Master ...

- Scala进阶之路-Spark独立模式(Standalone)集群部署

Scala进阶之路-Spark独立模式(Standalone)集群部署 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 我们知道Hadoop解决了大数据的存储和计算,存储使用HDFS ...

- Spark运行模式概述

Spark编程模型的回顾 spark编程模型几大要素 RDD的五大特征 Application program的组成 运行流程概述 具体流程(以standalone模式为例) 任务调度 DAGSche ...

- Vsftpd运行的两种模式-xinetd运行模式和 standalone模式

vsftpd运行的两种模式-xinetd运行模式和 standalone模式 vsftpd提供了standalone和inetd(inetd或xinetd)两种运行模式. standalone一次性启 ...

随机推荐

- [Luogu3065][USACO12DEC]第一!First!

题目描述 Bessie has been playing with strings again. She found that by changing the order of the alphabe ...

- 实用---生命游戏 Java

本程序由四个类组成: 其中Init_data,用于初始化各个活细胞的状态judge_state,用于判断下一代的细胞状态,并进行更新.set_color,用于给GUI界面中各个细胞涂色set_fram ...

- java集合之ArrayList链表基础

ArrayList可变数组 : arrayList继承AbstractList抽象类,实现list接口,底层基于数组实现.可存放null,除了非同步的之外,大致等同Vector.适用快速访问,复制.序 ...

- NOIP2018货币系统

题目大意 给出一组数,求出其中共有多少数不能被其他数表示 解题思路 法一:可爱的动态规划 这个思路还是比较好想的(也比较好写?) 有依赖关系的背包,思路这道题是差不多的 填满型01背包 (关于代码) ...

- 百万年薪python之路 -- MySQL数据库之 MySQL行(记录)的操作(二) -- 多表查询

MySQL行(记录)的操作(二) -- 多表查询 数据的准备 #建表 create table department( id int, name varchar(20) ); create table ...

- Python之路(第四十六篇)多种方法实现python线程池(threadpool模块\multiprocessing.dummy模块\concurrent.futures模块)

一.线程池 很久(python2.6)之前python没有官方的线程池模块,只有第三方的threadpool模块, 之后再python2.6加入了multiprocessing.dummy 作为可以使 ...

- 实用Linux控制台命令

实用Linux控制台命令 screen 例如用Xshell连接 服务器 screen -ls 列出当前用户所有的screen screen 回车直接创建新的screen screen -S scree ...

- linux下安装配置svn服务器

linux下安装配置svn服务器 1. svn服务器安装 将subversion-1.4.0.tar.gz和subversion-deps-1.4.0.tar.gz传到服务器. tar xfvz su ...

- fenby C语言 P19

#include <stdio.h> int main(){ int i,j; for(i=1;i<=8;i++) { for(j=1;j<=i;j++) { printf(& ...

- 一般链表实现集合运算(C语言)

最近在学习数据结构,遇到以下问题: 假设集合A = (c, b, e, g, f, d),B = (a, b, n, f),利用一般线性链表实现集合运算(A-B)∪(B-A). 分析: 上面的问题只要 ...