用sqoop将mysql的数据导入到hive表中

1:先将mysql一张表的数据用sqoop导入到hdfs中

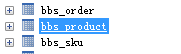

准备一张表

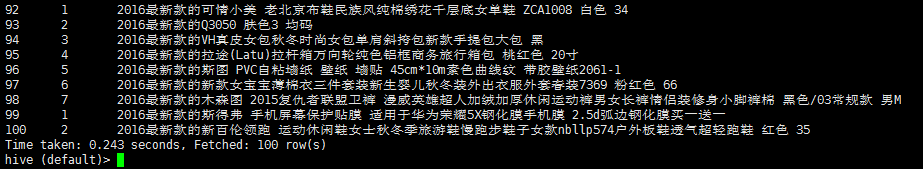

需求 将 bbs_product 表中的前100条数据导 导出来 只要id brand_id和 name 这3个字段

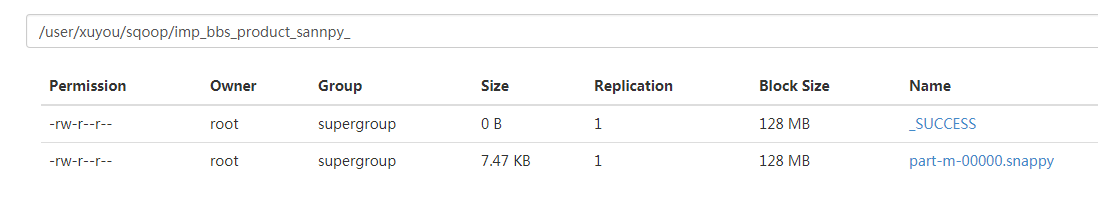

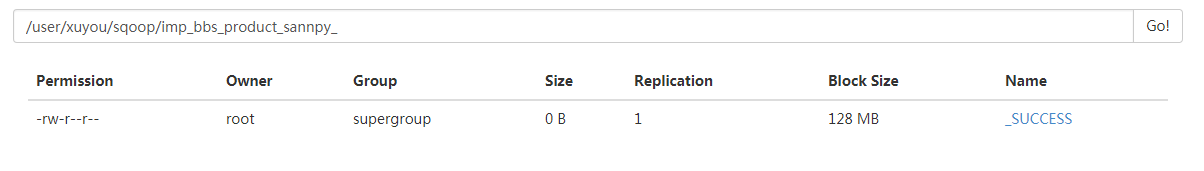

数据存在 hdfs 目录 /user/xuyou/sqoop/imp_bbs_product_sannpy_ 下

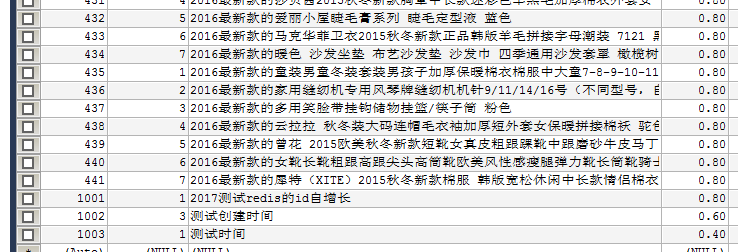

bin/sqoop import \

--connect jdbc:mysql://172.16.71.27:3306/babasport \

--username root \

--password root \

--query 'select id, brand_id,name from bbs_product where $CONDITIONS LIMIT 100' \

--target-dir /user/xuyou/sqoop/imp_bbs_product_sannpy_ \

--delete-target-dir \

--num-mappers 1 \

--compress \

--compression-codec org.apache.hadoop.io.compress.SnappyCodec \

--fields-terminated-by '\t'

ps: 如果导出的数据库是mysql 则可以添加一个 属性 --direct

bin/sqoop import \

--connect jdbc:mysql://172.16.71.27:3306/babasport \

--username root \

--password root \

--query 'select id, brand_id,name from bbs_product where $CONDITIONS LIMIT 100' \

--target-dir /user/xuyou/sqoop/imp_bbs_product_sannpy_ \

--delete-target-dir \

--num-mappers 1 \

--compress \

--compression-codec org.apache.hadoop.io.compress.SnappyCodec \

--direct \

--fields-terminated-by '\t'

加了 direct 属性在导出mysql数据库表中的数据会快一点 执行的是mysq自带的导出功能

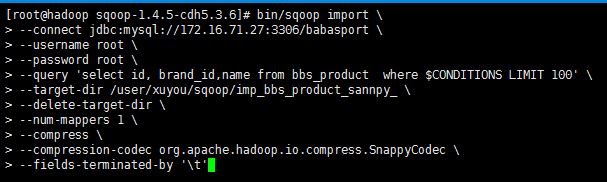

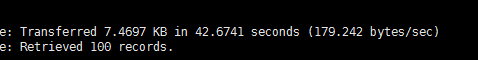

第一次执行所需要的时间

第二次执行所需要的时间 (加了direct属性)

执行成功

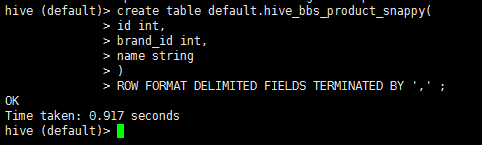

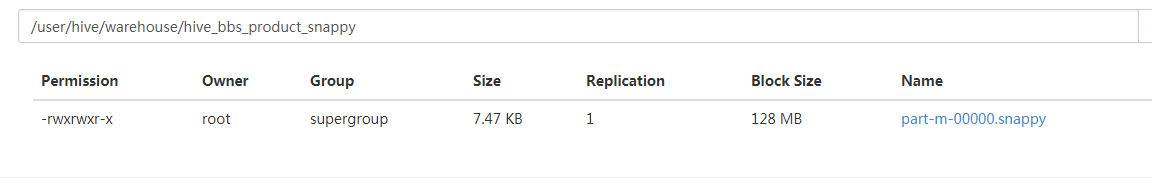

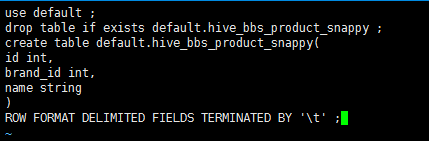

2:启动hive 在hive中创建一张表

drop table if exists default.hive_bbs_product_snappy ;

create table default.hive_bbs_product_snappy(

id int,

brand_id int,

name string

)

ROW FORMAT DELIMITED FIELDS TERMINATED BY '\t' ;

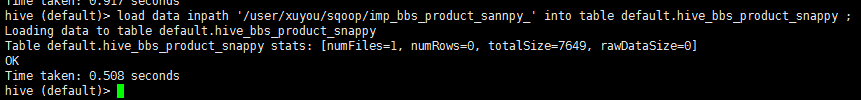

3:将hdfs中的数据导入到hive中

load data inpath '/user/xuyou/sqoop/imp_bbs_product_sannpy_' into table default.hive_bbs_product_snappy ;

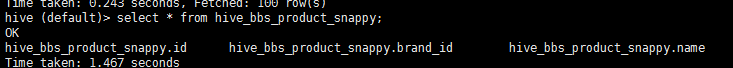

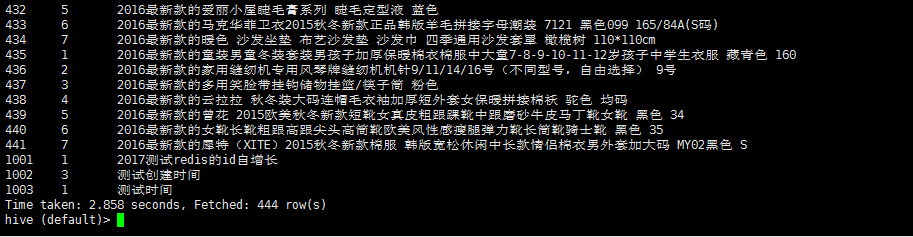

4:查询 hive_bbs_product_snappy 表

select * from hive_bbs_product_snappy;

此时hdfs 中原数据没有了

然后进入hive的hdfs存储位置发现

注意 :sqoop 提供了 直接将mysql数据 导入 hive的 功能 底层 步骤就是以上步骤

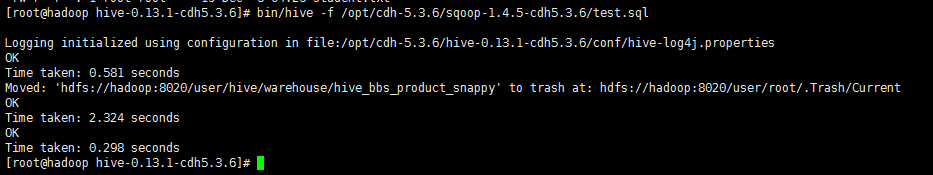

创建一个文件 touch test.sql 编辑文件 vi test.sql

use default;

drop table if exists default.hive_bbs_product_snappy ;

create table default.hive_bbs_product_snappy(

id int,

brand_id int,

name string

)

ROW FORMAT DELIMITED FIELDS TERMINATED BY '\t' ;

在 启动hive的时候 执行 sql脚本

bin/hive -f /opt/cdh-5.3.6/sqoop-1.4.5-cdh5.3.6/test.sql

执行sqoop直接导入hive的功能

bin/sqoop import \

--connect jdbc:mysql://172.16.71.27:3306/babasport \

--username root \

--password root \

--table bbs_product \

--fields-terminated-by '\t' \

--delete-target-dir \

--num-mappers 1 \

--hive-import \

--hive-database default \

--hive-table hive_bbs_product_snappy

看日志输出可以看出 在执行map任务之后 又执行了load data

查询 hive 数据

用sqoop将mysql的数据导入到hive表中的更多相关文章

- 用sqoop将mysql的数据导入到hive表

一.先将mysql一张表的数据用sqoop导入到hdfs 1.1.先在mysql中准备一张测试用的表 mysql> desc user_info; +-----------+---------- ...

- 11.把文本文件的数据导入到Hive表中

先在hive里面创建一个表 create table mydb2.t3(id int,name string,age int) row format delimited fields terminat ...

- 使用 sqoop 将mysql数据导入到hive表(import)

Sqoop将mysql数据导入到hive表中 先在mysql创建表 CREATE TABLE `sqoop_test` ( `id` ) DEFAULT NULL, `name` varchar() ...

- 使用spark将内存中的数据写入到hive表中

使用spark将内存中的数据写入到hive表中 hive-site.xml <?xml version="1.0" encoding="UTF-8" st ...

- MYSQL(将数据加载到表中)

1. 创建和选择数据库 mysql> CREATE DATABASE menagerie; mysql> USE menagerie Database changed 2. 创建表 mys ...

- 把HDFS上的数据导入到Hive中

1. 首先下载测试数据,数据也可以创建 http://files.grouplens.org/datasets/movielens/ml-latest-small.zip 2. 数据类型与字段名称 m ...

- 如何将hive表中的数据导出

近期经常将现场的数据带回公司测试,所以写下该文章,梳理一下思路. 1.首先要查询相应的hive表,比如我要将c_cons这张表导出,我先查出hive中是否有这张表. 查出数据,证明该表在hive中存在 ...

- Talend 将Oracle中数据导入到hive中,根据系统时间设置hive分区字段

首先,概览下任务图: 流程是,先用tHDFSDelete将hdfs上的文件删除掉,然后将oracle中的机构表中的数据导入到HDFS中:建立hive连接->hive建表->tJava获取系 ...

- 将DataFrame数据如何写入到Hive表中

1.将DataFrame数据如何写入到Hive表中?2.通过那个API实现创建spark临时表?3.如何将DataFrame数据写入hive指定数据表的分区中? 从spark1.2 到spark1.3 ...

随机推荐

- 使用Logstash同步数据至Elasticsearch,Spring Boot中集成Elasticsearch实现搜索

安装logstash.同步数据至ElasticSearch 为什么使用logstash来同步,CSDN上有一篇文章简要的分析了以下几种同步工具的优缺点:https://blog.csdn.net/la ...

- Communications link failure--分析之(JDBC的多种超时情况)

本文是针对特定的情景下的特定错误,不是所有Communications link failure错误都是这个引起的,重要的区分特点是:程序是不是在卡主后两个小时(服务器的设置)后程序才感知到,才抛出了 ...

- JSP 问题总结

<input type="button" value="返回" onclick="javascript:window.location.href ...

- 【前端学习笔记04】JavaScript数据通信Ajax方法封装

//Ajax 方法封装 //设置数据格式 function setData(data){ if(!data){ return ''; } else{ var arr = []; for(k in da ...

- 25个Java机器学习工具&库--转载

本列表总结了25个Java机器学习工具&库: 1. Weka集成了数据挖掘工作的机器学习算法.这些算法可以直接应用于一个数据集上或者你可以自己编写代码来调用.Weka包括一系列的工具,如数据预 ...

- 【bzoj1067】[SCOI2007]降雨量 倍增RMQ

题目描述 我们常常会说这样的话:“X年是自Y年以来降雨量最多的”.它的含义是X年的降雨量不超过Y年,且对于任意Y<Z<X,Z年的降雨量严格小于X年.例如2002,2003,2004和200 ...

- 【刷题】洛谷 P3806【模板】点分治1

题目背景 感谢hzwer的点分治互测. 题目描述 给定一棵有n个点的树 询问树上距离为k的点对是否存在. 输入输出格式 输入格式: n,m 接下来n-1条边a,b,c描述a到b有一条长度为c的路径 接 ...

- loj2541 「PKUWC2018」猎人杀 【容斥 + 分治NTT】

题目链接 loj2541 题解 思路很妙啊, 人傻想不到啊 觉得十分难求,考虑容斥 由于\(1\)号可能不是最后一个被杀的,我们容斥一下\(1\)号之后至少有几个没被杀 我们令\(A = \sum\l ...

- 解决win7 64位操作系统下安装PL/SQL后连接报错问题: make sure you have the 32 bits oracle client installed

1. 在Oracle官网(http://www.oracle.com/technetwork/topics/winsoft-085727.html)下载文件: instantclient-basic- ...

- Git config配置

git获取帮助git help config git config --help man git-config git config --global user.name "fuleyi ...